REGRESSIONE LINEARE Relazione tra una o più variabili risposta e una o più variabili esplicative, al fine di costruire una regola decisionale che permetta di prevedere i valori della variabile risposta, dati i valori delle variabili esplicative 1 Indipendenza in Generale(1) In matematica si dice che la variabile y non dipende dalla variabile x quando essa rimane costante al variare dei valori assunti da x. Nel caso contrario si dice che la y dipende ed è funzione di x. … 2 Indipendenza in Generale (2) Partendo da questa definizione, è immediato stabilire se c’è INDIPENDENZA tra due V.S. espresse da una serie di coppie di valori. Nel caso di TABELLE A DOPPIA ENTRATA, perché ci sia indi pendenza si deve verificare: Per tutte le caselle della tabella. L’INDIPENDENZA E’ RECIPROCA 3 Indipendenza in media (1) La moderna metodologia ha grandemente valorizzato la sostituzione delle distribuzioni parziali con i corrispondenti valori medi. Quando ricorrono le condizioni, si sarebbe indotti a ritenere che la relazione tra x e y farebbe corrispondere ad x il valore medio delle dato da … 4 Indipendenza in media (2) …quindi se si ha INDIPENDENZA IN MEDIA DI Y DA X. Così anche considerando le distribuzioni parziali di x dati da se si ha INDIPENDENZA IN MEDIA di X da Y. 5 Analisi della Dipendenza (1) (regressione lineare semplice) Nel caso in cui tra i due caratteri esiste una relazione unidirezionale nel senso che X indica il CARATTERE ANTECEDENTE o INDIPENDENTE e Y il CARATTERE CONSEGUENTE o DIPENDENTE si parla di DIPENDENZA DEL CARATTERE Y DAL CARATTERE X. 6 Analisi della Dipendenza (2) (regressione lineare semplice) yi = a + bxi + εi dove: a è l’intercetta b è il coefficiente di regressione εi è l’errore relativo all’osservazione i-esima 7 Regressione lineare semplice (1) Il calcolo dei parametri della RETTA DI REGRESSIONE si effettua con il metodo dei MINIMI QUADRATI; in altre parole si sceglie la retta per la quale la somma dei quadrati degli scostamenti tra i valori teorici e quelli osservati del carattere y sia minima: ossia: … 8 Regressione lineare semplice (2) risolvendo abbiamo: a yi x b i y b x n n x y / n y x / n2 i i i i b 2 2 x / n x / n i i Cov X , Y rX ,Y Y Var X X dove σY e σx indicano gli scarti quadratici medi delle variabili X e Y e r(X,Y) indica il coefficiente di correlazione lineare LA STIMA DELLA RETTA DI REGRESSIONE E’ UN POTENTE STRUMENTO PREVISIVO 9 Regressione (3) Proprietà dei residui della retta di regressione n n e y i 1 i i 1 i yˆ i 0 LA SOMMA DEI RESIDUI E' NULLA n e i 1 i n n n i 1 i 1 i 1 yˆ i e i a bx i a e i b e i x i 0 I RESIDUI SONO INCORRELAT I CON LA VARIABILE ESPLICATIV A … 10 Indice di Determinazione DEVIANZA TOTALE DEVIANZA DI REGRESSIONE DEVIANZA RESIDUA = INDICE DI DETERMINAZIONE, esprime QUANTA PARTE DELLA DEVIANZA TOTALE DI Y E’ DETERMINATA DALLA RETTA DI REGRESSIONE 11 REGRESSIONE LINEARE MULTIPLA 1 Yi a b1 X i1 b2 X i 2 ...... bk X ik i IPERPIANO DI REGRESSION E in termini matriciali Y Xb E dove Y è un vettore colonna n,1 contenenti i valori della variabile risposta X è una matrice n, (k 1) contenete, per ciascuna colonna i valori delle variabili esplicativ e b è un vettore (k 1),1 contenente tutti i parametri da stimare E è un vettore colonna n,1 contenente gli errori o residui 12 REGRESSIONE LINEARE MULTIPLA Il piano interpolante è 2 Y Xb a b1 X i1 b2 X i 2 ....... bk X ik Per determinare il piano interpolante si tratta pertanto di stimare il vettore di parametri b sulla base dei dati a disposizione. Utilizzando il criterio di ottimalità dei minimi quadrati i parametri b si otterrano minimizzando il quadrato della distanza euclidea: n d 2 y , yˆ Yi Yˆi i 1 2 13

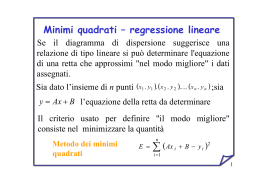

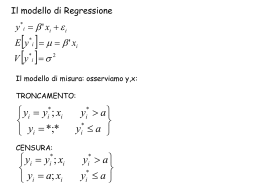

Scaricare