Modelli probabilistici

1. Variabili casuali

Il legame tra il calcolo della probabilità e gli strumenti di statistica sin qui visti, si

realizza attraverso le variabili casuali (o aleatorie1). Per avere un’idea intuitiva di come

questo accada si può pensare alla ripetizione di un esperimento casuale in cui viene rilevata la distribuzione di un certo fenomeno statistico. A lungo andare, con il ripetersi

dell’esperimento, si può giungere alla conclusione che le frequenze relative osservate con

cui si realizzano i differenti valori delle distribuzioni di frequenza siano assimilabili alle

probabilità con le quali questi valori possono realizzarsi. L’insieme dei valori assumibili

dal fenomeno statistico e le probabilità che gli attribuiamo costituiscono un modello matematico: cioè una descrizione di quello che può verificarsi e delle probabilità con cui ci

aspettiamo che questi eventi si verifichino. Le variabili casuali sono proprio tali modelli.

1.1. Variabili casuali discrete. Una definizione sommaria, ma sufficiente ai nostri

scopi, di variabile casuale consiste in quanto segue: dato un esperimento casuale, una

variabile casuale è un risultato numerico attribuito a tale esperimento. Pensiamo all’esperimento di due lanci di una moneta regolare, cioè P (T ) = P (C) = 12 . L’insieme dei

risultati possibili, cioè lo spazio campionario dell’esperimento, è Ω = {T T, T C, CT, CC}.

Se ad ogni lancio contiamo il numero di teste, otteniamo rispettivamente (2,1,1,0), ovvero

associamo ad ogni elemento ω ∈ Ω un numero X(ω) = x. Possiamo cioè costruire la

seguente tabella:

ω∈Ω

T T T C CT CC

P (ω)

1/4 1/4 1/4 1/4

X(ω) = x 2

1

1

0

Come si vede X rappresenta il risultato numerico di un esperimento. Possiamo sintentizzare la tabella di sopra raccogliendo i valori distinti assunti da X e le rispettive probabilità.

I valori distinti sono: 0, 1 e 2. X assume valore 0 solo in corrispondenza dell’evento CC

il quale ha probabilità 1/4, quindi possiamo dire che P (X = 0) = P (CC) = 1/4. Lo

stesso avviene per il valore 2, infatti X = 2 solo quando si verifica l’evento T T , quindi

P (X = 2) = P (T T ) = 1/4. Il valore X = 1 si realizza in due casi: quando si realizza

CT o quando si realizza T C, dunque P (X = 1) = P (CT ∪ T C) = P (CT ) + P (T C) =

1/4 + 1/4 = 1/2. Riassumendo abbiamo la seguente tabella

X=x

0

1

2

P (X = x) 1/4 1/2 1/4 1

Non abbiamo fatto altro se non definire un modello matematico che descrive i possibili risultati (numerici) di un esperimento casuale con l’attribuzione delle probabilità del

verificarsi dei singoli eventi. X è dunque una variabile casuale discreta (in analogia alla definizione di fenomeno quantitativo discreto) e P (X = x) è la sua distribuzione di

probabilità. Una volta noti i valori x1 , x2 , . . . , xk assumibili dalla variabile casuale e le

1

Notiamo incidentalmente che l’etimologia del termine “aleatorio” deriva dai giochi degli aliossi o dei

dadi. I termini casuale e aleatorio sono usualmente intercambiati nella letteratura.

1

0.0

0.1

0.2

P(X=x)

0.3

0.4

0.5

2

0

1

2

x

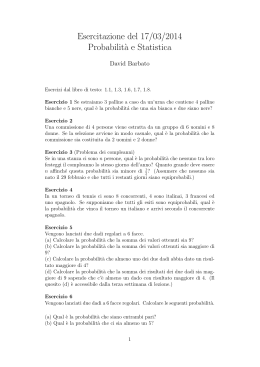

Figura 1. Distribuzione di probabilità della variabile casuale X = “numero di

teste nel lancio doppio di una moneta”.

probabilità P (X = xi ) con cui essa li assume possiamo anche dimenticarci di quale sia

l’esperimento casuale con cui essa è stata costruita. In sostanza, la corretta definizione

di variabile casuale discreta richiede che siano specificati i valori che essa assume e la sua

distribuzione di probabilità.

Variabile casuale discreta

Una variabile casuale discreta è un modello matematico {xi , P (X = xi ), i = 1, . . . , k} che

associa ai valori x1 , x2 , . . . , xk le rispettive probabilità P (X = xi ), i = 1, . . . , k.

P (X = xi ), i = 1, . . . , k si chiama distribuzione di probabilità ed è tale per cui

k

X

P (X = xi ) = 1

i=1

Per rappresentare graficamente la distribuzione di probabilità di una variabile casuale

si procede come nel caso di un fenomeno quantitivo discreto. Si mettono in ascissa i valori

xi e in ordinata le probabilità P (X = xi ). Si tracciano i corrispondenza dei singoli valori

xi delle asticelle con un’altezza pari a P (X = xi ). Si veda la Figura 1.

Vediamo ancora un esempio di costruzione di variabile casuale.

3

0.10

0.00

0.05

P(X=x)

0.15

1. VARIABILI CASUALI

2

3

4

5

6

7

8

9

10

11

12

x

Figura 2. Distribuzione di probabilità della variabile casuale X = “somma dei

punteggi nel lancio di due dadi”.

Esercizio 1. Consideriamo l’esperimento che consiste nel lancio di una coppia di

dadi. L’insieme dei risultati possibili è composto da 6×6 = 36 valori

Ω = {11, 12, 13, 14, 15, 16, 21, 22, 23, 24, 25, 26, 31, 32, 33, 34, 35, 36,

41, 42, 43, 44, 45, 46, 51, 52, 53, 54, 55, 56, 61, 62, 63, 64, 65, 66}

Supponiamo di essere interessati alla somma (X) dei punteggi realizzati con i due dadi.

I possibili risultati in questo caso sono tutti i numeri compresi tra 2 (1+1) e 12 (6+6).

Quindi X = 2 solo se è uscito un doppio 1, e questo avviene con probabilità 1/36. Mentre,

ad esempio, X = 7 può essere ottenuto in corrispondenza delle coppie di risultati dei dadi

che danno origine alle somme: 1 + 6, 6 + 1, 2 + 5, 5 + 2, 3 + 4, 4 + 3 cioè in 6 modi

differenti, quindi P (X = 7) = 6 · 1/36. Cosı̀ facendo costruiamo l’intera distribuzione di

probabilità della variabile casuale X

X=x

2 3 4 5 6 7 8 9 10 11 12

1

2

3

4

5

6

5

4

3

2

1

P (X = x) 36

1

36

36

36

36

36

36

36

36

36

36

Anche per questa variabile casuale disegnamo il grafico della sua distribuzione di probabilità come in Figura 2.

Per capire meglio le relazioni tra variabili casuali e fenomeni statistici consideriamo il

seguente esempio: si supponga di avere una popolazione di 5 individui di cui ha interesse

studiare una certa caratteristica. Ad esempio, il numero mediano di dipendenti di 5

aziende. Supponiamo inoltre che non sia possibile intervistare tutte e 5 le aziende e

quindi ci poniamo nella condizione di dover effettuare un campionamento. Poniamo di

poter rilevare solamente i dati di n = 3 aziende.

4

Le aziende, in realtà, hanno nell’ordine {1, 3, 5, 7, 9} dipendenti ma dobbiamo fingere

di non saperlo. Se estraiamo casualmente un campione di 3 aziende potremmo ottenere

come risultato il campione (1, 3, 9) oppure quello (1, 5, 9). Nel primo caso la mediana vale

3, nel secondo 5. Sappiamo però che la mediana vera della popolazione delle 5 aziende è

pari a 5. Ciò implica che il campione estratto può anche portare a conclusioni errate.

Elenchiamo tutti i possibili campioni che si possono estrarre. Lo spazio campionario

Ω è costituito da tutte le terne di numeri estraibili dall’insieme dei primi 5 numeri dispari.

In totale queste terne sono

5

5 · 4 · 3!

=

= 10

3

3! · 2!

Quindi

Ω = {(1, 3, 5), (1, 3, 7), (1, 3, 9), (1, 5, 7), (1, 5, 9), (1, 7, 9),

(3, 5, 7), (3, 5, 9), (3, 7, 9), (5, 7, 9)}

ciascuno di quegli eventi ha probabilità 1/10 di comparire.

Costruiamo la variabile casuale X = mediana campionaria

ω

X(ω)

(1,3,5)

3

(1,3,7)

3

(1,3,9)

3

5

(1,5,7)

(1,5,9)

5

(1,7,9)

7

(3,5,7)

5

5

(3,5,9)

(3,7,9)

7

(5,7,9)

7

Per cui la variabile casuale X risulta essere definita come segue

x P (X = x)

3

3/10

5

4/10

3/10

7

Mentre la mediana vera della popolazione è 5, la variabile casuale X mediana campionaria

è il modello che descrive tutti i possibili risultati che si possono ottenere calcolando la

mediana in uno dei 10 campioni estratti casualmente. Cioè a priori, prima di effettuare

un qualsiasi esperimento, la mediana può assumere i valori 3, 5 e 7. Quando andiamo ad

estrarre un campione e ne calcoliamo la mediana otterremo uno solo di quei 3 valori. La

frequenza con cui ci aspettiamo che un certo valore xi della mediana si realizzi è pari alla

probabilità dell’evento P (X = xi ).

Come si può notare, esiste un parallelismo tra le variabili casuali e i fenomeni statistici

o, meglio, tra le loro distribuzioni. In questa seconda parte del corso le variabili casuali

e i fenomeni statistici saranno spesso identificati tra loro. La distinzione fondamentale è

1. VARIABILI CASUALI

5

.......................................................

.............

..........

..........

........

........

.......

.......

......

.

.

.

.

.

......

....

.

.

.

......

.

.

....

.....

.

.

.

.

.....

...

.

.

.

.....

.

....

.....

.

.

.

.....

...

.

.

.

...

..

.

...

.

..

...

.

.

...

...

.

...

..

...

.

..

...

.

...

..

.

...

..

.

...

..............

..

.

...

......

.....

...

....

...

...

...

...

...

...

...

...

.

.

.

.

.

.

...

.

.

.

...

...

..... .......

.

.

...

.

...

...

.

.

.....

....

.

..

.

...

...

.

...

..................

...

....

...

.

.

...

...

...

...

...

...

...

..

.

...

...

...

...

...

...

..

...

..

.

.

...

..

...

...

...

...

...

...

....

..

.

.

.....

.

.

.....

....

.....

.....

.....

.....

......

.....

.....

......

.

.

.

.

.

.

......

.......

......

......

........

........

.........

............

.........

.............................................................

qq

qqqqqqqqqqq

qqqqqqqqqqqqqqqqqqqq

q

qqqq qq

qqqq

q

q

q

q

qqqq

qqqq

q

q

q

q

qqqq x

qqqq

1

q

q

q

qq

qqqq

q

q

q

q

qqqq

qqqq

q

q

q

qqq

Figura 3. La Ruota della Fortuna: La variabile casuale X segna i gradi xi in

corrispondenza dei quali l’ago della ruota di ferma. Nel disegno l’ago si ferma in

posizione X = x1 . Poiché si tratta di uno degli infiniti valori tra 0 e 360◦ , avremo

P (X = x1 ) = 1/∞ = 0.

che la distribuzione di probabilità ci dice con quali probabilità osserveremo certi valori del

fenomeno, mentre la distribuzione di frequenza fotografa quanto è accaduto all’interno di

un particolare campione di dati di ampiezza n.

Nota la distribuzione di probabilità di una variabile casuale è sempre possibile calcolare

probabilità del tipo P (X ≤ x). Ad esempio, per la variabile casuale appena vista, ci si può

chiedere con quale probabilità la mediana campionaria risulta essere minore o uguale al

valore 5, cioè P (X ≤ 5). È effettivamente molto semplice, basta sommare le probabilità,

meglio cumularle, come abbiamo fatto nel calcolo delle frequenze cumulate. Dunque

3

4

7

P (X ≤ 5) = P (X = 3) + P (X = 5) =

+

=

= 0.7

10 10

10

In termini più generali si può usare la formula

X

(1)

P (X ≤ x) =

P (X = xi )

xi ≤x

1.2. Variabili casuali continue. Ci sono esperimenti casuali che non sempre generano valori discreti o comunque in quantità numerabile. Si consideri l’esempio che

potremmo chiamare della Ruota della Fortuna. Possiamo pensare ad una sorta di roulette/bussola con un ago centrale. Se facciamo ruotare l’ago, questo terminerà la sua corsa

ponendosi in una certa posizione che possiamo registrare come il numero di gradi x1 da

una linea prefissata (confronta Figura 3). Se facciamo ruotare ancora l’ago otterremo

un nuovo valore x2 e cosı̀ via. Nella sostanza possiamo ottenere un numero infinito di

valori diversi xi quindi l’esperimento ci porta ad un insieme Ω che corrisponde a tutte

le possibili posizioni assumibili dall’ago della roulette. Se indichiamo con X la variabile

6

casuale che registra i gradi xi , allora la variabile casuale X assumerà tutti valori dei gradi

nell’intervallo (0,360). Proviamo a calcolare la probabilità con cui la variabile casuale

X assume un particolare valore xi . Poiché supponiamo di non barare nel far ruotare

la freccia, possiamo utilizzare l’usuale formula del caso di eventi elementari (i gradi di

inclinazione) equiprobabili

P (X = xi ) =

# casi favorevoli

1

=

=0

# casi possibili

∞

cioè ciascuno dei risultati X = xi ha probabilità nulla di verificarsi! Questo è quindi un

problema se pensiamo alla definizione di variabile casuale come nel caso discreto. Però non

è impossibile calcolare le probabilità relative ad eventi che coinvolgono variabili casuali

continue. Ad esempio, con quale probabilità la variabile casuale X, cioè l’ago, misurerà

un’inclinazione compresa tra 0 e 90◦ ? Poiché si tratta della quarta parte di un cerchio

(confronta la Figura 4), viene naturale rispondere che P (X ≤ 90) = 1/4 = 0.25.

In generale, le variabili casuali continue vengono sempre definite a partire dall’insieme

dei valori assumibili e dalle probabilità del tipo P (X ≤ x). Queste probabilità possono

in genere essere espresse attraverso un’altra funzione f (·), detta densità di probabilità, in

questa terribile forma

Zx

P (X ≤ x) =

f (u)du.

−∞

La formula qui sopra non deve spaventare poiché non la useremo mai direttamente,

ma

R

deve essere interpretata come un’estensione della formula (1) dove l’integrale sostituisce

la sommatoria e la funzione di densità f (·) sostituisce i termini P (X = xi ).

Della densità è utile dare un’interpretazione grafica. Calcolare l’integrale della funzione

f (·) corrisponde a calcolare l’area sotto la curva f (·) stessa. Si consideri il grafico (a) della

Figura 5. Abbiamo disegnato l’area sotto la curva f (·) di forma campanulare, fino al punto

1. Formalmente abbiamo calcolato

Z1

P (X ≤ 1) =

f (u)du = (a).

−∞

In (b) abbiamo rappresentato il valore dell’area sotto f (·) compresa tra -2 ed 1, cioè

P (−2 < X ≤ 1) e infine in (c) l’area a destra del punto 1, cioè P (X > 1).

È lecito aspettarsi che, come nel caso discreto, la somma delle probabilità in corrispondenza di tutti i valori assumibili dalla variabile aleatoria sia pari ad 1. Questa proprietà

per le variabili casuali continue corrisponde a chiedere che l’area totale sotto la curva f (·)

sia pari ad 1.

1. VARIABILI CASUALI

7

90◦

...................................

....................

...........

.........

...........

........

.........

.......

.......

.

.

.

.

.

......

....

.

.

.

......

.

.

....

.....

.

.

.

.

.....

...

.

.

.

.....

.

...

.

.....

.

.

.

.....

...

.

.

.

.

....

...

.

...

.

..

...

.

.

...

...

.

...

..

...

.

...

..

.

...

..

.

...

..

.

...

...

....

...

...

...

...

...

...

...

..........

.

.

.

.

.

.

...

.

...

...

.....

...

...

...

...

..

...

.

.

....

...

.

..

.

..............

...

...

...

..

.

...

..

.

...

...

...

...

...

...

...

..

...

.

...

...

...

...

...

..

...

..

.

...

.

.

...

...

...

...

...

...

.....

.....

.

.....

.

.

.

.....

....

.....

.....

.....

.....

......

......

......

......

.

.

.......

.

.

.

...

.......

.......

........

........

..........

..........

...............

.................................................

qqqq

qqqqqqqqq

qqqqqqqqqqqqq

qq q

qqq

qqq qq

qq

qqq

qqq qq

qq

qqq

qqq qq

qq

qqq

qqq qq

q

qqq

qqq

0◦

Figura 4. Ancora la Ruota della Fortuna: Con quale probabilità l’ago della

−2

−1

0

1

2

3

0.3

f(x)

0.2

0.0

0.0

−3

P(X > 1)

0.1

0.2

f(x)

0.3

P(− 2 < X ≤ 1)

0.1

0.2

0.0

0.1

f(x)

0.3

P(X ≤ 1)

0.4

0.4

0.4

Ruota si ferma in punto compreso tra 0 e 90◦ ? Questo accade una volta su 4,

cioè nel 25% dei casi, dunque P (X ≤ 90) = 0.25.

−3

x

−2

−1

0

1

2

3

x

(a)

−3

−2

−1

0

1

2

3

x

(b)

(c)

Figura 5. Esempi di rappresentazione grafica di calcolo di probabilità per

variabili casuali continue: (a) P (X ≤ 1), (b) P (−2 < X ≤ 1), (c) P (X > 1).

Variabile casuale continua

Una variabile casuale continua è un modello matematico {x, f (x)}. La densità f (·) ≥ 0 è

tale per cui

Zx

Z∞

P (X ≤ x) =

f (u)du e

f (u)du = 1

−∞

−∞

dove P (X ≤ x) rappresenta l’area sotto la curva f (·) fino al punto x.

Attenzione: per le variabili casuali continue si ha sempre P (X = x) = 0.

8

1.3. Valore atteso e varianza delle variabili casuali. Indipendenza. Come

per i fenomeni statistici quantitativi anche per le variabili casuali è possibile calcolare

media e varianza. La media di una variabile casuale viene anche chiamata valore atteso.

In analogia a quanto visto nella statistica descrittiva, per le variabili casuali abbiamo che

∞

Z

k

X

µ = E(X) =

xi · P (X = xi ) xf (x)dx per le continue

i=1

−∞

ricordiamo che per la media aritmetica si ha

x̄ =

k

X

xi · fi

i=1

Invece per la varianza

σ 2 = Var(X) =

k

X

(xi − µ)2 · P (X = xi )

Z∞

o

i=1

(x − µ)2 f (x)dx

−∞

analogamente al caso della statistica descrittiva

2

σ =

k

X

(xi − x̄)2 · fi

i=1

Anche se usiamo lo stesso simbolo per due oggetti diversi, difficilmente ci confonderemo.

Calcoliamo il valore atteso e la varianza della variabile casuale Mediana campionaria

del primo esempio. Ricordiamo che

x P (X = x)

3

3/10

5

4/10

7

3/10

Quindi

3

X

3

4

3

µ = E(X) =

xi P (X = xi ) = 3 ·

+5·

+7·

10

10

10

i=1

9 + 20 + 21

=5

10

mentre per la varianza si ha

=

Var(X) =

3

X

(xi − µ)2 P (X = xi )

i=1

= (3 − 5)2 ·

=

3

4

3

+ (5 − 5)2 ·

+ (7 − 5)2 ·

10

10

10

12 + 12

= 2.4

10

1. VARIABILI CASUALI

9

Per la media e la varianza delle variabili casuali valgono le stesse proprietà del caso

della statistica descrittiva che qui riportiamo.

Proprietà di media e varianza di variabili casuali

2

Se X è una variabile casuale di media µ = E(X) e varianza σX

= Var(X) e Y è una nuova

variabile casuale costruita come segue Y = a + b X, si ha che

E(Y ) = E(a + b X) = a + b E(X)

e

2

σY2 = Var(Y ) = Var(a + b X) = b2 Var(X) = b2 σX

Attenzione: se c è un numero, non aleatorio, allora E(c) = c.

Si supponga di avere due variabili casuali X ed Y . Il valore atteso della variabile

casuale Z = X + Y è pari alla somma dei loro valori attesi, cioè

E(Z) = E(X + Y ) = E(X) + E(Y )

Se abbiamo due variabili casuali discrete X = {xi , P (X = xi ), i = 1, . . . , h} ed Y =

{yj , P (Y = yj ), j = 1, . . . , h} queste si dicono indipendenti se e solo se si verifica

P (X = xi , Y = yj ) = P (X = xi ∩ Y = yj ) = P (X = xi ) · P (Y = yj ),

per ogni combinazione dei valori i = 1, . . . , h e j = 1, . . . , k. Con la notazione P (X =

xi , Y = yj ) si intende la probabilità dell’evento corrispondente al verificarsi contemporaneo

del valore xi di X e yj di Y . Se scriviamo A = (X = xi ) e B = (Y = yj ) allora la

definizione di indipendenza corrisponde a quanto già visto nel calcolo delle probabilità,

cioè A e B sono indipendenti se e solo se P (A ∩ B) = P (A) · P (B).

Un’analoga definizione si può scrivere per il caso di variabili casuali continue ma non

è essenziale riportare qui la formula. In ogni caso, le proprietà che riportiamo valgono per

ogni tipo di variabile casuale. In particolare vale la seguente proprietà: se X ed Y sono

due variabili casuali indipendenti si ha che Var(X + Y ) = Var(X) + Var(Y ). Riassumendo

Proprietà di media e varianza di somma di variabili casuali

Se X ed Y sono due variabili casuali allora

E(X + Y ) = E(X) + E(Y )

Se X ed Y sono anche indipendenti si ha che

Var(X + Y ) = Var(X) + Var(Y )

1.4. Esercizi riepilogativi.

Esercizio 2. Si consideri l’esperimento che consiste nel lancio di un dado regolare e

di una moneta truccata in modo tale che testa esca in proporzione 1:3 rispetto a croce.

Il risultato del lancio del dado non influenza e non è influenzato da quello della moneta.

10

Costruiamo la variabile aleatoria che ad ogni risultato del lancio del dado e della moneta

assume come valore il punteggio ottenuto con il dado sommandovi il numero di croci.

Cominciamo a costruire l’esperimento casuale e quindi Ω. Ad ogni lancio del dado

i sei risultati 1,2,. . . , 6 sono egualmente possibili. Poiché il dado è regolare, ognuno ha

probabilità di verificarsi 1/6. Indichiamo con D l’insieme dei punteggi ottenuti con il

dado D = {1, 2, 3, 4, 5, 6}. Nel lancio della moneta solo due eventi si verificano: testa T

o croce C. Poiché la moneta è stata truccata in modo che si abbia 1 testa ogni 3 croci

sarà P (T ) = 1/4 e P (C) = 3/4 infatti, su quattro lanci si avranno 1 (testa) + 3 (croci)

= 4 (risultati), cioè testa esce 1 volta su 4. Indichiamo con M = {T, C} l’insieme dei

risultati del lancio della moneta. Gli eventi ω sono tutte le 12 coppie (6×2) di risultati

del lancio del dado (6) e della moneta (2), quindi Ω è l’insieme delle coppie

Ω = {1T, 2T, 3T, 4T, 5T, 6T, 1C, 2C, 3C, 4C, 5C, 6C}

Gli eventi del tipo “iT ”, i = 1, . . . , 6 hanno probabilità 1/24, infatti

1 1

1

· =

6 4

24

per l’indipendenza tra i risultati del lancio del dado e della moneta, cioè

P (1T ) = P (2T ) = · · · = P (6T ) =

P (iT ) = P (i ∩ T ) = P (i) · P (T )

Quelli del tipo “iC”, i = 1, . . . , 6 hanno probabilità 1/8 per la stessa ragione, infatti

1 3

3

1

· =

= .

6 4

24

8

Dopo aver assegnato le probabilità agli eventi elementari di Ω, passiamo alla costruzione

della variabile aleatoria X. In corrispondenza del risultato (evento) iT , la variabile casuale

X vale i + 0, poiché il punteggio ottenuto con il dado è i e il numero di croci C è pari a

0 (abbiamo una testa: T ). In corrispondenza degli eventi iC, la variabile casuale X vale

i + 1, poiché la faccia del dado assegna un punteggio pari ad i e il numero di croci C è

pari ad 1. Quindi, in totale, la variabile casuale assume uno qualsiasi dei valori interi

compresi tra 1 e 7 come riporta la tabella seguente

ω

1T 2T 3T 4T 5T 6T 1C 2C 3C 4C 5C 6C

X(ω) 1

2

3

4

5

6

2

3

4

5

6

7

Per terminare la costruzione della variabile casuale X dobbiamo fornire la sua distribuzione di probabilità o legge, cioè le probabilità con cui assume i singoli valori.

Il valore 1 viene assunto da X in corrispondenza del solo evento 1T , quindi P (X =

1) = P (1T ) = 1/24. Il valore 2 viene assunto da X in corrispondenza degli eventi 2T e

1C, quindi

P (X = 2) = P (2T ∪ 1C) = P (2T ) + P (1C)

1

1+3

1

1

+ =

=

=

24 8

24

6

Si verifichi come esercizio che lo stesso avviene per i valori 3, 4, 5 e 6. Il valore 7 invece,

viene assunto da X in corrispondenza del solo evento 6C e quindi P (X = 7) = P (6C) =

P (1C) = P (2C) = · · · = P (6C) =

1. VARIABILI CASUALI

11

1/8. La Tabella 1 sintetizza tutti i passaggi eseguiti e definisce correttamente la variabile

casuale X.

xi

1

2 3 4 5 6 7

P (X = xi )

1

24

1

6

1

6

1

6

1

6

1

6

1

8

1=

7

P

P (X = xi )

i=1

Tabella 1. Distribuzione di probabilità della variabile casuale X = “punteggio

del dado + numero di croci”.

Esercizio 3. Un esperimento casuale consiste nell’estrarre una carta da una mazzo

di 8 carte composto da 4 Assi e 4 Nove (uno per ogni seme ♠, ♥, ♦, ♣) e nel lanciare una

moneta regolare. Costruire lo spazio campionario Ω e la variabile casuale X = “valore

carta + numero croci”. Si disegni la funzione di probabilità di X.

Lo spazio campionario Ω è costituito da tutti gli accoppiamenti “asso” e T o C e

“nove” con T o C quindi 4*2 +4*2 = 16 coppie di valori:

Ω = (1♠, T ), (1♥, T ), (1♦, T ), (1♣T ),

(1♠, C), (1♥, C), (1♦, C), (1♣, C),

(9♠, T ), (9♥, T ), (9♦, T ), (9♣, T ),

(9♠, C), (9♥, C), (9♦, C), (9♣, C)

Ciascuno degli eventi ω ∈ Ω ha probabilità 1/16 poiché gli eventi risultanti dall’estrazione

della carta sono equiprobabili cosı̀ come quelli risultanti dal lancio della moneta. Inoltre

siamo in condizioni di indipendenza.

La variabile casuale X considera il “valore della carta” e vi somma l’eventuale “numero

di croci”, quindi ad esempio, in corrispondenza dell’evento (1♠, T ), X((1♠, T )) = 1+0 = 1

mentre nel caso di (9♦, C), X((9♦, C)) = 9 + 1 = 10. La seguente tabella riassume i

risultati possibili in questo esperimento:

12

ω

X(ω) P (ω)

(1♠, T ) 1+0=1 1/16

(1♥, T )

1

1/16

(1♦, T )

1

1/16

(1♣T )

1

1/16

(1♠, C) 1+1=2 1/16

(1♥, C)

1

1/16

1

1/16

(1♦, C)

(1♣C)

1

1/16

(1♠, T ) 9+0=9 1/16

(1♥, T )

1

1/16

1

1/16

(1♦, T )

(1♣T )

1

1/16

(9♠, C) 9+1=10 1/16

(9♥, C)

10

1/16

(9♦, C)

10

1/16

(9♣C)

10

1/16

Quindi X assume i seguenti valori (con le rispettive probabilità)

xi

1

2

9

10

P (X = xi )

4 · 1/16 = 14

4 · 1/16 = 14

4 · 1/16 = 14

4 · 1/16 = 14

1

Il grafico della densità di probabilità è analogo al grafico di un fenomeno quantitativo

discreto che assume i valori 1,2, 9 e 10 con frequenze relative 1/4, 1/4, 1/4 e 1/4.

Esercizio 4. Un esperimento casuale consiste nell’estrazione con reinserimento di

due palline da un’urna contenente tre palline numerate da 1 a 3. Individuare lo spazio dei

possibili risultati (coppie) e costruire la variabile casuale X = “minimo dei due numeri

estratti”.

Lo spazio campionario Ω è costituito da tutte le coppie del tipo (i, j) con i, j = 1, 2, 3,

cioè

Ω = {(1, 1), (1, 2), (1, 3), (2, 1), (2, 2), (2, 3), (3, 1), (3, 2), (3, 3)}

Gli eventi elementari ω ∈ Ω sono tutti equiprobabili e P (ω) = 31 · 31 = 19 . Vediamo

che valori assume la variabile casuale X che ad ogni ω = (a, b) ∈ Ω associa il valore

X(ω) = X((a, b)) = min(a, b). Costruiamo una tabella riassuntiva

1. VARIABILI CASUALI

13

ω

X(ω) P (ω)

1

(1,1)

1

9

1

(1,2)

1

9

1

(1,3)

1

9

1

(2,1)

1

9

1

(2,2)

2

9

1

(2,3)

2

9

1

(3,1)

1

9

1

(3,2)

2

9

1

(3,3)

3

9

Quindi X assume i seguenti valori (con le rispettive probabilità)

xi P (X = xi )

1 5 · 19 = 59

2 3 · 19 = 39

3 1 · 19 = 19

1

14

Nei prossimi due paragrafi ci occuperemo dello studio di due importanti variabili

casuali che ricoprono un ruolo fondamentale in ambito statistico. Si tratta di una variabile

casuale discreta, la Binomiale, ed una continua, la Gaussiana o Normale. La seconda è

anche l’oggetto centrale della statistica inferenziale tanto che un importante teorema del

calcolo delle probabilità, che porta il nome di Teorema del Limite Centrale, vede proprio

la variabile casuale Gaussiana come protagonista.

2. La variabile casuale Binomiale

La variabile aleatoria Binomiale si costruisce a partire dalla nozione di esperimento

Bernoulliano.

Esperimento Bernoulliano

Un esperimento casuale che consiste in un insieme di prove ripetute con le seguenti

caratteristiche:

i) ad ogni singola prova si hanno solo 2 esiti possibili, chiamati “successo” ed

“insuccesso”,

ii) la probabilità dell’evento che da origine al “successo” è costante,

iii) i risultati delle prove sono indipendenti,

è detto un esperimento Bernoulliano.

È importante sapere riconoscere quando si è in presenza di questo tipo di esperimento.

Facciamo alcuni esempi.

Se lanciamo ripetutamente una moneta e registriamo come “successo” il risultato T ,

siamo esattamente in presenza di un esperimento Bernoulliano.

Se pensiamo alle chiamate che giungono ad un centrale telefonica in una certa fascia

oraria e indichiamo con “successo” l’evento “chiamata da telefonia mobile” e con “insuccesso” l’evento “chiamata da telefonia fissa”, siamo ancora in presenza di esperimento di

Bernoulli in quanto possiamo supporre che i vari utenti agiscano indipendentemente l’uno

dall’altro e che, nell’ambito di una data fascia oraria, rimanga costante la frequenza con

cui gli utenti chiamano da un cellulare o da un telefono di rete fissa.

Pensiamo all’esito di un sondaggio referendario. Supponiamo che siano possibili solo 2

esiti: successo = “SI” e insuccesso = “NO”. Ogni elettore vota in modo indipendente l’uno

dall’altro (se pensiamo a due elettori consecutivi). Supponiamo di prendere un campione

di schede votate. Se ne prendiamo una a caso possiamo immaginare che su quella scheda

troveremo un “SI” con una probabilità pari alla frequenza con cui (tutti) gli elettori si

sono espressi per il “SI”.

L’esperimento Bernoulliano deve il suo nome alla variabile casuale che descrive ogni

singola prova, la variabile di Bernoulli, che a sua volta porta il nome del matematico che

l’ha introdotta nel calcolo delle probabilità.

2. LA VARIABILE CASUALE BINOMIALE

15

Variabile casuale di Bernoulli

Una variabile casuale discreta che assume solo 2 valori 0 ed 1 con probabilità rispettivamente p ed 1 − p è detta variabile casuale di Bernoulli. Si scrive anche X ∼

Ber(p).

Tale variabile ha le seguenti proprietà

X : P (X = 1) = p; P (X = 0) = 1 − p 0 < p < 1

E(X) = p e Var(X) = p(1 − p)

Attenzione: p non può essere uguale ad 1 o a 0, quindi 0 < p < 1.

Infatti si ha che

E(X) = 1 · P (X = 1) + 0 · P (X = 0) = 1 · p + 0 · (1 − p) = p

e per la varianza

Var(X) = (1 − E(X))2 P (X = 1) + (0 − E(X))2 P (X = 0)

= (1 − p)2 p + (0 − p)2 (1 − p) = (1 − p)(1 − p)p + pp(1 − p)

= p(1 − p)(1 − p + p) = p(1 − p)

Il valore atteso della Bernoulliana ha una lettura intuitiva. Supponiamo di effettuare

un numero elevato di esperimenti, ad esempio il lancio di una moneta regolare (p = 0.5).

Dopo un numero elevato di lanci ci si può aspettare di aver ottenuto circa il 50% di

successi. Il valore atteso della Bernoulliana può quindi leggersi come la frequenza attesa

del numero di successi che otteniamo in un numero di prove elevato.

Spesso nell’ambito di un esperimento Bernoulliano si è interessati a sapere quante

volte si ottiene un successo su n prove, cioè ad esempio, si è interessati a conoscere il

numero di chiamate di telefonia mobile o il numero di “SI” nell’esempio del referendum.

In particolare, essendo l’esperimento di tipo casuale, siamo interessati a conoscere la

probabilità con cui si ottengono un certo numero k di successi su n. Chiaramente k può

essere pari a 0, se non vi sono successi, e poi 1, 2, etc. fino ad n. Prendiamo il seguente

esempio del lancio di una moneta 6 volte. Chiediamoci con quale probabilità possiamo

ottenere 2 successi (T ) in 6 prove. Abbiamo diversi risultati possibili. Indichiamo con 1

il successo, cioè X = 1 quando esce T , e con 0 l’insuccesso. La sequenza di lanci

110000

è una sequenza in cui abbiamo 2 successi e 4 insuccessi, ma anche

100100

è una sequenza analoga. Ciascuna di quelle due sequenze ha la stessa probabilità di

verificarsi. Infatti, indichiamo con Xi la variabile di Bernoulli che vale 1, con probabilità

16

p, se alla prova numero i otteniamo un successo:

P (“1 1 0 0 0 000 ) = P (X1 = 1, X2 = 1, X3 = 0, X4 = 0, X5 = 0, X6 = 0)

= P (X1 = 1) · P (X2 = 1) · P (X3 = 0)

· P (X4 = 0) · P (X5 = 0) · P (X6 = 0)

= pp(1 − p)(1 − p)(1 − p)(1 − p)

= p2 (1 − p)4

Mentre per la seconda sequenza si ha

P (“1 0 0 1 0 000 ) = P (X1 = 1, X2 = 0, X3 = 0, X4 = 1, X5 = 0, X6 = 0)

= P (X1 = 1) · P (X2 = 0) · P (X3 = 0)

· P (X4 = 1) · P (X5 = 0) · P (X6 = 0)

= p(1 − p)(1 − p)p(1 − p)(1 − p)

= p2 (1 − p)4

cioè esattamente lo stesso risultato. Ma in totale abbiamo un numero molto elevato di

sestine composte da due soli “1” e quattro “0”. Le elenchiamo di seguito:

110000 101000 100100 100010 100001

011000 010100 010010 010001 001100

001010 001001 000110 000101 000011

Come si vede sono in tutto 15, risultato che si poteva ottenere con l’utilizzo del coefficiente

binomiale. Infatti, spostare i due “1” all’interno di una sestina, coincide con l’estrarre

2 elementi da un gruppo di 6, cioè scegliere casualmente 2 tra i 6 posti all’interno della

sestina. Quindi in totale sono

6

6 · 5 · 4!

=

= 3 · 5 = 15

4! · 2!

2

In definitiva, la probabilità di ottenere 2 successi su 6 prove corrisponde alla probabilità del

realizzarsi di una delle 15 sestine che abbiamo elencato, ciascuna con la stessa probabilità

di realizzarsi e quindi

P (2 successi su 6 lanci) = P (“1 1 0 0 0 000 ) + · · · + P (“0 0 0 0 1 100 )

= p2 (1 − p)4 +p2 (1 − p)4 +· · · + p2 (1 − p)4

6 2

=

p (1 − p)4

2

6 2

=

p (1 − p)6−2

2

La variabile che in generale descrive il numero di successi che si possono ottenere in

n prove di Bernoulli, è la variabile casuale Binomiale. Questa variabile può essere vista

2. LA VARIABILE CASUALE BINOMIALE

17

come la somma di n variabili casuali Xi di tipo Bernoulli, indipendenti e di parametro p,

cioè

n

X

X1 ∼ Ber(p), X2 ∼ Ber(p), . . . Xn ∼ Ber(p) Y =

Xi .

i=1

Allora Y si dice variabile casuale Binomiale e si indica con Y ∼ Bin(n, p). Le variabili

Xi si dicono essere un campione i.i.d., cioè un insieme di variabili casuali Indipendenti e

Identicamente Distribuite (i.i.d.).

Variabile casuale Binomiale

Se abbiamo un esperimento Bernoulliano costituito da n prove in cui la probabilità del

successo è pari a p, 0 < p < 1, la variabile casuale X che conta il numero di successi

in n prove si chiama Binomiale e si scrive X ∼ Bin(n, p). Tale variabile assume tutti i

valori interi da 0 ad n con la seguente distribuzione di probabilità

n k

P (X = k) =

p (1 − p)n−k , k = 0, 1, . . . , n

k

Tale variabile ha le seguenti proprietà

E(X) = np e Var(X) = np(1 − p)

Se guardiamo al valore atteso della variabile casuale Binomiale possiamo interpretarlo

come numero di medio di successi che ci aspettiamo si realizzi se ripetiamo varie volte

l’esperimento di Bernoulli. Infatti, supponiamo che la probabilità di successo sia 0.3 e di

avere un esperimento composto da n = 100 prove di Bernoulli. Se ripetiamo diverse volte

l’esperimento, è lecito aspettarsi che in media il numero di successi sia circa 30. Ovvero,

in ogni singola sequenza di Bernoulli avremo un numero di successi pari, ad esempio, a 30,

29, 27, 31, 33, etc. La media aritmetica di questi valori dovrebbe essere 30 se l’esperimento

ha funzionato a dovere.

Vediamo un paio di esempi insoliti che coinvolgono l’utilizzo del processo di Bernoulli.

Verso la fine degli anni 80 dello scorso secolo, alcuni giuristi nord-americani sollevarono

la seguente questione: come mai le giurie popolari sono per la maggior parte composte

da persone non di colore? Si tratta del caso oppure no? Cioè siamo in presenza di

discriminazione razziale?

La risposta può essere data in questi termini. I dati considerati riguardavano le giurie

popolari istituite in alcuni stati del sud degli Stati Uniti tra gli anni ’60 e ’80. Negli USA,

i giurati vengono estratti a gruppi di 80 persone dalla popolazione USA elegibile. Chi

sostenne la causa mostrò che in media le giurie popolari contenevano non più di 4 afroamericani. La popolazione in quegli stati e in quel periodo era per circa il 50% composta

da afro-americani. L’idea è quella di confutare l’ipotesi, prevista dalla legge, che i giurati

siano eletti in modo casuale. Quindi se X indica la variabile casuale che conta il numero

di afro-americani in una giuria di 80 persone, X è una variabile casuale Binomiale di

parametri n = 80 e p = 0.5. Dobbiamo calcolare la probabilità P (X ≤ 4), ma si tratta di

18

un numero impressionantemente piccolo, infatti, tralasciando i passaggi intermedi, si ha

P (X ≤ 4) ' 0.0000000000000000014

Cioè pensare che la composizione delle giurie sia avvenuta “cosı̀ per caso”, cioè per selezione casuale, è un evento quasi impossibile. Per convincere i legislatori che tale numero

è effettivamente un numero piccolissimo, gli studiosi sottolinearono che quella probabilità è più piccola della probabilità di fare 3 scale reali consecutive nel gioco del poker! I

legislatori a quel punto non ebbero dubbi.

Un altro esempio irrituale dell’uso del processo di Bernoulli riguarda le frontiere degli stati. In particolare, la storia che raccontiamo è basata su un’esperienza realmente

condotta dalla polizia di frontiera al confine tra Stati Uniti e Messico. L’idea è la seguente. Nei punti di frontiera ad alto flusso di passaggi come quella USA-Messico, spesso è

improponibile pensare di passare al setaccio tutte le persone che chiedono di passare, in

particolare se le perquisizioni richiedono attenzioni particolari come quelle per l’identificazione degli stupefacenti. Non è neanche un metodo fruttuoso far scegliere al doganiere chi

perquisire e chi no, perché molto spesso l’aspetto fisico non permette da solo di identificare

i soggetti, cioè l’abito non fa il monaco!

È stato allora proposto di perquisire i passanti con un meccanismo di tipo casuale. Ad

ogni persona che chiede di passare la frontiera si osserva una lampada. Se la lampada si

accende si perquisisce la persona altrimenti la si lascia andare. La lampada viene accesa in

modo casuale attraverso la simulazione di un processo di Bernoulli che ha come parametro

p la percentuale, nota da studi precedenti, di persone che passano la frontiera in modo

illegale (ovvero trasportando stupefacenti, armi, etc). I risultati dell’esperimento hanno

mostrato che il numero di persone fermate è risultato più elevato utilizzando la selezione

casuale che non il fiuto del doganiere. Questa tecnica, adeguatamente raffinata, viene

utilizzata oggi in diversi punti di frontiera.

2.1. Esercizi riepilogativi. Vediamo ora una serie di esercizi basati sul processo di

Bernoulli. Come si vedrà, la risoluzione degli esercizi è piuttosto meccanica se si riesce ad

identificare correttamente il processo di Bernoulli sottostante.

Esercizio 5. Si considerino le estrazioni del gioco del lotto della ruota di Genova. Sia

p la probabilità che il numero 39 appaia ad ogni singola estrazione settimanale. Quanto

vale p? Qual è la probabilità che alla 30-esima estrazione il 39 non sia ancora uscito?

Se non è uscito nelle prime 100 estrazioni qual è la probabilità che esca alla 101-esima?

Quale quella che esca esattamente alla 130-esima settimana se non è uscito nelle prime

100 estrazioni? Qual è la probabilità che esca almeno 2 volte in 10 settimane?

Nel gioco del lotto vi sono 90 numeri e se ne estraggono 5 senza reimmissione (o in

blocco).

a) I casi possibili, cioè tutte le possibili cinquine estraibili dall’urna, sono quindi

90

= casi possibili

5

2. LA VARIABILE CASUALE BINOMIALE

19

I casi favorevoli all’evento sono tutte le cinquine che hanno un numero fisso, nel

nostro caso il 39, e i restanti 4 scelti tra i restanti 89 numeri disponibili, e dunque

1 89

= casi favorevoli

1

4

Concludendo si ha

casi favorevoli

p=

=

casi possibili

89

4

90

5

=

89!

4!85!

90·89!

85!5·4!

=

5

= 0.05̄

90

b) La probabilità che alla 30-esima estrazione il 39 non sia ancora uscito è pari

alla probabilità che vi siano in sequenza di 30 “insuccessi”, cioè numeri diversi

dal 39. Le estrazioni sono indipendenti e ripetute, siamo allora in uno schema

di Bernoulli con probabilità di successo pari a p, dunque la probabilità di 30

insuccessi è pari a

30

85

30

(1 − p) =

= 0.18

90

c) Sapere che non è uscito nelle prime 100 estrazioni non ha alcuna influenza su quello che accade nella successiva per l’indipendenza delle prove, quindi la probabilità

rimane invariata, cioè p.

d) Sappiamo che non è uscito nelle prime 100 estrazioni ed ora chiediamo che il 39

esca solo alla 130-esima settimana vuol dire che per 29 settimane dopo la 100esima si devono avere degli insuccessi e solo alla 30-esima (dopo la 100-esima)

il successo, quindi la probabilità richiesta è

29

85

5

29

(1 − p) · p =

= 0.01

·

90

90

e) Qui cerchiamo il numero di successi in n = 10 prove, usiamo quindi la variabile

casuale Binomiale. L’evento di cui dobbiamo calcolare la probabilità è P (X ≥ 2)

se X ∼ Bin(n = 10, p = 5/90). Dunque

P (X ≥ 2) = 1 − P (X < 2) = 1 − ( P (X = 0) + P (X = 1) )

10

10 0

85

10

p · (1 − p) =

P (X = 0) =

= 0.56

0

90

9

10 1

5 85

9

= 0.33

P (X = 1) =

p · (1 − p) = 10 ·

90 90

1

Quindi

P (X ≥ 2) = 1 − 0.56 − 0.33 = 0.11

20

Esercizio 6. Mario Dindini sta organizzandosi per fare una serie di uscite giornaliere

in barca a vela. Le statistiche metereologiche giornaliere del periodo riportano che nel 32%

dei giorni si registra cielo sereno ed assenza di vento, nel 53% dei giorni si registra mare

calmo e vento debole e nel restante 15% si registra mare mosso e vento teso. Mario decide

di salpare solo se c’è vento. Supponendo che le condizioni meteo di un giorno siano

indipendenti da quelle dei giorni precedenti e successivi:

a) Qual è la probabilità che vi siano esattamente 3 giornate di vento teso su 5 giorni

consecutivi?

b) Con quale probabilità Mario uscirà più di due volte in 10 giorni consecutivi?

Ciò che accade ogni giorno è indipendente da ciò che accade nei giorni successivi e

ogni giorno gli stessi eventi hanno la stessa probabilità di verificarsi. Si tratta quindi di

un modello di prove ripetute.

a) Sia A l’evento “c’è vento teso”, allora P (A) = 0.15 e P (Ā) = 1 − 0.15 = 0.85. Si

tratta di un modello binomiale X di parametri n = 5 e p = 0.15, quindi si deve

calcolare:

5

P (X = 3) =

· 0.153 · 0.852 = 10 · 0.003375 · 0.7225 = 0.024

3

b) Ora l’evento su cui concentrarsi è A = “c’è vento” = “c’è vento teso o vento

debole” dunque P (A) = 0.15 + 0.53 = 0.68 e P (Ā) = 1 − 0.68 = 0.32. Si tratta di

un modello binomiale X di parametri n = 10 e p = 0.68, quindi si deve calcolare:

P (X > 2) = 1 − (P (X = 0) + P (X = 1) + P (X = 2))

10

P (X = 0) =

0.680 · 0.3210 = 1 · 1 · 0.0000126 = 0.0000126

0

10

P (X = 1) =

0.681 · 0.329 = 10 · 0.68 · 0.0000352 = 0.000239

1

10

P (X = 2) =

0.682 · 0.328 = 45 · 0.4624 · 0.0001099 = 0.002288

2

Quindi P (X > 2) = 1 − 0.002538 = 0.997, cioè Mario uscirà quasi certamente in

barca più di 2 volte in 10 giorni.

Esercizio 7. Un esame consiste in due test a risposta multipla. Il primo test ha 3

possibili risposte di cui una sola corretta e il secondo test consiste in 5 possibili risposte

di cui ancora una sola corretta. L’esame si ritiene superato se si risponde correttamente

ad entrambe le domande. Uno studente sceglie a caso una risposta per il primo test e una

risposta per il secondo test. Indicando con Y il numero totale di risposte esatte

a) Calcolare la probabilità che lo studente superi l’esame.

b) Calcolare media e varianza di Y .

2. LA VARIABILE CASUALE BINOMIALE

21

Lo studente passa l’esame se Y = 2, quindi calcoliamo P (Y = 2). Se indichiamo con

X1 il risultato del primo test e con X2 quello del secondo, quindi dire Y = 2 vuol dire

che X1 = 1 e, contemporaneamente, X2 = 1. Dunque in termini di probabilità si deve

calcolare

P (Y = 2) = P (X1 = 1 ∩ X2 = 1) = P (X1 = 1) · P (X2 = 1)

1 1

1

= · =

3 5

15

in quanto le risposte al test sono indipendenti. Per rispondere ai quesiti successivi si

tiene conto del fatto che in realtà Y = X1 + X2 , ma X non è una Binomiale in quanto la

probabilità di successo varia ad ogni prova. Però

E(Y ) = E(X1 + X2 ) = E(X1 ) + E(X2 ) =

1 1

8

+ =

3 5

15

e, sempre per l’indipendenza,

Var(X) = Var(X1 + X2 ) = Var(X1 ) + Var(X2 )

86

12 14

+

=

= 0.382

=

33 55

225

Esercizio 8. In un remoto angolo della nostra Galassia esiste un pianetino dotato di

un bizzarro sistema elettorale. Poiché vi sono due soli partiti (SX e DX) e, da sempre, la

popolazione accorda il 70% di preferenze al partito SX e il restante 30% al partito DX, per

dare al partito DX la possibilità di governare, vengono estratti a caso dalla popolazione

totale 10 grandi elettori. Le elezioni sono vinte dal partito che riceve almeno 6 voti tra i

10 espressi da questi grandi elettori.

a) Con quale probabilità il partito DX vince le elezioni?

b) Quanti voti ricevono mediamente i due partiti?

Si tratta di uno schema binomiale con n = 10 prove, in cui la probabilità di successo

la poniamo pari alla probabilità di votare DX. Indichiamo quindi con X ∼ Bin(10, 0.3)

la somma dei voti ricevuti dal partito DX. Dobbiamo calcolare

P (X > 5) = 1 − P (X ≤ 5) = 1 − P (X = 0) + P (X = 1)+

+ P (X = 2) + P (X = 3) + P (X = 4) + P (X = 5)

22

10

P (X = 0) =

0.30 · 0.710 = 0.710 = 0.028

0

10

P (X = 1) =

0.31 · 0.79 = 10 · 0.3 · 0.79 = 0.121

1

10

10 · 9 · 8! 2 8

0.3 0.7 = 0.233

P (X = 2) =

0.32 · 0.78 =

2 · 8!

2

10 · 9 · 8 · 7! 3 7

10

P (X = 3) =

0.33 · 0.77 =

0.3 0.7 = 0.267

3

3! · 7!

10

10 · 9 · 8 · 7 · 6! 4 6

P (X = 4) =

0.34 · 0.76 =

0.3 0.7 = 0.200

4

4! · 6!

10

10 · 9 · 8 · 7 · 6 · 5! 5 5

0.3 0.7 = 0.103

P (X = 5) =

0.35 · 0.75 =

5! · 8!

5

Quindi P (X > 5) = 1 − (0.028 + 0.121 + 0.233 + 0.267 + 0.2 + 0.103) = 0.048. Ovviamente

in questo caso conveniva calcolare direttamente la probabilità richiesta scrivendo

P (X = 6) + P (X = 7) + P (X = 8) + P (X = 9) + P (X = 10)

calcolando 5 termini anziché 6. Il numero medio di voti ricevuti dai due partiti sono

rispettivamente 3 e 7 per il partito DX e SX ottenuti con valor medio di una variabile

casuale binomiale (E(X) = n · p = 10 · 31 nel caso DX.)

3. VARIABILE CASUALE GAUSSIANA

23

3. Variabile casuale Gaussiana

Uno degli aspetti più inquietanti del caso è che esso sembra pervadere il mondo fisico

più di quanto non si immagini. Abbiamo già detto che le variabili aleatorie non sono

altro che modelli matematici per descrivere le manifestazioni del caso e la probabilità è lo

strumento di misura necessario per poter parlare correttamente di caso senza ambiguità.

Il fisico Henri Poincaré (1854-1912), in un suo celebre brano di inizio secolo2, riporta la

seguente frase di J.Bertrand (1899) “Con che ardire si può parlare delle leggi del caso?

Il caso non è forse l’antitesi di ogni legge?”. Questa provocazione serve a ricordarci

che il termine caso non deve essere frainteso con il termine ignoranza. Nelle discipline

economiche è d’uso distinguere tra il termine rischio ed incertezza per distinguere le due

situazioni in cui l’esito di un’azione è riconducibile ad un modello casuale (il caso vero e

proprio) e quella in cui non sono disponibili modelli descrittivi (ignoranza degli esiti).

Tornando al mondo fisico cui si accennava sembra proprio che la variabile casuale

Gaussiana (chiamata anche Normale, degli errori accidentali, etc.) regni sovrana tanto

che biologi, fisici e sociologi ne rivendicano la paternità. Tra le ricorrenze importanti della

Normale c’è quella che riguarda la distribuzione delle misure di quantità fisiche del mondo

animale, ed in particolare umane, come la distribuzione delle altezze, della lunghezza di

parti anatomiche (avambracci, femori, orecchie, mignoli della mano sinistra e quant’altro).

Ricordiamo che una variabile casuale continua è ben definita quando: i) si specifica

l’intervallo di valori che può assumere e ii) viene indicata la sua funzione di densità. Per

la variabile casuale Normale standard si ha che la densità assume la seguente forma

x2

1

(2)

f (x) = √ e− 2 ,

x∈R

2π

dove x ∈ R vuol dire che la funzione f (x) è definita per ogni numero reale x.

La formula contiene due delle più importanti costanti matematiche: il numero e che è

la base dei logaritmi naturali e il numero π noto dalle scuole medie inferiori attraverso la

formula del calcolo dell’area di un cerchio di raggio r: A = πr2 .

La variabile casuale Normale standard si indica generalmente con la lettera Z dell’alfabeto. Abbiamo visto che può dunque assumere qualunque valore dell’asse reale z anche se

gli eventi di cui ha senso calcolare le probabilità sono gli intervalli del tipo P (a < Z < b)

poiché, come per tutte le variabili aleatorie continue, si ha sempre P (Z = z) = 0 per ogni

valore di z (si ricordi l’esempio della Ruota della Fortuna).

Gauss è sicuramente uno dei padri di tale distribuzione e ne fornı̀ una derivazione

partendo dall’osservazione di misure fisiche. Si accorse che misurando più volte una certa

quantità può accadere che la misura dell’oggetto vari di poco. Se m è la vera misura

dell’oggetto e xi è la misurazione i-esima eseguita, gli errori di misura sono definiti, come

i residui nell’analisi di regressione, dalla differenza ei = xi − m. A volte risulteranno

errori per eccesso a volte per difetto. Se consideriamo la media di tutte le misure xi

ci aspettiamo che sia pari ad m. Se gli errori di misurazione che commettiamo sono di

2Le

hasard, Revue du mois, III 1907 che è possibile trovare tradotto con Il caso in: H. Poincaré,

Geometria e caso, Universale Bollate Boringhieri, 1995.

24

−5

−3

−1

0

1

3

5

x

Figura 6. Grafico della densità di probabilità della variabile casuale Gaussiana

(o Normale) standard

tipo casuale (cioè non indotti sistematicamente dalla nostra sbadataggine ad esempio) e

tracciamo la distribuzione di frequenza dei valori ei ci accorgiamo che la maggior parte

dei valori si concentra attorno allo 0 e poi pochi valori saranno positivi e molto grandi

e altrettanti molto grandi ma con segno negativo. Cioè l’aspetto della distribuzione di

frequenza “allisciata” dovrebbe apparire come nel grafico in Figura 6 che è esattamente

il grafico della densità di una variabile casuale Gaussiana standard.

Per la variabile casuale Normale standard si hanno due proprietà fondamentali: i) il

valore atteso è pari a 0 (E(Z)=0) e la sua varianza è pari ad 1 (Var(X) = 1). La notazione

utilizzata per indicare che una variabile è di tipo gaussiano è la seguente: Z ∼ N (µ =

0, σ = 1) dove µ indica il valore atteso e σ lo scarto quadratico medio della variabile in

questione. Questa notazione lascia intuire che esistono diversi tipi di variabili gaussiane

al variare di µ e σ.

Infatti, la variabile casuale Gaussiana può essere definita in modo più generale da una

densità del tipo che segue

(x−µ)2

1

e− 2σ2

(3)

f (x) = √

2πσ

(si noti che ponendo µ = 0 e σ = 1 la (3) coincide con la (2).) La densità (3) appena

scritta è la densità di una variabile Gaussiana X di media µ e varianza σ 2 e si scriverà

X ∼ N (µ, σ 2 ).

Attenzione: si usa indifferentemente la notazione N (µ, σ) e N (µ, σ 2 ) per indicare

una Gaussiana di valore atteso µ e varianza σ 2 . Di volta in volta il testo chiarirà quale

delle due notazioni stiamo impiegando.

3. VARIABILE CASUALE GAUSSIANA

25

σ=1

σ=2

µ = −4

µ=7

0

0

x

x

(a)

(b)

Figura 7. Grafico delle densità di gaussiane al variare dei parametri µ e σ. In

(a) due variabili normali di varianza pari ad 1 e medie µ = −4 e µ = 7. In (b)

due gaussiane di media nulla ma varianza σ 2 pari ad 1 e 4.

I parametri µ e σ della Gaussiana hanno un’interpretazione molto diretta. Abbiamo

visto che la N (0, 1) ha una densità campanulare simmetrica attorno allo 0 che è anche

la sua media, mediana (per la simmetria) e la moda. Una normale di media µ avrà

le stesse proprietà solo che questa volta il punto di simmetria è proprio µ, ovvero µ è

contemporaneamente la media, la moda e la mediana della variabile casuale.

Il grafico in Figura 7 mostra la densità di due variabili gaussiane di media rispettivamente µ = −4 e µ = 7 con varianza pari ad 1 (Grafico (a)) e di altre due gaussiane di

media nulla ma varianze rispettivamente 1 e 4 (Grafico (b)). Come si vede la media µ è il

centro della distribuzione mentre il fattore σ, cioè la dispersione, agisce come un fattore

di scala ovvero, più è piccola la varianza più la distribuzione è concentrata attorno alla

media e dunque la distribuzione risulta anche essere più “appuntita”, viceversa più aumenta la varianza, più i valori tendono a disperdersi attorno alla media cosı̀ che il grafico

della densità della Normale risulta essere più “appiattito”.

Il termine “standard” viene riservato alla Gaussiana di parametri µ = 0 e σ = 1. Il

motivo fondamentale risiede nel calcolo delle probabilità. Sappiamo che per una variabile

casuale continua, calcolare probabilità del tipo P (X < x) vuol dire eseguire il calcolo di

un integrale, brrr! Cioè

Zx

P (X < x) =

f (u)du

−∞

Se X è la variabile casuale Normale standard, cioè X = Z ∼ N (0, 1) quelle probabilità ci vengono fornite dalle tavole come quelle che troviamo nelle Tabelle ?? e ??.

In particolare, se Z è la variabile Gaussiana standard si usa per convenzione la notazione P (Z < z) = Φ(z) e il valore Φ(z) viene letto sulla tavola. Ad esempio, se vogliamo calcolare la probabilità P (Z < 1.31) dobbiamo prendere la tavola della Tabella

26

??. All’incrocio della riga 1.3 e della colonna 0.01 troviamo il valore 0.90490. Quindi

P (Z < 1.31) = Φ(1.31) = 0.90490.

Supponiamo ora che X sia una Gaussiana di media 1 e varianza 4, dunque X ∼ N (1, 2).

Poniamo l’obiettivo di calcolare P (X < 3). Non ci sono tavole che ci permettono di

calcolare questo tipo di probabilità. Le alternative sono 2: i) calcoliamo l’integrale, ii)

usiamo la testa. Optiamo per la seconda strada e osserviamo quanto segue. Se X ha

media µ, allora X − µ avrà media nulla, infatti

E(X − µ) = E(X) − µ = µ − µ = 0

Se X ha varianza pari a σ 2 allora X/σ ha varianza 1, infatti

1

σ2

Var(X)

=

=1

σ2

σ2

Se mettiamo assieme le due operazioni abbiamo che

X −µ

è tale che E(Z) = 0 e Var(Z) = 1 .

Z=

σ

Quello che abbiamo ottenuto assomiglia molto ad una Normale standard, l’unica cosa di

cui non siamo certi è se realmente la variabile casuale Z cosı̀ costruita sia ancora una

variabile Gaussiana. In realtà lo è perché le operazioni che abbiamo fatto sono state

semplicemente di centrare la variabile X sullo 0 anziché su µ e di riscalarla del fattore

σ in modo tale da ottenere una varianza unitaria. Siamo quindi in grado di calcolare

P (X < 3) “usando la testa”, infatti

X −µ

3−µ

3−1

P (X < 3) = P

<

=P Z<

σ

σ

2

= P (Z < 1) = Φ(1) = 0.84134

Var(X/σ) =

Variabile casuale Gaussiana

Una variabile casuale continua X con densità pari alla (3) è detta Gaussiana di parametri

E(X) = µ e Var(X) = σ 2 . Si usa la notazione X ∼ N (µ, σ 2 ).

La variabile casuale X ∼ N (0, 1) si dice Normale standard.

Ogni variabile casuale X ∼ N (µ, σ 2 ) può essere ricondotta ad una Normale standard

tramite l’operazione di standardizzazione seguente

X −µ

∼ N (0, 1)

Z=

σ

Se vogliamo calcolare le probabilità del tipo P (a < Z < b), cioè Z assume valori

nell’intervallo di estremi a e b, possiamo aiutarci con i grafici. Infatti, rappresentando

graficamente P (a < Z < b) notiamo che,

P (a < Z < b) = P (Z < b) − P (Z < a) = Φ(b) − Φ(a)

come è evidente dalla Figura 8.

3. VARIABILE CASUALE GAUSSIANA

P(a < Z < b)

Φ(b) = P(Z < b)

Φ(a) = P(Z < a)

=

a

0

27

b

–

0

b

a

0

Figura 8. Calcolo di P (a < Z < b) = Φ(b) − Φ(a).

Proviamo ora a calcolare le seguenti probabilità

P (µ − σ < X < µ + σ), P (µ − 2σ < X < µ + 2σ), P (µ − 3σ < X < µ + 3σ)

dove X ∼ N (µ, σ 2 ). Otteniamo i seguenti risultati

µ−µ−σ

X −µ

µ+σ−µ

P (µ − σ < X < µ + σ) = P

<

<

σ

σ

σ

= P (−1 < Z < 1) = Φ(1) − Φ(−1)

= 0.84134 − 0.15866 ' 0.68

ovvero il 68% di tutti i valori possibili di una Gaussiana si realizzano all’interno dell’intervallo µ ± σ. Per gli altri intervalli otteniamo

µ − µ − 2σ X − µ µ + 2σ − µ

P (µ − 2σ < X < µ + 2σ) = P

<

<

σ

σ

σ

= P (−2 < Z < 2) = Φ(2) − Φ(−2)

= 0.97725 − 0.02275 ' 0.95

µ − µ − 3σ X − µ µ + 3σ − µ

P (µ − 3σ < X < µ + 3σ) = P

<

<

σ

σ

σ

= P (−3 < Z < 3) = Φ(3) − Φ(−3)

= 0.99865 − 0.00135 ' 0.997

In sostanza oltre (±) 3 volte lo scarto quadratico medio la probabilità che si realizzi un

evento della variabile casuale Gaussiana è praticamente nulla. Dal punto di vista

p statistico

ciò vuol dire che se in un campione troviamo valori esterni all’intervallo (x̄n ±3 s̄2n ), questi

valori verrano considerati degli outlier (si ricordi in proposito la legge dei 3-sigma).

Esercizio 9. Soffermiamoci sulle altezze della popolazione, ed in particolare sulla

distribuzione delle altezze della popolazione dei coscritti alla leva di mare e di terra del

1960. Cosı̀ come riportato dall’ISTAT, si può assumere che la distribuzione delle altezze

X segua una legge normale di media µ = 172.7 cm e scarto quadratico medio σ = 6.7

28

cm. Estraendo a caso un individuo da questa popolazione, ci si può chiedere con quale

probabilità:

a)

b)

c)

d)

questo individuo ha un’altezza pari all’altezza media della popolazione;

la sua altezza è inferiore all’altezza media della popolazione;

la sua altezza è superiore a 152 cm;

supponendo che tutti gli individui della popolazione portino scarpe con un tacco

di 10 cm, con che probabilità l’altezza (con scarpe ai piedi) dell’individuo estratto

è superiore a 162 cm.

La risposta alla domanda a) è, per quanto detto poco sopra, pari a zero: infatti X è una

variabile casuale continua e quindi P (X = µ) = 0. Per quanto riguarda i punti successivi,

ricordiamo che ciascuna frase corrisponde ad un evento. In particolare, per il punto b)

la frase non è altri se non l’evento “X < µ”. Dobbiamo quindi calcolare P (X < µ).

Eseguiamo l’operazione di standardizzazione su X, cioè si trasforma la variabile X nella

variabile casuale normale standard Z attraverso la seguente operazione

Z = (X − µ)/σ .

Quindi se effettuiamo la stessa trasformazione all’interno di P (X < x) otteniamo

X −µ

x−µ

x−µ

x−µ

<

=P Z<

=Φ

.

P (X < x) = P

σ

σ

σ

σ

Dunque per rispondere al quesito b) si deve calcolare

µ−µ

1

P (X < µ) = Φ

= Φ(0) = ,

σ

2

che è sempre vera qualsiasi sia la media µ della variabile Gaussiana X essendo µ anche

la mediana di X.

Il punto c) chiede con quale probabilità l’altezza dell’individuo estratto è superiore a 152

cm, il che vuol dire calcolare la probabilità dell’evento “X > 152”. Quindi per calcolare

P (X > 152) ricorriamo all’evento complementare

P (X > 152) = 1 − P (X > 152) = 1 − P (X ≤ 152)

= 1 − P (X < 152)

poiché la Gaussiana è continua

152 − 172.7

152 − µ

=1−Φ

=1−Φ

σ

6.7

= 1 − Φ(−3.1) = 1 − 0.00097 = 0.99903 ' 1 ,

cioè quasi certamente (con probabilità 1) l’altezza dell’individuo è superiore a 152 cm.

Il punto d) descrive una situazione in cui la variabile casuale X viene trasformata

in una nuova variabile casuale Y attraverso una traslazione Y = X + 10. La variabile

3. VARIABILE CASUALE GAUSSIANA

29

casuale Y è ancora una variabile casuale di varianza σ 2 ma media pari a µ + 10. L’evento

di cui ci interessa calcolare la probabilità è “Y > 162”. Procediamo come segue

P (Y > 162) = P (X + 10 > 162) = P (X > 152) = 0.99903 ' 1 ,

come nel punto c).

Terminiamo con qualche proprietà utile che riguarda la variabile aleatoria Normale.

Questa volta però utilizziamo un’altra proprietà della curva normale: la simmetria rispetto

alla propria media µ. Se prendiamo un numero z > 0 qualsiasi, possiamo calcolare la

P (|Z| < z) = P (−z < Z < z) come segue

P (|Z| < z) = P (−z < Z < z) = Φ(z) − Φ(−z) = 2Φ(z) − 1

poiché Φ(−z) = 1 − Φ(z) essendo la densità f (·) una funzione simmetrica rispetto allo 0

(la Figura 9 illustra questa proprietà). Dal fatto che P (|Z| < z) = 2Φ(z) − 1 deriva anche

che

P (|Z| > z) = P (Z > z, Z < −z) = 1 − (2Φ(z) − 1) = 2(1 − Φ(z)) .

Φ(− z) = 1 − Φ(z)

−z

0

z

Figura 9. Proprietà di simmetria della densità della variabile casuale

Gaussiana: f (z) = f (−z) e quindi Φ(−z) = 1 − Φ(z).

Infine, se X ∼ N (µ1 , σ12 ) e Y ∼ N (µ2 , σ22 ) sono indipendenti allora la variabile casuale

W = X + Y è ancora una variabile Gaussiana del tipo W ∼ N (µ1 + µ2 , σ12 + σ22 ).

30

Proprietà utili per la variabile casuale Gaussiana

Se X ∼ N (µ, σ 2 ) allora:

i) Se a e b sono due numeri non aleatori si ha che

a + bX ∼ N (a + b µ, b2 σ 2 )

ii) per il calcolo delle probabilità si deve ricordare che

x−µ

P (X < x) = Φ

σ

iii) per le proprietà di simmetria si ha che

Φ(−z) = 1 − Φ(z)

e quindi

P (|Z| < z) = P (−z < Z < z) = 2Φ(z) − 1

e

P (|Z| > z) = P (Z > z, Z < −z) = 2(1 − Φ(z))

iv) se X ∼ N (µ1 , σ12 ) e Y ∼ N (µ2 , σ22 ) sono indipendenti allora

W = X + Y ∼ N (µ1 + µ2 , σ12 + σ22 )

3.1. Approssimazione della Binomiale con la Gaussiana. Un altro modo di

derivare la variabile casuale Gaussiana è come limite della variabile casuale Binomiale. Il

problema con cui ci si scontra di frequente è che spesso il numero di prove n è piuttosto

elevato. Quando si effettuano i calcoli con la variabile casuale Binomiale, si incappa

necessariamente nel calcolo dei coefficienti binomiali che, abbiamo già visto, quando i

valori sono molto elevati diventano numeri intrattabili. De Moivre, si accorse che quando

p = 0.5, la distribuzione della variabile Binomiale X è simmetrica rispetto alla sua media,

cioè np. Effettuando l’operazione di standardizzazione sulla X in analogia a quanto già

visto, si ottiene che

X − E(X)

X − np

Z= p

=p

∼ N (0, 1)

Var(X)

np(1 − p)

cioè siamo ancora in presenza di una Gaussiana. L’approssimazione si può ritenere valida

se n supera 30. Più tardi ci si accorse che l’approssimazione vale anche quando p 6= 0.5,

infatti benché in tal caso la distribuzione sia asimmetrica, quando il numero delle prove n

cresce molto viene ad affievolirsi l’effetto dell’asimmetria e vale ancora l’approssimazione

alla Gaussiana della Binomiale standardizzata. La regola empirica dice che quando np ≥ 5

e n(1 − p) ≥ 5 allora può ritenersi valida l’approssimazione.

Esercizio 10. Un venditore contatta dei clienti e mediamente conclude una vendita 1

volta su 8. Calcolare in modo approssimato la probabilità che su 100 clienti si concludano

tra 6 e 10 vendite.

3. VARIABILE CASUALE GAUSSIANA

31

Siamo di fronte ad un processo di Bernoulli con n = 100 prove, i clienti, e il “successo”

è rappresentato dalla vendita che avviene con probabilità p = 81 . Quindi il numero totale

di vendite è una variabile casuale X ∼ Bin(n = 100, p = 18 ). Dobbiamo calcolare P (6 ≤

X ≤ 10). Usiamo l’approssimazione alla variabile casuale normale che si ottiene attraverso

la trasformazione

X − np

Z∼p

n p (1 − p)

L’approssimazione è lecita poiché np = 100 · 18 = 12.5 ≥ 5 e n(1 − p) = 100 · 78 = 87.5 ≥ 5.

Quindi

!

6 − 12.5

X − np

10 − 12.5

P (6 ≤ X ≤ 10) = P

≤p

≤

3.307

3.307

n p (1 − p)

' P (−1.97 < Z < −0.76) = Φ(−0.76) − Φ(−1.97)

dove

Φ(−0.76) = 1 − Φ(0.76) = 1 − 0.77637

e

Φ(−1.97) = 1 − Φ(1.97) = 1 − 0.97558

da cui segue che

P (6 ≤ X ≤ 10) ' 0.19921

Esercizio 11. Si supponga di fare n = 25 lanci di una moneta non truccata. Calcolare

la probabilità di fare al massimo 14 teste.

Indichiamo con X ∼ Bin(n = 25, p = 0.5) la variabile casuale che conta il numero di

teste in 25 lanci. Ci è richiesto di calcolare P (X ≤ 14). Il valore esatto della probabilità

è pari a 0.7878. Proviamo ad utilizzare l’approssimazione Normale, sapendo che n < 30

e vediamo cosa accade. Ci servono i valori np = 25 · 21 = 12.5 e np(1 − p) = 25 · 14 = 6.25

√

e quindi 6.25 = 2.5. Dunque

14 − 12.5

P (X ≤ 14) ' P Z ≤

= Φ(0.6) = 0.7257

2.5

come si vede la differenza dei valori delle probabilità cosı̀ calcolate è notevole. Se n è

piccolo come in questo caso, si può apportare una piccola modifica detta correzione di

continuità che consiste nell’aggiungere 0.5 al valore di cui si deve calcolare la probabilità,

cioè anziché calcolare P (X ≤ 14) si calcola P (X ≤ 14 + 0.5). Vediamo cosa accade

14.5 − 12.5

P (X ≤ 14.5) ' P Z ≤

= Φ(0.8) = 0.7881

2.5

che come si nota è un valore approssimato molto più vicino a quello vero del valore

calcolato con l’approssimazione alla Normale semplice.

32

Il risultato è in realtà molto più generale e prende il nome di Teorema del Limite

Centrale3. Questo teorema afferma che se abbiamo delle Xi i.i.d. (indipendenti ed iden2

ticamente distribuite),

Pncon stessa media µ e varianza σ finite, allora la distribuzione di

probabilità di Y = i=1 Xi , opportunamente standardizzata, può essere approssimata

con quella di una Gaussiana, cioè

Y − E(Y )

Z= p

∼ N (0, 1)

Var(Y )

Torneremo presto su questo risultato.

3.2. Esercizi riepilogativi.

Esercizio 12. La temperatura superficiale di un satellite geostazionario si distribuisce

come una variabile aleatoria Normale di media 7o C e scarto quadratico medio 14o C. Con

quale probabilità la temperatura del satellite è a) superiore a 32o C, b) uguale a 29o C, c)

in modulo più grande di 30o C, d) compreso tra 0o C e 10o C?

Sappiamo che X ∼ N (µ = 7, σ 2 = 142 ).

a) Si deve calcolare P (X > 32) ricorriamo alla standardizzazione

X −µ

32 − µ

P (X > 32) = P

>

σ

σ

32 − 7

= 1 − P (Z < 1.79)

=P Z>

14

= 1 − 0.96 = 0.04

b) P (X = k) = 0 qualsiasi sia k se X è una variabile casuale continua come il caso

della Normale.

c) Si deve calcolare P (|X| > 30). Dunque

P (|X| > 30) = P (X > 30 ∪ X < −30) = P (X > 30) + P (X < −30)

dove

30 − µ

P (X > 30) = 1 − P (X < 30) = 1 − P Z <

σ

= 1 − P (Z < 1, 64) = 1 − 0.95 = 0.05

−30 − µ

P (X < −30) = P Z <

σ

= P (Z < −2.64) = 0.004

3Qualsiasi

modello probabilistico si scelga, sotto ipotesi molto generali, al crescere del numero delle

replicazioni, la somma standardizzata di variabili casuali tende a distribuirsi come una Normale. L’aggettivo “centrale” è quindi riferito al ruolo cruciale che la distribuzione Gaussiana riveste nella teoria

della probabilità. In alcuni testi si parla di teorema centrale del limite, si sposta quindi l’aggettivo sul

sostantivo teorema per indicare che questo risultato è uno tra i fondamentali, forse il più importante, in

tutta la teoria asintotica della probabilità. Entrambe le interpretazioni-collocazioni del termine “centrale”

appaiono giustificate.

3. VARIABILE CASUALE GAUSSIANA

33

Cioè P (|X| > 30) = 0.05 + 0.004 = 0.054. Il risultato si poteva ottenere anche

passando all’evento complementare, cioè

P (|X| > 30) = 1 − P (−30 < X < 30) = 1 − (P (X < 30) − P (x < −30))

si sarebbe ottenuto lo stesso risultato.

d) Si deve calcolare P (0 < X < 10) cioè

P (0 < X < 10) = P (X < 10) − P (X < 0)

3

7

=P Z<

−P Z <−

14

14

= P (Z < 0.21) − P (Z < −0.5) = 0.58 − 0.31 = 0.27

Esercizio 13. Il tempo di rotazione (X, in minuti) attorno alla Terra di un satellite

artificiale si distribuisce secondo la distribuzione Normale di media 30 minuti. Sapendo

che P (X ≤ 29.4) = 0.4522:

a) Determinare la varianza di X.

b) Con quale probabilità il tempo impiegato sarà minore di 28 minuti?

c) Con quale probabilità il tempo impiegato sarà compreso tra 25 e 32 minuti?

Si utilizzi la seguente tabella della variabile Z Normale standardizzata:

Φ(z) 0.3446 0.3594 0.3707 0.5478 0.6406 0.7642 0.8413

z

-0.4

-0.36 -0.33

0.12

0.36

0.72

1.00

L’informazione che abbiamo è che X ∼ N (µ = 30, σ 2 =?) e P (X ≤ 29.4) = 0.4522.

Ma

a)

29.4 − µ

X −µ

<

0.4522 = P (X ≤ 29.4) = P

σ

σ

29.4 − 30

0.6

=P Z<

=P Z<−

σ

σ

per trovare σ dobbiamo risolvere l’equazione 0.4522 =

Se indichiamo con z = − 0.6

σ

P (Z < z) cioè dobbiamo cercare quel valore di z che ci fornisce P (Z < z) =

0.4522. Sulla tavola troviamo che P (Z < 0.12) = 0.5478 = 1 − 0.4522 cioè

1 − P (Z < 0.12) = 0.4522. Ma allora P (Z > 0.12) = 0.4522 e quest’ultima

probabilità, per la simmetria della variabile casuale normale, è pari a P (Z <

−0.12).

In conclusione 0.4522 = P (Z < −0.12) cioè lo z che stiamo cercando è proprio

z = −0.12, allora

0.6

−0.12 = −

σ

per cui σ = 5.

34

b) Ora sappiamo quindi che X ∼ N (µ = 30, σ 2 = 25). Dobbiamo calcolare

28 − 30

P (X < 28) = P Z <

= P (Z < −0.4) = 0.3446

5

c) Mentre P (25 < X < 32) si ottiene nel seguente modo

P (25 < X < 32) = P (X < 32) − P (X < 25) = Φ(0.4) − Φ(−1)

dove

Φ(0.4) = 1 − P (Z > 0.4) = 1 − Φ(−0.4)

e

Φ(−1) = 1 − P (Z > −1) = 1 − Φ(1)

e quindi

P (25 < X < 32) = 1 − P (Z < −0.4) − (1 − P (Z < 1))

= P (Z < 1) − P (Z < −0.4) = 0.8413 − 0.3446

= 0.4967

Esercizio 14. Uno studente prende il treno e poi la metropolitana per recarsi all’università. Supponiamo che i tempi di viaggio dei due mezzi siano variabili casuali normali

indipendenti con medie 20 e 10 minuti e deviazione standard rispettivamente 5 e 2 minuti.

Calcolare la probabilità che il tempo totale di viaggio sia compreso tra 25 e 35 minuti.

Indichiamo con X ∼ N (20, 52 ) il tempo di percorrenza in treno e con Y ∼ N (10, 22 )

il tempo di percorrenza in metropolitana. Il tempo totale T è allora ancora una variabile

casuale Gaussiana di parametri la somma delle medi di X ed Y e la somma delle varianze

delle stesse variabili casuali per l’indipendenza. Quindi T ∼ N (20 + 10, 52 + 22 ) =

N (30, 29). Si deve calcolare

25 − 30

X − 30

35 − 30

√

P (25 < T < 35) = P

< √

< √

29

29

29

= P (−0.93 < Z < 0.93)

= P (Z < 0.93) − P (Z < −0.93)

= P (Z < 0.93) − (1 − P (Z < 0.93))

= 2 · P (Z < 0.93) − 1

= 2 · 0.82381 − 1

= 0.64762

Scarica