Indice

1 CATENE DI MARKOV

1.1

1.2

1.3

1.4

1.5

1.6

Introduzione . . . . . . . . . . . . . . . . . . . . .

Descrizione probabilistica delle catene di Markov .

Matrice di transizione, catene omogenee . . . . .

Classicazione degli stati . . . . . . . . . . . . . .

Teoria ergodica per le catene di Markov . . . . . .

Catene di nascita o morte . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2

2

6

11

18

27

38

2 PROCESSI STOCASTICI A TEMPI DISCRETI: TRATTAZIONE GENERALE

45

2.1

2.2

2.3

2.4

2.5

2.6

2.7

2.8

Premessa e prime denizioni . . . . . . . . . . . . . . . . . . . 45

La descrizione hilbertiana dei processi discreti . . . . . . . . . 53

La predizione lineare ottimale (caso nito) . . . . . . . . . . . 71

Operatori lineari in uno spazio di Hilbert e loro rappresentazione matriciale. Propagazione della covarianza . . . . . . . . 82

Operatori causali e processi con lo stesso ordine temporale . . 86

Innovazione processi regolari decomposizione di Cholesky . . 96

Il problema della predizione lineare ottimale caso innito . . . 102

Un'applicazone al ltro di Kalman-Bucy . . . . . . . . . . . . 106

3 I PROCESSI STAZIONARI

3.1

3.2

3.3

3.4

3.5

3.6

118

Processi stazionari in senso stretto . . . . . . . . . . . . . . . 118

Processi stazionari in senso debole . . . . . . . . . . . . . . . . 122

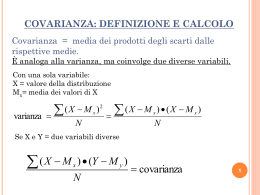

Funzione di covarianza: caratteristiche . . . . . . . . . . . . . 127

Lo spettro di potenza ed il calcolo spettrale . . . . . . . . . . 134

La predizione ottimale calcolo di M ed A dallo spettro . . . . 145

Problemi di stima della funzione di covarianza e dello spettro . 151

1

3.7 Processi semplici . . . . . . . . . . . . . . . . . . . . . . . . . 161

1 CATENE DI MARKOV

Premessa

Le catene di Markov costituiscono una particolare classe di processi stocastici, essendo costituite da una famiglia di variabili casuali denite in funzione

di un parametro mono-dimensionale o n-dimensionale discreto che interpreteremo come un tempo, n 2 N + f0 1 2 3 : : :g. Per esse quindi si puo

denire un \prima" e un \dopo" ed una corrispondenza con il principio di

causa ed eetto. La possibilita di individuare un senso obbligato (il \prima"

puo causare il \dopo" ma non puo essere il viceversa) determina anche la

trattazione matematica del problema.

Poiche il parametro varia per ipotesi in maniera discreta, il processo stocastico puo essere visto come la generalizzazione di una variabile tempo casuale

n-dimensionale: se X (n) = X0 X1 X2 : : : Xn]+ e una variabile le cui estrazioni sono in IRn+1 X (1) = X0 X1 X2 : : : Xn : : :]+ e una variabile casuale

in IR1(IR1 e il suo insieme di denizione) e ogni estrazione e rappresentata

da una successione di numeri reali.

1.1 Introduzione

Consideriamo ora tra le serie temporali quella classe il cui insieme di denizione e un reticolo in IR1, ottenuto dal prodotto cartesiano di sottoinsiemi

di IR discreti e niti. I punti di sono quindi successioni di numeri, ognuno

dei quali puo avere un valore scelto in un insieme discreto e nito di IR ogni

punto, ovvero ogni successione di questo tipo costituisce una realizzazione

del processo.

Le variabili marginali Xk di tali processi stocastici

X = fX0 X1 X2 : : : Xk : : :g non sono delle variabili casuali continue denite in IR, ma delle variabili casuali discrete con un numero nito di valori

argomentali.

Un esempio molto semplice e rappresentato dal lancio di una moneta innite

volte.

2

In tal caso, al variare di k Xk puo assumere solo due valori, testa o croce,

ovvero 0,1, ovvero -1,1, con probabilita 21 21 .

I valori che Xk puo assumere verranno di seguito indicati come stati del

sistema.

Fig.1.1.1

In Fig. 1.1.1 sono stati indicati i valori argomentali rispettivamente della marginale X0, della marginale (X0 X1), della marginale (X0 X1 X2) del

processo in esame. Essi sono ottenuti dal prodotto cartesiano dell'insieme discreto e nito (0,1) con se stesso 1, 2, volte rispettivamente per le marginali

a 2 e 3 dimensioni.

Un caso piu complesso e rappresentato dal RANDOM WALK 1 .

Gli stati del processo sono, al variare di k:

s0 = x0

s1 = x0 + x1

:::

sk = x0 + x1 + : : : + xk

:::

(1.1.1)

in cui xk e il risultato del \lancio di una moneta".

Non rientra, a rigore, nella classe delle catene di MARKOV, in quanto l'insieme dei

possibili stati del sistema varia da istante a istante e non e limitato nel tempo

1

3

Una tipica realizzazione del processo, puo essere rappresentata come in Fig.

1.1.2 quando xk puo assumere i valori (0,1)

Fig. 1.1.2

o come in Fig. 1.1.3

Fig. 1.1.3

quando xk puo assumere i valori (-1,1).

Caratteristica fondamentale di tali processi e che lo stato del sistema al tempo

k +1 dipende da quello al tempo k, ma e indipendente da come si e arrivati a

tale istante. In termini probabilistici cio si puo esprimere nel seguente modo:

P fSk+1 = sk+1jSk = sk Sk;1 = sk;1 : : : S0 = s0 g =

= P fSk+1 = sk+1jSk = sk g

(1.1.2)

4

Cio esprime la proprieta di Markov in senso debole.

Denizione 1.1.1: una CATENA DI MARKOV e un processo stocastico

il cui insieme di denizione e un reticolo in IR1 , in cui una qualunque

distribuzione condizionata soddisfa alla proprieta di Markov.

Osservazione 1.1.1: da un punto di vista sico, la proprieta di Markov

signica che, denito lo stato del sistema al tempo t, l'evoluzione successiva

del sistema stesso raccoglie come unica informazione sul suo passato proprio

il valore di xt , mentre la successive variazioni sono legate ad una qualche

causa stocastica, una \innovazione", indipendente dal passato.

Un notevole modello generale per leggi di questo tipo potrebbe essere

xk+1 = xk + g(xk "k+1)

(1.1.3)

che ovviamente traduce a tempi discreti una equazione dierenziale (o un

sistema di equazioni dierenziali se xk e una variabile pluridimensionale) del

tipo

x_ = g(x ")

(1.1.4)

Perche una equazione come la (1.1.4) dia luogo ad un processo di tipo markoviano basta assumere che "k+1 sia stocasticamente indipendente da "k;1 "k;2 : : :

in tal caso infatti, e facile vedere che e soddisfatta la (1.1.4). Per avere una

vera e propria catena di Markov, occorre anche supporre di discretizzare i

valori assunti da xk e che questi siano in numero limitato.

Riassumendo, nello studiare un particolare tipo di processi di Markov che

chiameremo Catene di Markov incontreremo sempre la seguente situazione:

sia dato un insieme discreto e nito dato l'insieme degli stati

S = fs1 s2 : : : smg 2 IR l'insieme degli eventi elementari del nostro processo e formato da un

reticolo regolare nito

r = S S : : : S : : : = S1 :

5

1.2 Descrizione probabilistica delle catene di Markov

Si consideri una catena associata ad una sequenza nita di tempi

k = 0 1 2 : : : N i possibili risultati si rappresentano in IRN +1 come una

successione di punti ognuno di coordinate (x0 x1 x2 : : : xN ) e l'insieme degli stati S e costituito da m valori reali qualsiasi o da m punti e sempre

possibile immaginare di trasformare la variabile x in modo tale che i nuovi

valori argomentali siano esattamente xk = i i = 1 2 : : : m. La descrizione

probabilistica di questa catena sara poi data dall'insieme delle probabilita

discrete

P fX0 = x0 X1 = x1 : : : XN = xN g = p(N ) (x0 x1 : : : xN ) :

(1.2.1)

Si noti che, come sempre nelle variabili a piu dimensioni, e la distribuzione

congiunta (1.2.1) che conta e non le singole distribuzioni

pi(xi) = P fXi = xi g

(1.2.2)

che sono invece le marginali della (1.2.1).

Il primo dubbio che si potrebbe avere e che, data la natura essenzialmente

discreta del problema, sia possibile, anche per una catena associata ad una

catena innita di tempi, denire una regola di probabilita assegnando le

probabilita punto a punto in , cioe per ogni singola realizzazione.

Dimostreremo tra breve che cio non e possibile perche possiede la potenza

del continuo. Tuttavia cominciamo a cercare di comprendere tale fatto con

un controesempio elementare.

Esempio 1.2.1: sia X = fX0 X1 : : :g la catena che rappresenta 1 lanci

indipendenti di una moneta, cos che ciascuna marginale Xi possa assumere

i valori 0 e 1 rispettivamente con probabilita 1/2, 1/2.

Sia

CN = fX0 = x0 X1 = x1 : : : XN = xN 8XN +1 8XN +2 : : :g (1.2.3)

un insieme in cui siano ssati i primi N + 1 valori. Le probabilita di tali insiemi devono coincidere con la (1.2.1) qualsiasi sia il valore di N e di

x0 x1 x2 : : : xN .

6

Nel nostro caso CN avra probabilita P (CN ) = 21N , cos che, ovviamente,

quando si cerchi la probabilita di una singola realizzazione

1

x = fx0 x1 : : : g = CN =

N =0

1

=

fX0 = x0 X1 = x1 : : : XN = xN g

(1.2.4)

\

\

N =0

risultera

1 =0

P

(

C

)

=

lim

P (x) = Nlim

N

!1

N !1 2N

(1.2.5)

Come si vede cio avviene per ogni realizzazione x, cos che appare ovvio che

la distribuzione su non puo essere ricostruita dalla probabilita delle singole

realizzazioni.

Come gia detto, cio che l'esempio precedente mette in luce e il fatto che ha la potenza del continuo e quindi, come per ogni insieme con tale cardinalita, una distribuzione di probabilita non puo essere denita sommando

probabilita di punti individuali.

Ne segue che, se vogliamo dare una descrizione probabilistica complessiva

della catena in IR1 occorrero arrivare a denire un'opportuna famiglia di

eventi (che deve anche essere una -algebra se si vuole che essa contenga tutte le unioni ed intersezioni numerabili di eventi) e le rispettive probabilita.

E logico poi richiedere che tale famiglia contenga come caso particolare insiemi del tipo (1.2.3) che chiameremo cilindri. Si tratta cioe di costruire una

distribuzione di probabilita, sull'insieme di IR1, che ammetta, per ogni N ,

le (1.2.2) come distribuzioni marginali.

La risposta ovvia, seppur alquanto astratta, al problema puo venire dal

seguente ragionamento:

supponiamo di saper assegnare ad ogni CN una probabilita P , che

soddis le seguenti condizioni di compatibilita (Kolmogorov):

X P fX0 = x0 X1 = x1 : : : XN = xN XN +1 = yg =

y

7

=

X p(N +1)fCN +1(x0 x1 : : : xN y)g =

y

(1.2.6)

= p(N ) fCN (x0 x1 : : : xN )g = P fX0 = x0 X1 = x1 : : : XN = xN g

che esprimono il fatto che ogni p(N ) puo essere vista come distribuzione

marginale di p(N +1) ,

deniamo una famiglia A di eventi che sia la minima -algebra di eventi

che contiene la sottofamiglia dei cilindri

fCN 8N x0 x1 : : : xN g supponiamo di poter estendere per continuita P da CN ad un qualsiasi

A 2 A (vi sono appositi teoremi che dimostrano che tale estensione

e possibile e noi ne vedremo tra breve una versione particolarmente

semplice),

in tal modo avremo denito una distribuzione di probabilita che soddisfa ai

requisiti minimali richiesti.

Naturalmente l'astrattezza del procedimento ci impedisce di comprendere

chiaramente la natura della distribuzione di probabilita cos costruita.

Lemma 1.2.1: ha la potenza del continuo.

Dimostriamo il lemma nel caso semplice che il sistema abbia solo due stati, cui

associamo i valori numerici (0,1) la dimostrazione puo essere generalizzata

in modo semplice al caso in cui il sistema abbia m stati distinti.

Sia # l'applicazione che fa corrispondere alla realizzazione x = fx0 x1 : : :g il

numero reale, compreso tra 0 e 1 (estremi inclusi)

#(x) = x0 12 + x1 212 + x2 213 + : : :

(1.2.7)

E ovvio che, potendo xk assumere al piu i valori 0 o 1,

cioe

#(x) 2 0 1]

(1.2.8)

#(x) : ! 0 1]

(1.2.9)

8

D'altro canto e facile anche vedere che per ogni r 2 0 1] esiste x tale che

#(x) = r

(1.2.10)

In eetti dalla (1.2.7), con ragionamento dicotomico, si vede che se 0 r < 21

si puo scegliere x0 = 0 e se 12 r 1 x0 = 1 se 0 r < 41 allora x1 = 0

e se invece 14 r < 12 x1 = 1 e cos via. Procedendo con tale criterio si

determina una successione fxk g tale che

XN 1 1

r ; xk k+1 < N +1

k=0 2 2

(1.2.11)

che, per N ! 1, dimostra la (1.2.10).

E bene notare che # non e biunivoca in eetti #;1 e non univoca per tutti i

punti con ascissa del tipo

r = 2kN (k intero 0 < k < 2N )

(1.2.12)

L'esempio

1 = 11 + 0 1 + 0 1 + : : : = 01 + 1 1 + 1 1 + : : :

2 2 22 23

2 22 23

(1.2.13)

dovrebbe essere su!ciente a chiarire il problema.

Tuttavia i numeri del tipo (1.2.12) costituiscono al piu un insieme numerabile,

cioe possono essere ordinati in una successione, cos che per tutti i casi in cui

i singoli punti hanno sempre probabilita zero come nell'Esempio 1.2.1, tale

insieme ha probabilita nulla e non muta i nostri calcoli probabilistici.

Comunque poiche ogni r 2 0 1] ha almeno una controimmagine in , resta

dimostrato che ha la potenza del continuo.

Osservazione 1.2.1: sia C N l'insieme

C N = fX0 = x0 X1 = x1 : : : XN = xN 8XN +1 : : :g

ci chiediamo quale sia l'immagine di C N secondo #.

9

(1.2.14)

Sara

frg = #(CN ) =

= x0 21 + : : : + xN 2N1+1 + 2N1+1 xN +1 12 + xN +2 212 + : : : =

= r0N + 2N1+1 t

(1.2.15)

con t reale arbitrario in 0,1].

Si vede che

#(C N ) = r0N r0N + 2N1+1

(1.2.16)

Inoltre, per quanto detto,

#;1 r0N r0N + 2N1+1 = (C N )

(1.2.17)

a meno possibilmente di una particolare successione (x0 x1 : : :), cioe di un

punto di che non appartiene a C N .

Ne deriva che, supposto di sapere a priori che nel processo in esame nessun

punto di possa avere una probabilita positiva, il problema di costruire

una distribuzione di probabilita in (cioe di costruire A e di estendervi

P , denita inizialmente solo su CN ), puo essere visto in immagine, tramite

#, come il problema di costruire una distribuzione di probabilita su 0,1] a

partire dai valori dati di probabilita per intervalli del tipo

(1.2.18)

P = r0N r0N + 2N1+1 = P (C N )

Si noti che le condizioni di Kolmogorov, indicando con

r0N = 2Nk+1

(1.2.19)

per k opportuno, diventano

P r 2 2Nk+1 k2N++11 =

(1.2.20)

=

P r 2 2Nk+1 + 2Ny+2 2Nk+1 + y2N++21

y=01

X

10

Esse devono essere valide, purche un singolo punto in 0,1] abbia sempre

probabilita 0.

Quindi il problema di denire una distribuzione di probabilita in a partire

dalle distribuzioni marginali (1.2.2) e sostanzialmente equivalente alla costruzione di una distribuzione di probabilita su 0,1] a partire dalla probabilita

nota per gli insiemi,

Fig. 1.2.1

probabilita rese consistenti tra loro dalla condizione (1.2.20).

Poiche tale problema ha soluzione unica in termini di distribuzione su IR,

altrettanto si puo dire per la questione originalmente posta in .

Come abbiamo detto questa argomentazione ha una ovvia generalizzazione

al caso in cui la catena in esame abbia m possibili valori.

Terminate queste considerazioni di carattere generale, passiamo ad esaminare

lo studio della evoluzione temporale della catena stessa, ovvero alla determinazione della distribuzione di probabilita tra gli stati al tempo t = k cioe

della distribuzione della variabile Xk , singolarmente presa.

1.3 Matrice di transizione, catene omogenee

Si abbia la seguente catena di Markov:

X0 X1 : : :

(1)

s1 p(0)

1 p1 : : :

(1)

s2 p(0)

2 p2 : : :

::: ::: ::: :::

si : : : : : : : : :

(1)

sm p(0)

m pm : : :

11

X1

p(1t)

p(2t)

:::

:::

pm(t)

:::

:::

:::

:::

:::

:::

(1.3.1)

in cui con si si indicano i possibili stati del sistema (i = 1 2 : : : m) e con

p(it) la probabilita che al tempo t il sistema si trovi nello stato si.

Si fa osservare che se le variabili casuali Xk fossero indipendenti tra di loro e

gli stati equiprobabili, saremmo nel caso lancio di un dado a m facce innite

volte, la distribuzione di probabilita ad ogni istante sarebbe nota probabilita

uguali fra loro e tutte pari a 1=m.

Nel caso in cui il processo soddis alla proprieta di Markov, invece, siamo in

grado di determinare tutte le distribuzioni p(t) se, come vedremo, e nota la

distribuzione ad un istante t e sono note le matrici di transizione del processo,

2 che andiamo a denire.

Supponiamo di conoscere la distribuzione del processo al tempo k sia

p(jk) = P fXk = j g la probabilita che il sistema al tempo k si trovi nello

stato j .

Dimostriamo che la probabilita che il sistema si trovi nello stato i al tempo

k + 1 e data da:

p(ik+1) = P fXk+1 = ijXk = j gp(jk)

(1.3.2)

X

j

e cioe la somma delle probabilita di tutti i percorsi che portano allo stato i

al tempo k + 1, passando per lo stato j al tempo k. Infatti:

la probabilita che il sistema si trovi nello stato i al tempo k + 1 e data da:

p(ik+1) =

P fX1 = 1 X2 = 2 : : : Xk = k Xk+1 = 1g (1.3.3)

X

1 2 :::k

ma

P fX1 = 1 X2 = 2 : : : Xk = k Xk+1 = ig =

= P fXk+1 = ijX1 = 1 X2 = 2 : : : Xk = k g P fX1 = 1 X2 = 2 : : : Xk = k g

(1.3.4)

essendo il processo di Markov

P fXk+1 = ijX1 = 1 X2 = 2 : : : Xk = k g =

= P fXk+1 = ijXk = k g

(1.3.5)

2

la matrice di transizione, in generale, varia da istante a istante.

12

e allora possiamo scrivere che

p(ik+1) =

X X

=

k 1 2 :::k;1

P fXk+1 = ijXk

X P fXk+1 = ijXk ; kg k

X P fXk = k Xk;1 = k;1 : : : X1 = 1g =

:::k;

X

P fXk+1 = ijXk = k gP fXk = k g

1 2

=

= k gP fX1 = 1 X2 = 2 : : : Xk = k g =

1

k

(1.3.6)

Denizione 1.3.1: si chiama matrice di transizione P (k) la matrice m m

i cui elementi sono dati da:

p(jik) = P fXk+1 = ijXk = j g

(1.3.7)

Essa realizza la transizione dalla distribuzione all'istante k a quella all'istante

k + 1 e precisamente

p(ik+1) = p(jik) p(jk)

X

j

p(k+1) = P (k)+p(k)

(1.3.8)

Percio tutta la storia dell'evoluzione della distribuzione puo essere ricostruita

con la successione

p(1) = P (0)+ p(0)

p(2) = P (1)+ P (0)+p(0)

:::

(1.3.9)

(

k

+1)

(

k

)+

(

k

;

1)+

(1)+

(0)+

(0)

=P P

:::P P p

p

Le matrici P (k) sono stocastiche, cioe soddisfano le due proprieta:

p(jik) 0

(1.3.10)

(

k

)

pji = P f8Xk+1jXk = j g = 1

X

i

13

Denizione 1.3.2: una catena di Markov con matrice di transizione costan-

te per ogni k e detta omogenea nel tempo.

In tal caso:

p(1) = P (0)+ p(0)

p(2) = P (1)+ P (0)+p(0) = (P +)2p(0)

:::

(1.3.11)

(

k

+1)

(

k

)+

(

k

;

1)+

(1)+

(0)+

(0)

+

k

+1

(0)

p

=P P

: : : P P p = (P ) p

Osservazione 1.3.1: da un punto di vista sico il concetto di omogenita e

legato alla invarianza per traslazione temporale della dinamica che governa

il sistema descritto dalla catena di Markov.

Cos ad esempio se il sistema segue una legge del tipo (1.1.3), se gli k hanno

tutti la stessa distribuzione, la probabilita di passare da Xk = j a Xk+1 = i

e pari alla somma delle probabilita di tutti quei valori di k+1 per cui

i = j + g(j k+1) poiche g e per ipotesi indipendente da k, anche questa probabilita non ne

dipende.

Esempio 1.3.1: ad esempio se

Xk+1 = Xk + k+1]mod3 se l'insieme degli stati e I = f0 1 2g e se

k ;1p 1q allora e chiaro che

fPji(k)g =

Stati al Stati al tempo k + 1

tempo k i = 0 1

2

j=0 0 p

q

1 p 0

q

2 q p

0

14

come si vede la matrice di transizione e appunto indipendente da k.

Esiste una maniera graca di rappresentare le matrici di transizione che

vediamo a partire da un esempio.

Esempio 1.3.2: si abbia la seguente matrice di transizione valida ad ogni

istante t = k:

0 1

0 p q

1 q p

in cui la colonna a sinistra della matrice indica gli stati al tempo k, la riga

sopra la matrice indica gli stati al tempo k + 1.

La probabilita che il sistema a partire dallo stato 0 al tempo k passi allo

stato 0 al tempo k + 1 e p (elemento della riga corrispondente allo stato

in considerazione al tempo k e della colonna corrispondente allo stato in

considerazione al tempo k + 1) e cos via.

15

Il grafo corrispondente e il seguente:

Fig. 1.3.1

in cui si indicano con i nodi gli stati possibili del sistema (in questo caso 2)

e con le frecce le transizioni, cui si associa la relativa probabilita.

Osservazione 1.3.2: generalizzando l'Esempio 3.2, possiamo ricavare la seguente regola che permette di istituire una corrispondenza biunivoca tra

matrici di transizione e gra orientati:

nella matrice di transizione consideriamo tutti e soli quegli elementi per

cui

p(jik) = P fXk+1 = ijXk = j g > 0

lasciando sottinteso che gli altri elementi sono necessariamente nulli

cos si crea un inventario delle coppie (j i) (per cui j e uno stato di

entrata al tempo k i e uno stato di uscita al tempo (k +1) tra cui esiste

una probabilita positiva di transizione dal tempo k al tempo k + 1

rappresentiamo gli stati del sistema con m punti nel piano, che saranno

i nodi del grafo: ad ogni coppia (j i) facciamo corrispondere una connessione (lato del grafo) orientata con una freccia da j ad i ad ogni lato

con freccia associamo un numero (intensita di "usso) corrispondente a

p(jik).

La corrispondenza inversa e del tutto evidente.

La rappresentazione cos introdotta e certamente espressione del funzionamento sico dell'evoluzione degli stati questa e utile particolarmente per catene omogenee in cui la matrice di transizione e quindi il suo grafo e sempre

la stessa al passare del tempo.

16

Esempio 1.3.3: si consideri ad esempio una catena di Markov omogenea

con matrice di transizione

0:5

0

0

P = 0

0

0

0

0:25 0 0 0:25 0

0 1 0

0 0

0 0 1

0 0

0:5 0:5 0

0 0

0 0 0

0 1

0 0 0

0 0

0 0 0 0:5 0:5

0

0

0

0

0

1

0

la sua rappresentazione mediante un grafo orientato sui suoi 7 stati e

Fig. 1.3.2

Fig. 1.3.2: i numeri tra parentesi rappresentano le probabilita di

transizione.

17

1.4 Classicazione degli stati

Denizione 1.4.1: si dice che lo stato j e comunicante con lo stato i se

esiste un tempo nito n per cui la probabilita di andare da j a i in n passi e

positiva

p(jin) > 0

(1.4.1)

Denizione 1.4.2: lo stato i e inessenziale se

( p(n) > 0

9(j n) ) pij(m) = 0

ij

(1.4.2)

8m

Denizione 1.4.3: se i non e inessenziale allora e essenziale, ovvero

( p(n) > 0

8j n 9m ) pij(m) > 0 oppure

ij

( p(n) = 0

ij

p(ijm) = 0

(1.4.3)

cioe e uno stato a cui, una volta visitato, si ha sempre la possibilita di tornare

in un tempo innito.

Sia S l'insieme degli stati della catena, esso e l'unione di stati inessenziali ed

essenziali

S =I E :

Denizione 1.4.4: se i comunica con j e j comunica con i, la coppia (i j )

e detta coppia di stati comunicanti.

Nel sottoinsieme E la probabilita di due stati di essere comunicanti e

riessiva: (i i) e comunicante in E , altrimenti i non potrebbe essere

essenziale

simmetrica: se i comunica con j ) j comunica con i:

18

Fig. 1.4.1

transitiva: se i comunica con j e j con k ) i comunica con k

Fig. 1.4.2

p(ikn+1) > p(jin) p(1)

jk > 0

p(ikh+m) > p(kih)p(jim) > 0

(1.4.4)

dunque la relazione binaria di essere stati comunicanti e una relazione di

equivalenza.

Pertanto gli stati essenziali si dividono in classi di equivalenza

disgiunte

\

E = Ei Ei Es = 0 i =

6 s

i

Lemma 1.4.1: non puo esistere una catena di Markov con un sistema S

fatto solo di stati inessenziali.

Per assurdo sia S fatta solo di stati inessenziali.

19

Fig. 1.4.3

Partiamo da i1 qualsiasi deve allora esistere i2 6= i1 ed n1 , tali che

8> (n )

< pi i > 0

>: p(imi) = 0

1

1 2

2 1

8m

(1.4.5)

ora ripartiamo da i2: deve esistere i3 6= i2 ed n2 tali che

8> (n )

< pi i > 0

>: p(imi) = 0

2

2 3

3 2

8m

(1.4.6)

Si noti che deve essere anche i3 6= i1 perche, per i3 = i1 , la prima delle (1.4.7)

risulterebbe in contraddizione con la seconda delle (1.4.6).

Inoltre deve anche essere

p(i3mi)1 = 0 8m

(1.4.7)

altrimenti

p(i3ni12+m) > p(i3mi)1 p(i1ni) 2 > 0 :

(1.4.8)

Procedendo in questo modo, si crea una catena che non puo mai essere percorsa all'indietro. Pertanto, ripetendo NI passaggi di questo tipo (NI =

20

numero totale di stati), ci si trova in uno stato i di I da cui non e possibile

uscire

P fXk = ijXk;i = ig = 1 se k NI

(1.4.9)

cioe e assorbente e quindi non inessenziale.

Lemma 1.4.2: sia data una catena di Markov fXng omogenea, i cui stati

siano divisi nei due sottinsiemi I , degli stati inessenziali, ed E , degli stati

essenziali. Ammesso che all'istante iniziale Xo 2 I , cioe che P fX0 2 I g = 1,

allora, quasi certamente, cioe con probabilita P = 1, la catena abbandona ad

un tempo nito l'insieme degli I , passando denitivamente in E .

L'aermazione signica che

P fXn 2 I 8njX0 2 I g = 0

(1.4.10)

infatti poiche il ritorno da E in I ha sempre probabilita P = 0, si ha che

Xn 2 I ) Xn;1 2 I ) Xn;2 2 I : : :

(1.4.11)

fXn 2 I g fXn;k 2 I g k = 0 : : : n

(1.4.12)

Xn 2 E ) Xn+1 2 E ) Xn+2 2 E : : :

(1.4.13)

cioe

mentre

cos che le sole realizzazioni di fXng che non passano denitivamente in E

sono quelle che stanno in I 8n.

Poiche la (1.4.12) implica che

P fXn 2 I g P fXn;k 2 I g

(1.4.14)

e poiche

P fXn 2 I 8ng = P fXn 2 I 8njX0 2 I g P fXn 2 I g 8n sso

21

(1.4.15)

ci bastera dimostrare che P fXn 2 I g e non solo decrescente, ma anche

tendente a zero per n ! +1 anzi, poiche P fXn 2 I g e decrescente, bastera

dimostrare che per una sottosuccessione nj (nj ! +1 j ! +1)

lim P fXnj 2 I g = 0

(1.4.16)

j !+1

Sia i0 un qualunque stato di I i0 2 I e supponiamo che x0 = i0 per denizione di stato inessenziale e seguendo il ragionamento del lemma precedente

si vede che per un qualche N nito

P fXN 2 E g = pi0 > 0

(1.4.17)

per la (1.4.13) allora si avra anche

P fXn 2 E 8n N g pi0

(1.4.18)

Poiche questo e vero per tutti gli stati i0 2 I (che sono in numero nito), e

chiaro che esistera un N su!cientemente grande ed un p abbastanza piccolo,

ma sempre p > 0, tali che

P fXN 2 E g = P fXN 2 E jX0 2 I g p

(1.4.19)

infatti

P fXN 2 E jX0 2 I g =

Ma allora

XP fX 2 EjX0 = i0gP fX0 = i0g N

i 2I

X

p P fX0 = i0 g = p

(1.4.20)

0

i0 2I

P fXN 2 I g = P fXN 2 I jX0 2 I g 1 ; p = q < 1 inoltre, essendo la catena omogenea, dovra anche essere, 8k

P fXN +k 2 I jXk 2 I g q < 1 :

(1.4.21)

(1.4.22)

Ora

P fX2N 2 I jX0 2 I g = P fX2N 2 I jXN 2 I gP fXN 2 I g 22

(1.4.23)

poiche

P fX2N 2 I jXN 2 E g = 0 (1.4.24)

cos che per la (1.4.21) e la (1.4.22)

P fX2N 2 I g = P fX2N 2 I jX0 2 I g q2 :

(1.4.25)

Procedendo analogamente si ha pure

P fXjN 2 I g qj ! 0 per j ! 1

(1.4.26)

cos che la (1.4.16) risulta dimostrata, con nj = jN ed il teorema e

provato.

Corollario 1.4.1: vale

lim P fXn 2 E g = 1

n!1

(1.4.27)

Dal Lemma 1.4.2 discende una prima classicazione qualitativa del processo

che stiamo analizzando: divisi gli stati nelle due classi I ed E , se il processo

nasce in E (X0 2 E ) allora vi rimane: se il sistema nasce in I , dopo un tempo

piu o meno lungo passa in E senza piu ritornare in I .

Il seguente lemma permette di specicare meglio il comportamento di fX g.

Lemma 1.4.3: se E si decompone in due classi disgiunte non comunicanti

E1 E2 .

9 nlim

!1 P fXn 2 E1 g = p1

9 nlim

!1 P fXn 2 E2 g = p2

(1.4.28)

P fXn+1 2 E1 g P fXn 2 E1 g

(1.4.29)

p1 + p 2 = 1

Infatti

23

perche

Xn 2 E1 ) Xn+1 2 E1

(1.4.30)

P fXn 2 E1 g P fXn 2 E2g

(1.4.31)

e quindi le successioni

sono crescenti, limitate superiormente e percio hanno limite, inoltre

p1 + p2 = nlim

!1 P fXn 2 E1 g + nlim

!1 P fXn 2 E2 g =

= nlim

!1 P fXn 2 E g = 1

(1.4.32)

Cio implica che il comportamento di evoluzione asintotica di una distribuzione iniziale di probabilita

P fX0 = ig = p(0)

i

(1.4.33)

abbia le seguenti caratteristiche:

se X0 2 I dopo un certo tempo n Xn va in E , inoltre Xn tende

a distribuirsi tra le classi irriducibili di E con una certa distribuzione di probabilita asintotica si osservi che in generale la distribuzione

asintotica tra gli Ek dipende dalla distribuzione iniziale (1.4.33)

24

Fig. 1.4.4

se invece X0 2 E allora X0 appartiene ad una delle classi disgiunte di

equivalenza Ek e vi rimane per sempre.

In conclusione, si puo dire che il comportamento asintotico di una catena di

Markov si riassume nel fatto che prima o poi lo stato della catena cadra in

una delle classi disgiunte degli stati essenziali e cio avverra con probabilita

calcolabile. Una volta raggiunta una delle Ei ci chiediamo ancora quale sara

il comportamento della catena in tale classe questo sara l'oggetto di studio

del prossimo paragrafo almeno per alcuni casi relativamente semplici.

Esempio 1.4.1: riprendiamo l'Esempio 1.3.3 e chiaro che 1 e uno stato

inessenziale in quanto il sistema quando lo abbandona non puo piu ritornarvi.

Tolto lo stato 1 il grafo di Fig. 1.3.2 si decompone automaticamente in due

classi disgiunte

E1 f2 3 4g E2 f5 6 7g :

E chiaro che ciascuna delle due classi e fatta da stati essenziali. Al di la del

fatto che appare intuitivo per motivi di simmetria che

1

lim

P

f

X

2

E

g

=

n

1

n!1

2

1

lim

P

f

X

2

E

g

=

n

2

n!1

2

25

proviamo a dimostrare anche direttamente che cio e vero a partire dalla

matrice di transizione del processo. A questo scopo e utile osservare che

poiche il fenomeno che vogliamo studiare e la transizione 1 ! E1 e 1 ! E2 ,

mentre per ora non ci interessa sapere cosa succede all'interno di ogni classe,

e utile costruire uno schema ridotto della catena in cui le classi E1 E2 siano

condensate in due unici stati. Si perviene cos allo schema ridotto di Fig.

1.4.5

Fig. 1.4.5: p + q + r = 1

che nel caso dell'Esempio 1.3.2 corrisponde a

p = 1=2 q = r = 1=4 :

La matrice di transizione corrispondente al grafo ridotto e dunque

p q r

P= 0 1 0 :

0 0 1

Supposto che al tempo zero il sistema si trovasse in 1, che e l'unico caso

signicativo per noi, cos che

p(0)+ = j1 0 0j

e facile vericare che (cfr. (1.3.11)

X

n;1 !

n;1 ! X

pk :

pk r

p(n)+ = P (0)+pn = pn q

k=0

k=0

26

Quindi passando al limite per n ! 1 si trova direttamente

q lim P fX = 3g = r

lim

P

f

X

=

1

g

=

0

lim

P

f

X

=

2

g

=

n

n

n

n!1

n!1

1 ; p n!1

1;p

che e appunto quanto ci aspettavamo.

1.5 Teoria ergodica per le catene di Markov

Supposto di esserci ristretti ad una catena omogenea costituita da un unica

classe di stati essenziali e comunicanti, ci chiediamo quale sia il comportamento della catena stessa, ovvero come si distribuisca la probabilita tra gli

stati essenziali, quando il tempo di evoluzione del sistema tende ad 1. Poiche l'evoluzione nel tempo della distribuzione di probabilita tra gli stati di

una catena omogenea e legata alla matrice di transizione e alla distribuzione

di probabilita iniziale, secondo la (1.3.11), occorrera studiare come agisce

(P +)k sui vettori di probabilita quando k ! 1.

Studiamo questo problema dapprima ponendo la forte ipotesi semplicatrice

che la matrice di transizione P (o la sua trasposta che per comodita chiameremo A) sia costituita tutta da elementi positivi, ovvero che tutti gli stati

siano comunicanti ad un passo con probabilita positiva vedremo piu oltre

come rilassare almeno parzialmente tale ipotesi.

Sia

1

1

e = 1 Sia A la matrice

aij = pji 0 < m pij M < 1 allora il fatto che P sia stocastica si traduce nella utile relazione

e+A = : : : aij : : :] = : : : pji = 1 : : :] = e+

X

X

i

i

27

(1.5.1)

(1.5.2)

Sia N il numero degli stati del processo descritto dalla catena di Markov in

esame al tempo k la distribuzione di probabilita tra gli stati sara un vettore

di IRN . Introduciamo in IRN una norma (L1 ) denita come

jr j =

X jrj j

(1.5.3)

j

Come si vede se p e una distribuzione di probabilita , il vettore corrispondente

avra jpj = 1 in IRN secondo tale norma.

Osservazione 1.5.1: se p e una distribuzione di probabilita (cioe

pi 0 e+p = 1), allora q = Ap e pure una distribuzione di probabilita.

Infatti

e+q = e+(Ap) = (e+A)p = e+p = 1

e inoltre

qi =

(1.5.4)

X aij pj = X pj pji 0

j

(1.5.5)

j

Quindi, poiche la matrice A governa la transizione da un vettore di probabilita ad un altro, avremo che, per per un vettore di probabilita p0 qualsiasi

jA+`p0 j = jA`;1p0 j = : : : = jp0 j = 1 :

(1.5.6)

Lemma 1.5.1: consideriamo il sottospazio R? = fv : e+v = 0g

A trasforma R? in se stesso.

Infatti

se e+v = 0 ! e+(Av) = (e+A)v = e+ v = 0 .

Ora in maniera particolare ci interessa studiare il comportamento di A quando essa agisce su R?, considerato come sottospazio di IRN , con la stessa

norma.

In generale avremo, sfruttando la proprieta di stocasticita di A,

jAvj =

X j X aij vj j X X jaij jjvj j = X jvj j X jaij j = X jvj j(1.5.7)

i

j

i

j

j

28

i

j

che dimostra che A, come trasformazione lineare di R?, e una trasformazione

non espansiva, ovvero jAj 1. In realta sfruttando a pieno l'ipotesi (1.5.1)

dimostreremo che la A e una contrazione in R?.

Lemma 1.5.2: in R? vale

jAvj jvj

<1

(1.5.8)

Fissato v sono ssati due insiemi di indici I + I ; tali che

vj 0 j 2 I +

vj < 0 j 2 I ;

Si noti che

e inoltre

X vj = 0 ! X vj = X(;vj )

(1.5.10)

X jvj j = X vj + X (;vj ) = 2 X vj

(1.5.11)

e+ v = 0 )

jv j =

(1.5.9)

j

i2I

j

I;

I+

Fissato v consideriamo

ui = aij vj =

X

j

j 2I ;

+

j 2I

+

X aij vj ; X aij (;vj )

j 2I

j 2I ;

+

(1.5.12)

sia ci il segno di ui

ci = +1 se ui > 0

ci = ;1 se ui < 0

allora

X juij = X ciui = X vj X ciaij

i

i

j

i

(1.5.13)

I ci non sono tutti concordi poiche e+u = 0, quindi, ricordando la (1.5.1)

X jciaij j 1 ; 2m = < 1

i

29

(1.5.14)

Percio

X juij X jvj jj X ciaij j X jvj j

i

j

i

(1.5.15)

j

ovvero, ogni volta che si applica A ad un vettore di R?, la sua norma si

contrae di .

Ci serviremo di tale risultato per dimostrare il teorema seguente.

Teorema 1.5.1: (sullo stato limite). Se A e stocastica, se m = min pij > 0

e se p0 e una distribuzione iniziale di probabilita

( i p0i = 1 p0i 0) allora Anp0 ammette limite

lim Anp0 = p

n!1

P

P

(1.5.16)

tale che p e una distribuzione di probabilita, ovvero (pi 0 i pi = 1)

il limite (1.5.16) va inteso nel senso della norma di IRN , ovvero in senso

ordinario per le componenti.

1. La dierenza tra due distribuzioni di probabilita p ; q e sempre in R?.

Infatti

e+(p ; q) = e+p ; e+q = 0

(1.5.17)

2. Consideriamo la dierenza

An+`p0 ; Anp0 = An(A` ; I )p0

e notiamo che

v = (I ; A`)p0 = p0 ; A`p0 2 R?

Percio, ricordando la (1.5.6) ed osservando che

jvj jp0j + jA`p0j 2jp0j = 2

si ha

(1.5.18)

8`

(1.5.19)

(1.5.20)

jAn+`p0 ; Anp0 j = jAnvj jAn;1vj : : : njvj 2nn;!

!10 (1.5.21)

30

Corollario 1.5.1: la distribuzione p e temporalmente invariante.

Infatti

n

n+1

Ap = A nlim

!1 A p0 = nlim

!1 A p0 = p

(1.5.22)

Cio signica che se il processo, ad esempio al tempo 0 ha una distribuzione

come p, allora, in tutti gli istanti successivi, manterra la stessa distribuzione.

Corollario 1.5.2: la distribuzione invariante p e unica.

Infatti

se p1 p2 sono invarianti

An(p1 ; p2) = p1 ; p2

inoltre poiche p1 ; p2 2 R?, per il Lemma 1.5.2

quindi

(1.5.23)

An(p1 ; p2 )n;!

!10

(1.5.24)

p1 = p2

(1.5.25)

Dunque p e un attrattore stabile per il sistema evolutivo descritto da An p0.

Si noti che n qui abbiamo supposto che valesse l'ipotesi

aij = pji 0 < m pji M < 1 (1.5.26)

per ottenere una cos forte restrizione dimostriamo il seguente teorema:

Teorema 1.5.2: condizione suciente anche Anp0 tenda ad una distribu-

zione stazionaria e che

(Ak )ij m > 0

per qualche k ssato.

31

(1.5.27)

In eetti, sfruttando il Teorema 1.5.1 sullo stato limite, si ha immediatamente

lim (Ak )np0 = p (1.5.28)

n!1

vogliamo pero qui dimostrare che e proprio

lim Anp0 = p :

n!1

Infatti

(An+` ; An )p0 = An(A` ; I )p0 = Akm A v

avendo posto

n = km + ( < k) e v = (A1 ; I )p0 2 R?

Essendo A v 2 R?

(1.5.30)

(1.5.31)

jvj 2 jAj 1

(1.5.32)

jAkmjR? = j(Ak )mjR? m

(1.5.33)

j(An+` ; An)p0j m jAj jvj;!

0

n!1

(1.5.34)

e per il Lemma 1.5.2

si trova:

(1.5.29)

Osservazione 1.5.2: la condizione sopra citata e solo su!ciente e comunque vi sono dei casi in cui non e soddisfatta, come dimostra il seguente

semplice esempio

Fig. 1.5.1

32

0 1

con matrice di transizione P = A = 1 0 infatti in tal caso A2n+1 = A

e A2n = I cosicche tale condizione non e soddisfatta per alcuna potenza di

A.

Si noti che in questo caso, partendo da uno stato iniziale pq (p + q = 1)

si trova alternativamente p2n = pq p2n+1 = pq , che quindi non da in

generale una successione convergente, tranne che se p = q = 1=2. In questo

caso lo stato p = q = 1=2 e anche lo stato invariante per A.

Lemma 1.5.3: p puo essere caratterizzato oltre che dalla relazione Ap = p

(le componenti pi sono proporzionali ai minori della prima riga di A ; I ),

anche dalla seguente notevole proprieta

lim An = pe+

(1.5.35)

n!1

P

Infatti sia p0 qualunque (normalizzato con la condizione i p0i = 1)

allora

Anp0 = An(I ; pe+)p0 + Anpe+p0 = An(p0 ; p) + pe+p0 !

! pe+p0 (= p)

(1.5.36)

perche e+p0 = 1 p0 ; p 2 R? e An (p0 ; p) ! 0.

Quindi

p1 p1 (1.5.37)

An ! pe+ = p

2 p

2 pn pn 3

77

5

2

66

4

Poiche A e il trasposto della matrice di transizione, saranno le righe di

quest'ultima, elevata alla n, a tendere a p.

Teorema 1.5.3: (teorema ergodico o legge dei grandi numeri).

Sia X = fX0 X1 : : :g una catena di Markov con matrice di transizione P =

A+, che ammette un unico stato limite sia

iN = numero degli Xk = i tra i primi N 33

allora risulta

N

i = p

lim

i

N !1 N

(1.5.38)

che rappresenta la probabilita dello stato i nella distribuzione limite p: il

limite va intero in media quadratica, cioe

iN lim E N = pi

N !1

N

2 i

lim N =0

N !1

1. Infatti ricordiamo che (teorema di Cesaro)

n

1

lim a = a ) Nlim

n!1 n

!1 N i an = a

X

Notiamo poi che si ha

iN

dove

i (xk ) =

N

X

= i(xk )

k=0

1

se xk = i

0 se xk =

6 i

Inoltre vale la relazione

E fi(Xk )g = 1 P fXk = 1g Ora sia

(1.5.39)

0 ei = 1 i

0 0

34

(1.5.40)

(1.5.41)

(1.5.42)

(1.5.43)

allora

P fXk = ig = e+i Ak p0

cosicche

+ k

+

k

+

lim E fi(Xk )g = klim

k!1

!1 ei A p0 = ei klim

!1 A p0 = ei p = pi

Quindi

X

n

1

lim

E fi (Xk )g = pi

N !1 N

k=1

cioe

iN lim E N

N !1

= pi

(1.5.44)

(1.5.45)

(1.5.46)

(1.5.47)

2. Dimostriamo ora la seconda della (1.5.30) a tal ne usiamo la relazione

N

N 2

N

(1.5.48)

2 Ni = E (Ni 2) ; E Ni

Calcoliamo

E

(1N )2 N2

X

= N12

XN Efi(Xk)i(X`)g =

k=0

`=0

(1.5.49)

XX

N

N N

1

2

2

= 2 E fi (Xk ) g + 2

N k=0

N k=0 `=k+1 E fi (Xk )i(X`)g

ma per la (1.5.33), essendo 2i = i ,

E fi(Xk )2g = E fi(Xk )g = P fXk = ig ! pi

percio

X

!

1 1 N E f (x )2 g pi (N ! 1)0

i k

N N k=0

N

35

(1.5.50)

(1.5.51)

Inoltre, osservando che i(j ) = ij per la (1.5.42),

E fi (Xk )i(X`)g = EXk fE fi(Xk )i (X`)K gg E fi(Xk )i(X`)jXk = j gP (Xk = j ) (1.5.52)

X

Xj Efi(x`)jXk = jgi(j)P (Xk = j) = Efi(X`)jXk = ig j

P fX` = ijXk = igP fXk = ig = e+i A1;k ei e+i Ak p0

Ma allora

XN Efi(Xk)(X`)g = e+Akp0 i

X e+A`;kei = e+Akp0(N ; k)e+ `=k+1

N

`=k+1

i

i

i

1

N ;k

X As! ei

(1.5.53)

N ;k

s=1

Dunque si ha, applicando il teorema di Cesaro e ricordando che An ! pe+,

N ;k

1

+

CN ;k = ei N ; k As eiN e+i pe+ ei = pi

(1.5.54)

!1

s=1

inoltre

X !

Bk = e+i Ak p0 ! pi per k ! 1

ed entrambe le successioni sono limitate.

In questa situazione e facile vedere che

X

X

(1.5.55)

2 N B C (N ; k) = lim 2 N p2(N ; k) =

lim

k N ;k

i

N !1 N 2

N !1 N 2

k=1

k=1

2 N (N + 1) = p2

p2i Nlim

(1.5.56)

i

!1 N 2 2

Quindi si ha:

N 2

N

N

(1.5.57)

2 Ni = E (Ni 2) ; E Ni p2i ; p2i = 0

36

Essenzialmente questo teorema aerma che, valutando su una realizzazione

unica la percentuale di occupazione dello stato i su N tempi e lasciando

tendere N ! 1, si ritrova la probabilita limite pi.

N

Poiche (1.5.37) e (1.5.38) implicano che Ni ! pi in probabilita, nel caso che

N ;1

! (pi);1 d'altro canto il limite

per ipotesi pi 6= 0 si avra anche Ni

di NiN puo essere interpretato come tempo medio di ritorno del sistema allo

stato i, percio, quanto dimostrato, si puo anche esprimere dicendo che il

tempo di ritorno allo stato i, su tutta una realizzazione, e pari all'inverso

della probabilita asintotica che il sistema si trovi in i.

Osservazione 1.5.3: il teorema ergodico che abbiamo qui dimostrato e naturalmente strettamente imparentato con la legge (debole) dei grandi numeri, che aerma che, dato un campione Bernoulliano di numerosita N , la

frequenza relativa fN (I ) di estrazioni appartenenti ad un intervallo I , tende

in media quadratica alla probabilita teorica p(I ). La notevole dierenza tra

questa legge e quanto dimostrato sopra sta nel fatto che per un campione

Bernoulliano le variabili X1 X2 : : : sono tutte indipendenti tra loro e tutte

uguali in distribuzione, mentre nel caso trattato qui le variabili non sono tra

loro indipendenti ne ugualmente distribuite.

Esempio 1.5.1: concludiamo il caso iniziato con l'Esempio 1.3.3, cercando

la distribuzione asintotica, se esiste, all'interno delle due classi essenziali

E1 E2 che sono chiaramente tra loro equivalenti. Per semplicita dunque

ci riduciamo ad una catena con tre stati con graco e matrice di transizione

P mostrati in Fig. 1.5.2.

37

Fig. 1.5.2

0

P = 0

1=2

1 0

0 1

1=2 0

In primo luogo ci si chiede se e possibile applicare il Teorema 1.5.2. In eetti

non e di!cile vedere che da P no a P 4 restano in P n degli elementi di

matrice nulli ad esempio partendo da 1 e chiaro che in 4 mosse la probabilita

di tornare a 1 e nulla.

Tuttavia e

1=4 1=4 1=8

5

P = 1=4 1=2 1=4

1=2 1=4 3=8

i cui elementi sono tutti positivi cos che vale la condizione (1.5.27). In tal

caso esiste la distribuzione asintotica p+ = jp1p2 p3j, tale che

p+ = p+P ne segue che la distribuzione asintotica e data da

1

1

p= 5 2 :

2

1.6 Catene di nascita o morte

Una catena di nascita o morte e una catena di Markov con probabilita di

transizione per uno stato intermedio i, rappresentata dal graco:

Fig. 1.6.1

38

ovvero tale che ogni stato comunichi solo con se stesso o con quelli adiacenti.

Agli estremi di questa catena si possono avere comportamenti diversi, tutti

compatibili con tale proprieta di base.

1.

Fig. 1.6.2

la connessione e ancora di tipo locale cioe limitata al piu vicino nel caso che

ra = 0 deve essere pa = 1, il che signica che la barriera e \ri"ettente"

2. caso \circolare"

i punti a e b possono essere disposti in un cerchio su cui si evidenzia che la

transizione e sempre al piu vicino

Fig. 1.6.3

3.

39

Fig. 1.6.4

Lo stato del sistema, raggiunto l'estremo a vi si ferma con P = 1.

La barriera a e allora detta \assorbente".

Osservazione 1.6.1: se in una catena vi e un solo estremo assorbente e gli

stati sono tutti comunicanti, lo stato limite nisce nell'estremo assorbente

con P = 1 cioe

X P fXm = a se m M Xm 6= a se m < M g =

=

M

P fX raggiunga a in un qualunque tempo nito g = 1

infatti in questo caso tutti gli stati sono inessenziali tranne a.

Osservazione 1.6.2: se vi sono due estremi a b assorbenti, questi costituiscono classi disgiunte, mentre tutti gli altri stati sono inessenziali.

Si vogliono trovare le probabilita del sistema di essere intrappolato in a o in

b (che chiameremo rispettivamente e ), essendo partito dallo stato x.

Si indichi con Bm(x) e Am (x) l'insieme delle realizzazioni in cui il sistema

arriva rispettivamente allo stato b e a per la prima volta all'istante m essendo

partito dallo stato x:

Bm (x) = fx xm = b a < xk < b k < mjx0 = xg

Am (x) = fx xm = a a < xk < b k < mjx0 = xg

(1.6.1)

Notiamo che Bm e disgiunto da Bm+1 Bm+2 e lo stesso vale per Am in quanto

le singole realizzazioni x sono tutte diverse tra loro pertanto posto

+1

M

B (x) = Bm (x) = Mlim

Bm (x) = Mlim

B M (x)

!1

!1

m=1

m=1

+1

M

A(x) = Am (x) = Mlim

Am (x) = Mlim

AM (x)

(1.6.2)

!1

!1

m=1

m=1

40

le probabilita cercate

1

(x) = P

fx xm = b a < xk < b se k < mjx0 = xg

(x) = P

"

"m

1=1

m=1

#

#

fx xm = a a < xk < b se k < mjx0 = xg

saranno date da

M

(x) = P fB (x)g = Mlim

!1 P fB (x)g = Mlim

!1 M (x)

M

(x) = P fA(x)g = Mlim

!1 P fA (x)g = Mlim

!1 M (x)

(1.6.3)

(1.6.4)

Ma

=

M (x) = P (B M ) =

P fa < xj < b 1 j < m

xm = b m = 1 2 : : : M jx0 = xg =

=

X P fa < xj < b 1 j < m

y

xm

XM P (Bm) =

m=1

= b 1 m M jx0 = x x1 = ygPxy

(1.6.5)

dove Pxy e la probabilita di passare allo stato y al tempo 1 essendo partiti

dallo stato x al tempo 0.

Per la proprieta di Markov, si ha

P fa < xj < b 1 j < m

xm = b 1 m M jx0 = x x1 = yg =

= P fa < xj < b 2 j < m

xm = b 2 m M jx1 = yg = M ;1(y)

(1.6.6)

Quindi

M (x) =

X PxyM ;1(y)

y

41

(1.6.7)

e per M ! 1

(x) =

X Pxy(y)

(1.6.8)

y

ovvero e invariante per la matrice di transizione e lo stesso vale per .

Osservazione 1.6.3: si noti che (x) e (x) non hanno nulla a che vedere

con lo stato limite p che e invece invariante per la matrice A = P +.

Osservazione 1.6.4: si osservi che vale

(x) + (x) = 1 8x

(1.6.9)

purche gli stati siano tutti connessi infatti in tal caso tutti gli stati tranne a

e b sono inessenziali.

Questa relazione, che vale per una qualunque catena con due stati assorbenti,

ci permette di ridurre la ricerca di (x) (x) ad una sola delle due funzioni,

ad esempio (x) usando la (1.6.8) ed il fatto che (a) = 0 (b) = 1 per

denizione.

Esempio 1.6.1: applichiamo il ragionamento sopra visto ad una catena

omogenea di vita o morte, la cui matrice di transizione quando si cataloghi

a come primo stato b come ultimo, e data da

1

q

0

P = 0 0 0

r p 0

q r p

0 q r

0 0 0

:

p 1

In tal caso, ricordando la (1.6.8), vale

(x) = p (x + 1) + r (x) + q (x ; 1) a < x < b (1.6.10)

(a) = 0 (se la catena parte in a non ne esce)

(1.6.11)

(b) = 1 (se la catena parte in b non ne esce ed e

sicuro che rimanga in b)

(1.6.12)

42

Posto r = 1 ; p ; q si trova

p (x + 1) ; (x)] = q (x) ; (x ; 1)]

(1.6.13)

#x = (x + 1) ; (x) = pq

(1.6.14)

#x = #x;1

(1.6.15)

#a = (a + 1) ; (a) = (a + 1)

(1.6.16)

cos che posto

si ha semplicemente

Poiche per x = a si ha

posto successivamente x = a + 1 a + 2 : : : si trova

#a+1 = #a = (a + 1)

#a+2 = 2 #a = 2 (a + 1)

:::

#b;1 = b;a;1 #a = b;a;1 (a + 1)

ovvero vale la relazione ricorsiva generale

(x + 1) ; (x) = x;a#a = x;a (a + 1)

(1.6.17)

(1.6.18)

Poiche

(x + 1) = (x + 1) ; (x) + (x) ; (x ; 1) + : : : +

+ (a + 1) ; (a) =

= x;a (a + 1) + x;a;1 (a + 1) + : : : + (a + 1)

(1.6.19)

ricordando che (a) = 0, si ha che

Xx k;a(a + 1) = (x + 1)

k=a

43

(1.6.20)

applicando questa relazione per x = b ; 1 e ricordando la (1.6.12), si trova

b;1

k;a (a + 1) = (b) = 1

(1.6.21)

X

k =a

da cui discendono le relazioni

(a + 1) = b;1 1

k;a

X

k=a

Xx k;a

(1.6.22)

1 + + : : : + x;a = 1 ; x+1;a (1.6.23)

(x + 1) = kb;=1a

Xk;a 1 + + : : : + x;a 1 ; x+1;a

k=a

che risolvono completamente il problema posto per puo essere ricavato

dalla (1.6.9).

44

2 PROCESSI STOCASTICI A TEMPI DISCRETI: TRATTAZIONE GENERALE

2.1 Premessa e prime denizioni

In questo capitolo si intende studiare una classe di processi stocastici assai

piu estesa di quella delle catene di Markov che purtuttavia mantiene una

decisiva semplicazione nella descrizione del suo comportamento in quanto il

\processo" e rappresentato da una famiglia di variabili casuali (v.c.) ordinate

per mezzo di un parametro n discreto

X = fXn n 2 Zg :

(2.1.1)

Qui le singole componenti Xn sono in generale v.c. in IR e non limitate ad

un numero discreto e nito di valori come nel caso delle catene.

Inoltre, per il tipo di scopo che si pregge il presente studio, supporremo

sempre che tutte le v.c. da noi usate abbiano media e varianza nite, cos da

poter usare il formalismo di L2() descritto nel quaderno Q4.

Dunque, in termini piu formali, dato uno spazio di probabilita f A P g

consideriamo una successione di v.c.

Xn = xn(!) n 2 Z (oppure n 2 Z + fn 0g) con Xn 2 L2() un processo stocastico a parametro discreto e per noi il vettore X fXng

con valori campionari x fxng 2 IR1 e con la distribuzione di probabilita

su IR1 PX denita da

PX (B ) = P f! x(!) 2 B g

(2.1.2)

8B 2 B, l'algebra di Borel in IR1 denita come la minima -algebra che

contiene tutti i cilindri (cfr. Q4 cap. 8).

Osservazione

2.1.1: una volta denita la distribuzione di probabilita PX

1

in IR , lo spazio di probabilita f A P g puo in tutto e per tutto essere

sostituito da fIR1 B PX g, nche ci si limita a considerare il processo stocastico X o sue funzioni, riportandoci cos ad una interpretazione di X come

una generalizzazione di una variabile N -dimensionale X N , passando da IRN

45

a IR1. Naturalmente questa operazione fara restringere la nostra attenzione da L2 () a L2(X ) che e un sottospazio chiuso del precedente costituito

da tutte le v.c. con varianza nita, funzioni di X che sono appunto quelle

che ci interessano anzi come vedremo tra breve la nostra analisi, limitandosi

all'ambito lineare, si restringera ad un sottospazio assai piu piccolo di L2(X ).

Avendo dotato X della sua distribuzione PX in IR1 e del tutto naturale

denire l'operatore di media E per una Y = g(X ), ovvero

EX fY g =

Z

IR1

g(x)dPX (x) :

(2.1.3)

Con tale operatore si possono denire i momenti di X , ad esempio i momenti

del 1 ordine

E fXig = i

(2.1.4)

E fXiXk g = Cik (2.1.5)

o del 2 ordine

oppure anche la funzione caratteristica

g(t) = E feit+xg

(t+ = ftn n 2 Zg) :

(2.1.6)

Il vettore di IR1

= fn n 2 Zg

(2.1.7)

e detto media del processo X , mentre la matrice (o operatore, trattandosi di

una matrice 1-dimensionale)

C fCik (i k) 2 Z Zg

(2.1.8)

e detta matrice, o operatore, di covarianza del processo X .

Diamo qualche primo esempio di processo stocastico a parametro discreto.

46

Esempio 2.1.1: il primo e piu semplice esempio di processo stocastico e il

cosiddetto rumore bianco (in senso stretto) che corrisponde ad una successione fXn n 2 Zg di v.c. stocasticamente indipendenti ed identicamente

distribuite.

Di fatto quando n 2 Z + questo modello generalizza la variabile campionaria di un campione bernoulliano al caso in cui si facciano innite estrazioni

indipendenti da una stessa v.c. X .

In questo caso e chiaro che

E fXng = (2.1.9)

2

E fXn+k Xng = X k0 (2.1.10)

dunque la media e un vettore con le componenti costanti, di solito si assume

= 0, mentre l'operatore di covarianza e proporzionale all'identita.

Esempio 2.1.2: (processo di Wiener discreto). Dato un processo di rumore

bianco f"ng a media nulla e con varianza "2 costruiamo fXn n 2 Z +g tramite

le formule ricorsive

Xn+1 = Xn + "n+1

X0 = 0

(n 2 Z +) :

(2.1.11)

Quindi il senso di questo processo, detto di Wiener, e di essere un integrale

(accumulatore) di rumore bianco nel tempo.

Lo schema (2.1.11) puo essere risolto esplicitamente per Xn+1, dando

n

X

Xn+1 = "k+1 :

(2.1.12)

E fXn+1g = 0

E fXn+k Xng = n"2 k 0

(2.1.13)

(2.1.14)

k=0

Da qui si vede che

Si osservi che a causa della denizione (2.1.11) il processo di Wiener fXng

gode della proprieta di Markov

E fXn+1jXn Xn;1 : : :g = E fXn+1jXng :

(2.1.15)

47

Notiamo anche che per il teorema centrale della statistica ci si puo aspettare

che Xn tenda a distribuirsi normalmente pr n ! 1.

Esempio 2.1.3: (processo di Poisson discreto). Sia f"ng una successione di

v.c. indipendenti del tipo testa o croce

"n =

e si ponga

0

1

q p

n

X

Xn = "k

k=1

n = 1 2 : : :

(2.1.16)

n = 1 2 : : : (2.1.17)

dunque Xn e un contatore del numero di successi nel tempo (variabile) n.

Sara

E fXng = np

E fXn+k Xng = npq k 0

(2.1.18)

(2.1.19)

Si osservi che in questo esempio, al contrario dei primi due, le v.c. Xn hanno

un insieme di valori argomentali discreto la peculiarita di questo processo e

che tale insieme f0 1 : : : ng varia al variare del tempo n. Per questo motivo,

benche fXng goda della proprieta di Markov, il processo non costituisce una

catena di Markov.

Esempio 2.1.4: sia ! = U ;1=2 1=2] una v.c. uniformemente distribuita

su ;1=2 1=2], poniamo

xn(!) = sin !n

n = 1 2 : : : :

(2.1.20)

Il processo X corrispondente ha ovviamente media nulla

E fXng =

Z 1=2

;1=2

sin !n d! = 0

48

(2.1.21)

e covarianza

Cn+kn = E fXn+k Xng =

(2.1.22)

1

=

2

= 1

cos !k ; cos !(2n + k)]d! =

2 ;1=2

1

k=0

2

0

k = 2` > 0

=

(;1)` 1 ; (;1)n

k = 2` + 1 > 0

2`+1 2n+2`+1

Esempio 2.1.5: sia ancora ! = U ;1=2 1=2] come nell'esempio 2.1.4 e si

prenda

(2.1.23)

xn(!) = sin(n 2 + 2!) :

Z

8>

<

>: h

i

Il processo X = fXng ha media nulla

Z 1=2 E fX g =

sin n + 2! d! = 0

n

(2.1.24)

2

;1=2

e covarianza

Cn+kn = E fXn+k Xng =

(2.1.25)

1=2

= 1

cos k ; cos(n + k + 4!) d! =

2 ;1=2

2

2

`

(;1)

k = 2` 0

:

= 1 cos k =

2

2

0

k = 2` + 1 > 0

Esempio 2.1.6:

(processi normali). Ricordiamo che dato un qualsiasi vettore 2 IR1 ed un operatore C Cnm in IR1 denito positivo nel senso che

Z h 8<

:

3

8 2 IR1 +C =

) +C 0 i

X X mnCnm < +1

n

m

(2.1.26)

Notiamo esplicitamente che se ad esempio n m 2 Z + la condizione + C < +1

signica

3

+ C = NMlim!1

Xn XM Cnmnm < +1 n=0 m=0

la modica di questo limite doppio nel caso che n m 2 Z e ovvia.

49

esiste in IR1 una distribuzione di probabilita P \normale con media e

covarianza C ". La distribuzione P e normale nel senso che, supposto che il

parametro n vari in Z +,

8N 2 Z + X N fX0 X1 : : : XN g

e una v.c. normale con media N f0 1 : : : N g e con covarianza

CN fCnm 0 n m N g :

(2.1.27)

Il processo X le cui componenti sono solo le componenti di x, ovvero Xn =

xn(x), e il processo normale con media e covarianza C .

Questo schema ha grandi applicazioni quando si sappiano costruire modelli

di operatori C che soddisno la condizione di denita positivita (2.1.26)

ritorneremo piu in la su questo argomento.

In Fig. 2.1 rappresentiamo una realizzazione con n da 0 a 100 per ognuno

degli esempi proposti in particolare il caso (f ) corrisponde ad un processo

gaussiano con

n = 0 Cn+kn = e;jkj = 0 1 :

(2.1.28)

Naturalmente non e possibile creare un repertorio di esempi che siano rappresentativi di tutti i possibili processi stocastici, tuttavia e utile formulare

qualche osservazione in merito al comportamento piu o meno stazionario dei

diversi processi.

50

Fig. 2.1.a

Fig. 2.1.b

Con stazionario intendiamo che un sottocampione, ad esempio di numerosita

10, preso in diverse epoche lungo la realizzazione presenta una signicativa

similarita statistica con gli altri ad esempio ha circa la stessa media e la

stessa varianza.

Fig. 2.1.c

51

Fig. 2.1.d

Fig. 2.1.e

Fig. 2.1.f

Cos vediamo che nel caso (2.1.a), nonostante la realizzazione sia la piu irregolare, la regolarita statistica e massima, invece il caso (2.1.b) e chiaramente

non stazionario perche costituito da onde che si amplicano nel tempo, mentre (2.1.c) si allontana sistematicamente, cioe anche come media, dall'asse

52

dell'ascisse. Ancora i casi (2.1.e), (2.1.f) si presentano con un aspetto signicativamente stazionario con pero la dierenza che (2.1.e) sembra piu

regolarmente periodico di (2.1.f) questa proprieta sono legate al fatto che la

media sia costante e che la covarianza Cn+kn sia funzione della sola k e non

di n, quindi anche la varianza Cnn sia costante, ovvero che la correlazione

tra le variabili Xn+k ed Xn dipenda solo dalla loro distanza nel tempo k e

non dall'epoca n

E f(Xn+k ; )(Xn ; )g = Cn+kn = C (k) :

(2.1.29)

E anche importante notare che nel caso (2.1.e) la covarianza e puramente

perioda in k mentre nel caso (2.1.f) essa tende a zero quando k ! 1 questo

fatto determina dierenze salienti tra i due processi.

2.2 La descrizione hilbertiana dei processi discreti

L'obiettivo che ci proponiamo in questo paragrafo e di caratterizzare in modo

compiuto le famiglie di funzioni lineari del processo X che siano contenute

in L2(X ).

Conveniamo di usare per gli elementi di L2(X ) la notazione semplice

X 2 L2

k x k2= E fX 2g

2

X Y 2 L < X Y >= E fXY g senza particolari indici per la norma ed il prodotto scalare.

Per comodita facciamo l'ipotesi che

= E fX g = 0 cio che in ogni caso non riduce la generalita della discussione successiva.

Notiamo allora che secondo la convenzione fatta possiamo porre

< Xn Xm >= Cnm < X X + >= E fX X +g = C :

Cominciamo osservando che se

2 R0 IR1 , fk k 0 jkj > N g

53

(2.2.1)

(2.2.2)

esiste sempre in L2(X ) la v.c.

X = +X =

XN kXk 2 L2(X ) ;N

(2.2.3)

poniamo per denizione

H0 = Span fXk k 2 Zg = fX = +X 2 R0 g :

(2.2.4)

H0 e ovviamente un sottospazio lineare di L2(X ) chiamiamo HX (o H (X ))

la chiusura di H0 in L2(X )

HX = H0]L2(X ) :

(2.2.5)

Per prima cosa vogliamo caratterizzare l'insieme f 2 IR1 +X 2 HX g

porremo poi

(2.2.6)

H` fX 2 HX X = + X 2 IR1g :

cioe l'insieme delle variabili in HX che sono eettivamente funzioni lineari di

X.

Osservazione 2.2.1: notiamo n da ora che H` sara un sottospazio lineare

di HX ma non necessariamente un sottospazio chiuso. Anzi qualora H` fosse

chiuso, deve necessariamente valere

H` HX

poiche e sempre

H0 H` HX

ed H0 e per denizione denso in HX .

Vale il seguente Teorema:

54

(2.2.7)

Teorema 2.2.1: sia 2 IR1 tale che +X = Nlim

!1

e anche

0 +C = NMlim!1

viceversa sia

XN kXk 2 HX allora

k=;N

XN XM nmCnm < +1 ;N ;M

2 HC f 2 IR1 +C < +1g

(2.2.8)

(2.2.9)

allora 9 la v.c. X = + X 2 L2 (X ) e quindi X 2 HX .

Dunque essenzialmente il teorema aerma che H` e l'immagine attraverso

l'operatore lineare

U = X +X

(2.2.10)

di HC , denito come in (2.2.9).

Nota: per semplicita di scrittura ma senza perdere in generalita supponiamo

che n 2 Z + cos che le serie

+X = Nlim

!1

XN nXn +C

n=1

XN XM

lim

nm Cnm

NM !1

n=1 m=1

abbiamo solo l'estremo superiore variabile.

Inoltre a livello di notazione porremo, per ogni 2 IR1 dato,

(N )+ = f1 2 : : : N 0 0 : : :g (2.2.11)

il simbolo N , che riguarda una successione costruita su un preciso sso,

non va poi confuso con fN g che viceversa indica una qualsiasi successione

in IR1 di componenti fNk g.

Supponiamo dunque che sia tale che

N +

X = +X = Nlim

!1( ) X 2 HX 55

(2.2.12)

cio ha tre conseguenze:

8N k (N )+X k2= (N )+CN a2 < +1

(2.2.13)

8N M j(N )CM j = j < (N )+X X +M > j (2.2.14)

k (N )+X k k (M )+X k a2 < +1

8N > N" opportuno 8p > 0

=k (N +p)+X ; (N )+X k2k (N +p ; N )+X k2=

(2.2.15)

= (N +p ; N )+C (N +p ; N ) < "2 :

Ma allora, ssato " 8N M > N" e 8p q > 0

NX+p MX+q

N X

M

X

n=1 m=1 nmCnm ; n=1 m=1 nmCnm =

= j(N +p)+CM +q ; (N )+CM j =

j < (N +p)+X (M +q )+X > ; < (N )+X (M )+X > j j < (N +p ; N )+X (M +q )+X > j + j < (N )+X (M +q ; M )+X > j k (N +p ; N )+X k k (M +q )+X k + k (N )+X k k (M +q ; M )+X k

2a "

dove si e usata la diseguaglianza di Schwarz, oltre alle (2.2.13), (2.2.14),

(2.2.15) dunque esiste il limite (2.2.8) ovvero 2 HC .

Viceversa se 2 HC , esiste il limite

lim (N )+CM = +C (2.2.16)

NM !1

56

ma allora, dall'identita

k (N )+X ; (M )+X k2= (N )+CN + (M )+CM ;

; 2(N )+CM (2.2.17)

prendendo il limite per N ed M ! 1 ed usando la (2.2.16) si ha

lim k (N )+X ; (M )+X k2 = 2+C ; 2+C = 0 NM !1

cos che f(N )+X g e una successione di Cauchy e dunque 9X 2 HX tale che

X = +X 2 HX L2(X ).

Notiamo tra l'altro che HC e uno spazio lineare in quanto

2 HC ) +X +X 2 HX ) ( + )+X 2 HX )

) + 2 HC :

Nella dimostrazione del Teorema 2.2.1 abbiamo piu volte usato un'utile identita che segnaliamo sotto forma di Corollario.

Corollario 2.2.1: l'operatore lineare U : HC ! H` denito da (2.2.10) e

una isometria se in HC si introduce la seminorma 4

jj2C = +C :

(2.2.18)

Infatti se 2 HC e quindi X 2 H` e chiaramente

N + N

N +

2

jj2C = +C = Nlim

!1( ) C = Nlim

!1 k ( ) X k =

= k +X k2=k X k2 0 :

(2.2.19)

Dunque l'operatore C e sempre semipositivo.

Denizione 2.2.1: diciamo che l'operatore C e positivo, C > 0, se

2 HC C = 0 ) = 0 :

(2.2.20)

Ricordiamo che una seminorma ha le stesse proprieta di una norma senonch

e non e

detto che valga jjC = 0 ) = 0:

4

57

Si puo dimostrare che tale denizione e equivalente a

2 HC +C = 0 ) = 0 :

(2.2.21)

Notiamo che la (2.2.20) e consistente in quante se 2 HC , allora C 2 IR1

per cui ha senso porre C = 0. In eetti poiche 8k

k

k = fk`g = f0 : : : 0 1 0 : : :g+ 2 R0 HC

esiste nito 8k

cioe C 2 IR1. 5

+k C = (C)k Osservazione 2.2.2: quando le (2.2.20) o (2.2.21) sono soddisfatte, jjC

data dalla (2.2.18) diventa una vera norma. Inoltre HC diventa uno spazio

pre-Hilbertiano ponendo

( )C = +C (2.2.22)

la denizione (2.2.20) e coerente in quanto se 2 HC ) ( + ) ( ; ) 2

HC e quindi e denita

+C = 14 f( + )+C ( + ) ; ( ; )+C ( ; )g :

(2.2.23)

Osservazione 2.2.3: se C non e positiva il processo X sore di una patologia che d'ora in avanti escluderemo sempre, ovvero esiste un tempo n tale

che Xn sia una funzione lineare di fXk k 6= ng. Infatti se e tale che

6= 0 +C =k +X k2 = 0 9n n 6= 0 e quindi si puo porre

Xn = ; 1

X kXk n k6=n

(2.2.24)

(2.2.25)

La (2.2.21) garantisce che esiste l'operatore C ;1 , denito sul range di C , cos che

C = ) = C ;1 tale relazione pero non ci dice che C ;1 e esprimibile come una

matrice cio e vero solo se il range di C contiene R0 .

5

58

la serie a secondo membro essendo ancora ovviamente convergente. La

(2.2.25) ci dice che conoscendo Xk k 6= n per una certa realizzazione e

possibile predire quasi certamente il valore di Xn.

Poiche a noi interessa solo il caso in cui questa prevedibilita quasi certa non

e possibile, escluderemo sempre che possa valere la (2.2.24).

Notiamo anche che (2.2.25) e conseguenza del fatto che

(2.2.26)

Xn 2 Span fXk k 6= ng]HX questa patologia puo vericarsi anche in casi in cui C > 0, come vedremo

nel seguente controesempio, percio sara proprio la (2.2.26) che considereremo

come condizione che non si verichi mai.

Esempio 2.2.1: sia fn n 0g un processo di rumore bianco con varianza

unitaria poniamo

X0 = 0 Xk = 0 + k :

L'operatore di covarianza di X e

1 1 1 1 1 2 1 1 C = 1 1 2 1 cos che

X

0 + +1 k

k=1+1

X

C = (0 + k=1 k ) + 1 = 0

+1

X

(0 + k) + 2 : : : k=1

implica

0 +

+1

X

k = 0 ) 1 = 2 = : : : = 0 ) 0 = 0 ) = 0 :

k=1

59

Dunque C e positiva e tuttavia

Xo 2 Span fXk x 1g]HX

in quanto

X

X

N

N

1

1

lim

Xk = Nlim

X0 + N k = X0 :

N !1 N

!1

k=1

k=1

Da questo controesempio appare chiaro che occorrera cercare una condizione

piu forte su C per giungere a garantirci che tutti gli elementi di HX siano

esprimibili come funzioni lineari di X ora tuttavia sottolineiamo qual e la

conseguenza dell'ipotesi C > 0.

Teorema 2.2.2: se C > 0, l'operatore U fC = +X g tra HC ed H` e

biunivoco.

Infatti ! X = + X e univoco per l'unicita del limite di (N )+X viceversa

se

X = +X = U = 0

e anche, ricordando che il prodotto scalare e continuo rispetto ai propri

elementi,

0 =< X X >=< X X + >= C ) = 0 :

Dunque U e invertibile e percio biunivoco.

Corollario 2.2.2: se C > 0 e se HC e uno spazio di Hilbert, ovvero se tale

spazio e completo, allora

H` HX :

(2.2.27)

In eetti se U e un'isometria biunivoca ogni successione Yn = +n X di Cauchy in H` e generata da una successione fng di Cauchy in HC , che quindi

ammette limite in HC ma allora Y = +X e in H` ed e il limite di Yn in

quanto

k Y ; Yn k2= j ; njC ! 0 :

Percio H` e chiuso in HX e quindi coincide con esso per la Osservazione 2.2.1.

60

L'importanza di questo corollario sta nel fatto che esso aerma che la proprieta (2.2.27) puo essere vericata guardando solo la struttura della matrice

di covarianza C e lo spazio HC da essa derivato.

Cerchiamo ora di vedere cosa possiamo guadagnare introducendo la condizione piu restrittiva che (2.2.26) non sia mai vericata.

A tale scopo poniamo

H(n) Span fXk k ng] H (n) Span fXk k > ng]

H(;n) Span fXk k 6= ng] :

(2.2.28)

Inoltre ricordiamo la denizione di successione biortogonale associata (che

chiameremo b.o.a.) alla successione fXng.

Denizione 2.2.2: fng e una successione b.o.a. a fXng se

< j Xk >= jk :

(2.2.29)

Teorema 2.2.3: se il processo X non puo mai essere predetto quasi certa-

mente, cioe se

Xn 2= H(;n) 8n (2.2.30)

allora esiste la successione fng b.o.a. a fXng.

Notiamo che H(;n) e sottospazio chiuso di HX , percio se e vera la (2.2.30)

esistera il vettore X n, proiezione ortogonale di Xn su H(;n) e per di piu

Xn 6= X n )k Xn ; X n k> 0 )k Xn k>k X n k :

Poniamo allora

Xn ; X n

n = Xn ; X n 2 =

k Xn ; X n k k Xn k2 ; k X n k2 risulta

8m 6= n < n Xm >= 0

perche per denizione n ? H(;n) Xm 2 H(;n), mentre

2

< n Xn >= k Xn k ;2 < Xn X n2 > = 1 k Xn k ; k X n k

61

(2.2.31)

cos che fng e la successione cercata.

Notiamo che in base all'Osservazione 2.2.3 se esiste fng b.o.a. ad fXng,

l'operatore C non puo che essere positivo, cos che, come si e gia detto,

(2.2.30) e una condizione piu stringente di C > 0.

Purtroppo l'esistenza di fng non e ancora su!ciente per garantire la (2.2.27)

come il seguente controesempio, simile all'Esempio 2.2.1, dimostra.

Esempio 2.2.2: sia fn n 0g un rumore bianco con varianza unitaria

poniamo

Xn = 0 + n n 1 e chiaro che fn n 1g stessa e una successione b.o.a. a fXng. Tuttavia il

vettore 0, che sta in HX in quanto

X

N

1

0 = Nlim

!1 N n=1 Xn non puo essere in H`. Infatti se

+1

+1

+1

k 1 0 = k Xk =

k 0 + k k X

X ! X

k=1

k=1

k=1

allora e anche, preso il prodotto scalare con j ,

j =< 0 j >= 0 ) 0 = 0

il che e assurdo per la condizione k 0 k= 1.

Osservazione 2.2.4: se X 2 H` X = +X , allora fng b.o.a. a fXng

permette di costruire direttamente da X , cioe realizza l'operatore U ;1 .

Infatti, se ad esempio n 2 Z +,

< X k >= Nlim

!1 <

XN nXn n >= k n=0

(2.2.32)

se n 2 Z la dimostrazione e analoga.

Per questo motivo fng e anche chiamata successione dei coe!centi biortogonali associati a fXng.

62

Osservazione

2.2.5: quando risulti H` = HX si avra che 8X 2 HX 9 2

+

HC X = X .

In questo caso si dice che fXng X e una base di Schauder dello spazio di

Hilbert HX . Tuttavia e noto

che per una semplice base di Schauder la conP

vergenza della serie X = n nXn e condizionata all'ordine in cui vengono

presi gli Xn. Se si vuole che cio non avvenga occorre richiedere che fXng

sia una cosiddetta base di Riesz, ovvero che valga una delle seguenti due

condizioni, che sono in un certo senso simili alla condizione di convergenza

assoluta per una serie numerica:

P nXn 2 HX ) X jnjXn 2 HX P nXn 2 HX ) X "nnXn 2 HX q.c.

(2.2.33)

(2.2.34)

dove "n e una successione di 1 presi a caso ed in modo indipendente.

E facile vedere che la (2.2.34) implica la condizione equivalente

+C < +1 )

X 2 Cnn < +1 n

n

(2.2.35)

la condizione (2.2.35) e essenzialmente solo una condizione su C . Introduciamo una nozione di equivalenza tra due operatori C D positivi in IR1.

Denizione 2.2.3: dati C > 0 D > 0 diciamo che C e D sono equivalenti

tra loro, cio che indicheremo con C D, se

+D +C +D > 0 :

(2.2.36)

E facile vedere che (2.2.36) e una relazione di equivalenza in particolare il

caso = > 0 corrisponde proprio a C = D.

Poiche la relazione tra operatori positivi A B

AB)

+A +B 8 per cui 9+A e una relazione di ordine parziale, riportiamo la (2.2.36) anche nella forma

equivalente

D C D :

(2.2.37)

63

Lemma 2.2.1: se C D valgono le seguenti proprieta:

1) 2 HC , 2 HD

2) se fn g e fondamentale in HC lo e anche in HD e viceversa

3) HC e uno spazio di Hilbert se lo e HD e viceversa, inoltre C D anche

se (2.2.36) e vericata solo 8 2 R0 .

Le 1) e 2) sono immediate.

Se HC e di Hilbert, cioe completo, e fng 2 HC e fondamentale 9 2 HC

tale che j ; njC ! 0 ma allora 2 HD per la 1) e inoltre

j ; njD 1 j ; njC ! 0

cioe anche HD e completo e percio di Hilbert.

Inne se (2.2.36) vale 8 2 IR0 preso un qualunque 2 HD e j ; N jD ! 0

per il Teorema 2.2.1 ma allora e anche j ; N jC ! 0 per la (2.2.36) e quindi

la (2.2.36) stessa vale 8 2 HD . Lo stesso vale 8 2 HC :

Dunque essenzialmente il Lemma 2.2.1 aerma che HC ed HD sono insiemisticamente coincidenti e topologicamente equivalenti.

Lemma 2.2.2: se D e un operatore matriciale diagonale

Dnm = Dnnm Dn > 0 8n HD e sempre uno spazio di Hilbert.

In eetti in questo caso, posto

D1=2 = f Dnnmg

p

(2.2.38)

si vede che

2 HD +D < +1 , = D1=2 2 `2 + = +D < +1 :

Dunque D1=2 e una isometria invertibile (in quanto Dn > 0) tra HD ed `2 ma allora poiche `2 e uno spazio di Hilbert e percio chiuso lo e anche HD .

Con cio abbiamo dimostrato tutte le proprieta necessarie per trarre le conclusioni che raccogliamo nel seguente teorema:

64

Teorema 2.2.4: sia D l'operatore diagonale costruito con la diagonale prin-

cipale di C ,

Dnm = Cnnnm (2.2.39)

se C D valgono le seguenti proprieta:

1) HC e completo e dunque uno spazio di Hilbert,

2) H` HX e quindi

8X 2 HX 9 2 HC X = +X cos che fXng e una base di (Schauder) di HX ,