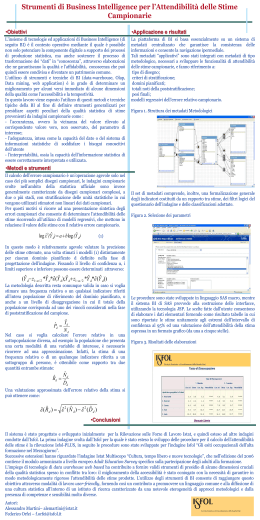

ISSN 2037-2582 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse 5 Strumento di ricerca a cura di Alessandro Martini n strume ti Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse L’Istituto per lo sviluppo della formazione professionale dei lavoratori (Isfol) è un ente pubblico istituito con DPR n. 478 del 30 giugno 1973. Nasce per accompagnare la prima fase di decentramento regionale delle competenze in materia di formazione professionale, codificata nella legge n. 845 del dicembre 1978; dal 1999 viene incluso tra gli enti pubblici di ricerca con DL n. 419 del 29/10/1999. L’attuale Statuto, approvato con DPCM del 19 marzo 2003, sancisce per l’Istituto competenze nel campo delle politiche formative, del lavoro e sociali. L'Isfol svolge e promuove attività di studio, ricerca, sperimentazione, documentazione, valutazione, informazione, consulenza e assistenza tecnica per lo sviluppo della formazione professionale, delle politiche sociali e del lavoro. Contribuisce al miglioramento delle risorse umane, alla crescita dell’occupazione, all’inclusione sociale e allo sviluppo sociale. È sottoposto alla vigilanza del Ministero del lavoro, della salute e delle politiche sociali al quale fornisce supporto tecnico-scientifico ed opera in collaborazione con il Ministero dell'istruzione, dell'università e della ricerca, la Presidenza del Consiglio dei ministri, le Regioni, le Parti sociali, l’Unione europea e altri Organismi internazionali. Strumenti Isfol è la collana elettronica che raccoglie tutti i contributi che l'Isfol realizza con specifiche finalità operative, come strumentazione a disposizione degli operatori e dei non specialisti, anche nell'ambito di committenze esterne vincolanti. La collana ha l'obiettivo di rendere disponibili non solo particolari elaborati teorici per la comunità scientifica ma anche una vasta tipologia di prodotti (quali kit, manuali, dispositivi operativi, opuscoli a fini divulgativi, atti di convegni, ecc.) per un target di utenti più ampio. La Collana Strumenti Isfol è curata da Claudio Bensi – Responsabile Servizio comunicazione web e multimediale Coordinamento editoriale: Paola Piras, Aurelia Tirelli, Matilde Tobia Editing e grafica: Federica Carboni Contatti: [email protected] strume nti Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Indice Introduzione p. 1 1 L’archidettura di Business Intelligence p. 3 2 Il contesto applicativo p. 4 3 Le metodologie per il calcolo dell’attendibilità delle stime di indagini campionarie complesse p. 6 4 I dati, i metadati e le procedure p. 10 5 Le indagini campionarie p. 16 Conclusioni e prossimi sviluppi p. 20 Bibliografia p. 21 strume nti Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Introduzione L’insieme di tecnologie ed applicazioni di Business Intelligence (di seguito BI) è il contesto operativo mediante il quale si intende non solo potenziare, dal punto di vista infrastrutturale, la componente digitale a supporto dei processi di produzione statistica, ma altresì sostenere il processo di trasformazione dei “dati” in “conoscenza”, attraverso elaborazioni che ne garantiscano la qualità e l’affidabilità, conoscenza che può quindi essere condivisa e diventare un patrimonio comune. L’utilizzo di strumenti e tecniche di BI (data-warehouse, Olap, Data mining, web application) è in grado di determinare un miglioramento per alcuni versi immediato di alcune dimensioni secondo le quali può essere declinata la qualità dei dati statistici. Tali dimensioni sono: - l'accessibilità, definita come semplicità per l'utente di reperire ed acquisire le informazioni necessarie - la tempestività, connessa all’intervallo di tempo tra il periodo a cui i dati si riferiscono ed il momento in cui sono disponibili. In questo lavoro viene esposto l’utilizzo di metodi e tecniche tipiche della BI al fine di definire strumenti generalizzati utili al presidio di aspetti peculiari della qualità statistica per stime provenienti da indagini campionarie. Nello specifico, gli aspetti presidiati sono: - l’accuratezza, ovvero lo scostamento del valore rilevato del parametro di interesse rispetto a quello vero, non osservato - l’interpretabilità, definita come la capacità dell’informazione statistica di essere compresa ed utilizzata - l’adeguatezza, intesa come la capacità del dato o del sistema di informazioni statistiche di soddisfare i bisogni conoscitivi dell'utente. Tale progetto è stato avviato principalmente allo scopo di “valorizzare” le fonti informative in possesso dell’Isfol, ossia di favorirne la diffusione interna migliorandone la fruibilità e favorendo la loro integrazione. I sistemi acquisiti consentono l’accesso da parte delle aree di ricerca dell’Istituto ad un comune set di dati validati - di provenienza sia interna che esterna - gestito centralmente in un server dedicato, mediante il quale è possibile selezionare e visualizzare dinamicamente le informazioni attraverso una navigazione ipermediale. L’integrazione dei metadati applicativi – 1 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse informazioni che consentono le operazioni di navigazione - con un set di metadati “metodologici” – informazioni derivanti dall’analisi della varianza delle stime - ha reso possibile la generalizzazione di metodologie consolidate per la valutazione dell’accuratezza delle stime di indagini campionarie. Le indagini campionarie su vasta scala vengono progettate e realizzate per rispondere ad obiettivi conoscitivi ben definiti già nella fase di progettazione, che verranno successivamente perseguiti attraverso precise scelte metodologiche. Queste ultime rappresentano un patrimonio informativo “sui dati”, ossia costituiscono un insieme di metadati a cui è necessario fare costantemente riferimento al fine di utilizzare correttamente i risultati che le indagini forniscono. In particolare, nella fase di analisi delle stime è necessario in prima istanza far riferimento alle informazioni riguardanti le specifiche del piano di campionamento sottostante, e successivamente valutare con attenzione l’accuratezza della stime stesse mediante gli errori campionari, sia quelli definiti in fase di progettazione, sia a quelli calcolati ex-post attraverso l’analisi delle varianza delle stime. La valutazione della precisione delle stime prodotte è un fattore che concorre ad aumentare in modo considerevole l’interpretabilità delle stime stesse, e allo stesso tempo consente all’utente di definire il grado di adeguatezza delle informazioni acquisite rispetto ai propri fabbisogni conoscitivi. Il raggiungimento di questo obiettivo, attraverso modalità di lavoro user-friendly, può contribuire a promuovere un linguaggio comune e alla diffusione di una cultura statistica all’interno di un istituto di ricerca caratterizzato da una notevole eterogeneità di approcci metodologici e dalla presenza di competenze e sensibilità molto diverse. 2 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse 1 - L’architettura di Business Intelligence Nella letteratura la business intelligence viene citata come il processo di "trasformazione di dati e informazioni in conoscenza", definizione che in qualche modo evoca i fondamenti stessi della statistica ed in particolare i principi alla base del ruolo istituzionale della statistica ufficiale. Se nell’ambito delle imprese i processi di raccolta, analisi e distribuzione è principalmente finalizzato all’acquisizione di un vantaggio competitivo, nel contesto del nostro lavoro è in particolare la struttura tecnologica della business intelligence ad avere un ruolo decisivo per il raggiungimento degli obiettivi prefissati, riconducibili al miglioramento della qualità statistica dei dati. Un primo obiettivo perseguito è stato quello di migliorare l’accessibilità da parte delle aree di ricerca ad un comune set di dati validati, di provenienza sia interna che esterna, affinché vada a costituire il patrimonio informativo comune dell’Istituto. La gestione centralizzata attraverso un server dedicato consente di profilare gli utenti in modo da aver traccia di chi “ha accesso a cosa” e poter garantire alle aree di ricerca la necessaria autonomia nella gestione ed elaborazione dei dati non ancora validati, ad esempio rendendo non accessibili dati personali e/o di natura sensibile a soggetti non incaricati del loro trattamento. Analogamente, dati elementari validati di provenienza esterna, acquisiti ad esempio dal Servizio Statistico Isfol mediante comunicazione dati all’interno del Sistan, possono essere condivisi con gruppi di ricerca interni e singoli ricercatori incaricati del loro trattamento, definendo anche il livello di possibile interazione (creazione, lettura, scrittura, eliminazione) con il patrimonio di risorse disponibili in termini di dati, metadati, procedure di elaborazione, etc. Attraverso la gestione centralizzata è possibile uniformare funzioni gestionali come l’estrazione, il caricamento e la trasformazione dei dati, che in ambienti client devono essere necessariamente ripetute con conseguenti possibilità di commettere errori. Si evita così che a partire da banche dati comuni elaborazioni simili possano generare risultati anche significativamente diversi. La possibilità di effettuare self-service reporting allarga significativamente la platea di utilizzatori del patrimonio informativo comune, dando la possibilità di ottenere l’informazione necessaria a diversi profili di utilizzatori, da chi ha poca familiarità con strumenti di elaborazione dati o non è in grado di scrivere codice ad utenti “evoluti” che possono utilizzare anche metodologie avanzate di analisi. 3 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Potendo contare sulla correttezza delle procedure di acquisizione dei dati centralizzate, quindi su dati consistenti e resi disponibili, l’utente può concentrare la propria attenzione sulle analisi e sui risultati, evitando di dover replicare processi di caricamento e trasformazioni dei dati spesso onerose e potenzialmente soggette a divenire fonte di errori. Anche gli strumenti di accesso ai dati rispecchiano le diverse necessità d’interazione con le strutture dati, correlate al ruolo ed alle esigenze delle varie tipologie di utente e costituiscono un sistema “scalato” di modalità di accesso al sistema e di utilizzo delle risorse condivise. Sono disponibili sia interfacce di acceso web-based, che non richiedono istallazione e consentono la navigazione ipermediale dei dati attraverso il browser alle applicazioni di gestione, sia interfacce add-in, che integrano le funzionalità dei prodotti Microsoft per l’office automation, word o excel ad esempio. Tali strumenti consentono di effettuare analisi avanzate attraverso la connessione al server e di ricevere i risultati direttamente all’interno del documento su cui si sta lavorando. I gruppi di lavoro che hanno maggiori necessità di sviluppo di applicazioni e di gestione dei dati possono connettersi attraverso applicativi maggiormente orientati a un interazione forte con i dati ed il sistema, che va dalle funzionalità di ETL (estrazione, trasformazione, caricamento ) alla modellazione delle strutture dati e alla definizione di progetti di analisi. A livello centralizzato, applicativi analoghi consentono l’amministrazione dell’intero sistema attraverso la definizione e la gestione dell’insieme di metadati necessari a costituire il patrimonio di risorse condiviso, reso consistente attraverso definizioni univoche lungo tutti i sistemi coinvolti. 2 - Il contesto applicativo Se l’adozione di un sistema di BI ha implicato in maniera diretta un aumento dell’accessibilità al patrimonio informativo, si è comunque ritenuto opportuno bilanciare il maggior grado di accessibilità ai dati elementari con funzionalità in grado di costituire un efficace presidio di alcune dimensioni critiche della qualità dei dati. Esigenza che diventa particolarmente stringente considerando alcune peculiarità del progetto: molte fonti di dati comunemente utilizzate nell’attività istituzionale sono costituite da dati elementari provenienti da indagini campionarie, svolte da aree di ricerca interne all’Istituto che, una volta ultimato il processo di validazione, possono essere condivise con una platea più vasta di 4 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse analisti e ricercatori dell’Isfol. Analogamente vengono resi disponibili dati elementari provenienti da indagini condotte da altri istituti di ricerca nell’ambito della statistica ufficiale. In quest’ultimo caso si tratta di dati acquisiti a fini di ricerca attraverso l’istituto della comunicazione dati tra enti appartenenti al Sistan e resi accessibili ai soli incaricati del loro trattamento. Attraverso tale istituto si ha la possibilità di accedere ai dati nella forma di maggior dettaglio possibile, nella completa assenza di qualsiasi strumento di guida che garantisca la coerenza dell’esplorazione, a parte le note metodologiche e la documentazione allegata. L’accesso e l’utilizzo di tali fonti di dati deve tener conto innanzitutto di vincoli legati sia alla tutela della riservatezza dei rispondenti sia di natura più specificatamente metodologica. Per quanto riguarda il problema della tutela della privacy, il rilascio dei file individuali prevede in ogni caso l’applicazione a monte di tecniche per la protezione dei dati che rende di fatto impossibile l’identificazione delle unità rispondenti attraverso l’uso di mezzi ragionevoli. Ad ogni buon conto è chiaro come un’analisi troppo dettagliata tenda a rivelare le caratteristiche dei singoli rispondenti, pertanto è necessario rispettare alcune soglie di sicurezza per poter diffondere i risultati. L’altro aspetto, peculiare delle indagini campionarie, è la necessità imprescindibile di analizzare i risultati delle indagini, tipicamente le stime che si ottengono, tenendo sotto stretto controllo aspetti qualitativi fondamentali come: - l’accuratezza, ovvero la vicinanza del valore rilevato al corrispondente valore vero, non osservato, del parametro di interesse - l’adeguatezza, intesa come la capacità del dato o del sistema di informazioni statistiche di soddisfare i bisogni conoscitivi dell'utente - l’interpretabilità, ossia la capacità dell’informazione statistica di essere correttamente interpretata e utilizzata. Nel caso delle indagini campionarie non è raro, analizzando in maniera sommaria i contenuti informativi del set di dati disponibili, individuare la possibilità di fare elaborazioni particolarmente interessanti e ottenere da queste risultati in linea con le ipotesi prefigurate. Tali risultati vanno invece analizzati con prudenza e spirito critico, per valutare quanto siano coerenti con i livelli di dettaglio compatibili con le specifiche metodologiche e con i limiti connessi al piano di campionamento sottostante. Adottando classificazioni particolarmente dettagliate o specificando 5 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse l’analisi per sottopopolazioni con scarsa numerosità, i dati divengono presto non significativi, ossia affetti da un errore campionario talmente elevato da renderli non utilizzabili. In tal caso l’utente deve necessariamente riflettere sull’adeguatezza della fonte a rispondere al fabbisogno informativo che sta cercando di soddisfare. Il ruolo dei metadati, in particolare dei risultati dell’analisi della varianza delle stime, gioca un ruolo fondamentale nel controllo di queste dimensioni qualitative, in quanto tali importanti informazioni di contesto, normalmente diffuse insieme ai set di dati elementari o nelle pubblicazioni, consentono di valutare nel dettaglio la bontà dei risultati delle analisi effettuate e la loro conformità con le specifiche metodologiche dell’indagine. Il loro utilizzo non è però in generale semplice ed immediato: la forma di più semplice utilizzo in cui si possono presentare è quella di fogli elettronici allegati ai CD che contengono i dati o prospetti e tavole riassuntive contenuti nelle appendici metodologiche. Utilizzando i fogli elettronici è possibile, una volta compreso il meccanismo del calcolo e chiariti quali siano gli elementi da modificare all’interno del foglio elettronico, valutare la precisione di una singola stima per volta, inserendo il valore in una cella opportuna in corrispondenza del dominio pianificato d’interesse. Diversamente è necessario far riferimento ai prospetti pubblicati nelle pubblicazioni cartacee o elettroniche, che non consentono alcuna modifica e richiedono la predisposizione di fogli di calcolo o di effettuare le necessarie approssimazioni. 3 - Le metodologie per il calcolo dell’attendibilità delle stime di indagini campionarie complesse Per poter correttamente interpretare i risultati di un’indagine campionaria è necessario valutare le stime puntuali congiuntamente ad una valutazione dell’accuratezza delle stime stesse, cioè una misura della dispersione delle stime attorno al valore vero del parametro della popolazione che si intende stimare. È pratica comune degli istituti che svolgono indagini campionarie nell’ambito del Sistema Statistico Nazionale diffondere insieme alle stime puntuali prodotte dalle indagini delle indicazioni sulla loro accuratezza, in modo che l’utilizzatore possa valutare la vicinanza del valore rilevato al corrispondente valore vero, non osservato, del parametro di interesse. 6 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Il calcolo dell’errore campionario è un’operazione agevole solo nel caso dei più semplici disegni campionari, le indagini campionarie svolte nell’ambito della statistica ufficiale sono invece generalmente caratterizzate da disegni campionari complessi, a due o più stadi, con stratificazione delle unità statistiche in cui vengono utilizzati stimatori non lineari dei dati campionari. Il rilevante numero di stime prodotte poi, vista l’articolazione dei questionari somministrati, rende tale operazione di certo non banale. Nelle pubblicazioni non è quindi riportato per ciascuna stima il corrispondente errore campionario, per diverse ragioni. Innanzitutto la normativa vigente in materia di tutela della riservatezza dei dati non consente la fornitura dei codici territoriali alla base della definizione dei disegni campionari di molte indagini effettuate sia dall’Istat che da altri enti appartenenti al SISTAN. In secondo luogo il numero elevato di stime che possono essere prodotte a partire dai dati elementari comporterebbe un elevato carico di lavoro per calcolare esplicitamente l’errore campionario per ciascuna di esse. Oltre a ciò aumenterebbe considerevolmente la complessità delle tavole statistiche che dovrebbero essere fornite, risultando di difficile comprensione per l’utente finale. In generale quindi non è possibile avere valutazioni dell’errore campionario sia per stime pubblicate sia per quelle che possono essere ricavate dagli utenti attraverso elaborazioni dei dati elementari, che con sempre maggiore frequenza vengono resi disponibili a fini di ricerca e di studio. Per questi motivi solitamente le pubblicazioni in cui sono diffuse stime campionarie o le indicazioni metodologiche allegate ai file di dati elementari riportano, sotto varie forme, i risultati dell’analisi della varianza campionaria in modo da consentire all’utente finale di valutare l’accuratezza delle stime prodotte. Spesso si ricorre ad una presentazione sintetica delle stime degli errori campionari che consente di determinare l’attendibilità delle stime ricorrendo all’utilizzo di modelli regressivi, che mettono in relazione il valore delle stime con il relativo errore campionario. L’approccio utilizzato per la definizione di questi modelli è diverso a seconda che si tratti di stime relative a frequenze di variabili qualitative o stime di totali relativi a variabili quantitative. Nel primo caso è possibile utilizzare modelli che hanno un fondamento teorico secondo il quale l’errore campionario è strettamente legato alla dimensione delle stime: a quelle più alte, basate 7 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse sull’osservazione di una caratteristica comune ad un maggior numero di unità, corrispondono errori campionari più bassi e viceversa. Nel caso di stime di totali di variabili quantitative la definizione dei modelli d’interpolazione costituisce un problema di notevole complessità in quanto non è stata elaborata una adeguata base teorica a supporto, pertanto le soluzioni finora adottate si basano su un approccio sostanzialmente empirico, in cui i modelli regressivi predisposti vengono valutati in base al criterio di massimizzare l’indice di determinazione R2. Nel presente lavoro si fa riferimento esclusivamente al caso della valutazione dell’attendibilità di stime di frequenze assolute o relative, sia per le ragioni appena espresse riguardo il quadro teorico non perfettamente delineato per le stime di variabili quantitative, che ne rende difficile l’estensione dei risultati, sia considerando che nella maggior parte dei casi le indagini campionarie svolte sulle famiglie e gli individui, quelle di maggior interesse per l’attività di ricerca svolta nell’ambito dell’Istituto, forniscono prevalentemente stime di frequenze associate a variabili qualitative. In questo specifico ambito il modello di riferimento è costituito da: logˆ 2 ( dYˆ ) a b log(dYˆ ) d=1,…D (1) Attraverso tali modelli viene posta una relazione funzionale tra la stima Yˆd ed il relativo errore campionario ( d Yˆ ) , dove d sta ad indicare il corrispondente dominio di stima pianificato. Risulta facile ricavare per una qualsiasi stima Yˆd , ottenuta rispetto ad un dominio pianificato, la corrispondente stima dell’errore campionario relativo, applicando i coefficienti a e b stimati nel relativo modello: ˆ ( d Yˆ ) exp a b log( d Yˆ ) (2) In questo modo è relativamente agevole valutare la precisione delle stime ottenute, una volta stimati i modelli (1) distintamente per ciascun dominio pianificato d definito nella fase di progettazione dell’indagine. 8 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse La stima dell’errore campionario relativo ( d Yˆ ) fornisce la possibilità di calcolare un intervallo di confidenza per la stima stessa ovvero gli estremi entro i quali il parametro è contenuto con una certa probabilità. Fissando il livello di confidenza α, i limiti superiore e inferiore possono essere determinati attraverso: ( d Yˆ z1 / 2 *d Yˆ * ˆ( d Yˆ );d Yˆ z1 / 2 *d Yˆ * ˆ( d Yˆ )) (3) Utilizzando i prospetti pubblicati nelle appendici metodologiche è possibile, in alternativa, utilizzare due ulteriori metodi: il primo consiste nell’approssimare l’errore campionario ˆ ( d Yˆ ) relativo alla stima di interesse Yˆd con l’errore relativo corrispondente al livello di stima che più si avvicina al valore della stima tra quelle pubblicate nei prospetti sintetici. Con il secondo metodo, l'errore campionario della stima Yˆd , si ricava mediante la seguente espressione: ˆ ( d Yˆ k ) ˆ ( d Yˆ k 1 ) ˆ k 1 ˆ ˆ Yd Yˆdk 1 ˆ ( d Y ) = ˆ ( d Y ) 1 k k Yˆ Yˆ d (4) d dove Yˆdk 1 e Yˆdk sono i valori delle stime entro i quali è compresa la stima d’interesse Yˆd , mentre ˆ ( d Yˆ k 1 ) e ˆ ( d Yˆ k ) sono i corrispondenti errori relativi presenti nel prospetto. La metodologia descritta resta comunque valida in caso si voglia stimare una frequenza relativa o un qualsiasi indicatore riferiti all’intera popolazione di riferimento del dominio pianificato, o anche a un livello di disaggregazione in cui il totale della popolazione corrisponda ad uno dei vincoli considerati nella fase di poststratificazione del campione. In tali casi il denominatore, ovvero il totale della popolazione, non viene considerato affetto da errore campionario in quanto costituisce un valore noto. Nel caso si voglia calcolare l’errore relativo in una sottopopolazione diversa, ad esempio la popolazione che presenta una certa modalità di una variabile di interesse, è necessario ricorrere ad una approssimazione. Infatti, la stima di una frequenza relativa o di un qualunque indicatore 9 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse riferita a un sottogruppo di persone, è ottenibile come rapporto tra due quantità entrambe stimate: Nˆ Rˆ d d Dˆ d (5) Una valutazione approssimata dell’errore relativo della stima R̂ d , sotto l’ipotesi di incorrelazione tra N̂ d e D̂ d , si può ottenere come: ˆ ( d Rˆ ) ˆ 2 ( Nˆ d ) ˆ 2 ( Dˆ d ) (6) 4 - I dati, i metadati e le procedure Il sistema di Business Intelligence si basa essenzialmente su un sistema di metadati centralizzato che garantisce da un lato la consistenza delle informazioni e dall’altro consente le funzionalità di base: gestione degli utenti e dei contenuti, navigazione ipermediale, etc. Tali metadati “applicativi” sono stati integrati con metadati di tipo metodologico, necessari a sviluppare le funzionalità di attendibilità delle stime campionarie, in maniera tale che il processo di elaborazione dei dati e di stima dell’errore campionario sia “trasparente” per l’utente finale, che può quindi concentrarsi sull’analisi dei risultati. I metadati “metodologici” tengono traccia per ciascuna indagine di alcune definizioni di base del disegno campionario, in primo luogo dei domini di stima pianificati, ovvero le sottopopolazioni in cui la cui numerosità campionaria ed il relativo livello di errore campionario sono definiti a priori in fase di progettazione, ma altresì della procedura di post-stratificazione, riportando i valori di ciascun totale noto che è stato considerato, nonché di tutti i vincoli impliciti a loro volta definiti ad un livello gerarchico superiore. A titolo esemplificativo, un vincolo sulla popolazione residente definito a livello provinciale stabilisce automaticamente un analogo vincolo per i livelli territoriali superiori (regionale, ripartizioni geografiche e livello nazionale). Il vincolo sulla popolazione residente in famiglia a livello provinciale per sesso e classi di età implica che tutte le distribuzioni marginali costituiscono dei totali noti che devono essere considerati. Analogamente sono stati integrati nel data warehouse i risultati dei modelli di interpolazione degli errori campionari, che consentono di definire per ciascuna stima e per ciascun dominio pianificato una stima dell’errore relativo campionario. 10 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Figura 1 – Schema dei metadati Il set di metadati comprende, inoltre, una formalizzazione generale degli indicatori costituiti da un rapporto tra stime che consenta la distinzione tra il numeratore e il denominatore, necessaria per poter calcolare in modo analitico sia le stime sia le singole componenti dell’errore relativo campionario in base alla (5). È stata inoltre stata definita una classificazione che consente di far riferimento, al livello più generale di classificazione, alla corretta metodologia di calcolo dell’errore, attraverso i metodi descritti nel paragrafo 3. Si tiene così conto del fatto che, almeno al livello più alto della struttura gerarchica dei domini pianificati, nella maggior parte dei casi il livello nazionale, il denominatore sia costituito da un totale noto o da una stima. Tale distinzione consente di far riferimento per il calcolo dell’errore relativo campionario, nel caso non si considerino ulteriori classificazioni o siano applicati filtri, rispettivamente alla (2) nel primo caso e alla (6) nel caso in cui il rapporto sia costituito da stime sia al numeratore che al denominatore. 11 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Le procedure sviluppate sono in grado di discriminare, nel corso dell’elaborazione, il metodo corretto di calcolo della stima dell’errore campionario in base alle scelte dell’utente, ai risultati che si determinano, in base ad una continua interazione e confronto con i metadati immagazzinati nel sistema. La scelta del metodo di stima corretto, infatti, non è sempre univoca, anche rispetto a uno specifico indicatore: si può considerare a titolo esemplificativo il caso del tasso di attività, definito come rapporto tra le persone appartenenti alle forze di lavoro e la corrispondente popolazione di riferimento: il denominatore risulta nel caso più generale costituito da un totale noto, quindi non affetto da errore campionario, pertanto la formula da utilizzare per determinare il relativo errore campionario sarà la (2). I valori utilizzati dalla procedura nel caso dell’Indagine sulle Forze di Lavoro sono costituiti dai totali noti considerati nella procedura di poststratificazione per il calcolo delle stime campionarie dell’indagine, desunti da fonte anagrafica: popolazione residente in famiglia a livello regionale per sesso e 14 classi di età popolazione residente in famiglia a livello provinciale per sesso e 5 classi di età popolazione residente in famiglia nei 12 grandi comuni per sesso e 5 classi di età cittadini stranieri residenti in famiglia per regione, sesso e nazionalità 1 . L’utente però potrebbe essere interessato ad una diversa classificazione o all’analisi di tale indicatore rispetto ad una specifica sottopopolazione. In questo caso la procedura è in grado di valutare se il filtro applicato o la classificazione richiesta non facciano più coincidere il totale della popolazione al denominatore con il relativo totale noto. Nel caso ciò accada, la procedura procede al calcolo dell’errore attraverso la formula (6), in quanto anche il denominatore risulta essere una stima, di cui va quindi considerato anche il relativo errore. Ad esempio, analizzando il tasso di attività per regione e classe di età quinquennale, il denominatore è costituito da un totale noto utilizzato nella procedura di poststratificazione. Tuttavia, nel caso che l’utente definisse un filtro, ad esempio restringendo l’analisi ai soli individui coniugati, il valore al denominatore diverrebbe a sua volta un valore stimato (il numero di individui coniugati), rendendo quindi necessario il calcolo dell’errore relativo attraverso l’approssimazione (5). 1 Il vincolo non è stato attualmente preso in considerazione in quanto non applicato uniformemente in tutte le regioni. 12 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Nel caso di indicatori costruiti come rapporti di quantità entrambi stimati, la scelta del metodo di calcolo è in ogni caso riconducibile alla (6). A quest’ultima tipologia appartiene, ad esempio, la stima del tasso di disoccupazione, calcolato nell’Indagine Forze di Lavoro, poiché è ottenuto come rapporto tra due aggregati, le persone in cerca di occupazione e le forze di lavoro, entrambi ottenuti da stime. Figura 2 – La specificazione dei parametri Le procedure sono state sviluppate in linguaggio SAS macro, mentre il sistema BI di SAS provvede alla costruzione delle interfacce grafiche per la selezione dei parametri da parte dell’utente, utilizzando la tecnologia JSP. Le interfacce quindi possono essere richiamate nei vari ambienti di interazione con il server centrale: le componenti web-intranet, gli ambienti di sviluppo SAS e di office automation di Microsoft Office. Le scelte fatte dall’utente consentono l’estrazione dalla base di dati in cui sono state organizzate le informazioni delle istanze necessarie all’elaborazione attraverso query SQl (Stuctured Query 13 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Language) generalizzate, per la manipolazione dei dati e la produzione di statistiche di sintesi si utilizzano data step SAS, proc TABULATE per definire le tabulazione finali. Il diagramma di flusso dell’algoritmo può essere sintetizzato nei seguenti passi logici: Costruzione delle stime Estrazione delle occorrenze dei parametri Confronto con i totali noti Stima dell’errore campionario relativo Calcolo dell’intervallo di confidenza Tabulazione dei risultati. Delle fasi descritte, solo il primo passo richiede tempi di elaborazione di una certa entità, in quanto le stime vengono costruite direttamente sul file dei dati elementari, mentre le altre operazione avvengono manipolando le tabelle dei metadati o di dati ormai in forma aggregata, di conseguenza i tempi di esecuzione risultano minimi. Complessivamente la durata dell’elaborazione è di alcuni secondi, pertanto non è necessaria una invocazione asincrona delle procedure e l’utente può rimanere in attesa della esecuzione remota e della produzione degli output. Il risultato delle elaborazioni è costituito da una tabella o più tabelle in cui sono riportate le stime in valore assoluto o in percentuale richieste dall’utente unitamente agli estremi dell’intervallo di confidenza costruito con un livello di confidenza del 95%, o del 99% se richiesto, ed una valutazione dell’attendibilità della stima espressa in funzione dell’errore campionario relativo stimato. Per quest’ultimo elemento è stato definito un formato grafico di presentazione, in modo da rendere semplice ed intuitiva la sua interpretazione anche ad analisti con conoscenze meno approfondite delle metodologie campionarie. La classificazione adottata si articola in cinque classi di valori dell’errore relativo campionario, cui corrispondono rispettivamente da una a cinque stelle: Inferiore al 5% Cinque Stelle ***** 5% - 10% Quattro Stelle **** 10% -15% Tre Stelle *** 15% - 20% Due Stelle ** Oltre il 20% Una Stella * 14 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Figura 3 – I risultati della procedura Le procedure sono state progettate e sviluppate con l’obiettivo di costituire un supporto per gli analisti ed i ricercatori con particolare riguardo alla fase di validazione delle stime, pertanto il sistema non prevede, allo stato attuale dello sviluppo, la definizione di percorsi predefiniti per la navigazione dei dati e la loro elaborazione. Un sistema “guidato” di consultazione dei dati, basato su una definizione preventiva di alcuni indicatori e delle relative dimensioni ritenute valide, risulterebbe in molti casi poco utile in tale ambito. Questo aspetto, che rappresenta un forte vincolo della possibilità di utilizzare comuni software di data warehouse nell’analisi di stime campionarie, è nel nostro caso mediato dalle funzionalità di valutazione della precisione delle stime. Le informazioni fornite all’utente sull’accuratezza delle stime ottenute migliora sensibilmente il grado di interpretabilità dei dati e, in un ambiente che non prevede percorsi predefiniti di navigazione, costituisce un controllo efficace dell’attendibilità dell’informazione disponibile. 15 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Tali funzionalità non esauriscono peraltro le verifiche necessarie a validare un’elaborazione e renderla idonea ad essere diffusa, ad esempio resta da verificare se l’elaborazione non violi le norme relative alla tutela della riservatezza delle unità rispondenti. 5 - Le indagini campionarie considerate Il lavoro è stato progettato e sviluppato in primo luogo per la Rilevazione Campionaria sulle Forze di Lavoro dell’Istituto Nazionale di Statistica, e quindi esteso sia ad altre indagini condotte dall’Isfol, sia ad altre indagini i cui dati sono stati acquisiti dal servizio statistico dell’Isfol attraverso protocolli di comunicazione dei dati in ambito SISTAN e utilizzati nell’ambito dell’attività di ricerca istituzionale. Considerando inoltre la complessità dell’impianto metodologico ed organizzativo dell’indagine Istat Forze di Lavoro, si ritiene utile far riferimento a questo contesto applicativo negli esempi che seguono per poi analizzare in dettaglio le specificità delle altre rilevazioni considerate, nelle quali difficilmente si raggiunge lo stesso grado di complessità del disegno campionario, di articolazione dei domini pianificati e di ampiezza delle informazioni ausiliarie utilizzate per la costruzione delle stime. Ciò ha determinato nelle applicazioni successive notevoli semplificazioni sia delle procedure sia delle strutture informative predisposte. La Rilevazione Campionaria sulle Forze di Lavoro costituisce la principale fonte statistica sul mercato del lavoro italiano e la più ampia indagine campionaria svolta in Italia. In dettaglio gli aggregati che l’indagine ha lo scopo di stimare, sia su base trimestrale che in media annuale, sono costituiti da: occupati, disoccupati e inattivi, in base alle definizioni suggerite dall’International Labour Office e recepite dai Regolamenti comunitari. Da tale fonte vengono quindi fornite le stime ufficiali degli occupati e delle persone in cerca di lavoro. Il suo utilizzo per analisi di tipo sia congiunturale sia strutturale è quanto mai ampio: l’evoluzione dei principali indicatori del mercato del lavoro può essere studiata in modo disaggregato a livello territoriale, settoriale e per le principali caratteristiche socio-demografiche della popolazione. La capacità di fornire inoltre informazioni riguardanti la partecipazione ad attività d’istruzione e/o di formazione professionale, disaggregate in base alla condizione professionale, al sesso, all’età e al territorio rende evidente quanto questa fonte informativa sia rilevante per gli ambiti di ricerca e di 16 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse attività istituzionale dell’Istituto e come questa abbia costituito il contesto applicativo ideale per la realizzazione della prima applicazione delle procedure. I dati dell’indagine Forze di Lavoro trattano essenzialmente mutabili statistiche che possono essere rappresentate attraverso variabili qualitative, per cui i modelli per la valutazione dell’attendibilità delle stime prodotte fanno riferimento essenzialmente a stime di frequenze assolute; per le poche variabili quantitative rilevate dall’indagine, es. le ore lavorate, vengono calcolati gli errori campionari con altri modelli, che non vengono regolarmente diffusi. Unitamente ai dati elementari, l’ISTAT diffonde alcuni prospetti necessari a valutare l’attendibilità delle stime, attraverso tabelle in cui sono riportati valori esemplificativi o fogli di calcolo con i quali è possibile determinare per singoli valori delle stime i relativi errori e intervalli, seguendo la metodologia che verrà descritta nel prossimo paragrafo. La prima indagine svolta dall’Isfol per la quale è stato esteso lo sviluppo delle procedure per il calcolo dell’attendibilità delle stime è la rilevazione Isfol-PLUS, indagine condotta dall’Area Ricerche sui Sistemi del Lavoro. In seguito le procedure sono state sviluppate sia per l’indagine “Gli esiti occupazionali dell'alta formazione nel Mezzogiorno”, svolta dall’area dall’Area Valutazione Politiche Risorse Umane dell’Isfol, sia per un’indagine Istat di particolare rilevanza per l’attività istituzionale dell’Isfol: l’indagine Istat Multiscopo “Cultura, tempo libero e nuove tecnologie”, che nell’edizione del 2006 contiene il modulo armonizzato a livello europeo Adult Education Survey specifico sulla partecipazione degli adulti alla formazione. Per un’analisi dettagliata della metodologia con cui è stato sviluppato il disegno campionario si rimanda alle note metodologiche dei rapporti di ricerca dei progetti, in cui si possono cogliere e approfondire tutti gli elementi di specificità delle varie indagini. Nel processo di elaborazione e trattamento dei dati si possono però identificare alcune attività tipicamente svolte in indagini campionarie su vasta scala tra cui l’analisi della varianza delle stime, la costruzione degli errori campionari nonché la presentazione sintetica degli errori campionari ricorrendo a modelli di regressione, che quindi ha consentito di estendere le procedure sviluppate nell’ambito dell’indagine sulle Forze di Lavoro. La Tabella 1 mostra le partizioni della popolazione di riferimento che definiscono per l’indagine Isfol-PLUS i domini stima all’interno dei quali sono stati calcolati gli errori campionari delle stime 17 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse relative alle variabili di interesse. Come è possibile notare i domini di stima sono definiti dalle variabili che concorrono alla stratificazione dell’universo di riferimento nella strategia campionaria. A partire dall’edizione del 2006 dell’indagine l’analisi della variabilità delle stime è stata rivista, estendendo il calcolo degli errori campionari a tutti i domini di stima pianificati. Tabella 1 – Variabili che definiscono i domini di stima dell’indagine Isfol-Plus Variabili Modalità Genere Femmina, Maschio Età in classi 15-19, 20-29, 30-39, 40-49, 50,64 Regione Tipo di comune Condizione occupazionale Tutte le regioni (insieme Valle d’Aosta e Piemonte) Metropolitano, Non metropolitano Occupato/a, In cerca di occupazione, Studente/essa, Casalinga, Ritirato/a dal lavoro L’elemento che caratterizza l’indagine Plus è la definizione di un insieme di domini pianificati che non costituisce una partizione sempre univoca dell’universo di riferimento. Nel caso dell’indagine Forze di Lavoro il dominio pianificato coincide sempre con un livello di disaggregazione territoriale che può andare dal totale Italia al dettaglio provinciale, pertanto è sempre possibile far riferimento ad una di queste partizioni per la scelta del modello su cui calcolare le stima dell’errore campionario. Nel caso dell’indagine Plus, invece, i domini pianificati definiscono partizioni in parte sovrapposte, pertanto non è sempre univoca la scelta del dominio pianificato cui fare riferimento. Ad esempio, analizzando il numero di lavoratori atipici per regione e sesso la stima può essere considerata come relativa a due diversi domini pianificati, quello regionale e per genere, lasciando al ricercatore la scelta del modello con cui effettuare la stima dell’errore. Sono stati tentati alcuni approcci per definire uno o più criteri di scelta generalmente validi da implementare nella procedura: è stato calcolato il massimo tra i possibili errori relativi riferiti ai vari domini di stima richiesti o, alternativamente, è stato individuato il riferimento al dominio pianificato di maggior dettaglio, che offre tipicamente errori relativi maggiori. 18 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Nessuno dei criteri sperimentati sembra al momento conciliare il necessario rigore metodologico e l’efficienza delle procedure, pertanto appare opportuno effettuare degli approfondimenti. Nelle applicazioni si lascia quindi la scelta del relativo dominio pianificato alla sensibilità del ricercatore, ricordando che in genere è da preferirsi il dominio pianificato di maggior dettaglio, che rappresenta la scelta più conservativa: nell’esempio considerato sarà preferibile scegliere la regione come dominio pianificato ed il sesso come variabile di classificazione. Un altro elemento forte di differenziazione è costituito dai vincoli introdotti nella procedura di calibrazione dell’Indagine Plus, che prevede l’identificazione, nella popolazione di riferimento individuata su base RCFL, di un certo numero di totali noti a cui vincolare le stime pesate ottenute dai micro dati PLUS. Le scelte fatte rispondono ad esigenze diverse: la necessità di garantire la coerenza con l’informazione ufficiale dell’ISTAT in due ambiti fondamentali: i) la distribuzione territoriale e composizione socio-demografica della popolazione, nonché ii) le caratteristiche necessarie alla definizione degli indicatori standard del mercato del lavoro (popolazione di occupati, disoccupati e inattivi – studenti, casalinghe e pensionati da lavoro). Un’immediata implicazione di questo complesso sistema di vincoli è l’impossibilità di far riferimento nell’analisi ad un solo “totale noto” della popolazione, in quanto i diversi moduli del questionario ed i fenomeni indagati sono specifici di particolari segmenti della popolazione di riferimento. 19 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Conclusioni e prossimi sviluppi In questo lavoro sono stati illustrati i primi risultati ottenuti in Isfol dal Servizio Statistico e Coordinamento delle Banche Dati riguardo la patrimonializzazione dell’informazione statistica dell’Istituto, costituita dalle fonti informative, le relative informazioni di contesto ed i metodi e strumenti di analisi e trattamento dei dati che garantiscano, integrandosi tra loro, un significativo miglioramento degli standard qualitativi dell’informazione statistica prodotta e diffusa. L’impiego di tecnologie di data warehouse web based ha contribuito a fornire validi strumenti di presidio di alcune dimensioni cruciali della qualità statistica spesso in conflitto tra loro: il miglioramento della accessibilità e della interpretabilità delle fonti statistiche basate su indagini campionarie è stato affiancato dalla predisposizione di strumenti generalizzati in grado di affrontare in modo metodologicamente rigoroso la necessità di valutare l’attendibilità delle stime prodotte. Il sistema, già in esercizio, è stato sviluppato per tutte le indagini campionarie acquisite dal Servizio Statistico attraverso protocolli di comunicazione dati tra enti appartenenti al Sistan e a gran parte delle indagini svolte internamente dalle aree di ricerca dell’Istituto. Gli sviluppi futuri potranno riguardare l’estensione a strutture dati basate su ipercubi navigabili attraverso OLAP, per i quali andranno sviluppate procedure generalizzate che consentano la loro definizione in modo parametrico nonché i meccanismi per la corretta applicazione delle metodologie descritte nella navigazione attraverso i livelli delle gerarchie, che possono coinvolgere diversi domini di stima e più vincoli dei totali noti. Le funzionalità sviluppate consentono di ovviare ad alcuni elementi di criticità nell’utilizzo di comuni data warehouse nel contesto delle indagini campionarie complesse e per la loro modularità costituiscono una esperienza che potrà essere applicata in altri progetti finalizzati allo costituzione di sistemi informativi basati su metadati per il supporto allo sviluppo di indagini dirette. 20 Strumenti e tecniche di Business Intelligence per valutare l’attendibilità delle stime campionarie di indagini complesse Bibliografia Centra M., Falorsi P.D. (a cura di), Strategie di campionamento per il monitoraggio e la valutazione delle politiche, Roma, Isfol, 2007 (Temi e strumenti) De Francisci S., Sindoni G., Tininini L., DaWinci/MD: un sistema per data warehouse statistici sul web, Roma, Istituto Nazionale di Statistica, Contributi n. 14 , 2005 http://www.istat.it/dati/pubbsci/contributi/Contributi/contr_2005/2005_14.pdf Deville, J. C., Särndal, C. E., Calibration Estimators in Survey Sampling, “Journal of the American Statistical Association”, vol. 87, 1992 http://www.jstor.org/pss/2290268 Di Giammatteo M., L’indagine campionaria ISFOL-PLUS: contenuti metodologici e implementazione, Roma, Isfol, Studi Isfol, 2009/3 http://www.isfol.it/Studi_Isfol/Dettaglio_Studi/index.scm?codi_nota=371&codi_percorso=51 Gazzelloni S. (a cura di), La rilevazione sulle forze di lavoro: Contenuti, metodologie, organizzazione, Roma, Istituto Nazionale di Statistica, Metodi e norme n. 32 , 2006 http://www.istat.it/dati/catalogo/ricerca.php?tipo=n&ciclo=0&stringa=&collane%5B%5D=14&nu m_collana=32&anni%5B%5D=2006 Pagliuca D. (a cura di), GENESEES V. 3.0 Manuale utente e aspetti metodologici, Istituto Nazionale di Statistica, Tecniche e Strumenti 3, 2005 http://www.istat.it/strumenti/metodi/software/produzione_stime/genesees/index.html Woodruff R. S., A Simple Method for Approximating the Variance of a Complicated Estimate, “Journal of the American Statistical Association”, Vol. 66, n. 334, 1971 http://www.jstor.org/pss/2283947 21

Scaricare