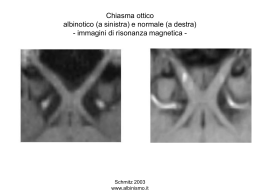

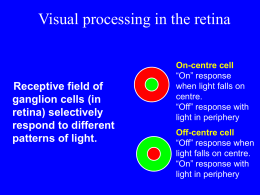

Capitolo 4 Sistema ottico 4.1 Introduzione Nel processo di formazione dell’immagine, il sistema ottico genera in un piano (il piano immagine) l’immagine bidimensionale degli oggetti 3D del mondo la cui superficie è normalmente illuminata da luce propria e dalla luce dell’ambiente. Il sistema ottico di un qualunque sistema di acquisizione delle immagini (macchine fotografiche, telecamera, ecc.) caratterizza fortemente la qualità dell’immagine generata, in termini di: • risoluzione geometrica capacità di riprodurre dettagli geometrici degli oggetti • proiezione geometrica modalità di propagazione dei raggi di luce incidenti il sistema ottico • intensità di luce proiettata • nitidezza dell’immagine. I raggi di luce provenienti dagli oggetti nella scena attraversano il sistema ottico, il quale, modifica in modo adeguato il loro cammino ottico. Infine, generano l’immagine della scena proiettata nel piano immagine perpendicolare all’asse ottico. Il processo di formazione dell’immagine è schematizzato in figura 6.1. Dal sistema ottico, la superficie visibile degli oggetti può essere vista come decomposta in superfici elementari S che si comportano come tante piccole sorgenti di luce ciascuna delle quali emette onde sferiche elettromagnetiche che propagano la luce radialmente in tutte le direzioni. In questo scenario, alcuni raggi di luce emergenti da un elemento di superficie S Figura 4.1: Sistema ottico per la formazione dell’immagine 87 88 CAPITOLO 4. SISTEMA OTTICO dell’oggetto, colpiscono il sistema ottico, il quale li converge in un punto P noto come punto focale del fascio di raggi di luce emergenti dal punto S dell’oggetto. Un sistema ottico con questa caratteristica è detto di essere stigmatico per i due punti S e P, e l’energia luminosa che raggiunge P genera una perfetta immagine del punto S. La luce proveniente da altri punti S dell’oggetto possono produrre l’immagine di S anche non perfetta, ossia il sistema ottico può convergere raggi di luce risultando non completamente a fuoco e generando intorno a P uno spot luminoso. Figura 4.2: Sezioni trasversali di lenti semplici sferiche. La prima interfaccia da sinistra ha raggio di curvatura R1 , mentre quella destra R2 . Figura 4.3: Pupilla e diaframma in un sistema ottico con tre lenti semplici sferiche. In questo schema di formazione dell’immagine, non si considerano alcuni fenomeni di propagazione della luce come la riflessione, dispersione, assorbimento che possono attenuare l’intensità del punto immagine P, ed il fenomeno della diffrazione dovuto alla propagazione ondulatoria della luce invece della propagazione con raggi rettilinei assunta nello schema 4.2. LENTI SOTTILI 89 precedente. Gli effetti della diffrazione sono trascurabili quando la lunghezza d’onda della luce considerata è molto piccola rispetto alle dimensioni del sistema ottico. Nel contesto dell’ottica geometrica la lunghezza d’onda λ si assume con valore zero e conseguentemente si considerano totalmente trascurabili i fenomeni della diffrazione e della interferenza. In analogia al sistema visivo umano che utilizza una coppia di lenti (i due cristallini), anche i sistemi ottici artificiali impiegano gruppi di lenti opportunamente sagomate (con superficie sferica) per focalizzare correttamente l’immagine acquisita. 4.2 Lenti sottili Un sistema ottico che consiste solo di una lente, ossia presenta un elemento con due superfici di rifrazione è chiamato lente semplice. Quando gli elementi ottici sono più di uno si parla di sistema ottico con lenti composte. Una lente è definita lente sottile quando lo spessore della lente è trascurabile. La figura 6.2 mostra lenti semplici convesse e concave e la figura 6.3 mostra un sistema ottico composto di tre elementi. Generalmente la sagoma delle lenti sono sferiche e caratterizzati dal raggio di curvatura R1 ed R2 e dall’asse ottico che è simmetrico rispetto alle due interfacce della lente. Si definisce interfaccia della lente la superficie di separazione tra i due mezzi di propagazione della luce che, nel caso di una lente sottile risultano aria-vetro oppure vetro-aria, e nel caso di lente composta si aggiungono anche le interfacce vetro-vetro. Le lenti convesse (o convergenti o positive) hanno lo spessore più grande in corrispondenza dell’asse ottico e tendono a decrescere il raggio di curvatura dei raggi di luce incidente, ossia tendono a far convergere i raggi luminosi che la attraversano assumendo che l’indice di rifrazione della stessa lente sia più grande di quello dell’aria dove generalmente è immersa (n2 >n1 ). Le lenti concave (o divergenti oppure negative), al contrario, hanno uno spessore minimo sull’asse ottico e tendono a far divergere i raggi luminosi che l’attraversano. Le lenti concave hanno la funzione di modificare la forma di un fascio di luce che li attraversa in modo controllato sulla base dei suoi parametri caratteristici (asse ottico, raggi di curvatura e sagoma della lente). Una buona lente deve convergere la luce proveniente dagli oggetti generando un’immagine nitida. Normalmente l’immagine formatasi, presenta delle deformazioni ed errori causati da alcuni difetti delle lenti, noti come aberrazioni, dovuti per esempio alla non sfericità o imperfetta simmetria della lente. Tali aberrazioni possono essere controllate correggendo adeguatamente le lenti, mentre rimangono quelli dovuti al fenomeno della diffrazione. θr θi A li lo h S V R p ϕ θi P q n2 n1 Figura 4.4: Rifrazione su un’interfaccia sferica. Vediamo ora cosa accade (vedi figura 6.4) quando un raggio di luce proveniente dal 90 CAPITOLO 4. SISTEMA OTTICO Figura 4.5: Raggi incidenti con lo stesso angolo. punto S dell’oggetto colpisce la superficie sferica della lente che ha un raggio di curvatura R e centrata in C. Sia A il punto di incidenza relativo al raggio SA che viene rifratto (n2 > n1 ) intersecando in P l’asse ottico. Per avere in P una immagine nitida di S ogni raggio di luce emesso da S deve convergere in P nello stesso intervallo di tempo come proposto da Huygens, oppure per il principio di Fermat applicato alla rifrazione, qualunque raggio proveniente da S esegue un cammino ottico più corto per raggiungere P. Se S è immerso in un mezzo con indice di rifrazione n1 e P in un mezzo più denso con indice di rifrazione n2 (ossia n2 > n1 ) si ha la seguente relazione: lo n1 + li n2 = pn1 + qn2 (4.1) dove p è la distanza del punto S (oggetto) dal vertice V, q è la distanza da V del punto P (l’immagine di S), l 0 è la lunghezza del segmento SA , ed l i è la lunghezza del segmento AP . La figura 6.4 evidenzia come i raggi che entrano in un mezzo con più alto indice di rifrazione si rifrangono verso la normale della superficie incidente e verso l’asse ottico. Si assume anche che nello stesso punto P converge ogni altro raggio luminoso incidente, avente lo stesso angolo θi come mostrato in figura 6.5. L’asse ottico è dato da SP ed i punti S e P sono chiamati punti coniugati ossia anche P può diventare sorgente e la sua immagine diventa S. In generale, dato un sistema ottico si chiamano punti coniugati il punto oggetto (in questo caso S) ed il corrispondente punto immagine (nell’esempio il punto P ) dato dal sistema ottico. Dal punto di vista fisico la (4.1) si spiega come segue. La luce proveniente dall’oggetto S attraversando la lente che è un materiale più denso dell’aria, viaggia con velocità minore rispetto a quando viaggiava nell’aria. Quando da S i raggi di luce simultaneamente passano dal vertice V e dal punto A viaggiando nello stesso mezzo n1 , si verifica che arriva prima (con velocità c/n1 ) il raggio in V propagandosi poi con una minore velocità c/n2 nel mezzo più denso (ricordiamo che n2 > n1 ). Il raggio che arriva in A invece, percorre nello stesso tempo un cammino più lungo (lo + li > p + q) ma convergendo in P nello stesso tempo. Definiti i valori di p e q, la relazione (4.1) diventa: lo n1 + li n2 = costante = cammino ottico stazionario (4.2) Si può concludere che se una sorgente puntiforme è posizionata nel punto S, sull’asse ottico di una lente, i raggi di luce convergono nel punto coniugato P ottenendo una immagine nitida (a fuoco) della sorgente S che si può osservare ponendo in P uno schermo perpendicolare all’asse ottico della lente convessa. L’immagine della sorgente S ottenuta è chiamata immagine reale. Se la sorgente è considerata localizzata all’infinito, i raggi incidenti su una lente concava arrivano paralleli ed emergono divergendo. Tali raggi appaiono provenienti dal punto P ma non si osserva nessuna immagine nitida su uno schermo posto 4.2. LENTI SOTTILI 91 F2 F1 a) F2 b) Figura 4.6: a) Lente doppia iperbolica e b) lente piana concava iperbolica. in P . In questo caso si parla di immagine virtuale analogamente all’immagine generata da uno specchio piano. La distanza q tra l’immagine virtuale in P (che appare alla sinistra del vertice V ) ed il vertice V risulterà negativa (figura 6.4). Ritornando al processo di rifrazione della luce incidente sulla lente sferica, considerando il lato vicino alla sorgente S (vedi figura 6.4), possiamo affermare che tutti i raggi con lo stesso angolo di incidenza θi convergono in P avendo lo stesso cammino ottico. Se il punto di incidenza A si sposta verso V assumendo pertanto valori di ϕ molto piccoli con l 0 ≈ p ed l i ≈ q, si dimostra, con buona approssimazione, valida la seguente relazione dei punti coniugati S e P : n1 n2 n2 − n1 + = p q R (4.3) dove R è il raggio di curvatura della lente del lato vicino alla sorgente. Questa relazione risulta valida per raggi poco inclinati rispetto all’asse ottico e sono chiamati raggi parassiali che generano normalmente una immagine nitida in P alla distanza q. Analizziamo tre casi speciali. Nel primo caso (vedi figura 6.7a), l’immagine si forma all’infinito ossia q = ∞ e dalla equazione (4.3) considerato che il termine n∞2 si annulla, si ricava la distanza singolare dell’oggetto chiamata lunghezza focale dell’oggetto f0 risultando: f0 = p = n1 R n2 − n1 (4.4) ed il punto S è chiamato primo fuoco o fuoco dell’oggetto. Nel secondo caso (vedi figura 6.7b), l’oggetto si considera all’infinito. Nella equazione (4.3) il primo termine n∞1 si annulla e l’immagine si forma in P alla distanza chiamata lunghezza focale dell’immagine f i data da: fi = q = n2 R n2 − n1 (4.5) 92 CAPITOLO 4. SISTEMA OTTICO Figura 4.7: Figura 4.8: Rifrazione su una interfaccia sferica. ed il punto P sull’asse ottico è chiamato secondo fuoco o fuoco dell’immagine. Analogamente si ha per l’immagine virtuale (i raggi divergono dal fuoco dell’immagine come evidenziato in figura 6.7c) e per l’oggetto virtuale dove i raggi convergono verso il fuoco dell’oggetto (vedi figura 6.7d). L’oggetto virtuale si forma alla destra del vertice V, la distanza p diventa negativa e l’immagine virtuale si forma alla sinistra di V con raggio R negativo come richiesto dalla (4.4) con la distanza focale f0 negativa. Nel terzo caso, se si assume p molto grande, per un fissato valore costante di n2 − n1 /R per la (4.3) risulterebbe associato un valore di q molto piccolo. Se p decresce, la distanza q aumenta, ossia l’immagine P di S si allontana dal vertice V (θi e θt aumentano, vedi figura 6.4), fino a quando p diventa uguale ad f 0 ed fi = ∞. In questo caso n1 /p = (n2 − n1 )/R e conseguentemente, se p diventa ancora più piccolo il fuoco dell’immagine si forma a sinistra di V con il valore di q negativo e con la (4.3) che risulterebbe ancora valida (vedi figura 6.8). I punti coniugati per una lente convessa con indice di rifrazione nl immersa nell’aria che ha indice di rifrazione na (con nl > na ) possono essere localizzati considerando ancora valida l’equazione (4.3). In figura 6.9 è visualizzato il processo di rifrazione quando un raggio attraversa entrambe le due interfacce della lente sferica. Un raggio incidente la prima faccia della lente viene rifratto entrando nella lente ed inclinato verso la normale alla superficie della lente nel punto di incidenza, e quando emerge dalla seconda faccia subisce un ulteriore rifrazione, e giacché nl > na, si propaga in modo inclinato verso l’asse ottico allontanandosi dalla normale alla seconda faccia. Nell’ipotesi di raggi parassiali che attraversano la prima faccia della lente della sorgente S localizzata alla distanza p1 dal vertice V1 , si forma l’immagine in P1 alla distanza q1 da V1 e la relazione dei punti coniugati diventa: nl nl − na na + = p1 q1 R1 (4.6) 4.2. LENTI SOTTILI 93 P1 P C2 S nl na nl R2 na V1 C1 C2 V2 C1 R 1 na na d p1 q2 q1 P2 Figura 4.9: Rifrazione in una lente sferica sottile e geometria dei punti coniugati. La seconda superficie vede i raggi (propagandosi nella lente con indice di rifrazione nl ) provenienti da P1 , che lo considera come un oggetto alla distanza p2 dal vertice V2 , formando l’immagine in P alla distanza q2 . Inoltre, i raggi che arrivano sulla seconda superficie sono immersi nel mezzo con indice di rifrazione n l , e lo spazio oggetto per questa superficie che contiene P1 ha indice di rifrazione n l . Infatti, i raggi luminosi provenienti da P1 sono rettilinei senza subire rifrazione come se la prima superficie della lente non esistesse. In tale contesto la relazione dei punti coniugati ricordando la (4.3) diventa: nl na na − nl + = p2 q2 R2 (4.7) considerando p2 = -q1 + d, R2 <0 e nl >na (vedi figura 6.9). Si osserva che l’equazione (4.7) rimane valida considerando che la distanza q1 risulta negativa dato che P1 si trova a sinistra di V1. Combinando la (4.6) e (4.7) si ha la relazione dei punti coniugati per una lente sottile: na nl + = (nl − na ) p1 q2 µ 1 1 − R1 R2 ¶ + nl d (q1 − d) q1 (4.8) Per una lente sottile, con lo spessore della lente trascurabile (d→0), l’ultimo termine della (4.8) è trascurabile e considerando l’indice di rifrazione dell’aria na = 1, l’equazione dei punti coniugati per la lente sottile diventa: 1 1 + = (nl − 1) p q µ 1 1 − R1 R2 ¶ (4.9) Per una lente sottile i vertici V1 e V2 possono coincidere con V ossia il centro della lente e le distanze p e q sono considerate calcolate rispetto al centro V della lente. Ricordiamo che anche per una lente sottile se l’oggetto è all’infinito l’immagine è focalizzata alla distanza fi ed analogamente se l’immagine è focalizzata all’infinito il fuoco dell’oggetto è alla distanza f0 che per l’equazione precedente risulta fi = f0 e pertanto possiamo definire un’unica distanza focale (per l’immagine e per l’oggetto) come: 1 = (nl − 1) f µ 1 1 − R1 R2 ¶ (4.10) La relazione dei punti coniugati per la lente sottile diventa: 1 1 1 + = p q f nota anche come la formula della lente Gaussiana. (4.11) 94 CAPITOLO 4. SISTEMA OTTICO 4.2.1 Esempio Utilizziamo l’equazione (4.10) per calcolare la lunghezza focale di una lente avente una faccia piana (ossia con R1 = ∞) e l’altra faccia sferica con raggio R2 di -50mm (vedi figura 6.2). Sia l’indice di rifrazione nl uguale a 1.5 applicando la (4.10) la lente risulterebbe avere una lunghezza focale di 100mm considerando la luce entrante dalla faccia piana e la lente immersa nell’aria (na ∼ = 1). La stessa focale si avrebbe se la prima faccia della lente risultasse sferica (ossia R1 = 50 mm) e la seconda faccia fosse piana. Si può inoltre osservare che ponendo un oggetto a diverse distanze 600, 200, 150, 100 e 50 con la (2) si calcola che l’immagine si forma alla distanza di µ ¶ µ ¶ 1 1 1 1 q = 1/ − = 1/ − = 120mm (4.12) f p 100 600 Per le altre distanze p le immagini si formano rispettivamente alle seguenti distanze 200mm, 300mm, ∞ e 100mm. Quando p = ∞ si ha che q = f. All’avvicinarsi di S verso la lente, ossia p diminuisce, il valore di q aumenta positivamente fino a quando p = f e conseguentemente q risulta negativo. Si può sperimentare direttamente con una lente convessa ed avvicinando una lampadina piccola accesa verso di essa, quindi ponendo un foglio di carta bianca nel piano di formazione dell’immagine si proietterà la lampadina in modo chiaro o sfocato in relazione alla sua distanza dalla lente. Nel caso di p < f l’immagine svanisce ossia si forma una immagine virtuale. Formalizziamo ora il piano focale dove si forma l’immagine. Nell’ipotesi della teoria parassiale, raggi di luce paralleli incidenti sulla superficie di una lente sottile convessa (R1 > 0 ed R2 < 0, con nl > na ) sono rifratti e convergono in un unico punto di un piano perpendicolare all’asse ottico della lente e passante per il fuoco dell’immagine. Tale piano si chiama piano focale di formazione dell’immagine. Fasci di luce paralleli all’asse ottico sono rifratti e convergono nel punto focale, mentre fasci paralleli leggermente inclinati rispetto all’asse ottico convergono in un punto del piano focale ottenuto dall’intersezione del raggio non deviato (ossia passante per il centro della lente sottile) ed un raggio deviato. Le dimensioni dell’immagine prodotta da una lente sottile sono determinate conoscendo la posizione dei punti focali della lente e considerando i raggi che soddisfano ad alcune proprietà: 1. due raggi passando attraverso un punto focale devono emergere dalla lente paralleli all’asse ottico (figura 6.10a); 2. viceversa raggi parassiali paralleli incidenti la lente convergono nel punto focale (figura 6.10b); 3. il raggio incidente passante per il centro della lente emerge senza subire nessuna deviazione (figura 6.10c); 4. due raggi sono sufficienti a localizzare l’immagine P di un punto S dell’oggetto (figura 6.11). Le informazioni di orientazione, localizzazione e dimensione dell’immagine rispetto ai parametri noti dalla lente (distanza focale f ) e dell’oggetto (distanza p dalla lente e altezza y0 rispetto all’asse ottico) sono facilmente determinati osservando (vedi figura 6.11) che i triangoli AOFi e PQFi sono simili e consegue la relazione seguente: f y0 = |yi | (q − f ) Dalla similitudine dei triangoli SRO e PQO segue la relazione: y0 p = |yi | q (4.13) (4.14) 4.2. LENTI SOTTILI 95 Figura 4.10: Cammino ottico di un raggio luminoso attraverso una lente positiva e negativa. Figura 4.11: Posizione dell’oggetto e dell’immagine per una lente sottile. Dalle relazioni (4.13) e (4.14) si ricava facilmente l’equazione gaussiana per le lenti sottili: 1 1 1 = + f p q (4.15) Ed infine, dalla similitudine dei triangoli SRF0 e BOF0 si ottiene la relazione: f |yi | = (p − f ) y0 (4.16) che combinando con la (4.13) e considerando le distanze Z e z dai fuochi, possiamo derivare le seguente relazione: Z · z = f2 (4.17) dalla quale è possibile determinare la distanza del piano focale z = f 2 /Z. L’equazione (4.17) è la formulazione di Newton dell’equazione fondamentale delle lenti. Per convenzione si assumono valori positivi di Z se l’oggetto è a sinistra del fuoco F0 , mentre z è considerato positivo se l’immagine è formata alla destra di Fi (vedi figura 6.11). Va ricordato pertanto, che oggetto ed immagine devono trovarsi ai lati opposti dei rispettivi fuochi, affinché le distanze Z e z risultino positive. L’inversione dell’immagine (ossia l’immagine capovolta) è considerata valutando il segno di yi , che se negativo, significa oggetto capovolto nell’immagine. Il rapporto tra le distanze verticali del punto immagine P e del punto oggetto S rispetto all’asse ottico, rispettivamente indicato con P Q ed RS , è chiamato fattore di ingrandimento M introdotto dal sistema ottico (vedi figura 6.11), ossia: M= q PQ =− p SR (4.18) Il segno meno indica che l’immagine è stata invertita. Le distanze p e q sono sempre entrambe positive per oggetti e immagini reali. Questo implica che l’immagine formata da una lente sottile è sempre invertita. 96 CAPITOLO 4. SISTEMA OTTICO Figura 4.12: Formazione dell’immagine con una lente sottile convessa. Considerando equazioni le equazioni (4.13), (4.15), (4.16) e (4.17) si possono derivare alcune relazioni utili all’analisi del sistema ottico: M =− z f f Z M f =p M +1 M =− q = f · (M + 1) p=f (M + 1) M (4.19) (4.20) (4.21) (4.22) (4.23) Il valore di M assume valore 1 (nessun ingrandimento) quando l’oggetto e l’immagine hanno uguale distanza e dall’equazione (4.15) dei punti coniugati si osserva che questo accade quando p = q = 2f. In questa configurazione l’oggetto e l’immagine si trovano ad una distanza di 4f che è la più vicina possibile. In figura 6.12 sono mostrate le altre possibili configurazioni variando la distanza dell’oggetto rispetto alla lente sottile. Si osserva che avvicinando l’oggetto alla lente si produce un’immagine reale che si allontana da essa, e quando si avvicina alla lente con distanza inferiore a f l’immagine prodotta risulta: • ingrandita, dalla(4.20) con |Z| < f ⇒ M > 1; • non invertita,dalla (4.20) con Z < 0 ⇒ M positivo; • virtuale,dalla (4.19) con M > 0 si ha che z < 0. Quando l’oggetto si allontana dalla lente (∞ > Z > 2f ) si ottiene un’immagine reale, invertita, rimpicciolita (M < 1) e localizzata alla distanza z nell’intervallo (f, 2f ) . La situazione singolare con la produzione di nessuna immagine (z = ∞) si verifica con l’oggetto localizzato alla distanza focale (Z = f ). Nelle realtà, non esiste una lente sottile ma una lente convessa con uno spessore molto piccolo che si comporta otticamente come una lente sottile. I sistemi ottici commerciali si compongono invece con un gruppo assemblato di lenti convesse e concave. Un sistema ottico con N lenti aventi focali f1 , f2 , . . . , fN può essere visto come tante lenti a contatto che costituiscono un’unica lente spessa e con lunghezza focale effettiva f tale che soddisfa la seguente relazione: 1 1 1 1 = + + ··· + . f f1 f2 fN (4.24) 4.3. ABERRAZIONI OTTICHE 97 Figura 4.13: Sistema ottico composto di lente positiva (convessa) e di lente negativa (concava). 4.3 Aberrazioni ottiche I sistemi ottici realizzati con un gruppo di lenti producono immagini non perfette in quanto la luce si propaga attraverso le lenti spesse violando le leggi di propagazione (riflessione e rifrazione) della luce, assunte per una lente sottile con la teoria parassiale. Per avere una misura quantitativa di come il sistema ottico introduce delle deformazioni nell’immagine si analizzano tali difetti che in ottica sono chiamate aberrazioni ottiche. Si hanno pertanto: • aberrazioni monocromatiche, che si verificano per qualunque tipo di luce (colore o singola frequenza) e producono immagini poco chiare per effetto delle aberrazioni sferiche, l’astigmatismo, il coma, la curvatura del campo, la distorsione; • aberrazioni cromatiche sono dovute al diverso indice di rifrazione delle lenti rispetto alle diverse radiazioni monocromatiche che le attraversano (figura 6.15a). La distanza focale di una lente è funzione della lunghezza d’onda della luce incidente che viene rifratta dagli elementi ottici, formando tante immagini diverse di una stessa sorgente luminosa per quante sono le componenti cromatiche dominanti di cui è composta. Questa aberrazione si elimina con componenti ottici acromatici. L’aberrazione sferica si ha nei sistemi ottici con simmetria circolare (specchi sferici, lenti normali, ecc.) per i quali i raggi provenuti dalle zone periferiche e dalle zone centrali di una lente o di uno specchio (detta zona parassiale ossia vicina all’asse della lente) non convergono in un punto, ma il loro inviluppo presenta una figura di rivoluzione chiamato caustica di rifrazione per lenti convesse e caustica di riflessione per lenti concave. Per attenuare gli effetti dell’aberrazione sferica normalmente si diaframma adeguatamente il sistema ottico (figura 6.15b). L’aberrazione di astigmatismo si ottiene quando l’oggetto puntiforme (o sorgente) non giace sull’asse ottico. L’oggetto ed il sistema ottico non hanno una simmetria rotazionale rispetto all’asse ottico, ne consegue che anche il fascio emergente del sistema ottico non è più conico, ma presenta un solo piano di simmetria rappresentato dall’oggetto e dall’asse ottico. Le sezioni del fascio non sono più circolari, ma si presentano ellittiche con dimensioni sempre più piccole man mano che ci si allontana dal sistema ottico sino a ridursi ad un segmento. Questo fenomeno si evidenzia restringendo adeguatamente il diaframma circolare. Una volta formatosi il segmento, il fascio continua ad aumentare di dimensione e la sua forma ellittica si allarga in modo indefinito (figura 6.15c). L’aberrazione del coma (una forma particolare di astigmatismo) si ha quando l’oggetto ed il diaframma sono spostati rispetto all’asse ottico (figura 6.15da). Le sezioni del fascio emergente non sono di forma ellittica ma assumono la configurazione di una cometa 1 (figura 6.15db). L’aberrazione di curvatura del campo generalizza l’aberrazione di astigmatismo. Si evidenzia disponendo un oggetto non più puntiforme, ma piano, e per ogni punto dell’oggetto 1 Il termine coma deriva dal nome cometa. 98 CAPITOLO 4. SISTEMA OTTICO Figura 4.14: Aberrazioni ottiche. si hanno due linee focali. Le due superfici inviluppate corrispondenti sono ricurve e costituiscono i luoghi delle immagini sfumate corrispondenti ai punti dell’oggetto. Il nome di curvatura di campo deriva dalla curvatura di queste superfici che non sono piane. Per ridurre questa aberrazione si tenta di far coincidere le superfici curve su un piano (figura 6.15c). L’aberrazione di distorsione si genera nei sistemi ottici per i quali l’ingrandimento trasversale lineare non è costante, ma può variare in funzione della distanza dell’oggetto dall’asse ottico. Per esempio, per un segmento rettilineo (non passante per l’asse ottico) l’immagine prodotta è distorta poiché ogni elemento del segmento subisce diversi ingrandimenti. Si hanno distorsioni a cuscinetto quando l’ingrandimento aumenta col crescere della distanza dell’oggetto dall’asse, viceversa l’ingrandimento diminuisce quando l’oggetto si avvicina all’asse ottico generando la distorsione a barile. L’aberrazione cromatica extra-assiale si ha quando l’ingrandimento trasversale lineare varia anche in funzione della lunghezza d’onda della luce utilizzata. 4.3.1 Parametri di un sistema ottico I primi due parametri, già discussi, che caratterizzano un sistema ottico sono la lunghezza focale f ed il diametro D che determina la quantità massima di luce che può raggiungere il piano immagine. La quantità di luce che colpisce il piano immagine, definita come energia luminosa per unità di area per unità di tempo (densità di flusso luminoso) è inversamente proporzionale all’area dell’immagine. I parametri diametro D e focale f di una lente ne caratterizzano il suo campo di vista. In altre parole determinano l’angolo di campo di una lente delimitando il cono di vista del mondo 3D che può essere osservabile (figura 4.15). Per un sistema ottico di diametro D, 4.3. ABERRAZIONI OTTICHE 99 Figura 4.15: l’energia luminosa è proporzionale al quadrato di D. L’area immagine varia anche con il quadrato della dimensione trasversale che risulta per l’equazione (4.18) proporzionale ad f2 . Conseguentemente nel piano immagine la densità di flusso luminoso varia in funzione di (D/ f)2 . Il rapporto D/f tra il diametro D e la focale f è chiamato apertura relativa ed il suo inverso è chiamato apertura del diaframma a, dato da: a= f D Nella letteratura anglosassone è indicato anche con il simbolo f/# (che si legge f - number). Il diaframma è un meccanismo per limitare la quantità di luce che attraversa il sistema ottico per raggiungere il piano immagine dove si trovano gli elementi sensibili (fotorecettori di una telecamera CCD oppure emulsione fotografica). Il diaframma si compone di tante lamelle incernierate su un anello che in modo sincronizzato ruotano facendo variare le dimensioni dell’apertura circolare limitando in questo modo il passaggio della luce. L’apertura a varia da un valore minimo quando il diaframma è completamente aperto (corrispondente al diametro D dell’ottica) ad un valore massimo ottenuto diaframmando al massimo ossia riducendo al minimo il diametro del diaframma.√La scala di valori dell’apertura a varia secondo una progressione geometrica di ragione 2 il cui primo valore è 1 e prosegue con i valori 1.4, 2, 2.8, 4, 5.6, 8, 11, 16, 32, 45, 60, . . . Questa scala di valori è stata standardizzata a livello internazionale e tutti i sistemi ottici commerciali hanno le stesse scale di diaframma come sopra indicato. Tutti gli obiettivi in commercio riportano sugli anelli esterni incisa la grandezza focale (esempio f=50mm) espressa in millimetri ed il valore della apertura massima dell’obiettivo stesso (per esempio a=2) che definisce la sua luminosità. Gli obiettivi più costosi a parità di focale hanno una maggiore luminosità ossia l’apertura massima con valore di a molto piccolo. La scala è motivata dal fatto che tra un valore dell’apertura e quello successivo si dovrebbe poter diaframmare per far passare una quantità di luce dimezzata rispetto al valore corrente (esempio a=2√ ). Questo si ottiene riducendo il diametro del foro, attraverso cui passa la luce, di un fattore 2 = 1.4 che come è noto la sezione circolare è proporzionale al quadrato del foro stesso. Normalmente il sistema ottico è configurato dinamicamente per proiettare una determinata quantità di luce sulla superficie sensibile di un sistema di acquisizione immagini, indipendentemente dalla tipologia di dispositivo sensibile utilizzato, film oppure fotorecettori di una telecamera. Questo è realizzato variando il diaframma f/# e compensando con il tempo di esposizione impostato adeguatamente dall’otturatore. Per esempio, la stessa quantità di luce è ottenuta impostando il sistema di acquisizione con f/2 e 1/1000 sec., f/2.8 100 CAPITOLO 4. SISTEMA OTTICO Figura 4.16: Macchina fotografica con modello pinhole: Immagine acquisita con valori diversi del diametro del foro ottenendo diversi gradi di sfocamento. e 1/500 sec., f/4 e 1/250 sec., ecc. Si osserva come passando da un valore di diaframma al successivo si dimezza la luce che passa ma si raddoppia il tempo di esposizione dell’area sensibile del sistema per proiettare sempre la stessa quantità di luce. In relazione alla tipologia e dinamica della scena viene selezionata adeguatamente la coppia diaframma e tempo di esposizione. Una scena con oggetti in movimento è acquisita selezionando la coppia di parametri con tempo di esposizione molto piccolo se si vuole evitare l’effetto sfocamento nell’immagine. Al contrario è selezionato un diaframma molto grande se si vuole aumentare la profondità di campo ossia aumentare l’intervallo fra distanza minima e massima di oggetti che risultano ancora a fuoco nel piano immagine del sistema di acquisizione. 4.4 Acquisizione dell’immagine Fin qui abbiamo analizzato le teorie fondamentali alla base dei meccanismi di formazione dell’immagine: la teoria parassiale dei sistemi ottici e l’interazione luce-materia. La natura attraverso i sistemi visivi degli esseri viventi offre uno spettro ampio di sistemi di acquisizione delle immagini con diversi livelli di complessità. Quasi tutti gli animali mostrano una particolare sensibilità alla radiazione luminosa, persino quelli non dotati di organi fotorecettori (Protozoi). Esistono organi visivi dalle forme più semplici che si limitano a distinguere il buio dalla presenza di luce, fino ad arrivare a quelli più evoluti capaci di percepire la forma ed il movimento degli oggetti. Per esempio gli organi visivi di alcuni animali determinano solo l’intensità di luce. In altri, gli organi visivi sono costituiti (Meduse) da più cellule localizzate in una cavità che vengono stimolate in tempi diversi dalla luce esterna a causa del movimento di un oggetto. Quando si ha una cavità più profonda con una fessura molto stretta senza lente (modello pinhole) si può avere la formazione di una immagine sulla parete opposta come avviene nella cosiddetta camera oscura (prototipo di una macchina fotografica). Si osserva (vedi figura 4.16) lo sfocamento dell’immagine in corrispondenza del foro grande per effetto della non convergenza dei raggi luminosi. Analogo sfocamento si verifica nel foro molto piccolo a causa del fenomeno della diffrazione. Questo principio di formazione dell’immagine era noto sin dai tempi di Aristotele. Leonardo Da Vinci lo descrive nei suoi appunti e Giovanni della Porta lo descrive dettagliatamente in Magic Naturalis. Una evoluzione degli organi visivi si ha quando in corrispondenza della fessura si formano mezzi diottrici, ossia una lente, come si riscontra nei vertebrati ottenendo in tal modo una immagine più luminosa e di qualità. Una ulteriore evoluzione si riscontra negli organi visivi composti degli Artropodi costituiti da una molteplicità di piccoli occhi ciascuno composto di propri mezzi diottrici (cornea, cono cristallino) e da elementi fotorecettori (retina). Nei 4.5. IL SISTEMA OTTICO UMANO 101 Figura 4.17: Sistema visivo di un vertebrato. vertebrati il sistema visivo diventa ancora più evoluto. La figura 4.17b mostra uno schema dell’occhio elementare chiamato ommatidio che assemblati come evidenziato in 4.17a formano l’occhio composto di molti Artropodi. L’occhio è costituito da una lente corneale bi-convessa di chitina trasparente, sotto la quale quattro cellule formano una seconda lente, il cono cristallino, omogeneo e trasparente. Segue la retinula costituita da 7-8 celle fotorecettori a forme allungate e sottili. Ciascuna di queste ultime celle trasmettono gli stimoli al dendrite della cellula conducente tramite il nervo ottico al cervello. Si riscontra un globo oculare, con retina, una sclerotica robusta, una cornea trasparente, una coroide pigmentata ed un cristallino (lente convergente). Sono inoltre sviluppate le strutture muscolari portanti per garantire le funzionalità di adattamento degli elementi ottici per ciascuna tipologia di animale (pesci, rettili, uccelli, cetacei, ecc.). I sistemi visivi biologici esistenti sulla terra anche se presentano differenti soluzioni nel sistema ottico, presentano processi elettro-chimici dei meccanismi di trasduzione dell’immagine molto simili. 4.5 Il sistema ottico umano Il sistema visivo umano può essere pensato come costituito da una lente doppia convergente che forma una immagine reale nella zona sensibile alla luce (retina). Il sistema visivo umano (vedi figura 4.18) si integra con le seguenti componenti: sistema ottico, nervo ottico e corteccia cerebrale. Nell’uomo il sistema ottico (l’occhio) ha una struttura consistente ed elastica, ed è tenuto in posizione oltre che dai muscoli, da fasce, nervi e vasi che in esso penetrano. Nella parte anteriore presenta all’esterno la cornea che è trasparente, nel cui centro sono visibili l’iride, variamente colorata, e la pupilla, il foro attraverso cui passa la luce, e vengono recepite le immagini. La pupilla si dilata o si restringe (2÷8mm) a seconda della minore o maggiore intensità degli stimoli luminosi. La parte posteriore della struttura sferica è formata dalla sclera, ed è sede della componente convessa del sistema ottico. Da questa sede della sclera emerge il nervo ottico avvolto da materiale fibroso che impedisce la riflessione e rifrazione dei raggi luminosi. I raggi di luce incidente penetrano nell’occhio dall’interfaccia aria-cornea subendo la massima deviazione (l’indice di rifrazione della cornea è n c ∼ =1.376 ). Nelle immersioni subacquee la vista diminuisce proprio perché i raggi di luce non vengono adeguatamente rifratti a causa dell’indice di rifrazione dell’acqua (n a ∼ =1.33 ) molto vicino a quello della cornea. La luce, superando la cornea, entra in uno spazio cavo contenente l’umor acqueo (n ua ∼ =1.336 ), un liquido incolore e trasparente, viene solo leggermente deviata nell’interfaccia cornea–umor acqueo poiché quest’ultimo ha un indice di rifrazione quasi identico a quello della cornea. L’iride si trova anche immersa nel liquido acquoso ed espleta le funzioni di diaframma che 102 CAPITOLO 4. SISTEMA OTTICO Figura 4.18: Il sistema ottico umano controlla la quantità di luce che entra nell’occhio attraverso la pupilla. I muscoli radiali e circolare dell’occhio consentono all’iride di aprirsi in pessime condizioni di luce e di chiudersi in buone condizioni di luce. Adiacenti all’iride verso l’interno del bulbo è localizzata la lente cristallina di 9 mm di diametro e 4 mm di spessore, costituita da una massa fibrosa multistrato (22000 strati) e trasparente, ed avvolta da una membrana sottile ed elastica. Abbiamo già analizzato l’architettura biologica del sistema visivo umano. Analizziamo ora alcune sue caratteristiche più dal punto di vista di sistema ottico di acquisizione delle immagini. A differenza delle lenti artificiali realizzate in vetro, il cristallino per la caratteristica della sua struttura lamellare può aumentare di dimensioni e presenta un indice di rifrazione che varia da 1.406, nel nucleo centrale, a circa 1.386 nelle parti meno dense. La lente cristallina, variando in forme e dimensioni, permette un’eccellente meccanismo di messa a fuoco fine variando la sua lunghezza focale. Dal punto di vista ottico, il sistema cornea-cristallino può essere pensato come un sistema ottico a due lenti con il fuoco dell’oggetto di circa 15.6mm (dal lato della cornea) ed il fuoco immagine di circa 24.3mm dietro la retina. Per semplificare si può considerare il sistema ottico come un’unica lente avente il centro ottico a 17.1mm davanti la retina e posizionato subito dopo la lente cristallina. Dopo il cristallino si trova il corpo vitreo e il corpo ciliare. Il corpo vitreo consiste in una massa trasparente e gelatinosa che riempie lo spazio esistente tra l’interfaccia posteriore della lente cristallina e la membrana interna del globo oculare. Questa massa è denominata umor vitreo: liquido gelatinoso trasparente (indice di rifrazione n uv =1.337 ) formato da sostanza amorfa, fibre e cellule, tenute assieme dalla membrana ialoidea. Nella zona più interna aderente alla sclera si trova una membrana fibrosa sottile chiamata coroide o corioride di natura vascolare e pigmentata con melanina. Uno strato sottile (0.1÷0.5mm) di celle fotorecettori coprono una zona estesa della superficie interna della coroide che è denominata retina dal latino rete. La luce focalizzata è assorbita attraverso un processo elettrochimico in questa struttura multistrato. Nei paragrafi precedenti abbiamo evidenziato che il sistema visivo umano presenta due tipologie di fotorecettori: coni e bastoncelli. La retina è considerata come una espansione del nervo ottico, che come una membrana, si applica sulla coroide fino all’ora serrata. L’area dove esce il nervo ottico dall’occhio non contiene fotorecettori ed è insensibile alla luce. La piccola zona di contatto tra nervo e retina è chiamata pupilla ottica. Il meccanismo di messa a fuoco (potere di accomodazione) delle immagini sulla retina per il sistema visivo umano, è realizzato dalla lente cristallina che, grazie alla sua natura elastica, può essere più o meno stirata dai muscoli ciliari. Più grande è la stiratura tanto maggiore diventa la curvatura delle sue facce (diminuisce il raggio R della lente) e conseguentemente diminuisce la sua lunghezza focale (come previsto dall’equazione (4.10)) con la diminuzione del suo potere diottrico (unità di misura della convergenza di un sistema ottico centrato). Il potere diottrico di una lente è una misura della capacità di una lente a convergere i raggi luminosi incidenti. E’ noto che una lente grandangolare (con lunghezza focale corta) 4.5. IL SISTEMA OTTICO UMANO Figura 4.19: Accomodamento dell’occhio. contratti. 103 a)Muscoli ciliari rilassati; b)Muscoli ciliari ha la capacità di convergere i raggi incidenti meglio di una lente con grande lunghezza focale. Consegue che il potere diottrico è inversamente proporzionale alla lunghezza focale. La grandezza fisica associata alla misura della convergenza è chiamato potere diottrico ed è definito come l’inverso della distanza focale di un sistema ottico centrato. La distanza focale è misurata in metri e la convergenza in diottria. Se vi sono più lenti la convergenza è data dalla somma algebrica delle singole convergenze di ciascuna lente. Per una lente con focale f di 1 metro la diottria è definita con l’inverso della focale di un metro o diottria indicata con 1D=1m−1 . Se una lente divergente ha focale di -2m, le diottrie sono -1/2D. Per una lente convergente con f=100mm il valore di diottria è 1/0.1D ossia 10D. L’equazione (4.10) è utilizzata per il calcolo delle diottrie di una lente, noti i raggi di curvatura e gli indici di rifrazione. Il grado di miopia, presbiopia si misura in diottria, riferendosi alla convergenza delle lenti correttrici. Il potere diottrico del cristallino del sistema visivo umano considerato immerso nell’aria è di +19D mentre per la cornea fornisce circa +43D per un totale di 59.6D considerato l’occhio con i muscoli rilassati. Tale valore è stimato considerando il sistema ottico come una lente composta (cristallino + cornea) il centro della quale dista 17.1 mm dalla retina (1/f=1/0.0171∼ =59D). Normalmente quando i muscoli dell’occhio sono rilassati, il cristallino non subisce nessun stiramento ed opera con la massima lunghezza focale e la luce di oggetti che si trovano all’infinito sono ben focalizzati sulla retina. Man mano che l’oggetto si avvicina all’occhio i muscoli ciliari si contraggono, generano un forte stiramento sulla lente cristallina (processo di accomodamento) per la messa a fuoco sulla retina dell’oggetto vicino. La minima distanza di un oggetto per essere visto correttamente varia con l’età. Per i giovani adolescenti, per un occhio normale, la distanza minima è di 70mm, per i giovani adulti è di 120mm e per età sempre maggiore la distanza varia da 250mm a 1000mm. La perdita progressiva del potere di accomodamento è detta presbiopia. Molti animali hanno la stessa capacità di accomodamento dell’uomo. Altri muovono solo la lente avanti ed indietro rispetto alla retina giusto per mettere a fuoco l’immagine come viene fatto nelle comuni macchine fotografiche. I molluschi invece effettuano l’adattamento contraendo o espandendo completamente il corpo dell’occhio per allontanare o avvicinare la lente dalla retina. Alcuni uccelli rapaci invece che focalizzare costantemente la preda, mentre si muovono velocemente anche per una considerevole distanza, per la loro sopravvivenza, hanno sviluppato un meccanismo di accomodamento in un modo molto diverso cambiando la curvatura della cornea. Il sistema ottico garantisce il processo di formazione dell’immagine sulla retina. Il processo di percezione dell’immagine (visione) è il risultato dell’attività sinergica e congiunta dell’occhio e del cervello. Tale attività si sviluppa in frazioni di secondi e comprende le seguenti fasi: 1. la formazione dell’immagine reale rimpicciolita e capovolta sulla retina in analogia a quanto avviene in uno strumento di acquisizione immagini (telecamera, macchina fotografica, ecc.); 104 CAPITOLO 4. SISTEMA OTTICO 2. stimolazione dei fotorecettori localizzati sulla retina in relazione all’energia luminosa della scena osservata; 3. trasmissione attraverso il nervo ottico degli impulsi prodotti dai fotorecettori al cervello; 4. la ricostruzione della scena 3D partendo dalle immagini 2D prodotte capovolte sulla retina; 5. la interpretazione degli oggetti della scena. Nel paragrafo Sistema visivo umano sono stati descritti le capacità sensoriali di esso compreso gli aspetti di percezione del colore. 4.6 Sistemi di acquisizione immagini Diversi sono i dispositivi disponibili per acquisire le immagini digitali. Le caratteristiche di tali dispositivi variano in relazione alle modalità di formazione delle immagini. Il primo dispositivo di acquisizione delle immagini, noto già ad Aristotele, è la camera oscura. Consiste in un ambiente impermeabile alla luce, di dimensioni variabile tra quelle di una piccola scatola a quelle di una stanza, su una parete delle quali è praticato un piccolo foro (foro stenopeico) attraverso cui una immagine capovolta, degli oggetti che si trovano all’esterno, è generata e proiettata sulla parete opposta (vedi figura 4.16). Leonardo da Vinci suggerı̀ di sostituire il foro stenopeico con una lente per migliorare la qualità dell’immagine in termini di nitidezza e luminosità. Per diversi secoli, rimase l’unico dispositivo per l’acquisizione delle immagini e successivamente, inserendo alla parete di proiezione una superficie fotosensibile ed introducendo obiettivi di buona qualità, la camera oscura diventa il prototipo delle moderne macchine fotografiche e delle telecamere con lo sviluppo della microelettronica. Tali dispositivi hanno entrambi le ottiche con lunghezza focale fissa e per mettere a fuoco l’immagine dell’oggetto l’ottica deve essere avvicinata o allontanata dal piano immagine (area sensibile del film o dei fotorecettori). Ricordiamo che ciò è controllato dai parametri del sistema di acquisizione delle immagini relazionati tra loro dalle equazioni (4.14), (4.15) e (4.18) già discusse nel paragrafo Sistema ottico. Riscriviamo la relazione dei punti coniugati 1 1 1 = + f p q (4.25) e la relazione di ingrandimento M= q Dim vert i =− Dim vert o p (4.26) dove f è la lunghezza focale dell’ottica, p è la distanza dell’oggetto dal centro lente, q è la distanza del piano immagine dal centro della lente, M è il fattore di ingrandimento o di rimpicciolimento dell’immagine rispetto all’oggetto, Dim vert i e Dim vert o sono le altezze misurate rispetto all’asse ottico rispettivamente dell’immagine e dell’oggetto. Il segno negativo indica che l’immagine è capovolta. Della scena osservata, il sistema ottico ne acquisisce solo una sua porzione circolare, nota come campo angolare di vista α. La scena osservata, compresa in corrispondenza del campo angolare di vista, è proiettata attraverso la lente nel piano immagine 2D rappresentato in figura 4.20 con l’area circolare. Considerando l’oggetto all’infinito per la (7.26) l’immagine si forma alla distanza q che coincide con la distanza focale. Man mano che l’oggetto si avvicina 4.6. SISTEMI DI ACQUISIZIONE IMMAGINI 105 Figura 4.20: Angolo di campo del sistema ottico e piano immagine. alla lente l’immagine si allontana dalla lente formandosi a distanze q maggiori di f per essere a fuoco, come spiegato in dettaglio nel paragrafo Sistema ottico. Normalmente tutti i dispositivi di acquisizione delle immagini hanno l’area sensibile rettangolare e soltanto una porzione di tale area circolare è acquisita. Le dimensioni dell’area sensibile, dove è focalizzata in modo uniforme l’immagine, è caratterizzata geometricamente dalla diagonale maggiore dell’area sensibile rettangolare. In genere, la diagonale maggiore dell’area sensibile è scelta approssimativamente uguale alla focale dell’obiettivo. Consegue che α2 ∼ = 1/tg 21 ed α corrisponde a circa 53◦ . Un obiettivo cosiddetto normale per una macchina fotografica con area sensibile di 24×36mm ha una lunghezza focale intorno a 50mm ed un angolo di campo di circa 50◦ . E’ chiamato normale in quanto le caratteristiche dell’immagine create con queste ottiche sono molto simili in senso di resa prospettica a quelle generate dal sistema ottico umano. Con focale più corte si ha un angolo di campo più ampio che da 50◦ può raggiungere valori superiori a 180◦ (fish-eye con f < 6 mm). Tali obiettivi si chiamano grandangolari che quando molto spinti possono produrre immagini molto distorte. Obiettivi con lunghezza focale maggiore di 50mm riducono l’angolo di campo fino a qualche grado in corrispondenza di focali di ≈1000mm (teleobiettivi). La qualità dei moderni obiettivi è tale da produrre immagini qualitativamente eccellenti per tutte le lunghezze focali e luminosità espressa con il simbolo f/# introdotto nel paragrafo Sistema ottico. L’area sensibile delle moderne telecamere è normalmente di 10×10mm2 e conseguentemente gli obiettivi standard hanno una lunghezza focale intorno a 15mm. I sistemi ottici dei dispositivi considerati, macchina fotografica e telecamera, producono una immagine ottica degli oggetti della scena osservata. In altre parole il sistema ottico produce una immagine fisica che è la distribuzione spaziale dell’intensità di energia luminosa. Quando l’immagine fisica è osservabile dagli umani si dice che è una immagine nel visibile. Immagini fisiche che non sono nel visibile potrebbero essere per esempio le immagini per rappresentare grandezze come l’altezza del terreno, la temperatura, l’umidità, ecc. generate normalmente da sistemi di acquisizione non ottici. Senza perdere in generalità, consideriamo tra le immagini fisiche quelle generate da una macchina fotografica e da una telecamera Vidicon (dispositivo basato su tubo elettronico). I dispositivi di acquisizione delle immagini (telecamera e macchina fotografica) realizzano una corrispondenza tra gli oggetti della scena e le immagini fisiche generate (figura 4.21). Il film di una macchina fotografica è il supporto fisico che cattura il negativo dell’immagine corrispondente all’immagine ottica. Il tubo elettronico Vidicon è il supporto fisico che 106 CAPITOLO 4. SISTEMA OTTICO Figura 4.21: Componenti di un sistema di acquisizione immagini. Figura 4.22: Sistema di digitalizzazione a scansione elettronica. cattura elettronicamente l’immagine corrispondente all’immagine ottica della telecamera. A differenza del film della macchina fotografica (sul quale si produce una immagine negativa dopo il suo sviluppo attraverso un processo fisico-chimico), una telecamera Vidicon produce una immagine elettronica dell’immagine ottica formatasi. Attraverso il processo di scansione elettronica, l’immagine ottica (disponibile sotto forma di energia luminosa), formata sulla zona detta target del tubo Vidicon, è trasdotta sotto forma di variazione di corrente, dai dispositivi elettronici che producono un segnale video standard (per esempio, RS170) per riprodurre simultaneamente su monitor monocromatici televisivi l’immagine acquisita. Ricordiamo che il nostro obbiettivo primario, una volta acquisita l’immagine, è quello di analizzare gli oggetti della scena. Abbiamo visto come il sistema visivo umano elabora l’immagine acquisita sulla retina propagando, attraverso il nervo ottico, le informazioni di intensità luminosa ed elaborandole con un modello neurale per la percezione completa (riconoscimento, localizzazione e dinamica) degli oggetti osservati. In analogia al sistema umano, abbiamo la necessità di elaborare il contenuto informativo delle immagini ottiche acquisite per esempio dalla telecamera Vidicon e quelle registrate sul film. I sistemi di elaborazione possibili sono i calcolatori elettronici digitali che sono capaci di elaborare informazioni solo di tipo numerico. Risulta necessario perciò tradurre in formato numerico, ossia in formato digitale, il contenuto informativo della scena acquisita attraverso il processo di formazione dell’immagine con i vari dispositivi disponibili. Se si considera l’immagine registrata su film fotografico, è necessario un processo di scansione meccanico oppure elettronico che, muova un pennello di luce punto per punto sul film trasparente e misurare la luce trasmessa o riflessa come stima dell’intensità di luce corrispondente al punto della scena osservato durante il processo di acquisizione dell’immagine. Un fotosensore misura la luce trasmessa o riflessa punto per punto ed il segnale elettrico prodotto è adeguatamente trasdotto dal dispositivo di digitalizzazione che converte il segnale analogico sotto forma numerica (figura 4.22). Se si considera l’immagine acquisita dalla telecamera Vidicon, è necessaria una conversione in forma numerica del segnale video generato con la completa scansione elettronica della superficie sensibile del vidicon. In particolare, lo standard europeo RS-170 prevede la scansione dell’intera immagine (frame) in 625 linee orizzontali con una frequenza di 25 frame al secondo (figura 4.23). In figura 4.24 è rappresentata l’immagine analogica (continua) acquisita come video frame ed il segnale analogico video corrispondente ad una linea orizzontale (figura 4.24b). Per la conversione del segnale video analogico in formato digitale, gestibile dal computer, è 4.6. SISTEMI DI ACQUISIZIONE IMMAGINI 107 Figura 4.23: Telecamera con tubo Vidicon. Figura 4.24: Segnale video standard RS170. necessario un dispositivo hardware chiamato frame-grabber. Quest’ultimo converte il segnale video analogico in immagine digitale campionando il segnale continuo con un intervallo temporale costante. In figura 4.25 è schematizzato il processo di campionamento di una linea del segnale video campionato attraverso la misura istantanea del valore del segnale elettrico ad intervalli di tempo costanti. Il valore del segnale elettrico, per ciascun intervallo di tempo, è convertito in un valore numerico e memorizzato. Tale valore è correlato al valore di intensità luminosa dell’immagine in quel punto. Questo processo è ripetuto per ciascuna linea del segnale video dell’intero frame ed al termine si ottiene l’immagine digitale che può essere elaborata direttamente dal computer. I valori di intensità luminosa campionati sono inoltre quantizzati in valori digitali per soddisfare le esigenze di accuratezza numerica. Tale accuratezza dipende dal numero di bit assegnati per rappresentare l’informazione di intensità luminosa per ciascun punto campionato. Normalmente sono assegnati 8 bit generando cosı̀ 256 livelli di intensità luminosa. L’intervallo dei livelli di intensità è chiamato anche intervallo dinamico e nel caso di immagini digitali quantizzate a 8 bit si ha un range dinamico da 0 a 255. Una immagine digitale dopo l’elaborazione può essere ulteriormente visualizzata. Si rende necessario un processo inverso a quello di digitalizzazione che si propone di ricostruire l’immagine continua partendo dall’immagine numerica precedentemente digitalizzata ed elaborata. A tal scopo è necessario un dispositivo hardware di conversione da digitale ad analogico. La figura 4.26 mostra lo schema completo di conversione dell’immagine da digitale 108 CAPITOLO 4. SISTEMA OTTICO Figura 4.25: Conversione in digitale del segnale video. Figura 4.26: Sistema di visualizzazione immagini. ad analogico. Nei paragrafi seguenti verranno analizzati gli effetti introdotti dal processo di digitalizzazione per valutare qualitativamente e quantitativamente eventuali perdite di informazioni rispetto all’immagine originale. Si può anticipare che tali effetti sono ormai minimi considerando la buona qualità dei dispositivi di digitalizzazione oggi disponibili. Le telecamere più recenti sono realizzate con sensori di acquisizione immagini di tipo a stato solido con l’elettronica di scansione contenuta in un vettore o matrice di sensori. Le più diffuse hanno una matrice di sensori del tipo charge-coupled device (CCD) ed a matrice di fotodiodi. I fotosensori sono integrati in un singolo chip che comprende l’elettronica necessaria per determinare la carica elettrica generata nel piano immagine incidente. Il processo di campionamento avviene direttamente nel punto ove è localizzato ciascun sensore nella matrice sensoriale mono o bidimensionale. Il processo di digitalizzazione è completato con la quantizzazione dei valori di intensità luminosa nel caso di telecamere digitali oppure è generato un segnale video standard (segnale analogico) ed in questo caso le informazioni spaziali di campionamento relativo a ciascun sensore sono perse. In appendice saranno approfonditi alcuni aspetti della tecnologia dei moderni sistemi di acquisizione delle immagini. 4.7 Rappresentazione dell’immagine digitale Nei paragrafi precedenti abbiamo descritto i fondamenti del processo di formazione dell’immagine analizzando come l’energia luminosa dell’ambiente interagisce con il sistema ottico che genera una immagine fisica 2D degli oggetti 3D della scena osservata. Si è descritto inoltre, come dall’immagine fisica continua, che contiene le varie tonalità di intensità luminosa dei punti corrispondenti della scena, attraverso il processo di digitalizzazione, si perviene ad una immagine discreta digitale (vedi figura 4.27). L’immagine fisica continua f(x,y) generata dal sistema ottico o in generale da qualunque altro sistema di acquisizione (radar, raggi x, infrarosso, sonar, chimico, ecc.) rappresenta l’informazione di intensità luminosa (o livelli di grigio) in ciascun punto (x,y) del piano bidi- 4.8. RISOLUZIONE E FREQUENZA SPAZIALE 109 Figura 4.27: Immagine digitale. mensionale g(i,,j), che rappresenta i valori dell’intensità luminosa derivata dall’immagine fisica continua f(x,y) in corrispondenza della griglia di campionamento definita da (i ∆x,j ∆y), dove ∆x e ∆y rappresentano gli intervalli di campionamento rispettivamente lungo l’asse delle x e l’asse delle y. Dal processo di quantizzazione è generata l’immagine digitale I(i,j) con i valori digitali dell’intensità luminosa g(i,j) riportati per ciascun elemento (i,j) dell’immagine, chiamato pixel (dall’inglese picture element). Il valore di ciascun pixel I(i,j) rappresenta l’elemento discreto digitale dell’immagine digitalizzata. Il valore del pixel I(i,j) rappresenta il valore medio dell’intensità luminosa corrispondente ad una cella della griglia con superficie rettangolare di dimensioni ∆x ×∆y. L’insieme dei pixel I(i,∗) rappresenta la colonna i-ma dell’immagine digitale, mentre la riga j-ma è rappresentata dai pixel I( ∗,j). L’immagine digitale I risulta una buona approssimazione dell’immagine continua originale f se sono scelti in modo adeguato i seguenti parametri: gli intervalli di campionamento ∆x e ∆y, e l’intervallo dei valori di intensità I assegnati a ciascun pixel nella fase di quantizzazione. Da questi parametri dipende quello che è definito come qualità dell’immagine ossia la risoluzione spaziale e la risoluzione radiometrica (o di intensità luminosa o di colore). Un altro parametro che definisce la qualità dell’immagine è rappresentato dalla risoluzione temporale come l’abilità di catturare la dinamica della scena nel caso di oggetti in movimento. In questo caso è considerato il parametro frame rate che definisce la velocità di acquisizione di una o più sequenze di immagini (numero di frame al secondo). 4.8 Risoluzione e frequenza spaziale L’immagine digitale acquisita è il risultato del processo di digitalizzazione realizzato partendo dall’immagine ottica generata dal sistema ottico. Possiamo allora affermare che la risoluzione dell’immagine digitale, che indica come l’intero sistema di acquisizione sia capace di risolvere i più piccoli dettagli degli oggetti della scena osservata, dipende dalle varie componenti del sistema di acquisizione complessivo: ambiente, sistema ottico, sistema di digitalizzazione. Per semplificare possiamo affermare che la risoluzione dell’immagine digitale dipenda dalla risoluzione dell’immagine ottica e dalla risoluzione del sistema di digitalizzazione. Ipotizziamo di avere una immagine ottica di buona qualità nel senso che risolve bene le strutture spaziali della scena originale e valutiamo gli effetti del processo di digitalizzazione sulla risoluzione spaziale. Quando osserviamo una foto di buona qualità abbiamo un esempio di immagine con livelli di colore continuo ed osservando col sistema visivo umano gli oggetti della scena appaiono con una buona risoluzione geometrica con tutti i dettagli geometrici e senza discontinuità. Questo avviene per due motivi. Il primo è che la macchina fotografica utilizzata ed il supporto cartaceo su cui è stata riprodotta l’immagine, hanno una buona risoluzione spaziale ed una buona riproduzione cromatica. Il secondo motivo riguarda l’alta risoluzione spaziale del 110 CAPITOLO 4. SISTEMA OTTICO Figura 4.28: Risoluzione spaziale del sistema visivo umano. sistema visivo umano legato all’elevato numero di fotorecettori (coni e bastoncelli) presenti, ed alle piccole dimensioni dei fotorecettori stessi. In altre parole l’immagine che si forma sulla retina presenta un elevato numero di pixel con dimensioni puntiformi producendo l’effetto di immagine continua. In figura 4.28 è rappresentata la risoluzione spaziale del sistema visivo umano a diverse condizioni di illuminazione. La scelta della risoluzione spaziale del pixel e quindi dell’intera immagine digitale è strettamente legato alle varie applicazioni. Esistono numerosi sistemi di acquisizione che possono digitalizzare immagini da 256×256 pixel fino a 8K×8K pixel per varie applicazioni. Formalizziamo ora il concetto di risoluzione nel contesto di immagine digitale che dovrà essere elaborata e successivamente visualizzata (ipotizziamo che il monitor sia ad altissima risoluzione). In una immagine digitale i dettagli geometrici della scena appaiono come variazione di intensità luminosa presente tra pixel adiacenti. Se tali pixel corrispondenti non registrano variazioni di livelli significativi, le strutture geometriche non sono risolte e possiamo affermare che la risoluzione spaziale è scarsa. Il concetto di risoluzione spaziale è correlato al concetto di frequenza spaziale che indica con quale rapidità variano i valori dei pixel spazialmente. Per semplicità consideriamo la figura 4.29 che mostra diverse immagini includendo solo barre nere verticali intervallate da strisce bianche e presenta i valori d’intensità dei pixel della riga i-ma di ciascuna immagine. Si osserva come i pixel sulla riga variano in modo ciclico dal bianco al nero ripetutamente. La frequenza ν indica la velocità di variazione dei valori dei pixel spazialmente. Nell’esempio si osserva che il valore di intensità varia da zero (barra nera) al valore massimo (barre bianche). Nella figura 4.29 sono indicate barre con frequenze spaziali man mano più alte corrispondenti a strutture geometriche sempre più fine. Nella figura 4.30 è rappresentata una immagine complessa ed il profilo dell’intensità luminosa di una riga evidenzia zone dello spazio geometrico con strutture uniformi, con piccole variazioni di intensità, ed altre zone che variano più rapidamente. In corrispondenza delle zone tra gli oggetti si hanno pochi dettagli pertanto poca variabilità dell’intensità e quindi basse frequenze spaziali. Si hanno alte frequenze spaziali e quindi alta variabilità d’intensità in corrispondenza di strutture geometriche con maggiori dettagli. Siamo ora interessati a definire adeguatamente i parametri del processo di digitalizzazione allo scopo di ottenere una immagine digitale che riproduca fedelmente tutte le strutture spaziali presenti nell’immagine ottica originale. Questo è realizzato modellando il processo di formazione dell’immagine applicando la teoria dei sistemi lineari e successivamente appli- 4.8. RISOLUZIONE E FREQUENZA SPAZIALE Figura 4.29: Frequenze nel dominio spaziale. Figura 4.30: Immagine con alte e basse frequenze spaziali. 111 112 CAPITOLO 4. SISTEMA OTTICO y y P(x,y) x x P( x, y, z) z P’ do di Figura 4.31: Geometria dell’oggetto e dell’immagine nel modello pinhole. cando il teorema del campionamento per determinare in modo appropriato i parametri della conversione analogica-digitale (numero di pixel richiesti e spazio di campionamento). 4.9 Modello geometrico della formazione dell’immagine Nei paragrafi precedenti abbiamo discusso l’importanza del sistema ottico per la formazione dell’immagine ottica. Gli oggetti 3D della scena sono proiettati dal sistema ottico nel piano immagine 2D. Abbiamo già evidenziato come l’immagine ottica prodotta è influenzata dagli effetti della diffrazione e dalle aberrazioni dell’ottica. Possiamo già affermare che la proiezione da 3D a 2D comporta una perdita di informazione sulla scena osservata. Il modello geometrico più semplice che proietta un punto luminoso dell’oggetto nel piano immagine è il modello pinhole o prospettico. Come evidenziato in figura 4.31 il punto luminoso P(X,Y,Z) dell’oggetto genera un raggio luminoso rettilineo, passante per il centro O del sistema ottico, ipotizzato come un foro infinitesimale, che produce un punto luminoso p localizzato in (x,y,d i ) sul piano immagine. Se consideriamo gli oggetti referenziati rispetto al sistema di riferimento (X,Y,Z) con origine nel centro del sistema ottico ed il piano immagine (con assi x,y), perpendicolare all’asse Z localizzato alla distanza d i , le relazioni tra le coordinate spaziali (X,Y,Z ) degli oggetti e le coordinate 2D nel piano immagine (x,y) sono date da: x y = = − diZX = −sX iY − dZ = −sY (4.27) dove il rapporto s=d i /Z è il fattore di scala del sistema prospettico. Si può osservare che le equazioni (7.28) non sono lineari (per la presenza di Z al denominatore) e non è possibile calcolare la distanza e le dimensioni degli oggetti, rispetto all’origine del sistema ottico. Tutti i punti dell’oggetto che giacciono sulla linea di proiezione risultano proiettati nella stessa locazione (x,y) nell’immagine. Per esempio i punti P e P’ (figura 4.31) che si trovano a distanze diverse giacciono sullo stesso raggio di proiezione e sono proiettati entrambi in p nel piano immagine nella stessa locazione (x,y). Un segmento rettilineo 3D è comunque proiettato nel piano immagine generando un segmento 2D. Tutti i raggi emessi dai punti del segmento rettilineo 3D giacciono nello stesso piano (figura 4.32). Da queste considerazioni, consegue che la proiezione di un oggetto 3D opaco e geometricamente complesso, genera nel piano immagine 2D una perdita di informazione riducendo lo spazio di origine di una dimensione. Per la proiezione inversa ossia per la ricostruzione 4.10. FORMAZIONE DELL’IMMAGINE CON UN SISTEMA OTTICO REALE 113 1111 0000 0000 1111 0000 Ombra 1111 0000 1111 Oggetto 000 111 111 000 000 111 000 111 Superfice O 00Ombra 11 11 00 00 11 Figura 4.32: 3D della scena, descritta dalla funzione di livello di grigio f(x,y,z) che rappresenta l’immagine della scena, dovrebbero essere note due funzioni bidimensionali: la funzione inversa dell’immagine I(x,y) che rappresenta i livelli di grigio nel piano immagine e la funzione mappa di profondità Z(x,y) che rappresenta la distanza di ciascun punto visibile nella scena (proiettato nel punto (x,y) del piano immagine) dal sistema ottico. La corrispondenza uno a uno tra un punto (X,Y,Z) della scena e la sua proiezione nel piano immagine (x,y) è garantita, dal modello di proiezione prospettica, solo se ciascun raggio proietta un solo punto della scena. Nel caso di oggetti trasparenti e di oggetti opachi con superfici concave (in presenza di superfici occluse) tale condizione non è più valida poiché più punti sono allineati sullo stesso raggio di proiezione. Il sistema umano di percezione visiva ricostruisce la scena 3D (modellata da una funzione di luminosità g(X,Y,Z) ) attraverso il proprio sistema visivo binoculare acquisendo due immagini 2D della scena (visione stereo) e valutando la mappa di profondità Z(x,y) attraverso un processo neurale che fonde le due immagini. 4.10 Formazione dell’immagine con un sistema ottico reale L’immagine prodotta con il modello geometrico di proiezione pin-hole è indipendente dalla distanza degli oggetti dal sistema ottico ideale ed assume che il processo di formazione dell’immagine sia priva di qualunque disuniformità. Un sistema ottico reale, per esempio costituito da una semplice lente convessa sottile, proietta un punto luminoso di un oggetto nel piano immagine producendo una immagine bidimensionale (spot luminoso con intensità variabile) normalmente chiamata: Point Spread Function (PSF). Se l’oggetto si trova all’infinito lo spot luminoso è completamente a fuoco nel piano immagine che si forma alla distanza focale f ed il sistema ottico si comporta come il sistema ideale pin-hole. Nella realtà, gli oggetti sono a distanza finita dal sistema ottico, e, nell’immagine generata dalla proiezione di un punto luminoso, anche se apprezzabilmente ancora a fuoco, si osserva quanto segue: 1. L’immagine del punto luminoso diventa un’area circolare meno luminosa e leggermente sfocata ma ancora accettabile come nitidezza; 2. Il piano focale dove si forma l’immagine non è più alla distanza f dalla lente ma diventa q spostandosi verso il sistema ottico (ossia, q < f ), e con l’aumentare della distanza p dell’oggetto dal sistema ottico l’immagine si allontana (q > f ). Ricordiamo l’equazione () del paragrafo Sistema ottico, ossia la relazione che lega i parametri ottici dei punti coniugati: 1 1 1 = + f p q dove f è la lunghezza focale della lente; 114 CAPITOLO 4. SISTEMA OTTICO Figura 4.33: Processo di formazione dell’immagine. a) Sistema ottico che proietta l’immagine di un punto dell’oggetto; b) PSF: l’immagine irradiata generata sul piano immagine del sistema ottico. 3. Il modello geometrico di proiezione prospettico (pin-hole) si può considerare ancora valido se le dimensioni del disco generato come proiezione del punto luminoso si mantengono le più piccole possibili e le equazioni (7.28) sono ancora valide considerando le coordinate del centro del disco in luogo del punto immagine del modello pin-hole; 4. La luminosità del disco nel piano immagine aumenta in proporzione all’aumentare della luminosità del punto-oggetto. Questa condizione ci suggerisce che il processo di formazione dell’immagine soddisfa la condizione di omogeneità di un sistema lineare. Questi aspetti della formazione dell’immagine, l’immagine PSF ed il diametro dello spot, incominciano a definire in modo quantitativo la risoluzione spaziale dell’immagine ottica generata che è strettamente dipendente dalle caratteristiche del sistema ottico considerato. Con l’osservazione 4. si deduce che il sistema ottico è un sistema lineare bidimensionale ed è plausibile modellare il processo di formazione dell’immagine con la teoria dei sistemi lineari. Siamo allora motivati ad affermare quanto segue: a) due punti luminosi dell’oggetto producono una immagine (nel piano immagine) in cui si sovrappongono (si sommano) gli effetti delle aree circolari luminose; b) considerando punti luminosi in posizioni diverse nel piano dell’oggetto (X,Y) l’immagine dello spot luminoso si sposta in una nuova posizione in relazione alle equazioni (7.28); c) un sistema ottico ottimale genera immagini di spot luminosi di forma simile se la distanza dall’asse ottico è limitata ragionevolmente. Questo significa che la PSF è spazialmente invariante. In altre parole l’affermazione c) ci dice che il sistema ottico risulta stazionario, ossia che cambiando la posizione del punto luminoso (sorgente) di input nel piano oggetto, si ha in corrispondenza il cambiamento della posizione nel piano immagine (affermazione b), senza che vi sia una variazione della forma della PSF che descrive il punto luminoso sorgente. Se le condizioni precedenti sono mantenute, si può assumere che il sistema ottico di formazione dell’immagine è un sistema lineare: invariante spazialmente, lineare e la PSF rappresenta la risposta impulsiva dello stesso. Il processo di formazione dell’immagine per un oggetto 3D luminoso può essere pensato come la sovrapposizione delle singole immagini spot, descritte dalla PSF del sistema ottico, generata in corrispondenza di tutti i punti luminosi che costituiscono l’oggetto 3D. In sostanza l’immagine complessiva dell’oggetto è la sovrapposizione spaziale di tutti gli spot luminosi descritti dalle PSF corrispondenti a tutti i punti luminosi costituenti l’oggetto 3D. 4.10. FORMAZIONE DELL’IMMAGINE CON UN SISTEMA OTTICO REALE 115 Figura 4.34: Applicazione per due punti luminosi dell’oggetto del principio di omogeneità e sovrapposizione. In figura 4.33 è rappresentato il sistema ottico con uno spot luminoso nel piano oggetto (X,Y) che emette una intensità luminosa di ∆X ∆Yf(X,Y). Il sistema ottico proietta questa intensità luminosa nel piano immagine (x,y) che per effetto della diffrazione (o per la presenza di aberrazioni ottiche) produce uno spot luminoso leggermente sfocato. Questo effetto di sfocamento introdotto dal sistema ottico è descritto dalla PSF ed in termini quantitativi l’intensità luminosa che arriva nel punto (x,y) del piano immagine è data dalla relazione: ∆I(x, y) = h(X, Y ; x, y)f (X, Y )∆X∆Y (4.28) dove con h(X, Y ; x, y) è indicata la PSF che descrive come uno spot luminoso sorgente in (X,Y) nel piano dell’oggetto viene modificato nel piano immagine centrato nella locazione (x,y). Per semplicità la proiezione della sorgente luminosa elementare è supposta uno a uno senza produrre un fattore di ingrandimento. L’intensità luminosa I(x,y) nel piano immagine, in ciascuna locazione (x,y), è data dal contributo di tutte le aree elementari dell’oggetto (pensate come sorgenti elementari luminose) attraverso un processo di sovrapposizione (seconda condizione dei sistemi lineari) come segue: +∞ Z +∞ Z I(x, y) = f (X, Y )h(X, Y ; x, y)dXdY (4.29) −∞ −∞ Abbiamo già osservato che nel contesto di sistema invariante spazialmente considerando altre aree luminose nello spazio dell’oggetto (X,Y) l’unico effetto che si riscontra è lo spostamento nel piano immagine dello spot luminoso, mentre rimane invariata la forma della PSF , ossia la modalità di proiezione in punti diversi nell’immagine dello spot luminoso sorgente. Nella realtà sappiamo che questo non è sempre possibile ma considerando il piano immagine partizionato in regioni limitate si può considerare invariante la forma della PSF. La figura 4.34 mostra nel monodimensionale il valore dell’intesità luminosa nel piano immagine in un punto x derivato dalla sovrapposizione di due punti luminosi X 0 e X 00 nel piano oggetto. La figura 4.35 mostra invece sempre nel monodimensionale una situazione più complessa ossia come l’intensità luminosa nel piano immagine in ciascun punto x è il risultato della sovrapposizione dell’intensità di ciascun punto dell’oggetto, quest’ultimo modellato da impulsi di Dirac scalati e da una funzione di luminosità continua, entrambi poi modificati dalla PSF con forma gaussiana. Nelle condizioni di sistema invariante spazialmente, i valori della PSF h(x0 , y 0 ; x, y) non dipendono dalle coordinate (x,y) nel piano immagine I , ma dipendono solo dagli spostamenti (x − x0 , y − y 0 ) rispetto a tali locazioni della forma gaussiana con h centrata in (x = x0 , y = y 0 ). Per esempio, considerando (x = x0 , y = y 0 ) l’immagine della PSF è 116 CAPITOLO 4. SISTEMA OTTICO Figura 4.35: Figura 4.36: 4.11. RISOLUZIONE DEL SISTEMA OTTICO 117 centrata nel piano immagine in (x0 , y 0 ) dove il valore di h è massimo come evidenziato in figura 4.36. Conseguentemente l’equazione (7.30) diventa: I(x, y) = +∞ Z +∞ Z 0 0 f (x, y)h(x − x , y − y )dxdy (4.30) −∞ −∞ che è nota come l’integrale di CONVOLUZIONE . Nella (7.31) f(x,y) è la funzione di intensità luminosa nel piano immagine identica a quella dell’oggetto con intensità luminosa f(X,Y) e senza degradazione in accordo alle equazioni (7.28) ed ipotizzando una proiezione con fattore di ingrandimento uguale a 1 f (x, y) = f (M X, M Y ) = f (X, Y ) . Più in generale se si trascurano gli effetti di degradazione ottica, la proiezione dell’oggetto nel piano immagine si può considerare come il processo combinato di proiezione geometrica e di convoluzione nel piano immagine attraverso la funzione PSF caratteristica del sistema ottico. L’immagine cosı̀ ottenuta dell’oggetto, attraverso la convoluzione è il risultato della distribuzione dell’energia luminosa proiettato nel piano immagine e modulata in ciascun punto P(x,y) dell’immagine pesando con la PSF i contributi dei punti immagine compresi in un intorno di P. Il processo che modifica una funzione f(x,y) in ciascun punto del suo dominio attraverso un’altra funzione h(x − x0 , y − y 0 ) producendo una nuova funzione I(x,y) è chiamato operatore di convoluzione e si dice che la funzione I deriva da f convoluta con h. La convoluzione, oltre a modellare il processo di formazione dell’immagine, vedremo che avrà un ruolo fondamentale nel campo della elaborazione dell’immagine. Nel processo di formazione dell’immagine, la convoluzione ha l’effetto di smussare i livelli di intensità dell’immagine e conseguentemente comporta una riduzione della risoluzione spaziale. In figura 4.37 si osserva come viene livellato il profilo dell’intensità corrispondente ad una linea dell’immagine f(x) quando è convoluta con la PSF gaussiana h(x-x ’), mentre quando è convoluta con una PSF ideale, la funzione Delta δ(x − x0 ), si ottiene solo una replica di f(x). In generale, in presenza di frequenza spaziale la cui lunghezza d’onda è superiore al dominio di azione della PSF, gli effetti di livellamento della convoluzione sono limitati. Al contrario, se i livelli di intensità si ripetono spazialmente con alta frequenza (lunghezza d’onda piccola) gli effetti del livellamento sull’immagine sono significativi, riducendo sensibilmente la sua risoluzione spaziale. Lo strumento matematico che può quantificare l’effetto della convoluzione è dato dalla trasformata di Fourier , che come è noto, decompone i valori di intensità dell’immagini in variazioni periodiche dell’intensità luminosa presenti nell’immagine stessa. 4.11 Risoluzione del sistema ottico La qualità di un sistema di acquisizione immagini dipende dalla sua capacità di riprodurre fedelmente le strutture spaziali degli oggetti conservando le variazioni di luminosità delle strutture stesse osservate. La risoluzione spaziale e radiometrica esprimono in termini quantitativi il concetto espresso di qualità del sistema. La risoluzione spaziale è strettamente connessa al concetto espresso in precedenza delle frequenze spaziali, espressa in cicli oppure in linee per unità di lunghezza. La risoluzione radiometrica è detta anche contrasto ed indica la differenza di luminosità tra aree diverse di un oggetto e tra oggetti diversi. 118 CAPITOLO 4. SISTEMA OTTICO Figura 4.37: Procedura di convoluzione. La risoluzione del sistema di formazione dell’immagine combina i due aspetti ossia il contrasto degli oggetti ed i dettagli geometrici a scale diverse. Nel processo di formazione dell’immagine si è visto che un elemento dell’oggetto assimilato ad una sorgente di luce puntiforme proiettato dal sistema ottico nel piano immagine diventa un disco luminoso descritto da h(x,y) la PSF . L’immagine complessiva dell’oggetto, attraverso il processo di convoluzione, è ottenuta in ciascun punto come sovrapposizione di dischi luminosi che si sommano linearmente. Anche con un sistema ottico di alta qualità, privo di aberrazioni, un punto luminoso dell’oggetto è proiettato nel piano immagine come un’area luminosa estesa, a causa dell’effetto della diffrazione che limita la risoluzione spaziale dell’immagine. Per quantificare il livello di risoluzione massima possibile, consideriamo due punti luminosi dell’oggetto di uguale intensità. Vogliamo valutare nel piano immagine quale può essere la distanza minima tra i centri delle rispettive aree luminose circolari descritti dalla PSF . Per un sistema ottico con focale f il primo zero della PSF si ha in corrispondenza del raggio λf (4.31) d dove d è il diametro della lente e λ è la lunghezza d’onda della luce. Nel visibile, il diametro del disco luminoso, detto anche disco di Airy , è uguale approssimativamente ad f/# delle lenti espresso in milionesimi di metro (vedi figura 4.38). In corrispondenza di δ si ha una misura angolare di δ = 1.22 ∆θ= 1.22 λ/d poiché δ/f=sin∆θ ∼ = ∆θ (vedi figura 4.39a). I dischi corrispondenti ai due punti luminosi dell’oggetto saranno visibili e separati nel piano immagine (vedi figura 4.39a) se la loro separazione angolare ∆ϕ sarà molto più grande 4.11. RISOLUZIONE DEL SISTEMA OTTICO 119 Figura 4.38: Profilo del disco di Airy di ∆θ. Considerando punti luminosi sull’oggetto sempre più vicini tra loro, nel piano immagine, i corrispondenti dischi di Airy si sovrappongono e tendono a diventare un unico oggetto ossia non sono più discriminabili. Il criterio di Rayleigh suggerisce che due punti luminosi sono ancora separati nel piano immagine se il centro di un disco si trova sul primo minimo del disco corrispondente all’altro punto luminoso (vedi figura 4.39b). La separazione angolare minima solvibile è data da: ∆ϕmin = ∆θ = 1.22λ/d (4.32) mentre la distanza minima δ descrivibile dai due dischi nel piano immagine è calcolata con la (7.32) che è chiamata la distanza di Rayleigh. Una misura quantitativa del potere risolutivo per un sistema di formazione dell’immagine è dato dall’inverso della distanza di separazione oppure dall’inverso della separazione angolare. La qualità di un sistema può essere valutata considerando un oggetto piano campione dove sono presenti strisce verticali e orizzontali, bianche e nere a diverso spessore e con frequenza spaziale variabile. Tali strutture geometriche note possono essere espresse in cicli per millimetro oppure numero di strisce (linee) per millimetro. Per separare strutture geometriche con alte frequenze spaziali il sistema deve avere un alto potere risolutivo. Una alternativa al criterio di Rayleigh, per valutare la risoluzione di un sistema ottico, è data considerando la distanza di Abbe r 0 che esprime in modo approssimato il diametro del disco di Airy considerato accettabilmente a fuoco nel piano immagine alla distanza q dal centro ottico: λq r0 ∼ (4.33) = d Si può osservare come r 0 varia inversamente al diametro del sistema ottico aumentando in questo modo la risoluzione. Analogamente, per avere una buona risoluzione, può essere utilizzata luce con lunghezza d’onda λ più corta, usando per esempio, luce ultravioletta piuttosto che luce visibile come avviene in microscopia per evidenziare strutture geometriche molto piccole. 120 CAPITOLO 4. SISTEMA OTTICO Figura 4.39: Vediamo ora l’altro aspetto che influenza la risoluzione dell’immagine, il contrasto o la modulazione dell’intensità luminosa definita come: M= Imax − Imin Imax + Imin (4.34) La modulazione esprime una misura quantitativa di come il sistema ottico proietta l’energia luminosa dell’oggetto nel piano immagine. Per semplicità consideriamo un oggetto target con luminosità I i che illuminato produce una immagine di output I 0 , ciascuna linea della quale rappresenta la modulazione dell’intensità luminosa in ciascun punto dell’immagine (vedi figura 4.40). Nell’esempio, l’intensità luminosa di ciascuna linea è descritta dalla funzione seno che ha una modulazione più alta rispetto alla stessa linea dell’immagine di output che è anche funzione seno ma con modulazione minore. Tale funzione rappresenta solo una frequenza spaziale (1 ciclo per 2 cm) con un periodo spaziale T (uguale a 2 cm per un ciclo). In generale, anche per alte frequenze spaziali la modulazione dell’oggetto è diversa dalla modulazione dell’immagine. Per quantificare complessivamente il concetto di risoluzione di un sistema acquisizione dell’immagine è definita la funzione MTF, la funzione di modulazione di trasferimento che indica il rapporto della modulazione dell’immagine alla modulazione dell’oggetto per tutte le frequenze spaziali. La figura 4.41 rappresenta la funzione MTF di un sistema ottico con due tipi di lenti. Se Tmin è il periodo spaziale minimo presente nell’oggetto target (distanza di separazione tra due linee), Fmax =1/Tmin rappresenta la frequenza spaziale più alta presente. La curva interseca l’asse orizzontale individuando una frequenza Fc detta Frequenza di soglia al di sopra della quale non riesce a separare le strutture spaziali di input. Questa limitazione è dovuta al fenomeno della diffrazione, ed applicando il criterio di Abbe, la frequenza di Soglia Fc può essere calcolata con la seguente relazione: Fc = d λf (4.35) che evidenzia come la risoluzione migliora con un diametro d della lente più grande. 4.11. RISOLUZIONE DEL SISTEMA OTTICO 121 Figura 4.40: Figura 4.41: Funzione di Modulazione rispetto alle frequenze spaziali (linee per mm) per due lenti. 122 CAPITOLO 4. SISTEMA OTTICO Figura 4.42: Risposta di un sistema ottico ipotetico pe una singola frequenza spaziale. 4.12 Funzioni di Trasferimento Ottico (OTF) In generale possiamo assumere che il sistema ottico operando come sistema lineare trasforma il segnale di input sinusoidale in un altro segnale di output sinusoidale non distorto con una variazione del contrasto (riduzione dell’ampiezza delle funzioni sinusoidale) dovuta alla diffrazione ed alle aberrazioni (4.42). L’informazione associata ad una linea dell’immagine può essere trasformata in una serie di funzioni sinusoidali con diversi valori di ampiezza e di frequenze spaziali di Fourier. In questo scenario, se consideriamo l’oggetto composto dalle componenti di Fourier, le modalità con cui tutte le singole componenti armoniche sono trasformate dal sistema ottico per produrre l’immagine, composta da armoniche con ampiezza diversa e senza essere sfasati, costituisce l’aspetto fondamentale del processo di formazione dell’immagine (figura 4.43). La funzione che modella tale processo è la funzione di trasferimento ottico (OTF). In questo scenario, oggetti geometricamente complessi visualizzano la natura continua delle loro trasformate di Fourier. La (4.35) suggerisce inoltre che un sistema ottico, estendendo la possibilità di avere diametro infinito, si comporta come un operatore di filtraggio che rigetta le alte frequenze spaziali superiori ad un certo valore Fc , caratteristico di un dato sistema ottico, lasciando alterate tutte quelle inferiori. La funzione OTF è complessa, e nel dominio delle frequenze spaziali, i moduli rappresentano la funzione MTF, mentre la fase (Phase Transfer Funtcion – PTF) è trascurata nell’ipotesi di sistema ottico privo di aberrazioni che modificano la fase. La funzione MTF misura la riduzione del contrasto nel processo di formazione dell’immagine ottica (proiezione dell’oggetto nel piano immagine). La funzione PTF quantifica gli spostamenti di fase e nei sistemi ottici parassiali possono essere trascurati. In sostanza la funzione MTF è lo strumento analitico che descrive le caratteristiche di tutte le componenti di un sistema di acquisizione immagini (lente, sensori, convertitori, ecc.). Se sono noti le MTF di ciascuna componente, la MTF del sistema completo è dato dal prodotto delle singole MTF note. Ricordiamo che il processo di formazione dell’immagine era stato modellizzato attraverso la convoluzione della funzione di luminosità dell’oggetto f(X,Y) e la funzione PSF: Z +∞ Z +∞ I(x, y) = f (X, Y ) · h(x − X, y − Y )dXdY = f (X, Y ) ⊗ h(X, Y ) −∞ (4.36) −∞ e per il teorema di convoluzione possiamo scrivere: = (I(x, y)) = F (u, v) · H(u, v) (4.37) dove il simbolo = indica la trasformata di Fourier, F(u,v) e H(u,v) sono rispettivamente le trasformate di Fourier dell’oggetto e della PSF, ed u e v sono le frequenze spaziali orizzontali e verticali. Alcuni aspetti rilevanti: 1. Lo spettro delle frequenze dell’oggetto è modificato attraverso l’operatore di moltiplicazione dallo spettro delle frequenze della PSF, denotato con H(u,v), che converte lo 4.13. CAMPIONAMENTO 123 Figura 4.43: Relazione tra spettro dell’oggetto e dell’immagine modificato da OTF; e relazione tra oggetto e immagine nel dominio della luminosità modificata dalla PSF. spettro dell’oggetto nello spettro delle immagini. 2. Lo spettro delle frequenze dell’immagine I è ottenuto con l’operatore di convoluzione che nel dominio delle frequenze spaziali si riduce alla moltiplicazione dello spettro delle frequenze della luminosità dell’oggetto e la trasformata della PSF. 3. La (4.37) esprime la modalità con cui H(u,v) proietta lo spettro dell’oggetto nello spettro dell’immagine. Questa modalità l’avevano considerato espletata dalla funzione OTF che possiamo allora identificarla con H: H(u, v) = = (h(X, Y )) (4.38) 1. Ricordiamo che siamo interessati a modificare con il modulo di H(u,v) le ampiezze delle varie componenti di frequenza dello spettro dell’oggetto e la fase di tali componenti è anche modificata per produrre lo spettro dell’immagine dell’oggetto. 2. Nel processo di convoluzione, la funzione caratteristica del sistema ottico è data dalla funzione PSF mentre la funzione OTF rappresenta la corrispondente funzione nello spazio di Fourier che caratterizza il sistema ottico. In tale spazio l’oggetto è rappresentato in termini di frequenze spaziali e la funzione di trasferimento ottico OTF modellizza come queste strutture geometriche periodiche sono modificate dal sistema ottico. 3. Ricordiamo che noto h e calcolato la sua trasformata di Fourier H, il modulo di quest’ultimo rappresenta MTF mentre la fase la funzione di trasferimento della fase (PTF). Se h è simmetrica (cioè dispari) non si hanno spostamenti di fase nel segnale di input, diversamente accade se è una funzione asimmetrica. (Nell’esempio h è una funzione simmetrica). Nelle condizioni di luce visibile (non coerente), la figura 4.43 mostra le relazioni tra oggetto e spettro dell’immagine attraverso la funzione di trasferimento ottico (OTF), e la relazione tra oggetto e Intensità luminosa dell’immagine attraverso la funzione PSF. 4.13 Campionamento Dopo aver analizzato il modello fisico-matematico del processo di formazione dell’immagine (generazione dell’immagine ottica) ed analizzato i parametri che lo caratterizzano (risoluzione geometrica e radiometrica, funzione di modulazione e PSF), siamo ora in grado di digitalizzare l’immagine ottica ottenuta, ossia campionare la funzione continua di intensità luminosa g(x,y) scegliendo una griglia di punti adeguatamente spaziati alla distanza (∆X,∆Y) nel dominio spaziale dell’oggetto oppure nel dominio spaziale dell’immagine (∆x, ∆y). Il processo di digitalizzazione comporta una perdita di informazione, nel senso che dell’immagine ottica continua g(x,y) solo l’intensità luminosa in corrispondenza dei nodi della 124 CAPITOLO 4. SISTEMA OTTICO Figura 4.44: Griglia di campionamento funzione di Dirac griglia (punti di campionamento) rimangono per rappresentare l’immagine. In altre parole, con il campionamento l’immagine continua g(x,y) è rappresentata con una matrice bidimensionale I(m,n) dove m indica le righe e n indica le colonne. E’ ragionevole pensare che la risoluzione della griglia di campionamento dovrà esser scelta in accordo alla equazione (4.35) tale che se Fc è la frequenza spaziale più alta di interesse nel piano dell’oggetto, corrispondente al periodo spaziale Tc che rappresenta il dettaglio geometrico significativo più fine, la frequenza di campionamento Fs dovrà essere scelta con il criterio che l’immagine campionata dovrà conservare i dettagli ancora ben contrastati. Questo è possibile considerando il teorema del campionamento di Nyquist il quale stabilisce che per poter ricostruire perfettamente un segnale continuo attraverso dei suoi campioni generati con periodo spaziale Ts , ossia con frequenza spaziale Fs =1/Ts , è necessario che il periodo spaziale Ts sia uguale o inferiore alla metà del periodo spaziale Tc corrispondente ai dettagli più fini presenti nell’immagine (Ts ≤ 12 Tc ). Equivalentemente si può dire che la condizione di Nyquist è soddisfatta se la frequenza spaziale di campionamento Fs è maggiore o uguale al doppio della frequenza massima Fc presente nell’immagine: Fs ≥2Fc . Questa condizione di Nyquist, espressa in termini di frequenza spaziale, significa che campionando l’immagine con periodo spaziale Ts è possibile ricostruirla con tutte le frequenze spaziali compreso la massima frequenza Fc : 1 2TS Fc = (4.39) che è chiamata frequenza di Nyquist nell’ipotesi di una griglia quadrata. Il processo di digitalizzazione può essere modellizzato matematicamente considerando il prodotto tra l’immagine continua f(x,y) e la funzione ideale di campionamento spaziale descritta dalla funzione Delta di Dirac bidimensionale che graficamente è rappresentata come una griglia di punti equamente spaziati di ∆x e ∆y lungo gli assi coordinati (vedi figura 4.44a). Ricordiamo che la funzione Delta di Dirac è data da: +∞ X δ(x, y, ∆x, ∆y) = X δ(x − m∆x)(y − n∆y) (4.40) m,n=−∞ che soddisfa le seguenti relazioni: Z∞ Z∞ 0 f (x, y) = 0 0 0 0 f (x , y )δ(x − x , y − y )dx dy 0 (4.41) −∞ −∞ Z² Z² lim ²→0 −² −² δ(x, y)dxdy = 1 (4.42) L’immagine campionata I risulterebbe: I(x, y) = f (x, y) · δ(x, y; ∆x, ∆y) = +∞ X m,n=−∞ X f (m∆x, n∆y)δ(x − m∆x, x − n∆y) (4.43) 4.13. CAMPIONAMENTO 125 Figura 4.45: a) Lo spettro dell’immagine originale; b) lo spettro dell’immagine campionata. La (4.43) evidenzia che l’immagine campionata eredita le informazioni di f(x,y) solo campionandola nei nodi della griglia (m∆x, n∆y). Per il teorema di convoluzione la (4.43) diventa: = (I(x, y)) = F (u, v) ∗ D(u, v) (4.44) dove =(I), F e D sono le trasformate di Fourier rispettivamente delle funzioni I , f ed δ. La trasformata di Fourier della funzione delta che descrive la griglia bidimensionale (∆x, ∆y) è un’altra funzione delta che nello spazio delle ³ frequenze ´ rappresenta la griglia bidimensionale 1 1 con spaziatura lungo gli assi coordinati di ∆X , ∆Y descritta da: +∞ X X D(u, v) = us · vs δ(u − kus , v − lvs ) (4.45) k,l=−∞ 1 1 dove us = ∆x e vs = ∆y sono le frequenze di campionamento dell’immagine nel dominio di Fourier. Considerando l’immagine continua f(x, y) da campionare una funzione limitata, ossia con la sua trasformata di Fourier con valore zero esterno ad una delimitata regione, dalla equazione di convoluzione (4.44) sostituendo la (4.45) si ottiene la trasformata di Fourier dell’immagine campionata: = (I(u, v)) = 1 1 ∆x ∆y +∞ X X F (u − kus , v − lvs ) (4.46) k,l=−∞ La (4.46) è ricavata considerando anche la proprietà di sifting della funzione delta (vedi figura 4.44b): XX δ(x − x0 , y − y0 ) · f (x, y) = f (x0 , y0 ) (4.47) La figura 4.45 mostra l’immagine originale e l’immagine campionata nello spazio delle frequenze. Quest’ultima è ottenuta replicando in modo indefinito lo spettro ´ ³ dell’immagine 1 1 , ∆y . ideale originale nello spazio delle frequenze con una griglia con risoluzione ∆x Verifichiamo ora come nelle condizioni imposte dal teorema del campionamento (4.44) l’immagine campionata possa essere ricostruita fedelmente anche se sono state perse le informazioni dell’immagine tra i nodi della griglia. In altri termini è possibile riavere f(x,y) partendo dall’immagine campionata I(x,y)? Questo è possibile se potessimo ricavare F(u,v) da =(I(x, y)). Dalle figure precedenti si osserva che questo è possibile eliminando da =(I(x, y)) tutte le repliche di F(u,v) ad eccezione dello spettro centrato sull’origine di =(I(x, y)). F(u,v) è ottenuto moltiplicando =(I) con la funzione rettangolare di campionamento Q³ u v ´ (figura 4.46) 2ux 2vy : 126 CAPITOLO 4. SISTEMA OTTICO Figura 4.46: La funzione rettangolare di campionamento. Figura 4.47: Interpolazione con sinx/x dell’immagine campionata. Yµ u v ¶ F (u, v) = =(I(x, y)) · 2ux 2vy uc ≤ ux ≤ 1 − uc ∆x vc ≤ vx ≤ 1 − vc ∆y (4.48) (4.49) L’immagine originale continua f è ottenuta applicando la trasformata di Fourier di F come segue: ·Y µ ¶ ¸ u v f (x, y) = =−1 (F (u, v)) = =−1 , · =(I(x, y)) 2ux 2vy Per il teorema di convoluzione la (4.48) diventa: f (x, y) = I(x, y) ∗ 2ux vy 2ux vy 2ux vy +∞ X X k,l= −∞ sin(2πux x) sin(2πvy y) = 2πux x 2πvy y f (k∆x, l∆y) sin(2πux x) sin(2πvy y) (2πux x) (2πvy y) (4.50) che indica l’operazione di convoluzione tra la funzione campionata I(x,y) e la funzione di interpolazione del tipo sin(x)/x . La (4.50) ci informa anche che l’operazione di convoluzione, moltiplicando la funzione campionata con la funzione di interpolazione nei punti di campionamento produce la replica della funzione sin x x e garantisce la ricostruzione esatta dalla funzione originale (come indicato in figura 1 1 4.47) attraverso la sommatoria che sovrappone le funzioni sin(x)/x con ux = 2∆x e 2∆y . La funzione di interpolazione diventa sin [2π(x/2∆x)] sin [2π(y/2∆y)] · 2π(x/2∆x) 2π(y/2∆y) di cui è rappresentata in figura 4.47 la versione monodimensionale. Se le condizioni di Nyquist non sono mantenute si può verificare per esempio il sottocampionamento in cui le frequenze di campionamento sono inferiore a quelle di Nyquist: 4.13. CAMPIONAMENTO 127 Figura 4.48: Spettro di immagine sottocampionata. us < 2uc e vs < 2vc ossia ∆x > 1 1 e ∆y > 2uc 2vc (4.51) (4.52) Se risultano soddisfatte le relazioni (4.51) o (4.52) le repliche periodiche di F(u,v) si sovrappongono (vedi figura 4.48) ottenendo uno spettro distorto =(I(x, y)) da cui non è possibile recuperare integralmente lo spettro F(u,v) e la (4.48) non è più soddisfatta dal segno di uguaglianza. Questo tipo di distorsione introdotta, per il non corretto campionamento, è chiamato l’effetto di Moirè per le immagini mentre nel caso monodimensionale viene chiamato errore di aliasing. Un modo per rimuovere questo errore consiste nel filtrare con un filtro passa-basso l’immagine allo scopo di aumentare il periodo spaziale delle strutture geometriche presenti nell’immagine (ossia diminuire la frequenza spaziale di campionamento) per soddisfare le condizioni di Nyquist. Riassumiamo gli aspetti fondamentali della teoria di campionamento: 1. Immagine con dimensioni finite: vista come una funzione bidimensionale è assunta con banda limitata (la trasformata di Fourier è zero nell’intervallo esterno delle frequenze considerate). 2. Campionamento modellizzato come replica dello spettro dell’immagine originale. L’immagine campionata è rappresentata (vedi figura 4.50) dai campioni f (k∆x, l∆y) ricavata campionando l’immagine continua originale f(x,y) con una griglia bidimensionale con risoluzione (∆x, ∆y). 3. Le condizioni di Nyquist consentono di ricostruire fedelmente l’immagine originale partendo dall’immagine campionata se quest’ultima è stata campionata con banda limitata da Fc (massima frequenza presente nell’immagine) e nel rispetto della equazione (4.49) che lega l’intervallo spaziale di campionamento (∆x, ∆y) con la frequenza limite Fc . 4. Le condizioni di Nyquist in termini di frequenza impongono che la frequenza di campionamento deve essere maggiore o uguale alla frequenza limite della banda ¢ ¡ 1 1 . ∆x = us ≥ 2extuc ∆y = vs ≥ 2extvc 5. Il fenomeno di Aliasing (effetto di Moire nel caso 2D) si verifica se le condizioni 3 e 4 non sono mantenute ossia us <2uc e vs <2vc , e produce distorsioni nell’immagine campionata. 6. Il fenomeno di Aliasing produce nelle immagini distorsioni osservabili che non possono essere eliminati con filtraggi successivi. Può essere eliminato solo se prima del campionamento l’immagine è filtrato per attenuare le alte frequenze e soddisfare la condizione del 128 CAPITOLO 4. SISTEMA OTTICO Figura 4.49: a) L’immagine originale. b) L’effetto di Moirè ottenuto campionando l’immagine a) ogni quattro punti. c) L’effetto di Moirè ottenuto campionando l’immagine a) ogni cinque punti. d) Effetto di aliasing generato con un segnale con lunghezza d’onda 10λ campionando con ∆x uguale a 9/10 della lunghezza d’onda il segnale sinusoidale di input. Figura 4.50: Scansione elettronica per la digitalizzazione con una telecamera con sensori CCD. punto 4. 7. La ricostruzione dell’immagine originale f(x,y) è ottenuta attraverso un processo di interpolazione descritta dalla equazione (4.50). Nella realtà i sistemi di acquisizione delle immagini (scanner, machina fotografica, telecamera, ecc.) non operano nelle condizioni idealizzate sopra indicate. L’immagine non può essere descritta come una funzione con banda limitata. La griglia di campionamento non sempre è regolare e questo genera il fenomeno di aliasing. Per esempio, in una telecamera con sensori CCD che deve campionare l’immagine ottica continua f(x,y) con una griglia bidimensionale con risoluzione (∆x, ∆y), il meccanismo di scansione elettronica che digitalizza l’immagine è costituito da una matrice di fotorecettori di 512x512 come evidenziato in figura 4.50, dove ciascun fotorecettore ha dimensioni 10µmx10µm. La figura 4.50 mostra come per ragioni fisiche esiste uno spazio tra fotorecettori e conseguentemente il periodo spaziale di campionamento è più piccolo violando le condizioni di Nyquist (equazioni 4.51 o 4.52). Questo comporta il fenomeno di Moirè che elimina le alte frequenze spaziali presenti nell’immagine. I fotorecettori possiamo considerarli come il segnale di campionamento modellizzato da un impulso rettangolare (esprime la sensibilità del sensore) la cui larghezza è data dalle 4.14. QUANTIZZAZIONE 129 dimensioni del fotorecettore. Con il segnale di campionamento più piccolo si ha l’effetto di ridurre l’energia delle alte frequenze presente nell’immagine. Abbiamo già osservato in precedenza che questo problema può essere eliminato prima del campionamento (prima dell’acquisizione) defocalizzando per esempio l’immagine, minimizzando cosı̀ con l’effetto di Moirè. 4.14 Quantizzazione Mentre il campionamento ha definito la risoluzione spaziale ottimale dell’immagine, per completare il processo di digitalizzazione dell’immagine è necessario definire la risoluzione radiometrica (livelli di luminosità) adeguata ossia con quale accuratezza il pixel rappresenterà l’intensità luminosa dell’oggetto originale. Il processo di quantizzazione converte i valori continui di intensità, in corrispondenza di ciascun punto campionato dell’immagine, in un valore numerico che può assumere valori compresi in un intervallo definito che dipende dal numero di bit assegnati. Per un’immagine binaria (ciascun pixel rappresentato con valore 0 oppure 1) è sufficiente assegnare 1 bit a ciascun pixel. Normalmente a ciascun pixel sono assegnati 8 bits e in questo modo l’intervallo di input di intensità luminosa (imin , imax ) può essere convertito in 256 livelli normalmente tra 0 e 255 memorizzando il valore del pixel in un byte nella memoria del calcolatore. In figura 4.51 sono visualizzate immagini quantizzate a diverse risoluzioni di intensità luminosa e si osserva come partendo dall’immagine a 8 bit di buona qualità man mano che diminuiscono i bit di quantizzazione (ossia livelli di intensità) si degrada la qualità dell’immagine. La quantizzazione ossia l’assegnazione di un valore di intensità a ciascun pixel campione dell’immagine, e di codifica (nel caso della digitalizzazione delle immagini significa trasformazione del segnale intensità luminosa in una forma binaria adeguata per l’elaborazione e memorizzazione digitale) sono processi distinti anche se nella caso della digitalizzazione delle immagini è realizzato dallo stesso dispositivo: convertitore da analogico a digitale. Se la scala di quantizzazione è composta da intervalli di uguale ampiezza, la quantizzazione è detta lineare o uniforme altrimenti è chiamata non lineare. L’operazione di quantizzazione, essendo un processo di discretizzazione comporta di assegnare valori approssimati definiti con l’errore di quantizzazione. In figura 4.52 è evidenziata graficamente la funzione di trasformazione a gradino per quantizzare l’intervallo di input delle ascisse in un intervallo definito dai livelli di quantizzazione significativi. Nella digitalizzazione delle immagini ai fini della visualizzazione la codifica delle intensità in 8 bit è sufficiente per avere una buona qualità dell’immagine a livelli di grigio quantizzandola con una scala logaritmica che meglio si adatta alla risposta dei fotorecettori visivi. In Questo modo si produce una risoluzione più alta in corrispondenza della intensità luminosa più bassa dove l’occhio presenta una buona sensibilità alle deboli variazioni di luminosità, ed al contrario si ha risoluzione più bassa in corrispondenza di pixel più luminosi dove comunque l’occhio ha una peggiore sensibilità. In molte applicazioni di visione artificiale 8 bit sono sufficienti per la quantizzazione dell’immagine. In altre applicazioni, per esempio in astronomia, oppure in astrofisica oppure in biomedica, è richiesta una quantizzazione con risoluzione più alta con 12 e perfino 16 bits di quantizzazione. 130 CAPITOLO 4. SISTEMA OTTICO Figura 4.51: Per valutare l’errore introdotto dal processo di quantizzazione, si può utilizzare il metodo di LLOYD-MAX che minimizza l’errore quadratico medio dato da: Z Imax 2 2 ² = E (I − Iq ) = (I − Iq ) p(I)dI (4.53) Imin dove I rappresenta l’intensità luminosa di input, Iq il valore quantizzato e p(I) è la distribuzione densità di probabilità dei valori dell’immagine di input (vedi figura 4.53). Ipotizzando una distribuzione gaussiana per p(I) con variazione σ I e media MI, se gli L livelli di quantizzazione sono uniformemente spaziati di ∆I=(I min ¡ max -I∆I ¢)/L, l’errore di quantizzazione ² risulta uniformemente distribuito nell’intervallo − ∆I 2 , 2 . L’errore quadratico medio è dato da: Z ∆I/2 ∆I 2 1 2 (I − Iq ) dI = (4.54) ²= ∆I ∆I/2 12 Se l’immagine I ha un range dinamico Imax -Imin e distribuzione uniforme, la varianza σ I 2 è data da (Imax -Imin )2 /12. Con un quantizzatore uniforme con Q bit risulta: ∆I=(Imax Imin )/2Q . Da ciò consegue che ∈ = 2−2Q ⇒ SN R = 10 log10 22Q = 6Q dB σI2 (4.55) 4.15. ESEMPI DI SISTEMI DI ACQUISIZIONE REALI 131 Figura 4.52: Figura 4.53: ossia, il rapporto segnale rumore raggiunto da un ottimo quantizzatore quadratico medio per una distribuzione uniforme è di 6 dB per bit espresso in decibel. La teoria dell’informazione di codifica che in generale calcola l’entità dell’errore introdotto in relazione al numero di bit associati per pixel, anche se non assicura la funzione di quantizzazione ideale, presenta una linea guida sulle condizioni ottimali per minimizzare l’errore di quantizzazione che non può mai essere zero. In generale il rapporto segnale rumore per la quantizzazione è dato da: µ SN R = 10 log 4.15 NI2 ² ¶ (4.56) Esempi di sistemi di acquisizione reali Analizziamo ora alcuni parametri caratteristici dei sistemi reali di acquisizione delle immagini, analizzando le loro differenze significative. Figura 4.54: Prestazioni di un quantizzatore Gaussiano. 132 CAPITOLO 4. SISTEMA OTTICO Figura 4.55: Profondità di campo per una lente sottile. 4.16 Telecamera e macchina fotografica Tali dispositivi utilizzano in particolare sistemi ottici che operano nella condizione in cui la distanza degli oggetti do è normalmente molto maggiore della distanza focale (do >>di ∼ =f) e per l’eq.() il fattore di ingrandimento S≤1. Un punto luminoso dell’oggetto se è perfettamente a fuoco è proiettato nel piano immagine che si trova alla distanza di =f del centro della lente. Se non risulta a fuoco il vertice del cono di proiezione si troverà ad una distanza minore di f e superiore in relazione al valore di do in accordo alla equazione dei punti coniugati. In tale contesto il punto luminoso nel piano immagine diventa un disco di diametro ² che può essere accettato a fuoco se non raggiunge un valore del diametro non superiore ad un valore di soglia d. Se si considera la pupilla di entrata uguale a quella di uscita, con do >0 il diametro del disco è calcolata dai triangoli simili e risolto in termini dei parametri della lente e della distanza dell’oggetto (vedi figura 4.56): µ ¶ µ ¶ µ ¶ Sia − Soa do f ²=D = f2 −1 / (do − f ) (4.57) Sia Soa D con do =∞ segue che ²= f2 D = f2 = f · D/s f f soa D soa (4.58) Per distinguere se il disco è focalizzato prima o dopo il piano focale ² è rispettivamente positivo o negativo anche se dovrà essere sempre considerato positivo come valore assoluto.Per macchina fotografica con formato da 35 mm un disco accettabile risulta con diametro 0.03 per la maggior parte delle ottiche commerciali. Se la lente è focalizzata all’infinito, l’immagine si trova alla distanza focale f mentre l’oggetto più vicino al centro ottico che risulta accettabilmente a fuoco si trova ad una distanza chiamata distanza iperfocale D.I.: dI = f D/d = f 2 /fstop · ² (4.59) dove fstop = f /D con D diametro della pupilla d’entrata. Se l’oggetto si trova ad una distanza finita l’oggetto più vicino a fuoco ancora accettabile si trova alla distanza do min: domin = di do / (di + (do − f )) (4.60) mentre l’oggetto più lontano ancora a fuoco si trova alla distanza do max: domax = di do / (di − (do − f )) (4.61) 4.17. MICROSCOPIA 133 che diventa uguale all’infinito se il denominatore diventa zero oppure negativo. La profondità di campo di un oggetto alla distanza do dalla lente è data dalla differenza do max- do min. Una telecamera CCD con buona risoluzione utilizza fotorecettori di dimensioni 10µmx10µm. L’aerea sensibile nel piano immagine in questo caso ha le dimensioni di circa 12 × 12mm2 , dipende dal numero di fotorecettori presenti del chip, attualmente possono superare 3 milioni di fotorecettori nelle telecamere a colori. Se si considera una lente con f=16mm e con un diametro f# =fstop =f/D=f/2 per un oggetto alla distanza di 2m e considerando luce visibile dominante λ=555nm si hanno: diametro del disco ² = 2.43934·λ·f# = 2.43934·555·f# per ²=0.03mm c f# = 0.00135383 = 22.16 per la fotografia f# = 0.05 0.00135383 = 36 f# = 0.005 = 3.6 per la fotografia per le telecamera f# = 0.013 = 2.2 domin = 25.600 · 2.000/(25.600 + (2.000 · 16)) = 1.856mm DI = f 2 /(f /# · ²) = 162 /2 · 0.005 = 25.600mm domax = 25.600 · 2.000/(25.600 − (2.000 − f )) = 2.168mm si osserva una buona profondità di campo (2.168÷1.856) di circa 312mm. Quando d o ∼ f = 16 = d i considerando f 6= = 2 d o = 2f i = 32mm domin = 25.600 · 32/(25.600 + (32 − 16)) = 31 domax = 25.600 · 32/(25.600 − (32 − 16)) = 32.02 Si osserva come la profondità di campo si riduce moltissimo e pertanto solo oggetti piani e piccoli possono essere acquisiti. 4.17 Microscopia Per questi dispositivi la lente che attraversa un supporto meccanico è allontanato dal piano immagine per avere una distanza d i >>f mentre la distanza dell’oggetto è quasi uguale alla focale f della lente (d o ∼ =f ). In queste condizioni il fattore di ingrandimento s = d i /d o >>1 e l’ottica diventa in questo caso fondamentale per ottenere immagini fortemente ingranditi e di qualità. Galileo fu il secondo che annunciò l’invenzione del microscopio dopo Zacharias Janken. La lente vicina all’oggetto è chiamata obiettivo che forma l’immagine reale, invertita ed ingrandita con focale f o . L’immagine è formato nel piano field stop della lente oculare con focale f e . I raggi luminosi che emigrano da questo piano immagine passano attraverso la lente oculare come fascio di raggi paralleli all’asse ottico. In questo seconda lente, l’immagine è ulteriormente ingrandita ed il risultato dell’ingrandimento finale P I è il prodotto di quello traverso S o 134 CAPITOLO 4. SISTEMA OTTICO Figura 4.56: Telescopio di Galileo. causato dall’obiettivo di focale f o e dall’ingrandimento oculare S e . C i e C ie sono le quantità x o indicati nella figura 6.11 distanza dell’oggetto (o immagine) dal fuoco. µ ¶µ ¶ Ci Cie P T = So · Se = (4.62) fo fe dove d i in questo caso deve considerarsi la distanza, tra il secondo fuoco dell’obiettivo con focale f o e il primo fuoco dell’oculare f e che normalmente è standard con valore L=160mm, nota come la lunghezza del tubo ottico di separazione delle lenti ossia la distanza dell’immagine dall’obiettivo (pupilla di entrata). P t è chiamato potenza di ingrandimento di uno strumento di visione definita come il rapporto delle dimensioni dell’immagine sulla retina quando l’oggetto si osserva con lo strumento di visione ad occhio nudo. Si osserva inoltre che se l’oggetto è posto alla distanza f o dall’obiettivo, l’ingrandimento So = −di /do tende all’infinito ossia l’immagine si forma all’infinito. Nell’ipotesi che la focale dell’obiettivo sia uguale a 32, l’ingrandimento S o è di un fattore 5, che indica la potenza di ingrandimento (detto anche 5x). Se l’oculare ha una focale f e =25,4 e l’oggetto è posto alla d i 254 dal fuoco dell’obiettivo, l’ingrandimento P t del microscopio per la (4.62) risulta 50x. Uno strumento di visione in generale ed in particolare un microscopio è caratterizzato oltre che dalla potenza di ingrandimento P t anche dalla qualità e luminosità dell’immagine ottenuta. Quest’ultima dipende dalla quantità di luce acquisita dall’obiettivo che è caratterizzato dal parametro f # . Quando la distanza dell’oggetto e dell’immagine sono finite, un parametro più adeguato per esprimere la luminosità del sistema ottico è dato dalla apertura numerica NA: N A = no · sin θ ∼ = D/2f (4.63) dove n o è l’indice di rifrazione del mezzo adiacente all’obiettivo (olio, aria, acqua, ecc.), e θ è l’angolo di massima apertura angolare di luce acquisita dell’obiettivo rispetto all’origine del piano oggetto. Per l’aria l’indice di rifrazione è circa 1. Per il microscopio, i parametri di risoluzione del sistema di acquisizione (distanza tra pixel) sono meglio definiti se si ragiona sul piano dell’oggetto piuttosto che sul piano immagine. In questo caso l’oggetto è posto alla distanza dall’obiettivo che risulta quasi sempre uguale ad f. In queste condizioni, noto il fattore di ingrandimento S o dell’obiettivo del microscopio, la frequenza di soglia nel piano oggetto è data da: Fe = So D/λf = D/λf ∼ (4.64) = 2N A/λ ed il diametro del disco calcolato con la distanza di Ryleagh è data da: ² = 0.61λ/N A (4.65) Se la potenza di ingrandimento è adeguata, con una apertura angolare non molto alta, l’immagine risulta di buona qualità con un diametro del disco con valore compreso nell’intervallo 0.025:0.05mm per la fotografia e telecamere. Con le potenze di ingrandimento di 4.18. TELESCOPIA 135 Figura 4.57: Telescopico astronomico. 50x ed una luminosità di f/1 si può verificare con le formule precedenti che la profondità di campo si riduce decisamente diventando di qualche frazione di micron di millimetro. 4.18 Telescopia Al contrario della microscopia, nella telescopia un oggetto lontano è osservato apparendo ben ingrandito. Come si osserva in figura 4.57, dell’oggetto che si trova ad una distanza finita dell’obiettivo con focale f o , si forma l’immagine subito dopo il secondo fuoco dell’obiettivo stesso. Questa immagine diventa l’oggetto della seconda lente di focale f e che è l’oculare. Quest’ultima forma una immagine virtuale ingrandita se l’immagine intermedia si forma ad una distanza uguale o minore di f e rispetto all’oculare. In sostanza, l’immagine intermedia risulta costante e solo l’oculare è mosso per mettere a fuoco il telescopio. Per il telescopio d o >> d i ∼ = f. La frequenza di soglia F c (espressa in cicli/radianti) nel sistema di coordinate angolari centrate rispetto al telescopio è data: Fc = D λ (4.66) mentre il disco di Airy ha il diametro: δ = 2.44λ/D (4.67) L’ingrandimento del telescopio è dato dal rapporto fra l’angolo θ sotto il quale si osserva l’oggetto e l’angolo sotto cui si vede lo stesso oggetto senza telescopio. L’ingrandimento è proporzionale alla lunghezza focale f o del telescopio ed inversamente proporzionale a quella dell’oculare ST = −fo /fe . Normalmente f o è fisso mentre si cambiano gli oculari con focali diverse. Per esempio, un telescopio con f o = 10.000mm produce un ingrandimento di 1000 se si utilizza un oculare con f e =10mm. 4.19 La funzione MTF del sistema di acquisizione Un sistema completo di acquisizione, elaborazione e restituzione dell’immagine possiamo considerarlo come una catena sequenziale di sistemi lineari invarianti linearmente ed il loro effetto risultante può essere modellato con una singola funzione PSF oppure con la corrispondente unica funzione di trasferimento. Il sottosistema di acquisizione è descritto dalle funzioni PSF h1 ed h2 rispettivamente corrispondenti alla componente ottica ed alla componente di digitalizzazione (per esempio una telecamera) del sistema. Il sottosistema di elaborazione descritto da p(x,y) ipotizziamo che non introduca nessuna alterazione dell’immagine digitale. Il sottosistema di restituzione, per esempio un monitor, è modellato dalla funzione di trasferimento h3 (x,y). La funzione di modulazione MTF dell’intero sistema è dato combinando per moltiplicazione le funzioni MTF di ciascuna componente del sistema. 136 CAPITOLO 4. SISTEMA OTTICO h(x,y)=I-1(H) + Sistema Processo Output Rumore H(u,v)=H1*H2*H3 Figura 4.58: Figura 4.59: Sistema di acquisizione e di restituzione immagini. La funzione PSF o le funzioni di trasferimento sono note analiticamente oppure calcolate sperimentalmente oppure fornite direttamente dai costruttori delle singole componenti del sistema. In figura 4.60 sono rappresentate le PSF e le funzioni di trasferimento delle componenti del sistema. La funzione di trasferimento dell’intero sistema è dato dal prodotto delle funzioni di trasferimento di ciascuna componente del sistema e si osserva come quest’ultima sia un’ampiezza minore mentre la funzione PSF corrispondente h(x,y) dell’intero sistema presenta una ampiezza maggiore dimostrando come il sistema introduce un leggero effetto di sfocamento. Un buon sistema di acquisizione e visualizzazione immagine deve avere una funzione di modulazione MTF di trasferimento dell’immagine caratterizzato ad attenuare le alte frequenze generalmente dominate dal rumore mentre dovrebbe lasciare le altre frequenze generalmente dominate dal rumore mentre dovrebbe lasciare inalterate le frequenze corrispondenti ai dettagli delle immagini in accordo al criterio di Nyquist che definisce la frequenza limite di taglio ossia la più alta frequenza presenta un’immagine da mantenere, ed in accordo al criterio di Raylegh che fissa la spaziatura di campionamento a metà della risoluzione del diametro dello spot di campionamento. Concludiamo, inoltre, con l’aver modellizzato il sottosistema ottico come un sistema lineare invariante spazialmente e considerato valido entro certi limiti di apertura del sistema al di sopra di determinati valori. In condizioni di illuminazione con luce coerente il sistema ottico è considerato lineare in intensità luminosa. La funzione PSF che descrive il Figura 4.60: Funzioni di trasferimento delle varie componenti del sistema. 4.19. LA FUNZIONE MTF DEL SISTEMA DI ACQUISIZIONE 137 sistema ottico è finita e tendenzialmente ampia per l’effetto dell’aberrazione ottica e della natura ondulatoria della propagazione della luce. Un modo semplificato per modellizzare la caratteristica (PSF e OTF) del sistema è quello di considerare la componente ottica con diffrazione limitata ossia con assenza di aberrazioni. Con questa assunzione la risoluzione del sistema dipende solo dalla diffrazione (limitata). Un sistema ottico con diffrazioni limitate ha la caratteristica di trasformare onde sferiche divergenti entranti in onde sferiche che escono convergenti dal sistema ottico. L’energia luminosa che attraversa il sistema ottico è caratterizzato dalla pupilla di entrata che rappresenta il piano contenente l’apertura del sistema ottico stesso. 138 CAPITOLO 4. SISTEMA OTTICO