Università degli Studi di Roma “La Sapienza”

Anno Accademico 2009-2010

Facoltà di Scienze Matematiche Fisiche e Naturali

Corso di Laurea Specialistica in Matematica per le Applicazioni

Alcuni appunti per il corso di

CALCOLO DELLE PROBABILITÀ 3

Giovanna Nappo

A.A. 2009/2010

versione del 1.11.2009

Indice

Introduzione

ii

Programma provvisorio del corso

iii

1 Richiami su spazi di probabilità

1.1 Esempi di spazi di probabilità . . . . . . . .

1.2 Variabili aleatorie . . . . . . . . . . . . . . .

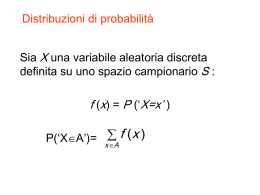

1.3 Distribuzioni di variabili aleatorie . . . . . .

1.4 Valori attesi . . . . . . . . . . . . . . . . . .

1.4.1 Variabili aleatorie in spazi misurabili

1.5 Misura indotta e Cambio di variabile . . . .

1.6 Variabili gaussiane . . . . . . . . . . . . . .

.

.

.

.

.

.

.

1

1

4

6

10

12

12

16

2 Costruzione di variabili aleatori in (0, 1)

2.1 Teorema di rappresentazione di Skorohod . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.2 Costruzione di una succesione di variabili aleatorie indipendenti . . . . . . . . . . . . . . . . . . . . . .

2.3 Convergenza per variabili aleatorie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

20

20

23

25

Bibliografia

28

3 ESERCIZI PROPOSTI

3.1 Esercizi di tipo analitico . . . . . . . . . .

3.2 Esercizi sulla convergenza in distribuzione

3.3 Esercizi con le funzioni caratteristiche . .

3.4 Esercizi sulla condizione di Lindeberg . .

3.5 Esercizi sulla legge dei grandi numeri . . .

3.6 Esercizio riassuntivo . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

29

29

30

30

32

33

33

ii

CP3–1-nov-2009

Introduzione

Lo scopo di questo corso è quello di riesaminare con gli strumenti più sofisticati (come ad esempio la teoria della

misura) alcuni dei concetti principali del Calcolo delle Probabilità, già affrontati nei corsi di Calcolo delle Probabilità

1 e 2.

Argomento principale saranno i vari tipi di convergenza per variabili aletaorie e le generalizzazioni della Legge dei

Grandi Numeri e del Teorema Centrale del Limite.

Come è noto, la Legge (debole) dei Grandi Numeri ed il Teorema Centrale del Limite hanno come soggetto principale

una successione {Xn }n≥1 di variabili aleatorie indipendenti, con funzione di distribuzione data1 .

Nei corsi elementari abbiamo dato per scontato che una tale successione di variabili aleatorie esistesse: in questo

corso vedremo come questo fatto sia vero. Il problema va diviso in due parti:

• primo problema: data una funzione di ripartizione F (ossia una funzione a valori in [0, 1], non decrescente,

continua da destra e normalizzata) esiste sempre uno spazio di probabilità (Ω, F, P) e una variabile aleatoria X, tale

che FX (x) = F (x), dove FX (x) := P(X ≤ x)?

• secondo problema: data una successione di funzioni di distribuzione {Fn }n≥1 esiste uno spazio di probabilità

(Ω, F, P) e una successione di variabili aleatorie {X}n≥1 , indipendenti e tali che FXn (x) = Fn (x)?

Ci sono due risposte possibili a questa domanda, una dovuta a Kolmogorov e una dovuta a Skorohod: noi

accenneremo alla¡ risposta di Kolmogorov,

mentre vedremo la risposta di Skorohod in cui lo spazio di probabilità

¢

è semplicemente (0, 1), B(0, 1), λ|(0,1) , dove B(0, 1) è la sigma-algebra dei boreliani e λ|(0,1) è la misura di Lebesgue

ristretta all’intervallo (0, 1).

Questi appunti (parzialmente basati su appunti scritti per altri corsi) non sono in nessun modo completi. Le lezioni

sono basate principalmente sui testi di Billingsley [1] e di Koch [2].

ATTENZIONE: le notazioni potrebbero differire da quelle usate a lezione.

GLI APPUNTI NON SONO ANCORA COMPLETATI(ad esempio, nella sezione sui vari tipi di convergenza,

mancano le definizioni), E NON SONO STATI ANCORA CORRETTI.

1 Nel caso più semplice la funzione di distribuzione F

Xn è addirittura sempre la stessa, ma, come vedremo questa condizione non è

necessaria.

CP3–1-nov-2009

iii

PROGRAMMA PROVVISORIO DEL CORSO

CALCOLO DELLE PROBABILITÀ 3 I Semestre , A. A. 2009/10

docente: Giovanna Nappo,

(ufficio n.108, tel. 49913262, e-mail: [email protected])

Prerequisiti: Nozioni di base di Probabilità, acquisibili attraverso i corsi di Calcolo delle Probabilità 1 e 2.

In particolare si presuppone che lo studente conosca le nozioni di distribuzione congiunta e le distribuzioni classiche. È

inoltre consigliato avere familiarità con i concetti di base di teoria della misura (tali nozioni sono acquisibili nel corso

di Analisi Reale).

Obiettivi: Studio delle relazioni tra teoria della misura (misure finite) e modelli probabilistici. Studio delle

possibili descrizioni e costruzioni per variabili aleatorie. Studio di alcuni tipi di convergenza per variabili aleatorie

(quasi certa, in probabilità e in distribuzione). Acquisizione delle tecniche fondamentali di convergenza e dei risultati

fondamentali del Calcolo delle Probabilità (Legge dei Grandi Numeri e Teorema Centrale del Limite)

TESTI CONSIGLIATI:

- P. Billingsley, Probability and Measure, Wiley 1984.

- G. Koch, La matematica del probabile, Aracne, 1997.

ALTRI TESTI CONSIGLIATI:

- D. Williams, Probability with martingales, Cambridge University Press, 1991;

- L. Breiman, Probability, Addison Wesley, 1968;

- Y.S. Chow, H. Teicher, Probability Theory, Springer Verlag, 1988;

- B. De Finetti, Teoria delle Probabilità, Einaudi, 1970;

- W. Feller, An introduction to probability theory and its applications (Vol 1 e 2), Wiley & Sons, 1970

Programma:

A. MISURE DI PROBABILITÀ:

σ-algebre di eventi, σ-additività e continuità delle misure di probabilità. sigma-algebre generate, λ-sistemi e π-sistemi

di eventi, lemma π − λ di Dynkin, limiti superiore ed inferiore per successioni di eventi. Indipendenza stocastica fra

sigma-algebre, lemmi di Borel-Cantelli, sigma-algebra coda di una successione di eventi, Legge 0-1 di Kolmogoroff.

Misure di probabilità sulla retta, funzioni di distribuzione associate.

B. VARIABILI ALEATORIE (COME FUNZIONI MISURABILI):

σ-algebra generata da una funzione misurabile (e da un vettore aleatorio), misura indotta da una funzione misurabile

(e da un vettore aleatorio).

Misura di probabilità indotta da una variabile aleatoria reale X (legge di una variabile aleatoria). Funzioni di

distribuzione reali e spazi canonici: (a) i reali R e i boreliani di R con la misura indotta da X; (b) lo spazio (0, 1) con

i boreliani di (0, 1) e la misura di Lebesgue ristretta a (0, 1) e costruzione di Skorohod su (0, 1).

Integrazione di funzioni misurabili (cenni). Valori attesi e proprietà fondamentali.

Indipendenza stocastica per variabili aleatorie e misure prodotto, costruzione di una successione di variabili aleatorie

indipendenti sullo spazio canonico (0, 1).

???Applicazioni probabilistiche del Teorema di Fubini.

Legge 0-1 di Kolmogoroff per variabili aleatorie. Enunciati dei teoremi di convergenza monotona e dominata.

Disuguaglianza di Markov.

C. CONVERGENZA PER SUCCESSIONI DI VARIABILI ALEATORIE:

Definizioni di convergenza quasi certa, in probabilità ed in legge (o in distribuzione) per successioni di variabili aleatorie.

Relative proprietà e relazioni. Convergenza debole per successioni di misure di probabilità, caratterizzazioni (Teoremi

di Helly) e relazioni con la convergenza in legge. Teorema di Scheffé (convergenza delle densità di probabilità)[solo

enunciato]. Successioni tight (trattenute o strette) di misure di probabilità e Teorema di Prohorov. Uniforme

integrabilità e convergenza debole.

iv

CP3–1-nov-2009

D. FUNZIONI CARATTERISTICHE E TEOREMA CENTRALE DEL LIMITE:

Definizione di funzione caratteristica di una distribuzione di probabilità sulla retta e relative proprietà. Teorema di

Bochner [solo enunciato]. Calcolo della funzione caratteristica in casi notevoli; distribuzioni simmetriche. Relazione

tra funzione caratteristica e momenti della distribuzione. Cenno al problema dei momenti: controesempio della legge

lognormale. Teorema di inversione e caso in cui la funzione caratteristica appartiene a L1 (R) (è integrabile sui reali

rispetto alla misura di Lebesgue).

Teorema di continuità. Teorema Centrale del Limite per successioni di variabili aleatorie indipendenti: Teorema di

Lindeberg-Levy, Teorema di Lindeberg con discussione della condizione di Lindeberg (la generalizzazione al caso di

insiemi triangolari è facoltativa) Teorema di Lyapunov, Teorema di Berry-Esseen (solo enunciato).

Applicazioni del Teorema Centrale del Limite (approssimazione della legge della somma di variabili aleatorie

indipendenti identicamente distribuite, relazione con la formula di Stirling)

E. LEGGI FORTI DEI GRANDI NUMERI:

Legge forte con esistenza e limitatezza del momento quarto (di Cantelli). Disuguaglianza di Kolmogoroff. Criterio

sufficiente di Kolmogoroff per la legge forte. Legge forte per variabili aleatorie indipendenti identicamente distribuite

(i.i.d.) con momento primo (Teorema di Kinchin). Estensione al caso di variabili aleatorie i.i.d., ma con momento

primo della parte positiva non finito.

Riferimenti dettagliati per gli argomenti in A e B:

[Billinsgley]:

1: The Unit Interval,

2: Spaces, Classes of Sets, Probability Measures,

3: Uniqueness and the λ − π Theorem (si consiglia la lettura di tutto)

4: tutto,

5: se ne consiglia la lettura,

10:, 11: e 12: i contenuti si considerano noti, e se ne consiglia la lettura,

20: Random variables and Vectors, Subfields, Distributions, Independence, Sequences of Random Variables,

Convolution,

21: Expected Values and Distributions, Moments, Inequalities, Independence and Expected Values,

22: Kolmogorov’s 0-1 law.

[Koch]:

Cap. 4, appendice II,

Cap. 5: 5.1, 5.2 e 5.3 (si consiglia la lettura anche dei rimanenti paragrafi),

Cap. 6: Teorema 6.87,

Cap. 8: 8.1 e 8.2 (si consiglia la lettura di 8.3),

Cap. 9: 9.1 e 9.2,

Cap.13: 13.2.

Riferimenti dettagliati per gli argomenti in C, D ed E:

[Billinsgsley]:

20: Convergence in Probability,

22: Kolmogorov’s Inequality, The strong Law of Large Numbers,

25: tutto,

26: tutto,

27: Identically Distributed Summands, The Lindeberg and Lyapunov Theorems.

[Koch]:

Cap.11,

Cap.12: 12.1, 12.2.,

Cap.13: 13.1 (fino a pag. 503), Prop. 13.34, 13.3

(in particolare i Teoremi 13.49, 13.50, 13.51, 13.52, 13.59, 13.60)

Capitolo 1

Richiami su spazi di probabilità

1.1

Esempi di spazi di probabilità

Come dovrebbe essere noto uno spazio di probabilità è una terna (Ω, F, P), dove

F è una σ-algebra, ovvero F è una famiglia di sottoinsiemi di Ω, cioè F è un sottoinsieme di P(Ω), tale che

Ω ∈ F;

se A ∈ F, allora Ac ∈ F ;

se An ∈ F, n ∈ N, allora ∪n∈N An ∈ F;

(1.1)

(1.2)

(1.3)

P è una misura di probabilità, ovvero

P :F 7→ [0, 1];

A 7→ P(A)

con le proprietà che

P(Ω) = 1;

se An ∈ F , n ∈ N, con An ∩ Am = ∅ per n 6= m,

¡[

¢ X ¡ ¢

allora P

An =

P An .

n∈N

(1.4)

(1.5)

n∈N

La σ-algebra F rappresenta l’informazione disponibile, ovvero gli eventi appartenenti a F sono gli unici eventi di

cui abbiamo la possibilità di sapere se si sono verificati oppure no.

Oltre alla misura di probabilità P, per tutti gli eventi A ∈ F con P(A) > 0, si possono definire le probabilità

condizionate 1 all’evento A, che rappresentano la valutazione della probabilità nel caso in cui si verificasse l’evento

A:

P(·|A) F : → [0, 1]

P(E ∩ A)

E→

7 P(E|A) :=

P(A)

(1.6)

(1.7)

Vediamo ora alcuni esempi elementari di spazi di probabilità:

1 È facile verificare che la funzione P(·|A) definita in (1.6) è una probabilità, cioè soddisfa gli assiomi delle probabilità. Per mettere in

evidenza tale fatto va detto che Kolmogorov aveva adottato la notazione PA (·), ovvero PA (E) invece di P(E|A), anche per mettere meglio

in evidenza questa proprietà.

1

2

CP3–1-nov-2009

Esempio 1.1. Qualunque sia Ω, la σ-algebra banale F = {∅, Ω} è una σ-algebra, e necessariamente P(Ω) = 1 e

P(∅) = 0.

Esempio 1.2. Qualunque sia Ω, preso un sottoinsieme proprio A di Ω la σ-algebra F = {∅, A, Ac , Ω} è una σ-algebra,

e necessariamente P(Ω) = 1, P(∅) = 0, P(A) = p, P(Ac ) = 1 − p, per un p ∈ [0, 1].

Esempio 1.3. Qualunque sia Ω, sia {Hm , m = 1, 2, . . . , N } una partizione finita di Ω, cioè se gli eventi sono

incompatibili:

Hn ∩ Hm = ∅ per n 6= m, n, m ∈ {1, 2, . . . , N }

ed esaustivi:

N

[

Hm = Ω,

m=1

allora la famiglia M = {A =

S

m∈I Hm , al variare di I ⊆ {1, 2, . . . , N }}, (con la convenzione che

σ-algebra. Inoltre se p1 , p2 , . . . , pN sono numeri non negativi, a somma 1, ovvero

N

X

pm ≥ 0, m = 1, 2, . . . , N,

[

Hm = ∅) è una

m∈∅

pm = 1,

m=1

allora P : M 7→ [0, 1]; A 7→ P(A), con

P(A) =

X

pm ,

per A =

m∈I

[

Hm ,

(1.8)

m∈I

definisce una probabilità su (Ω, M).

Esempio 1.4. Le proprietà dell’esempio precedente valgono anche nel caso di una partizione numerabile {Hm , m ∈

N} con i dovuti cambiamenti: cioè, se

Hn ∩ Hm = ∅ per n 6= m, n, m ∈ N,

[

Hm = Ω,

m∈N

allora la famiglia

F = {A =

(con la convenzione che

[

[

Hm , al variare di I ⊆ N},

m∈I

Hm = ∅), è una σ-algebra2 .

m∈∅

Inoltre se p1 , p2 , . . . , pm , . . . sono numeri non negativi, somma 1, ovvero

X

pm = 1,

pm ≥ 0, m ∈ N,

m∈N

2 La

verifica è banale:

Ω=

[

Hm , ovvero I = N

m∈N

[

se A =

Hm , allora Ac =

m∈I

se An =

[

m∈In

[

Hm

m∈I c

Hm , n ≥ 1, allora

∞

[

n=1

An =

[

m∈I

Hm , per I = ∪∞

n=1 In .

CP3–1-nov-2009

3

allora P : F 7→ [0, 1]; A 7→ P(A), con

X

P(A) =

pm ,

per A =

m∈I

[

Hm ,

(1.9)

m∈I

definisce una probabilità su (Ω, F).

La verifica di quest’ultima proprietà è banale3 .

Elenchiamo adesso alcune proprietà e notazioni relative alle σ-algebre:

1 l’intersezione di σ-algebre è una σ-algebra

\

Gα è una σ-algebra4 .

Sia {Gα , α ∈ Λ} una famiglia di σ-algebre, allora F :=

α∈Λ

2 l’unione di σ-algebre non è (in generale) una σ-algebra

Basta mostrare con un controesempio che l’unione di due σ-algebre non è una σ-algebra: ad esempio se

Gi = {∅, Ai , Aci , Ω}, con A1 ∩ A2 6= ∅, A1 , A2 , allora G1 ∪ G2 = {∅, A1 , A2 , Ac1 , Ac2 , Ω} non è una σ-algebra.

3 la σ-algebra generata da una collezione di eventi

Sia K un sottoinsieme di P(Ω), l’insieme delle parti di Ω, allora

\

σ(K) :=

G:K⊆G

è la σ-algebra5 generata da K.

In particolare quindi la σ-algebra M, generata dalla partizione {Hm ; m ∈ N} come nell’Esempio 1.4, coincide

con σ({Hm ; m ∈ N}), in quanto, come già visto M è una σ-algebra, e inoltre ogni σ-algebra che contenga

{Hm ; m ∈ N}, deve necessariamente contenere tutte le unioni del tipo ∪m∈I Hm .

4 la σ-algebra generata

S da una collezione di σ-algebre

Nel caso in cui K = α∈Λ Gα , dove Gα sono σ-algebre, allora si pone

_

¡ [

¢

Gα := σ

Gα .

α∈Λ

α∈Λ

¡

¢

In particolare se M = σ({Hm ; m ∈ N}) e N = σ {K` ; ` ∈ N} , allora

[

©

ª

M ∨ N = σ({Hm ∩ K` ; m ∈ N, ` ∈ N}) = E =

Hm ∩ K` ; con J ⊆ N × N .

(m,`)∈J

3 La

funzione P : M 7→ [0, 1] definita in (1.9) è una probabilità, infatti

X

P(Ω) =

pm = 1,

m∈N

se An =

[

Hm ∈ M, n ∈ N, con An ∩ An0 = ∅ per n 6= n0 ,

m∈In

allora

[

An =

n∈N

[

e quindi P

n∈N

4 La

[

[

Hm con I =

m∈I

In , e con In ∩ In0 = ∅ per n 6= n0 ,

n∈N

X X

X

X

P An ,

p` =

pm =

An = P A =

`∈I

n∈N m∈In

n∈N

verifica è banale:

Ω ∈ F , in quanto Ω ∈ Gα , per ogni α ∈ Λ;

se A ∈ F , cioè se A ∈ Gα , per ogni α ∈ Λ, allora Ac ∈ Gα , per ogni α ∈ Λ, e quindi Ac ∈ F ;

[

[

An ∈ F ;

An ∈ Gα , per ogni α ∈ Λ, e quindi

se An ∈ F , n ∈ N cioè se An ∈ Gα , per ogni α ∈ Λ, n ∈ N allora

n∈N

5 Il

fatto che

T

G:K⊆G

sia una σ-algebra, deriva dalla proprietà che l’intersezione di σ-algebre è una σ-algebra.

n∈N

4

CP3–1-nov-2009

5 la σ-algebra dei Boreliani Nel caso in cui K = A, la famiglia degli aperti di Rk , allora

B(Rk ) := σ(A)

è detta σ-algebra dei boreliani, o σ-algebra di Borel, ed ogni elemento di I di B(Rk ) è detto boreliano.

1.2

Variabili aleatorie

Definizione 1.1. Dato uno spazio di probabilità (Ω, F, P)6 , una variabile aleatoria reale X è una funzione

F-misurabile, ovvero una funzione

X : Ω 7→ R; ω 7→ X(ω),

tale che la controimmagine di ogni aperto O ∈ A sia un elemento di F 7 , cioè tale che

X −1 (O) := {ω tali che X(ω) ∈ O} ∈ F , per ogni aperto O ∈ A.

Si dice anche che X è una variabile aleatoria F-misurabile.

Una definizione analoga vale nel caso di variabili aleatorie multidimensionali

¡

¢

X : Ω 7→ Rk ; ω 7→ X(ω) = X1 (ω), . . . , Xk (ω) ,

basta infatti sostituire R con Rk .

Vediamo alcuni esempi di variabili aleatorie F-misurabili, al variare della σ-algebra F.

Esempio 1.5. Se F = {∅, Ω}, allora le uniche variabili aleatorie reali X F-misurabili sono le costanti:

Se X : Ω 7→ R; ω 7→ X(ω) = c, allora X −1 (O) è l’evento impossibile(=insieme vuoto ∅), se c ∈

/ O, oppure è l’insieme

certo(=Ω), se c ∈ O.

Viceversa se X : Ω 7→ R; ω 7→ X(ω) non è costante allora X assume almeno due valori c1 e c2 distinti (cioè esistono

ωi tale che X(ωi ) = ci , per i = 1, 2, con c1 6= c2 ). Quindi se c1 ∈ O, ma c2 ∈

/ O, allora ω1 ∈ X −1 (O), mentre

−1

−1

ω2 ∈

/ X (O), ovvero ∅ ⊂ X (O) ⊂ Ω (dove le inclusioni sono in senso stretto), e quindi X non è F-misurabile.

Si noti che l’esempio precedente mostra anche che tutte le variabili aleatorie costanti sono misurabili rispetto a

qualunque σ-algebra ({∅, Ω} ⊆ F, per ogni σ-algebra F).

Esempio 1.6. Sia {Hm , m ∈ N} una partizione numerabile, e sia M come nell’esempio 1.4. Allora X : Ω 7→ R; ω 7→

X(ω) è M-misurabile, se e solo se esiste una successione di costanti {cm , m ∈ N}8 , tale che

X

X(ω) =

cm IHm (ω).

(1.10)

m∈N

Se X è definita come in (1.10) allora X è M-misurabile, infatti per ogni aperto O,

[

X −1 (O) =

Hm ,

m:cm ∈O

S

ovvero X −1 (O) = m∈I Hm ∈ M, per I = {m : cm ∈ O}.

Viceversa se X è M-misurabile, cioè, per ogni aperto O, esiste un I ⊆ N tale che

[

X −1 (O) =

Hm ,

m∈I

6 In realtà basta che ci sia uno spazio probabilizzabile, ovvero basta solo la coppia (Ω, F), mentre non è necessario specificare la misura

di probabilità P.

7 Si noti l’analogia con la definizione di funzione continua f : Rk 7→ Rd , come una funzione tale che le controimmagini di aperti sono

aperti.

8 Si noti che non si assume che i valori di {c } siano tutti distinti, ad esempio nel caso della successione costante, cioè c

m

m = c per ogni

m ∈ N, si trova una variabile aleatoria costante.

CP3–1-nov-2009

5

allora qualunque sia c ∈ R, preso On l’intervallo aperto (c − 1/n, c + 1/n) si ha che

\ [

[

¡ \ n ¢ \ −1 n

X −1 ({c}) = X −1

O =

X (O ) =

Hm =

n

n

n m∈I n

T

m∈

Hm ∈ M,

n

nI

Esempio 1.7. Sia X : Ω 7→ R; ω 7→ X(ω), una funzione discreta, ovvero tale che l’immagine X(Ω) = {x ∈

R, tali che esiste un ω con X(ω) = x} di X sia un insieme numerabile (finito o infinito), cioè X(Ω) = {xm , m ∈ N},

con xn 6= xm per n 6= m. Allora

X

X(ω) =

xm IHm (ω),

(1.11)

m∈N

dove

Hm = X −1 ({xm }) = {ω tali che X(ω) = xm }.

Si noti che {Hm , m ∈ N} forma una partizione numerabile.

Inoltre la funzione X è una variabile aleatoria F -misurabile, se e solo se

Hm = X −1 ({xm }) ∈ F , per ogni m ∈ N,

come è immediato da (1.11), osservando che, come nel caso precedente,

[

X −1 (O) =

Hm .

m:xm ∈O

Infine la variabile aleatoria X si dice semplice o elementare, se l’insieme X(Ω) è un insieme finito.

Si può dimostrare che

1 se X è una variabile aleatoria F-misurabile, allora la controimmagine X −1 (I) ∈ F, per ogni boreliano I ∈ B(R),

2 la variabile aleatoria X è F-misurabile, se e solo se ciascuna componente

Xi è F-misurabile9 , per ogni i = 1, . . . , k.

T

−1

In particolare X ({x}) ∈ F, per ogni x ∈ R, in quanto {x} = n (x − 1/n, x + 1/n).

Connessa con la precedente Definizione 1.1 è la seguente definizione:

¡

¢

Definizione 1.2. Sia data una funzione X : Ω →

7 Rk ; ω 7→ X(ω) = X1 (ω), . . . , Xk (ω) . Si dice σ-algebra

generata da X, la σ-algebra

\

G

σ(X) =

G∈RX

dove RX è la famiglia delle σ-algebre, per le quali X è G-misurabile10 .

Si dimostra che

3 La σ-algebra generata da X, si può caratterizzare come:

σ(X) = {A = X −1 (I), per I ∈ B(Rk )},

4 la funzione X è F-misurabile, se e solo se σ(X) ⊆ F,

5 le variabili aleatorie σ(X)-misurabili a valori in Rd sono tutte e sole le variabili aleatorie Z per le quali esiste

una funzione g boreliana11 tale che

Z = g(X).

9 Dimostriamo

10 La

solo la necessità, che è immediata: basta prendere O = R × · · · × R ×Oi × R × · · · × R.

|

{z

}

|

{z

}

i−1 volte

k−i volte

famiglia RX non è vuota, in quanto contiene almeno G = P(Ω), l’insieme delle parti di Ω.

11 Una funzione g : Rk 7→ Rd , si dice boreliana se è una funzione tale che le controimmagini di aperti sono boreliani.

Ovviamente le funzioni continue sono boreliane. Sono boreliane anche le funzioni continue a tratti, o meglio ancora costanti a tratti.

Per chi non avesse familiarità con i concetti di misurabilità può pensare a queste funzioni, o a funzioni che siano limite puntuale di funzioni

di uno dei due tipi precedenti.

6

CP3–1-nov-2009

Esempio 1.8. Sia X una funzione semplice, come in Esempio 1.7, allora

[

σ(X) = σ({Hm , m ∈ N}) = {A =

Hm ; I ⊆ N},

m∈I

dove Hm = X −1 ({xm }).

Inoltre tutte e sole le variabili aleatorie σ(X)-misurabili sono le funzioni

X

Z : Ω 7→ R; ω 7→ Z(ω) :=

cm IHm ,

m

come discende immediatamente dall’Esempio 1.6. Di conseguenza se g : R 7→ R tale che g(xm ) = cm , per ogni m ∈ N,

allora

X

X

X

¡

¢

Z(ω) :=

cm IHm = Z(ω) =

g(xm )IX −1 ({xm }) (ω) =

g(xm )I{xm } X(ω) = g(X(ω)).

m

m

m

Terminiamo questa sezione, ricordando che le operazioni di massimo, minimo, somma, prodotto, di due funzioni

misurabili, danno luogo a funzioni misurabili: quindi se X ed Y sono variabili aleatorie F-misurabili, lo sono anche

X ∨ Y = max(X, Y ), X ∧ Y = min(X, Y ), X + Y , XY . In particolare sono variabili aleatorie X + := X ∨ 0 e

X − := (−X) ∨ 0.

1.3

Distribuzioni di variabili aleatorie

Sia (Ω, F, P) uno spazio di probabilità e sia

X : Ω 7→ Rk ; ω 7→ X(ω)

una variabile aleatoria a valori in Rk . Tramite X è possibile definire una misura di probabilità PX sullo spazio

misurabile (Rk , B(Rk )) nel seguente modo:

¡

¢

PX : B(Rk ) 7→ [0, 1] I 7→ PX (I) := P X ∈ I .

È facile verificare che effettivamente PX definisce una probabilità sui boreliani B(Rk ). La misura di probabilità cosı̀

definita è detta misura di probabilità indotta da X, o distribuzione di X.

A volte,¡ per indicare

misura

di probabilità indotta, si usa il simbolo PX −1 , che nasce dall fatto che

¢

¡ la

¢

−1

PX (I) := P X ∈ I = P X (I) . Nel seguito, a volte useremo anche il simbolo µX per indicare la distribuzione di

probabilità di X.

Come è noto, associata alla variabile aleatoria X c’è anche la funzione di distribuzione12

¡

¢

FX (x) := P(ω ∈ Ω : X(ω) ≤ x) = PX (−∞, x] ,

x ∈ Rk .

(1.12)

La funzione di distribuzione gode di alcune proprietà caratterizzanti13 :

Proprietà delle funzioni di distribuzione

0 FX (x) ∈ [0, 1]

1 La funzione FX è continua dall’alto14 , nel senso che, per ogni x ∈ Rk si ha

lim FX (y1 , · · · , yi , · · · , yk ) = F (x1 , · · · , xi , · · · , xk ),

y&x

dove y & x significa yi → x+

i , per ogni i = 1, · · · , k.

12 Si

ricordi che, per k ≥ 1, l’evento e l’insieme nella (1.12) sono rispettivamente

{ω ∈ Ω : X(ω) ≤ x} = {ω ∈ Ω : X1 (ω) ≤ x1 , · · · , Xk (ω) ≤ xk }

13 Si

veda la sezione 2.1

caso k = 1 la proprietà 1 corrisponde alla continuità da destra.

14 Nel

e

(−∞, x] = (−∞, x1 ] × · · · × (−∞, xk ].

CP3–1-nov-2009

7

2 La funzione FX (x) è monotona non decrescente.

3 Siano a = (a1 , · · · , ak ) e b = (b1 , · · · , bk ), si definisca

∆(a, b) = {x ∈ Rk : ∀i = 1, · · · , k, si ha xi = ai oppure xi = bi },

e si definisca na (x) il numero di i tali che xi = ai , per x ∈ ∆(a, b).

Se ai ≤ bi , per ogni i = 1, · · · , k, allora15

X

(−1)na (x) FX (x) ≥ 0.

x∈∆(a,b)

4 Per ogni x ∈ Rk e per ogni i = 1, · · · , k si ha che

lim FX (x1 , · · · , xi−1 , yi , xi+1 , · · · , xk ) = 0.

yi →−∞

Inoltre

lim

|x|→+∞

FX (x1 , · · · , xi−1 , xi , xi+1 , · · · , xk ) = 1.

È importante sottolineare che la funzione di distribuzione FX individua la misura di probabilità indotta PX sulla

famiglia (di boreliani)

(−∞, b] := {x ∈ Rk : xi ≤ bi }

con b = (b1 , · · · , bk ) ∈ Rk .

Questa famiglia ha la proprietà di essere chiusa rispetto all’intersezione finita:

(−∞, b] ∩ (−∞, b0 ] = (−∞, b ∧ b0 ],

dove b ∧ b0 := (b1 ∧ b01 , · · · , bk ∧ b0k ).

Ciò è sufficiente a individuare la misura di probabilità indotta, grazie a un risultato molto utile di teoria della

misura:

Lemma 1.1 (Lemma di Dynkin, Billingsley 1984 [1]). Sia A una famiglia di eventi che genera la σ-algebra G e che

è chiusa rispetto alla intersezione finita (cioè: A, B ∈ A implica A ∩ B ∈ A). Se due misure di probabilità ν e µ

coincidono su A, allora le due misure coincidono su G = σ(A).

Definizione 1.3 (variabili aleatorie con densità discreta). Si dice che una variabile aleatoria elementare X ha densità

discreta

µ

¶

x1 x2 · · · · · · xm

p1 p2 · · · · · · pm

dove x1 , x2 , · · · xm sono elementi di Rk e p1 , p2 , · · · pm sono numeri reali tali che

pj ≥ 0

per ogni j = 1, 2, · · · , m,

m

X

pj = 1,

j=1

15 Nel

caso k = 1, la proprietà 3 corrisponde alla proprietà di monotonia 2:

se a ≤ b

allora

FX (a) ≤ FX (b).

Nel caso k = 2, invece la proprietà 3 diviene:

se a1 ≤ b1 e a2 ≤ b2

allora

FX (b1 , b2 ) − FX (a1 , b2 ) − FX (b1 , a2 ) + FX (a1 , a2 ) ≥ 0.

Per k ≥ 2 la proprietà 3 non si riduce alla proprietà di monotonia 2, come mostra il seguente controesempio:

(

0 se x < 0, oppure se x + y < 1,

oppure se y < 0.

F (x1 , x2 ) =]

1 se x ≥ 0, y ≥ 0, e x + y ≥ 1

Si vede facilmente che F è una funzione monotona. Tuttavia F non soddisfa la proprietà 3, infatti

F (1, 1) − F (1, 0) − F (0, 1) + F (0, 0) = 1 − 1 − 1 + 0 = −1.

8

CP3–1-nov-2009

se, per ogni boreliano I, vale

m

X

PX (I) := P(X ∈ I) =

pj .

j=1

xj ∈I

In particolare quindi il significato di pj è chiaro, essendo

P(X = xj ) = pj .

La definizione è analoga nel caso di variabili aleatorie discrete, la cui distribuzione viene caratterizzata attraverso una

densità discreta su un insieme numerabile {xk , k ≥ 1}

µ

¶

x1 x2 · · · · · · xm xm+1 · · ·

p1 p2 · · · · · · pm pm+1 · · ·

Esempio 1.9 (variabili aleatorie con distribuzione binomiale). Ogni variabile aleatoria X per la quale

n µ ¶

X

n h

PX (I) :=

p (1 − p)n−h

h

h=0

h∈I

viene detta una variabile aleatoria binomiale di parametri n e p e si scrive in breve X ∼ Bin(n, p).

Definizione 1.4 (variabili con densità). Sisupponga di avere una funzione f : Rk 7→ R con le proprietà:

Z

f (x) ≥ 0 per ogni x ∈ Rk ,

f (x) dx = 1,

Rk

si dice che X ha distribuzione con densità (di probabilità) f se accade che, per ogni boreliano I ∈ B(Rk ),

Z

PX (I) :=

f (x) dx.

I

Esempio 1.10 (distribuzione gaussiana). Come caso particolare si consideri il caso della variabile aleatoria

unidimensionale con densità

(x−µ)2

1

e− 2σ2

f (x) = √

2πσ

dove µ è un numero reale e σ è un numero (strettamente) positivo. Una variabile aleatoria con questa distribuzione è

detta gaussiana o normale di valore atteso (o valore medio) µ e varianza σ 2 . Brevemente si indica X ∼ N (µ, σ 2 ).

Se µ = 0 e σ 2 = 1 si dice che X è una variabile gaussiana (o normale) standard.

Vediamo ora dei semplici esempi di calcolo della distribuzione indotta.

Esempio 1.11 (una variabile aleatoria binomiale). Sia

Ω = {0, 1}N = {ω = (ω1 , ω2 , . . . , ωN ), con ωi ∈ {0, 1}, per i = 1, 2, . . . , N },

sia

F = P(Ω),

l’insieme delle parti di Ω, sia la probabilità definita attraverso la relazione

PN

P({ω}) := p

i=1

ωi

PN

(1 − p)N −

i=1

ωi

,

dove p è un numero fissato con la condizione che p ∈ (0, 1). Sia infine X la variabile aleatoria definita da

X(ω) :=

N

X

i=1

Si vede facilmente che

ωi .

CP3–1-nov-2009

9

• 1 la variabile aleatoria X assume solo i valori {0, 1, . . . N },

• 2 per h ∈ {0, 1, . . . N } si ha16

• 3 per ogni boreliano I

µ ¶

N h

PX (h) := P(X = h) =

p (1 − p)N −h ,

h

N µ ¶

X

N h

p (1 − p)N −h

PX (I) := P(X ∈ I) =

h

h=0

h∈I

Esempio 1.12 (Variabili esponenziali). Sia Ω = (0, 1) F = B(0, 1) e P la misura di Lebesgue su (0, 1). Sia λ > 0 e

X(ω) := − log(1 − ω)/λ. Allora

FX (x) = P(X ≤ x) = mis{ω ∈ (0, 1) : − log(1 − ω) ≤ λ x} = mis{ω ∈ (0, 1) : ω ≤ 1 − e−λ x },

e quindi

(

FX (x) =

0

1 − e−λ x

per x ≤ 0,

per x > 0.

Per il Lemma di Dynkin (Lemma 1.1) sappiamo che la funzione di distribuzione individua univocamente la

distribuzione di X. È quindi facile convincersi che, tale distribuzione coincide con la distribuzione

νλ (dx) = 1(0,∞) (x) λ e−λ x dx,

che è nota come la distribuzione esponenziale di parametro λ.

Sempre nello stesso spazio si può definire la variabile aleatoria

Y (ω) = −

log(ω)

,

µ

dove µ è una costante strettamente positiva. È facile vedere che Y ha distribuzione esponenziale, di parametro µ.

Esempio 1.13. Sempre nello stesso ambito dell’esempio precedente, ci si può chiedere quale sia la distribuzione

congiunta di X e Y , ossia la distribuzione del vettore aleatorio (X, Y ).

Chiaramente, si ha X(ω), Y (ω) > 0 e inoltre

¡

¢

log 1 − e−λ X(ω)

Y (ω) = −

,

µ

come si ottiene subito da

ω = 1 − e−λ X(ω) .

¡

¢

log 1−e−λ x

Di conseguenza, se G := {(x, y) : x > 0, y > 0, ey = −

}, è facile convincersi che

µ

¡

¢³

¡

¢´

PX,Y (I) = νλ πx (G ∩ I) = νµ πy (G ∩ I)

dove πx e πy sono le proiezione sull’asse x e sull’asse y, rispettivamente.

16 L’evento

Ah := {X = h} è rappresentato dall’insieme, di cardinalità

ω

=

h.

La probabilità di ciascuno di questi ω vale quindi

i=1 i

PN

PN

P(ω) = p

i=1

ωi

PN

(1 − p)N −

N

,

h

i=1

ωi

i cui elementi ω = (ω1 , ω2 , . . . , ωN ) hanno la proprietà che

= ph (1 − p)N −h

e la probabilità dell’insieme vale

P(X = h) = P(Ah ) =

X

ω∈Ah

P(ω) =

X

ω∈Ah

ph (1 − p)N −h = |Ah |ph (1 − p)N −h =

N h

ph (1 − p)N −h

10

CP3–1-nov-2009

Esempio 1.14 (trasformazione di Box-Müller). Sia Ω = (0, 1) × (0, 1), con la misura di Lebesgue sui boreliani. Siano

p

X(ω1 , ω2 ) := −2 log ω1 cos(2 π ω2 );

p

Y (ω1 , ω2 ) := −2 log ω1 sin(2 π ω2 );

Si può dimostrare che la distribuzione congiunta di (X, Y ) ammette densità si probabilità

pX,Y (x, y) =

x2

x2

1 − x2 +y2

1

1

2

=√

e

e− 2 √

e− 2

2π

2π

2π

Tale densità caratterizza le variabili aleatorie gaussiane com media nulla e matrice di covarianza l’identità (si veda

l’Appendice 1.6).

A volte, invece di definire lo spazio di probabilità e la variabile aleatoria X ed infine trovare la distribuzione di X,

si può dare direttamente la distribuzione di X. Questo è il caso delle variabili aleatorie che vengono caratterizzate

solo attraverso la densità discreta o con densità (di probabilità).

Più in generale, le distribuzioni si possono specificare solo attraverso la funzione di distribuzione.

Quando si specifica una variabile aleatoria attraverso la sua distribuzione, e ancor di più se invece si specifica solo

una funzione che goda delle proprietà delle funzioni di distribuzione (si veda pag. 6), rimane il dubbio che una tale

variabile aleatoria esista, ovvero che esista uno spazio di probabilità (Ω, F, P) e una variabile aleatoria X. A questo

problema risponde il teorema di Skorohod (vedere Appendice 2.1).

1.4

Valori attesi

In questa sezione ricordiamo come si può definire il valore atteso per variabili aleatorie generali, a partire dalla sua

definizione per variabili aleatorie semplici. Per maggiori approfondimenti si rimanda, ad esempio, al libro di Billingsley

[1] o a quello di Williams [3].

Definizione 1.5 (Valore atteso per variabili semplici). Sia X una variabile aleatoria in (Ω, F, P), non negativa e

semplice, cioè come in Esempio 1.7,

X

X(ω) =

xm IHm (ω), con Hm ∈ F per ogni m ∈ N,

m∈N

allora si definisce

E[X] =

X

xm P(Hm ).

m∈N

Osservazione 1.1. Ogni variabile aleatoria X in (Ω, F, P), non negativa, ammette una successione di variabili

aleatorie Xn , semplici e non negative, tali che

0 ≤ Xn (ω) ≤ Xn+1 (ω),

17

Infatti

e tali che lim Xn (ω) = X(ω).

n→∞

basta prendere

Xn (ω) =

n

n2

−1

X

m=0

n

n2

−1

X

m

m

I

1 m m+1 (X(ω)) + n1[n,∞) (X(ω)),

(n) (ω) + nI (n) (ω) =

n

H

H

m

n

n2

2

2n [ 2n , 2n )

m=0

(1.13)

17 La monotonia della successione delle variabili aleatorie X è evidente:

n

• se Xn (ω) = m/2n , con m < n2n , allora i soli casi possibili sono

Xn+1 (ω) = (2m)/2n+1 = m/2n = Xn (ω),

oppure

Xn+1 (ω) = (2m + 1)/2n+1 = m/2n + 1/2n+1 > Xn (ω);

• se Xn (ω) = n allora Xn+1 (ω) può assumere un valore compreso tra n ed n + 1.

Per la convergenza basta osservare che, qualunque sia ω, pur di prendere n sufficientemente grande e in modo che X(ω) < n, si ha

che

0 ≤ X(ω) − Xn (ω) ≤ 1/2n .

CP3–1-nov-2009

11

dove si è posto

(n)

Hm

= X −1

¡£ m

2n ,

m+1

2n

¢¢

∈ F per 0 ≤ m ≤ n2n − 1,

¡

¢

(n)

Hn2n = X −1 [n, ∞) ,

e, per A ∈ F,

IA (ω) = 1

se

ω∈A

e

IA (ω) = 0

se

x ∈ [a, b)

e

1[a,b) (x) = 0

ω∈

/ A,

ed infine, per a < b numeri reali,

1[a,b) (x) = 1

se

se

x∈

/ [a, b).

È infine interessante notare che, posto bxc la parte intera inferiore18 di x, si può riscrivere nel seguente modo

Xn (ω) =

b2n X(ω)c

∧ n.

2n

Definizione 1.6 (Valore atteso per variabili nonnegative). Sia X una variabile aleatoria in (Ω, F, P), non negativa,

si definisce

E[X] = sup

n

nX

i=1

o

inf X(ω) P(Ai ) al variare tra le partizioni dell’evento certo A1 , · · · , An .

ω∈Ai

Si dimostra che

E[X] = lim E[Xn ],

n→∞

dove {Xn ; n ∈ N} è la successione monotona definita come in (1.13) dell’Osservazione precedente. Il limite esiste ed

è monotono, per la proprietà di monotonia del valore atteso, sulle variabili aleatorie semplici. Si noti bene che tale

limite può valere anche +∞, nel qual caso si dice che la variabile X ha valore atteso infinito.

bn ; n ∈ N} è un’altra successione di variabili aleatorie semplici che converge

Osservazione 1.2. **Ovviamente se {X

bn ] è una successione che converge monotonamente. Si

monotonamente ad X, anche la successione dei valori attesi E[X

può dimostrare che il limite non dipende dalla successione scelta19 ed in particolare coincide con il limite considerato

nella precedente Definizione 1.6.

Arriviamo ora alla definizione generale del valore atteso:

Definizione 1.7 (Valore atteso per variabili generali). Sia X una variabile aleatoria in (Ω, F, P), Siano X + := X ∨0 e

X − := (−X)∨0, le variabili aleatorie non negative, definite alla fine della sezione precedente. Si noti che X = X + −X −

e che invece |X| = X + + X − . Si definisce allora, se ha senso20

E[X] = E[X + ] − E[X − ].

18 La

parte intera inferiore bxc di x è quel numero intero k tale che k ≤ x < k + 1.

ottenere l’unicità del limite basta dimostrare che se {Yn ; n ∈ N} e {Zn ; n ∈ N} sono due successioni di variabili aleatorie

semplici che convergono monotonamente ad X, allora per ogni k si ha

19 **Per

E[Yk ] ≤ lim E[Zn ],

n→∞

da cui si deduce immediatamente che limk→∞ E[Yk ] ≤ limn→∞ E[Zn ]e quindi l’uguaglianza, scambiando il ruolo delle due successioni.

P

Si fissi quindi k e si consideri che, per ipotesi Yk è semplice e che quindi si può scrivere Yk = `i=1 yi IAi , dove Ai = {Yk = yi } (ovviamente `

(n)

ed yi dipendono da k, ma tralasciamo l’indice k per comodità di notazione e perché è inessenziale). Sia ora ε > 0 e Bi

Essendo {Zn ; n ∈ N} una successione monotona si ottiene che

(n)

Bi

= Ai ∩{Zn > yi −ε}.

Inoltre Yk (ω) ≤ X(ω) e Zn (ω) % X(ω) e quindi se ω ∈ Ai ,

S

(n)

ossia se Yk (ω) = yi , allora per un n sufficientemente grande deve valere Zn (ω) > yi − ε e quindi n Bi = Ai . Per la continuità della

(n)

probabilità deve valere allora che P(Bi

E[Zn ] ≥

⊂

(n+1)

Bi

.

) % P(Ai ). Ovviamente si ha

X̀

(n)

(yi − ε)P(Bi )

e quindi

i=1

lim E[Zn ] ≥

n→∞

X̀

(yi − ε)P(Ai ).

i=1

P`

Per l’arbitrarietà di ε si ha allora limn→∞ E[Zn ] ≥ i=1 yi P(Ai ) = E[Yk ].

20 Si considera che la somma E[X + ] − E[X − ] ha senso

1 se E[X + ] < ∞, E[X − ] < ∞, nel qual caso E[X] ∈ R e inoltre si ha anche E[|X|] = E[X + ] + E[X − ] < ∞;

2 se E[X + ] < ∞, E[X − ] = ∞, nel qual caso E[X] = −∞;

3 se E[X + ] = ∞, E[X − ] < ∞, nel qual caso E[X] = +∞;

Il caso che rimane escluso è quindi il caso in cui E[X + ] = ∞, E[X − ] = ∞, del resto si avrebbe la forma indeterminata ∞ − ∞.

12

CP3–1-nov-2009

Se invece di usare la probabilità P si usa la probabilità condizionata ad un evento A, ovvero P(·|A), allora si parla

di valore atteso di X condizionato all’evento A e si usa la notazione

E[X|A].

Ciò significa che, nel caso di una variabile aleatoria semplice

X

X(ω) =

xm IHm (ω), con Hm ∈ F per ogni m ∈ N,

m∈N

si ha

E[X|A] =

X

xm P(Hm |A).

m∈N

**Terminiamo questa sezione ricordando che la definizione di valore atteso di una variabile aleatoria X corrisponde

alla definizione dell’integrale della funzione misurabile X rispetto alla misura P e che per il valore atteso valgono i due

famosi risultati di passaggio al limite sotto il segno di integrale:

Teorema della convergenza monotona:

se Xn sono variabili aletaorie limitate dal basso e che convergono

monotonamente ad X (P − q.c.) allora la successione dei valori attesi E[Xn ] converge monotonamente a E[X].

Teorema della convergenza dominata: se Xn sono variabili aletaorie che convergono ad X P − q.c. e se Y

è una variabile aleatoria tale che |Xn | ≤ Y , con E[Y ] < ∞, allora la successione dei valori attesi E[Xn ] converge a

E[X].

1.4.1

Variabili aleatorie in spazi misurabili

QUESTA SEZIONE SI PUO’ SALTARE Oltre a definire le variabili aleatorie reali o vettoriali si possono definire in

modo naturale anche variabili aleatorie a valori in spazi misurabili.

Definizione 1.8 (variabile aleatoria (o ente alealorio) a valori in (S, S)). Siano (Ω, F) e (S, S) due spazi misurabili.

Una variabile aleatoria a valori in S è una funzione misurabile

X : (Ω, F) → (S, S); ω 7→ X(ω).

In altre parole una funzione da Ω in S e tale che per ogni B ∈ S, la sua controimmagine tramite X appartiene a F,

ossia l’insieme X −1 (B) ∈ F.

Se S è uno spazio metrico (o più in generale uno spazio topologico, allora la sigma-algebra S coincide con la

sigma-algebra dei boreliani, ossia la sigma-algebra generata dagli aperti.

Esempi tipici nascono quando si vogliono trattare i processi aleatori come funzioni aleatorie, ed in particolare a

funzioni aleatorie continue. In tale caso si può prendere, ad esempio, lo spazio delle funzioni continue su [0, T ] a valori

reali. Prendendo poi come sigma-algebra la sigma-algebra dei boreliani, allora si può affermare che funzioni come il

massimo o il minimo, sono variabili aleatorie.

Come si vede, nella definizione di variabile aleatoria non abbiamo neanche nominato la misura di probabilità su

(Ω, F).

1.5

Misura indotta e Cambio di variabile

QUESTO ARGOMENTO E’ SVOLTO QUI IN MODO PIU’ APPROFONDITO CHE A LEZIONE.

Negli Esempi 1.12, 1.13, 1.14 abbiamo trovato le distribuzioni di alcune variabili aleatorie a valori reali o vettoriali.

In termini astratti quello che abbiamo fatto è caratterizzare la misura indotta.

Definizione 1.9 (Misura indotta). Siano (A1 , A1 ) e (A2 , A2 ) due spazi con le rispettive sigma-algebre, e sia

ψ : A1 → A2 , a1 7→ ψ(a1 ) una funzione misurabile (cioè per ogni B2 ∈ A2 si ha che la controimmagine

ψ −1 (B2 ) ∈ A1 ). Supponiamo che su (A1 , A1 ) sia definita una misura µ1 . Allora si definisce misura indotta (da

ψ) la misura

¡

¢

µ2 (B2 ) := µ1 ψ −1 (B2 ) ,

B2 ∈ A2 .

CP3–1-nov-2009

13

Ovviamente perché la precedente definizione sia ben posta bisogna verificare che effettivamente definisca una misura

(questo è un semplice esercizio ed è lasciato al lettore).

¡ Tornando ¢agli Esempi precedentemente citati ed in particolare agli Esempi 1.12, 1.13, in entrambi (A1 , A∞ ) =

(0, 1), B(0, 1) e µ1 = P, la misura di Lebesgue ristretta a (0, 1), mentre A2 = R nel primo esempio e invece A2 = R2 ,

nel secondo esempio. Inoltre nel primo esempio sono state considerate due funzioni ψ1 (ω) = X(ω) = − log(1−ω)

e

λ

log(ω)

ψ2 (ω) = Y (ω) = − ¡ λ , mentre nel secondo esempio

la funzione ψ := (ψ1 , ψ2 ). Nell’Esempio 1.14,

¢ è stata considerata

2

invece (A1 , A∞ ) = (0, 1) × (0, 1), B((0, 1) × (0,

1)

e

A

=

R

e

µ

è

la

misura

di Lebesgue ristretta

a (0, 1) × (0, 1).

2

1

¡√

¢

√

Infine la funzione ψ è definita da ψ(ω1 , ω2 ) =

−2 log ω1 cos(2 π ω2 ), −2 log ω1 sin(2 π ω2 ) .

Più in generale, nel caso di variabili aleatorie X a valori in (S; S), se nello spazio misurabile (Ω, F) è definita una

misura di probabilità P, si definisce legge di X o distribuzione di X, la probabilità PX : S → [0, 1] definita come la

misura indotta da (Ω, F, P) tramite X:

PX (B) := P(X ∈ B),

B ∈ S.

Quello che più ci interessa qui è la formula del cambio di variabile negli integrali, che, nell’ambito del calcolo delle

probabilità, corrisponde alla possibilità di calcolare i valori attesi di funzioni di variabili aleatorie X a valori21 in (S, S)

sia come integrali sullo spazio (Ω, F, P) che come integrali sullo spazio (S, S, PX ).

In tale caso si ottiene che i valori attesi di f (X), per f funzioni misurabili e limitate, si possono calcolare sia come

integrali sulo spazio degli eventi Ω

Z

E[f (X)] =

f (X(ω)) P(dω),

Ω

sia come integrale sullo spazio degli stati S

Z

E[f (X)] =

f (x) PX (dx).

S

Riportiamo qui la dimostrazione nell’ambito astratto della Definizione 1.9 di misura indotta.

¡

¢

¢

Lemma 1.2 (Cambio di variabile). Sia f ∈ Mb (A2 ), ossia una funzione misurabile da A2 , A2 in (R, B(R) e

limitata. Allora

Z

Z

f (a2 )µ2 (da2 ) =

f (ψ(a1 ))µ1 (da1 )

(1.14)

A2

A1

Dimostrazione. Iniziamo con il mostrare che, per definizione di µ2 , (1.14) è valida per f = IB2 , per ogni B2 ∈ A2 :

da una parte

Z

¡

¢

IB2 (a2 )µ2 (da2 ) = µ2 (B2 ) := µ1 ψ −1 (B2 ) ,

A2

dall’altra, tenuto conto che IB2 (ψ(a1 )) = Iψ−1 (B2 ) (a1 ), in quanto ψ(a1 ) ∈ B2 se e solo se a1 ∈ ψ −1 (B2 ),

Z

Z

¡

¢

IB2 (ψ(a1 ))µ1 (da1 ) =

Iψ−1 (B2 ) (a1 )µ1 (da1 ) = µ1 ψ −1 (B2 ) .

A1

A1

La dimostrazione segue poi con una tecnica che è standard nell’ambito della teoria della misura.

Sia H l’insieme delle funzioni f per cui è valida l’uguaglianza (1.14).

L’insieme H verifica le seguenti proprietà:

(i) linearità, ovvero se f , g ∈ H, allora, per ogni a,b ∈ R la funzione a f + b g ∈ H

caso di variabili aleatorie vettoriali lo spazio (S, S) coincide con Rd , B(Rd ) . Ma la formula vale anche per variabil aleatorie

a valori in spazi più generali, come ad esempio gli spazi metrici, prendendo come sigma-algebra la sigma-algebra dei boreliani, ossia la

sigma-algebra generata dagli aperti (in altre parole la più piccola sigma algebra contente gli aperti). Come già detto esempi di tale genere

si incontrano quando ci si interessa di processi aleatori, pensati come variabili aletorie a valori in uno spazio di funzioni, ad esempio lo

spazio delle funzioni continue su un intervallo [0, T ], con la metrica della norma uniforme.

21 Nel

14

CP3–1-nov-2009

(come segue dalla proprietà di linearità per gli integrali rispetto a µ1 )

(ii) la funzione 1, cioè la funzione costante uguale ad 1, appartiene a H

(come segue dall’osservazione iniziale e notando che 1 = IA2 , )

(iii) monotonia, ovvero se fn ∈ H e fn % f , f ∈ M2 (A2 ) allora f ∈ H

(come segue dalla proprietà della convergenza monotona degli integrali rispetto a µ1 )

(iv) per ogni B2 ∈ A2 , la funzione IB2 ∈ H

(come segue immediatamente dalla osservazione iniziale; si noti inoltre che in realtà la (ii) segue da questa proprietà)

Le precedenti proprietà assicurano che H è una classe monotona. Basta allora applicare il teorema delle classi

monotone, che per comodità del lettore riportiamo di seguito.

Teorema 1.3 (Teorema delle classi monotone). Sia (Ω, F) uno spazio misurabile e sia H un insieme di funzioni reali

misurabili e limitate, con le seguenti proprietà:

(i) H è uno spazio vettoriale,

(ii) H contiene la funzione costante 1,

(iii) fn ∈ H, fn % f , f limitata implicano f ∈ H

cioè H è una classe monotona.

Se inoltre H soddisfa anche la seguente proprietà

(iv) H contiene le funzioni del tipo IA per ogni A ∈ A, dove A ⊂ F è un π-sistema, cioè è chiuso per intersezione

finita,

allora H contiene tutte le funzioni limitate e σ(A)-misurabili.

Il precedente Teorema 1.2 si applica anche quando vogliamo calcolare la distribuzione di una trasformazione

di una variabile

ad esempio, se Z è una variabile aleatoria con distribuzione PY ed Z = ϕ(Y ), allora

¡ aleatoria:

¢

PZ (B) = PY ϕ−1 (B) , come è immediato verificare.

Nel caso di variabili aleatorie multivariate, e per funzioni ϕ sufficientemente regolari, si possono ottenere formule

esplicite, utilizzando noti risultati di analisi: ad esempio, se Y ammette densità fY e ϕ è invertibile22 e con derivate

continue, allora anche Z ammette densità e si ha

¯

µ −1 ¶¯

¯

∂ϕ (z) ¯¯

1

³

´¯

fZ (z) = fY (ϕ−1 (z)) ¯¯det

= fY (ϕ−1 (z)) ¯¯

.

¯

∂ϕ(y) ¯

∂z

¯det ∂y ¯

−1

y=ϕ

(z)

Particolarmente semplice è il caso di trasformazioni lineari (o affini) in cui lo Jacobiano è il determinante della

matrice. Ad esempio se Z = AY , con A invertibile, allora ϕ−1 (z) = A−1 z e la formula precedente diviene

fZ (z) = fY (A−1 (z))

1

.

|det(A)|

Esempio 1.15. Un esempio di trasformazione che incontreremo spesso nel seguito è il caso in cui Y = (Y1 , Y2 , · · · , Ym )

e

Z1 = Y1 ,

Z2 = Y1 + Y2 ,

···

Zm = Y1 + Y2 + · · · + Ym ,

ossia z = ϕ(y) = A y, con

1

1

Allora la matrice A è la matrice triangolare A =

1

· · ·

1

22 In

z1 = y1 ,

z2 = y1 + y2 ,

0

1

1

···

1

0

0

1

···

1

···

···

···

···

···

···

zm = y1 + y2 + · · · + ym .

0

0

0

con determinante uguale ad 1.

· · ·

1

realtà basta che esista un aperto O, tale che la densità fY (y) = 0 per y ∈

/ A e tale che ϕ sia invertibile da O a ϕ(O,

CP3–1-nov-2009

15

La trasformazione inversa è

y1 = z1 ,

y2 = z2 − z1 ,

ossia y = ϕ−1 (z) = A−1 y dove A−1

···

ym = zm − zm−1 ,

1

0

0

−1 1

0

=

0 −1 1

· · · · · · · · ·

0

0

0

··· 0

··· 0

··· 0

· · · · · ·

−1 1

per cui, se Y ammette densità di probabilità,

fZ (z1 , z2 , · · · , zm ) = fY (z1 , z2 − z1 , · · · , zm − zm−1 ).

Il caso m = 2 è particolarmente interessante in quanto permette di ricavare la densità della somma di due variabili

aleatorie, semplicemente calcolando la densità marginale di Z2 = Y1 + Y2 : per z ∈ R

Z

³

´ Z

0

0

fY1 +Y2 (x) = fZ2 (x) =

fZ1 ,Z2 (x, x ) dx =

fY1 ,Y2 (x, x0 − x) dx0 .

R

R

16

CP3–1-nov-2009

1.6

Variabili gaussiane

QUESTO ARGOMENTO DOVREBBE ESSERE GIA’ STATO SVOLTO IN ALTRO CORSO, ALMENO IN

PARTE...

Cominciamo con il definire una variabile aleatoria gaussiana standard unidimensionale:

Definizione 1.10. Si dice che una variabile aleatoria reale Z è gaussiana di valore atteso µ e varianza σ 2 , se

ammette densità

(

µ

¶2 )

1

1 x−µ

.

fZ (z) = √ exp −

2

σ

2π

In questo caso si usa la notazione Z ∼ N (µ, σ 2 ). Se µ = 0 e σ 2 = 1 allora si dice che Z segue una legge normale

o gaussiana standard.

Caso n−dimensionale: iniziamo con il caso di un vettore (colonna) aleatorio

Y1

Y2

· · ·

Y =

Yk

· · ·

Yn

a componenti indipendenti e tutte gaussiane standard, ovvero il caso in cui

½

¾

1

1

√ exp − yi2

2

2π

i=1

i=1

(

)

½

¾

n

1

1X 2

1

1 0

= √

exp −

=

y

exp − y y .

2 i=1 i

2

(2π)n/2

( 2π)n

fY (y) =

n

Y

fYi (yi ) =

n

Y

dove l’apice indica l’operazione di trasposizione, ovvero y 0 è il vettore riga (y1 , y2 , · · · , yn ).

È immediato verificare che E(Yi ) = 0, V ar(Yi ) = 1 e che Cov(Yi , Yj ) = 0, per i 6= j.

Sia ora A una matrice non singolare e sia m un vettore (colonna). Definiamo ora Z = AY + m e cerchiamo la

sua densità. Sappiamo dai risultati generali che se Y ammette densità e Z = ϕ(Y ) con ϕ invertibile e con derivate

continue, allora anche Z ammette densità:

¯

µ −1 ¶¯

¯

∂ϕ (z) ¯¯

1

−1

¯

³

´¯

fZ (z) = fY (ϕ (z)) ¯det

= fY (ϕ−1 (z)) ¯¯

¯

¯

∂ϕ(y)

∂z

¯det ∂y ¯

−1

y=ϕ

di conseguenza, poiché nel nostro caso ϕ(y) = Ay + m e ϕ−1 (z) = A−1 (z − m)

¾

½

¢0

1

1

1¡

fZ (z) = √ n exp − A−1 (z − m) A−1 (z − m)

.

2

|det(A)|

2π

Essendo

(A−1 (z − m))0 A−1 (z − m) = (z − m)0 (A−1 )0 A−1 (z − m)

= (z − m)0 (A0 )−1 A−1 (z − m) = (z − m)0 (AA0 )−1 (z − m)

si ottiene

fZ (z) =

½

¾

1

1

1

0

0 −1

exp

−

(z

−

m)

(AA

)

(z

−

m)

.

2

(2π)n/2 |det(A)|

La precedente espressione si basa sulle seguenti proprietà:

(z)

CP3–1-nov-2009

17

(A0 )−1 = (A−1 )0

(i)

in quanto

A0 z = w ⇔ z = (A0 )−1 w

e inoltre

0

A0 z = w ⇔ (z 0 A) = w ⇔ z 0 A = w0 ⇔ z 0 = w0 A−1

¡

¢0

¡

¢0

⇔ z = w0 A−1 ⇔ z = A−1 w.

(AA0 )

(ii)

−1

−1

= (A0 )

A−1

in quanto

(AA0 )

−1

−1

z = w ⇔ z = AA0 w ⇔ A−1 z = A0 w ⇔ (A0 )

A−1 z = w.

È interessante notare che sia il vettore m che la matrice AA0 = A0 A hanno una interpretazione probabilistica:

E(Zi ) = E(

n

X

ai,k Yk ) + mi =

k=1

n

X

ai,k E(Yk ) + mi = mi

k=1

Cov(Zi , Zj ) = E[(Zi − mi )(Zj − mj )] = E[

n

X

ai,k Yk

k=1

n

X

aj,h Yh ] =

h=1

n X

n

X

ai,k aj,h E[Yk Yh ]

k=1 h=1

e quindi

Cov(Zi , Zj ) =

n

X

k=1

ai,k aj,k E[Yk Yk ] +

1,n

n X

X

ai,k aj,h E[Yk Yh ] =

k=1 h6=k

n

X

ai,k aj,k = (AA0 )i,j

k=1

Si osservi che se Z = (Z1 , ..., Zn ) è un vettore gaussiano allora (Z1 ...Zk ) e (Zk+1 , ..., Zn ) sono indipendenti, se e

solo se Cov(Zi , Zh ) = 0 per ogni i = 1, · · · , k e h = k + 1, · · · , n. In tale caso allora è ovvio che il vettore (Z1 ...Zk ) è

un vettore gaussiano23

Terminiamo questo paragrafo con il ricordare quanto valgono i momenti di una variabile aleatoria gaussiana.

Sia Z una variabile aleatoria N (0, σ 2 ). Per quanto visto prima possiamo considerare Z = σY con Y una variabile

aleatoria N (0, 1). Da questa osservazione segue subito che

E[Z k ] = σ k E[Y k ]

e

E[|Z|k ] = |σ|k E[|Y |k ].

23 Per ottenere lo stesso risultato nel caso generale, ovvero che se Z = (Z , ..., Z ) è un vettore gaussiano allora (Z ...Z ) è un vettore

n

1

1

k

gaussiano, si può procedere nel seguente modo. Innanzitutto basta considerare il caso in cui i valori attesi sono nulli senza ledere in

0

0

0

generalità. Inoltre si può pensare che Z = AY . Se la matrice A = (aij ) è definita in modo che aij = aij qualunque siano i = 1, ...k e

j = 1, ...., n, e il vettore aleatorio Z 0 è definito da

Z 0 = A0 Y ,

allora, chiaramente,

Se inoltre

0

(Zk+1

,···

a0hj per h = k + 1, ...n e j

0 ), ovvero in modo che

, Zn

Zi0 = (A0 Y )i = Zi = (AY )i ,

per i = 1, ...k.

= 1, ...., n sono presi in modo che il vettore (Z10 , · · · , Zk0 ) = (Z1 , ·, Zk ) sia indipendente dal vettore

0 = E[Zi Zh0 ] = Cov(Zi , Zh0 ) =

n

X

ai,` a0h,`

`=1

per i = 1, ...k e h = k + 1, ...n, allora si ottiene il risultato voluto.

Nel caso in cui la matrice A sia non singolare ciò è sempre possibile perché i vettori a(i) = (ai1 , ai2 , · · · , ain ) sono linearmente indipendenti

e quindi basta trovare n − k vettori a0(h) = (a0i1 , a0h2 , · · · , a0hn ) ortogonali allo spazio vettoriale k-dimensionale span(a(i) , i = 1, ·, k).

18

CP3–1-nov-2009

Vale poi la pena di ricordare che

E[Y 2k+1 ] = 0,

E[Y 2k ] = (2k − 1)!! = (2k − 1)(2k − 3) · · · 5 · 3 · 1,

mentre24 infine

r

E[|Y |

2k+1

]=

2

(2k)!! =

π

r

2

(2k)(2k − 2) · · · 4 · 2 =

π

r

2 k

2 k!.

π

Prima di dimostrare queste tre uguaglianze si osservi che le ultime due si possono scrivere in modo sintetico come

r

2

E[|Y |n ] = C((−1)n ) (n − 1)!!

.

C(+1) = 1

C(−1) =

π

La prima relazione è banale, per ragioni di simmetria, e permette di ricavare la seconda osservando che

E[euY ] = e

u2

2

=

∞

∞

h

X

X

1 u2

1 u2h

=

.

h! 2

h! 2h

h=0

h=0

e d’altra parte, essendo appunto ovviamente E[Y 2k+1 ] = 0,

E[euY ] = E[

∞

∞

X

X

1 k k

1

u Y ]=

u2h E[Y 2h ]

k!

(2h)!

k=0

h=0

si deve necessariamente avere che i coefficienti delle due serie devono coincidere:

1 1

1

=

E[Y 2h ],

h

h! 2

(2h)!

ovvero

(2h)!

2h(2h − 1)(2h − 2)(2h − 3) · · · 3 · 2 · 1

=

h

h!2

h(h − 1) · · · 3 · 2 · 1 · 2h

(2h)!!(2h − 1)!!

2h h! · (2h − 1)!!

=

=

= (2h − 1)!!.

h

h!2

2h h!

E[Y 2h ] =

q

Infine la terza si ricava per integrazione per parti e calcolando a mano che E[|Y |] =

2

π.

Concludiamo questo paragrafo con un lemma che riguarda il comportamento asintotico della funzione di

sopravvivenza di una gaussiana standard e del modulo di una gaussiana standard.

Lemma 1.4. Sia Y una gaussiana standard, allora, posto fY (y) =

2

y

√1 e− 2

2π

, si ha, per x > 0,

µ

¶−1

1

1

x+

fY (x) ≤ P(Y > x) ≤ fY (x),

x

x

µ

¶−1

1

1

x+

f|Y | (x) ≤ P(|Y | > x) ≤ f|Y | (x),

x

x

P(|Y | > x) ≤ e−

24 Si

x2

2

,

noti che dalle ultime due relazioni sui momenti si ottiene che

E[|Y |m ] = (m − 1)!!C(−1)m ,

r

con C+1 = 1, C−1 =

x > 0,

(1.15)

x > 0,

(1.16)

x > 0.

(1.17)

2

.

π

CP3–1-nov-2009

19

Dimostrazione. La disuguaglianza (1.16) discende immediatamente dalla prima disuguaglianza (1.15), la quale equivale

a

µ

¶−1

x2

x2

1

1

1 1

√ e− 2 ≤ P(Y > x) ≤ √ e− 2 ,

x+

x

x

2π

2π

e discende dalla seguente relazione

µ

¶−1

Z +∞

w2

z2

1

1 − w2

w+

e− 2 ≤

e− 2 dz ≤

e 2 ,

w

w

w

w > 0.

(1.18)

La disuguaglianza destra della (1.18) discende da

Z

+∞

e−

z2

2

w

Inoltre

dz ≤

1

w

Z

+∞

z e−

z2

2

dz =

w

1 − w2

e 2 ,

w

µ

¶

w2

d 1 − w2

1

2

e

= − 1 + 2 e− 2

dw w

w

e quindi

1 − w2

e 2 =

w

Z

+∞

w

µ

µ

¶

¶ Z +∞

z2

z2

1

1

1 + 2 e− 2 dz ≤ 1 + 2

e− 2 dz ,

z

w

w

che prova l’altra disuguaglianza nella (1.18).

Infine, per provare la disuguaglianza (1.17), basta osservare che,

Z

x

= 2e

Z +∞

y2

y 2 −x2

x2

1

1

√ e− 2 dy = 2 e− 2

√ e− 2 dy

2π

2π

x

Z +∞

Z +∞

2

(y+x)(y−x)

(z+2x)z

1

1

− x2

2

√ e−

√ e− 2 dz

dy = 2 e

2π

2π

x

0

Z +∞

x2

1 − z2

√ e 2 dz = e− 2 .

2π

0

+∞

P(|Y | > x) = 2

2

− x2

≤ 2 e−

x2

2

(essendo x > 0,)

Capitolo 2

Costruzione di variabili aleatori in (0, 1)

2.1

Teorema di rappresentazione di Skorohod

In questa sezione affrontiamo il problema seguente:

Data una funzione F , esiste uno spazio di probabilità (Ω, F, P) e una variabile aleatoria X, definita su questo

spazio, per la quale F è la funzione di distribuzione, cioè F = FX ?

Chiaramente F deve soddisfare le proprietà delle funzioni di distribuzione, (ossia le proprietà 0 − 4 di pagina 6).

Si può dimostrare che tali proprietà sono sufficienti a individuare una misura di probabilità µ = µF sui boreliani di

Rk , per la quale F (x) = µ(−∞, x]. Di conseguenza si può prendere come spazio di probabilità (Rk , B(Rk ), µF ) e come

variabile aleatoria l’identità, ossia X(x1 , · · · , xk ) = (x1 , · · · , xk ).

Tuttavia c’è un altro spazio in cui costruire tale variabile aleatoria, lo spazio (0, 1) con la misura di Lebesgue sui

boreliani di (0, 1).

In questa sezione ci limitiamo al caso unidimensionale, il caso a più dimensioni (e addirittura per successioni di

variabili aleatorie viene brevemente considerato nella sottosezione ??).

Teorema 2.1 (di rappresentazione di Skorohod). Sia data una funzione F , che verifica le seguenti proprietà:

P0 F è a valori in [0, 1];

P1 F è non decrescente;

P2 F è continua a destra, cioè, per ogni t ∈ R,

P3 F è normalizzata, cioè

lim F (t + ε) = F (t);

ε→0+

lim F (t) = 0; lim F (t) = 1.

t→−∞

t→+∞

Sia ϕ : (0, 1) → R definita da

ϕ(u) := inf{y : F (y) ≥ u}.

Allora ϕ è boreliana, inoltre la variabile aleatoria

X : (0, 1) →

ω 7→

R

X(ω) = ϕ(ω)

definita nello spazio di probabilità (Ω, F, P) ≡ ((0, 1), B(0, 1), λ) con λ la misura di Lebesgue, ha funzione di

distribuzione F , ovvero FX (x) = F (x).

Dimostrazione. La dimostrazione è basata sul fatto che

{u ∈ (0, 1) : ϕ(u) ≤ x} = {u ∈ (0, 1) : u ≤ F (x)}

per ogni x ∈ R. Dalla precedente affermazione segue infatti che:

20

(2.1)

CP3–1-nov-2009

21

(i) ϕ è misurabile rispetto a B(0, 1);

(ii) Per ogni x ∈ R risulta

FX (x) = P(ω ∈ Ω : X(ω) ∈ (−∞, x]) = λ({u ∈ (0, 1) : ϕ(u) ≤ x})

= λ({u ∈ (0, 1) : u ≤ F (x)})

λ ((0, F (x)]) , se F (x) < 1,

= λ ((0, 1) ∩ (−∞, F (x)]) =

λ(0, 1),

se F (x) = 1,

(per definizione di X e di (Ω, F, P ))

(per l’affermazione (2.1))

ovvero

FX (x) = F (x).

Si tratta dunque di provare l’affermazione (2.1). Dimostriamo innanzitutto che

ϕ(u) = min{y : F (y) ≥ u},

cioè

F (ϕ(u)) ≥ u.

(2.2)

Infatti, essendo ϕ(u) = inf{y : F (y) ≥ u}, esiste una successione {yn }∞

n=0 tale che:

(a) F (yn ) ≥ u per ogni n, e quindi yn ≥ ϕ(u),

(b) {yn } tende a ϕ(u) per n → ∞.

Allora, poiché F è continua a destra,

F (ϕ(u)) = lim F (yn ) ≥ u.

n→∞

Possiamo ora mostrare l’uguaglianza in (2.1)

• Prima facciamo vedere che {u ∈ (0, 1) : ϕ(u) ≤ x} ⊆ {u ∈ (0, 1) : u ≤ F (x)}, mostrando che, per ogni u in (0, 1)

se ϕ(u) ≤ x

allora

u ≤ F (x).

E infatti, poiché F è non decrescente, se ϕ(u) ≤ x, allora F (ϕ(u)) ≤ F (x) e quindi per la (2.2)

u ≤ F (ϕ(u)) ≤ F (x).

• Proviamo ora l’inclusione opposta {u ∈ (0, 1) : ϕ(u) ≤ x} ⊇ {u ∈ (0, 1) : u ≤ F (x)}, mostrando che, per ogni u

in (0, 1),

se u ≤ F (x),

allora

ϕ(u) ≤ x.

Infatti, se u ≤ F (x), allora x ∈ {y : F (y) ≥ u} e quindi inf{y : F (y) ≥ u} ≤ x, cioè ϕ(u) ≤ x.

Prima di terminare la dimostrazione lasciamo al lettore il compito di osservare che fino ad ora non abbiamo

(esplicitamente) usato la proprietà P3 di normalizzazione. Tuttavia tale proprietà serve per garantire che la funzione

ϕ sia a valori reali.

Dall’affermazione (2.1) segue anche il seguente Corollario.

Corollario 2.2. Sia U una v.a. uniformemente distribuita1 in (0, 1). Allora X := ϕ(U ) ha distribuzione F

1 Ricordiamo

che U ∼Unif(0, 1) è una v.a. che ha densità

f (t) :=

che è la derivata della funzione

1,

0,

0<t<1

altrove

8

< 0,

t,

F (t) ≡ FU (t) =

:

1,

Per una funzione con questa densità vale

Z

t<0

0≤t≤1

t>1

b

P(U ∈ [a, b]) =

dt = b − a

a

quantità che dipende solo dall’ampiezza dell’intervallo, il che spiega la dizione uniforme

22

CP3–1-nov-2009

Dimostrazione. Infatti

P(X ≤ x) = P(ϕ(U ) ≤ x) = P(U ∈ {u ∈ (0, 1) : ϕ(u) ≤ x})

= P(U ∈ {u ∈ (0, 1) : u ≤ F (x)}) = F (x).

(per l’affermazione (2.1))

poiché U ∼Unif(0, 1)

e è crescente:

Sempre la stessa proprietà (2.1) ci garantisce che la funzione X

e Sia ω ≤ ω 0 , vogliamo mostrare che X(ω)

e

e 0 ).

Osservazione 2.1 (Crescenza di X).

= min{x : F (x) ≥ ω} ≤ X(ω

e 0 ) = min{x : F (x) ≥ ω 0 } e quindi si ha che

La relazione (2.1) garantisce che X(ω

¡

¢

e 0 ) ≥ ω0 .

F X(ω

Quindi (in quanto ω ≤ ω 0 )

¡

¢

e 0 ) ≥ ω 0 ≥ ω,

F X(ω

e 0 ) ∈ {x : F (x) ≥ ω} da cui

e cioè X(ω

e

e 0 ).

X(ω)

= min{x : F (x) ≥ ω} ≤ X(ω

Osservazione 2.2 (spazi completi). Terminiamo questa sezione con una osservazione importante, che riguarda la

possibilità di considerare spazi di probabilità completi, cioè di spazi che contengono anche gli insiemi trascurabili

N = {A ⊂ Ω : ∀²∃B² ∈ F, tale che A ⊆ B² , e P(B² ) ≤ ²},

ossia i sottoinsiemi degli insiemi di misura nulla: infatti, se A è trascurabile allora esiste una successione di eventi

B1/n tali che, per ogni n, B1/n contiene A e con probabilità minore uguale a 1/n. Non si lede in generalità a supporre

che B1/n sia una successione monotona. Di conseguenza A ⊆ B := ∩∞

n=1 B1/n e P(B) = 0.

È noto che la misura di Lebesgue si può costruire (estendendo la misura definita sull’algebra delle unioni finite di

intervalli) su spazi completi, e sulla σ-algebra L(0, 1) degli insiemi Lebesgue misurabili, che è appunto il completamento

della σ-algebra B(0, 1) dei boreliani. Tutte le funzioni boreliane sono ovviamente L-misurabili (cioè misurabili secondo

Lebesgue).

Quindi

la variabile

aleatoria definita

nel teorema di Skorohod è ancora misurabile se consideriamo

¡

¢

¡

¢

(0, 1), L(0, 1), λ , invece di (0, 1), B(0, 1), λ , e quindi possiamo affermare che il teorema di Skorohod assicura che,

data F che soddisfa le proprietà P0 - P3 esiste uno spazio completo, dove è possibile definire una variabile aleatoria

X con FX = F .

CP3–1-nov-2009

2.2

23

Costruzione di una succesione di variabili aleatorie indipendenti

L’affermazione che una successione di variabili aleatorie {Xn , n ∈ N} è una successione di v.a. indipendenti con

µXn = µn , è un’affermazione che riguarda le distribuzioni finito dimensionali del processo {Xn , n ∈ N}. L’esistenza

di una tale successione si potrebbe quindi dedurre dal teorema di rappresentazione di Kolmogorov, o magari da un

risultato ad hoc la cui prova fosse la semplificazione del procedimento usato nel dimostrare tale teorema. Tuttavia

l’esistenza di una tale successione tuttavia si può dedurre direttamente, pur di dare per scontato che esiste la misura di

Lebesgue su (0, 1). Infatti su (0, 1) si possono definire delle variabili aleatorie indipendenti ed identicamente distribuite,

a valori nell’insieme {0, 1}, e che assumono il valore 0 con probabilità 1/2 (lo stesso vale per il valore 1). A partire da

questa successione di variabili aleatorie si può costruire una successione di variabili

aleatorie

{Uj , j ∈ N} indipendenti

¡

¢

ed uniformi in (0, 1), come descritto qui di seguito. Infine, posto Fn (x) = µn (−∞, x] , la successione cercata è data

dalla successione delle v.a. Fn−1 (Un ).

Lemma 2.3 (Successioni di v.a. indipendenti uniformi in (0, 1): esistenza). Nello spazio Ω = (0, 1) con la misura di

Lebesgue sui boreliani, è possibile avere una successione di v.a. uniformi in (0, 1) ed indipendenti.

Per costruire tale successione si ricordi che scrivendo ω ∈ (0, 1) in forma diadica

ω=

∞

X

Wi (ω)

1

1

,

2i

le v.a. Wi risultano indipendenti e P(Wi = 0) = P(Wi = 1) = 21 . La successione Un di v.a. uniformi ed indipendenti si

fi,n } cosı̀

può costruire, a partire dalle v.a. {Wi }, riordinandole in modo che formino una sequenza a doppio indice {W

da poter definire

∞

X

fi,n (ω) 1 .

Un (ω) =

W

2i

i=0

fi,n = W2i−1 (2n+1) , che corrisponde a riordinare la successione {Wi } in questo modo:

Ad esempio si può prendere W

W1

W2

W4

W8

..

.

W3

W6

W12

W24

..

.

W5

W10

W20

W40

..

.

W7

W14

W28

···

W9

···

···

···

ottenendo da {Wi } infinite sottosuccessioni (corrispondenti alle colonne di questa matrice) in modo tale che nessuna

Wi venga tralasciata né ripetuta.

****

fi,n , i ≥ 1), e che

Rimane da osservare che, per ogni n, la variabile aleatoria Un è misurabile secondo Fen := σ(W

tali sigma algebre sono indipendenti2 . Quindi le variabili aleatorie Un formano una succesione di variabili aleatorie

indipendenti.

fk,n , k ≥ 1, esattamente come la variabile

Inoltre poiché le variabili aleatorie Un (ω) sono definite attraverso le W

fk,n ,

aleatoria U (ω) = ω è costruita attraverso le Wk (ω), k ≥ 1, e, per ogni n, la successioni di variabili aleatorie W

k ≥ 1 è una successione di variabili aleatorie indipendenti identicamente distribute (esattamente come Wk (ω), k ≥ 1)

anche la legge di Un è la stessa di U e cioè uniforme su (0, 1).

Osservazione 2.3. **Ribadiamo che la precedente costruzione è riportata affinché sia chiaro che l’affermazione che

esiste una successione di v.a. indipendenti ed uniformi in (0, 1), è vera.

A questo punto, data una successione di funzioni di distribuzione Fn , per costruire

¡ una successione di¢ variabili

aleatorie indipendenti Yn e con funzione di distribuzione Fn , basta mettersi nello spazio (0, 1), B(0, 1), λ|(0,1) , definire

¡

¢

Yn (ω) = ϕFn Un (ω) ,

2 Si

confronti il Corollario 2 pag. 50 di [1] oppure, meglio il Teorema 20.2 pag. 268.

24

CP3–1-nov-2009

dove le Un sono le variabili aleatorie definite sopra, e infine usare il Corollario 2.2, per ottenere che Yn ha funzione di

distribuzione FYn = Fn , e infine, grazie all’osservazione che Yn è misurabile rispetto alla sigma algebra generata da

Un , dedurre che le Yn formano una successione di variabili aleatorie indipendenti.

CP3–1-nov-2009

2.3

25

Convergenza per variabili aleatorie

Esistono vari tipi di convergenza per variabili aleatorie. Noi ci occuperemo principalmente di tre tipi di convergenza:

1 CONVERGENZA QUASI CERTA

mettere definizione

2 CONVERGENZA IN PROBABILITÀ

mettere definzione

3 CONVERGENZA IN LEGGE O IN DISTRIBUZIONE (DETTA ANCHE DEBOLE)

mettere definizione

Valgono le seguenti implicazioni

Xn −→ X

n→∞

⇓

in P r

Xn −→ X

n→∞

⇓

L

Xn −→ X

P − q.c.

n→∞

Nel caso in cui X è una variabile aleatoria degenere (ossia se esiste un a ∈ R tale che P(X = a) = 1) allora la

convergenza in probabilità equivale alla convergenza in legge:

in P r

Xn −→ a

n→∞

Xn

m

L

−→ a

n→∞

Infine vale anche una specie di implicazione inversa, nel senso specificato dal teorema di immersione di Skorohod (vedi

il successivo Teorema 2.4)

L

Xn −→ X

n→∞

⇓

L

L

e

e

en =

e=

Xn , X, with X

Xn , X