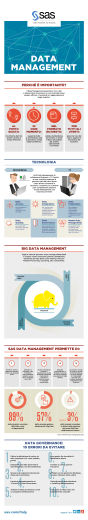

Università degli studi di Padova Facoltà di Ingegneria Gestionale Dipartimento di tecnica e gestione dei sistemi industriali Strumenti software per gestire i BIG DATA Laureando: Pedassou Yao Edem Relatore: Bonollo Giuliano Anno Accademico 2011-2012 Sommario Definizione di big data Descrizione dei processi in campo big data e i relativi problemi e criticità Le tecnologie : Apache hadoop Applicazioni Prospettive e conclusioni • E’ un insieme di dati talmente grande che è praticamente impossibile utilizzarli con gli strumenti tradizionali. • Definizione doppiamente inadeguata per la dimensione dei dati via via crescente e il valore di sfida che racchiude il big data PROCESSI E CRITICITÀ Dati di acquisizione e di recording • • • • Sorgenti di generazione dei dati Definizione dei filtri dei dati Generazione automatica del metadata giusto Provenienza dei dati Estrazione dell’informazione e il data cleaning Informazioni non inizialmente in formato strutturato pronte per l’analisi L’integrazione, l’aggregazione e la rapresentazione dei dati Ricerca di automatizazione dell’analisi dei dati rendendo l’analisi comprensibile in modo computazionale e poi risolvibile con la robotica Elaborazione delle query, modellazione e analisi dei dati • Scaling di query complesse • Mancanza di coordianamento tra i sistemi di dati strutturati e non strutturati Interpretazione dei dati • L’analisi deve essere reso facile al decisore • Si deve soddisfare la richiesta di precisione del decisore Le sfide • • • • • Eteregeneità La scala La tempestività La privacy La collaborazione umana Tecnologie • apache hadoop • linguaggio R • Cascading • Scribe • ElasticSearch • Apache Hbase • Apache Cassandra • MongoDB • Apache CouchDB Cos’è ? È un framework Open Source per applicazioni distribuite data-intensive • MapReduce • Hadoop Distributed file system (HDFS) HDFS: È un software che : • memorizza i file attraverso un insieme di server in un cluster. • Rileva e compensa i problemi di hardware, di disco e guasti di server • Tolera e compensa i fallimenti del cluster MapReduce : Sistema di elaborazione parallela dei dati • Fare fronte a un problema di esplosione di dati che nessun sistema preesistente era in grado di risolvere • Capace di archiviare qualsiasi tipi di dati • Prevedere uno stoccaggio a costo basso • Offre un nuovo repository dove tutti dati strutturali e complessi possono essere • • facilmente combinati Scalabilità e affidabilità per l’elaborazione di algoritmi arbitrari Compatibile con i sistemi preesistenti (database, log generator…) • Permette al DBA di ottimizzare il database • Fornire agli utenti meno tecnici informazioni sui dati (analisti..) • Guida ad una struttura incentrata sui dati Applicazioni Applicazioni analitiche • Basate su Attributi Attribuiscono un credito a una serie di attività (Partner di società) • Basate su predizione o previsione Usano le tecniche statistiche e di data Mining per processi decisionali in svariati scenari di mercato (valutazione rischi, gestione del rendimento) • Basate su approfondimento Usano le stese tecniche della precedente ma per rilevare Comportamenti insoliti (uso della carta di credito) Applicazioni settoriali • Finanza • Impatto su i costi, rischi, ricavi e conformità • Miglioramento dell’anlisi del profilo di clienti determinazione dell’eggibilità del capital azionario (mutui, assicurazione,credito) • Individuazione delle frodi e prevenzione di eventi futuri di frodi • Permette l’analisi del commercio Industria Manifatturiera Gestione dei servizi piu efficiente e più efficace grazie alla proliferazione dei sensori e all’ analisi di feed di dati di gran dimensione Le Operazioni • Miglioramento del processo di post-vendita di manutenzione • Con l’aggiunta di sensori per attrezzature per fornire livello crescenti di dati sulle operazioni di manutenzione dell’apparecchiatura • Aumento della qualità complessiva del prodotto Sanità • Migliorare la qualità dei servizi sanitari e ridurre il numero di ospedalizzazioni. • Sviluppo dei farmaci : uso dei dati per fornire medicinali efficace e in tempo breve • Scambio di informazioni sulla salute Conclusioni • Nuove tecnologie come hadoop sono impiegate per affrontare le sfide di big data e fino ad oggi ci riescono abbastanza bene • Finché i Cloud Computing, l’internet ed altri generatori di dati ci sarano, i problemi dei big data sarano di attualità : • La tecnologia deve affrontare il dilemma di risolvere crescita esponenziale e continua di dati con risorse a capacità limitate e con esigenza degli utenti ancora piu accentuata • Siamo ancora in fase sperimentale e di ricerca: permangono vari punti dubbi riguardo alle tecnologie, alle possibili “Killer application”, ad un utilizzo basico a livello di utenti. GRAZIE PER L’ATTENZIONE

Scaricare