I fondamenti statistici per la costruzione di scale psicometriche Pietro Giorgio Lovaglio1 1 Dipartimento di statistica, Facoltà di Scienze Statistiche, Milano-Bicocca, P.za dell’Ateneo Nuovo 1, Edificio U7, [email protected] Premessa Le metodologie o tecniche statistiche vengono definite come quella serie di strumenti volti allo all’analisi e allo studio dei fenomeni empirici che si manifestano in natura. Oggetto dell’indagine è tipicamente lo studio della variabilità di uno (statistica univariata) o più fenomeni (statistica multivariata) intesa come attitudine intrinseca di un particolare fenomeno ad assumere differenti intensità (manifestazioni del fenomeno) su una serie di soggetti interessati dall’analisi. La ricerca in ambito psicometrico non può prescindere da un’attenta conoscenza ed applicazione degli strumenti statistici come supporto scientifico volto alla comprensione della realtà e alla presa di decisioni da parte degli operatori coinvolti quotidianamente con processi e fenomeni di carattere psico-fisici. 1.Gli strumenti statistici di base per un’analisi psicometrica Indici di posizione. Organizzati in una distribuzione i dati relativi ad una serie di osservazioni o intensità (xi i=1,..n) occorre sintetizzare attraverso un valore sintetico o indice di posizione la distribuzione osservata in modo tale che metta in luce un aspetto particolare del fenomeno considerato a seconda degli scopi del ricercatore (per semplicità analizzeremo l’esempio i punteggi di un test attitudinale). Gli indici più utilizzati sono la moda o intensità che ha associata la più alta frequenza (tanto più espressiva quanto più elevate le frequenza ad essa associate) e la mediana definita come quella modalità o intensità che occupa la posizione centrale, una volta ordinate le intensità xi dalla più piccola alla più grande (ovviamente non esiste per quei fenomeni senza criteri oggettivi di ordinabilità es. sesso, colore capelli, etc). La mediana può definirsi come quel valore che divide in due gruppi ugualmente numerosi una distribuzione X: per identificare la mediana si deve conoscere l’intensità o la modalità del fenomeno associata alla persona che occupa il posto centrale della distribuzione una volta ordinati i valori della distribuzione. Se su 100 allievi che si cimentano in una prova che prevede tre possibili risultati (0=non supera la prova, 1=supera la prova con difficoltà ,2=supera la prova) si osserva che 30 allievi hanno punteggio 0, 10 allievi punteggio 1 e 60 allievi punteggio 2, in tal caso la moda vale 2 (punteggio più frequente) e la mediana altrettanto (il punteggio associato ai due soggetti centrali, il 50° e il 51° soggetto, una volta ordinati i valori dal più basso al più alto). Discorso analogo vale per i quantici; in particolare i quartili dividono la distribuzione del fenomeno in 4 parti uguali: il 1° quartile è quel valore del fenomeno (punteggio ad un test) tale che, una volta ordinati i punteggi in ordine crescente, separa il 25% dei soggetti peggiori (punteggi sotto il primo quartile) dal 75% dei migliori (punteggi sopra il primo quartile), mentre il 3° quartile è quel valore del fenomeno (punteggio ad un test) tale, che una volta ordinati i punteggi in ordine crescente, separa il 75% dei peggiori (punteggi sotto il terzo quartile) e il 25% dei migliori (punteggi sopra il terzo quartile). L’indice di posizione più noto è la media aritmetica, definita dal rapporto tra la somma delle intensità del fenomeno e il numero di osservazioni. La media non sempre è l’indicatore più indicato, spesso lo è la mediana, soprattutto laddove vi siano situazioni di valori anomali (punteggi di soggetti particolarmente sopra o sotto la media); cioè per rimanere nell’ambito dell’esempio del test attitudinale, se un basso numero di allievi 1 ottenesse performance molto superiori all’andamento generale (o molto inferiori all’andamento generale), la tendenza media del collettivo di studenti ne risulterebbe elevato (abbassato) artificiosamente per merito (colpa) di tale minoranza. In tali situazioni la mediana è più stabile della media. Al fine di evidenziare un andamento medio nel senso un intervallo di “valori regolari” va certamente citato il ruolo della differenza interquartile (Differenza tra il 3 Quartile e il 1 Quartile) che fornisce un range del punteggio totale degli allievi che si trovano nella parte centrale della distribuzione (e per definizione più stabile ed affidabile). Indici di Variabilità. Le medie -intese in senso lato- possono intendersi come una sintesi del fenomeno in un numero che esprime un particolare aspetto; lo studio non può tuttavia limitarsi a questo poiché non si riuscirebbe a valutare il grado di variabilità del fenomeno, ovvero come si distribuiscono le intensità del fenomeno attorno alla media . In particolare gli indici di variabilità più diffusi va citata la varianza (σ2) che valuta lo scostamento dei valori osservati xi dalla media e la deviazione standard definita come la radice quadrata della varianza (σ). Valori bassi di questi indici esprimono il fatto che le intensità di X si discostano poco dalla media (cioè essa rappresenta bene l’ordine di grandezza di X), mentre un valore alto il contrario. Legame tra due fenomeni: Correlazione. Supposto che due fenomeni x ed y siano quantitativi ci si può chiedere se il tipo di legame esistente tra essi può essere lineare, cioè se al variare di x y cresce in modo proporzionale (supponiamo di osservare sulle stesse unità statistiche i punteggi di due prove attitudinali ad esempio saltare e correre oppure la relazione tra peso e altezza). Sapere che il trend di evoluzione di un fenomeno varia linearmente rispetto alle variazioni di un altro fenomeno significa poter affermare ad esempio che al variare dell’altezza il peso cresce proporzionalmente per ogni aumento di 1 cm di altezza il peso presenta un incremento costante. La misura di linearità più diffusa tra due fenomeni quantitativi è il coefficiente di correlazione di Bravais- Pearson, (ρ) definito come il rapporto tra la media dei prodotti (xi-µx)(yj-µy) [dove (xiµx) sono gli scarti di ogni osservazione di xi dalla sua media ed (yj-µy) gli scarti di ogni osservazione di Y dalla sua media] e il prodotto delle deviazioni standard di X e di Y. L’indice ρXY assume valori tra -1 e 1; a) ρ = 0 se le due variabili sono incorrelate (ovvero il diagramma a dispersione mostra un andamento casuale dei punti di coordinate (xi, yj), tipico di situazioni in cui i punti si dispongono senza un trend lineare (si nota in Fig.1, a sinistra che al variare dell’età (x) il punteggio al test (y) si dispone in modo causale attorno alla media di y senza una chiara relazione tra y ed x): 100 90 80 70 60 50 40 30 20 10 0 14 Punteggio al test Punteggio al test 12 10 8 6 4 2 0 0 10 20 30 40 50 60 70 80 0 10 20 30 Età 40 Età Fig.1: Grafici a dispersione che evidenziano la correlazione tra età e punteggio al test 2 50 60 70 80 b) ρ= 1 se e solo se vi sia perfetta dipendenza lineare fra x ed y diretta, quando cioè il legame tra x ed y è perfettamente lineare su una retta crescente (al crescere di x y aumenta in modo perfettamente proporzionale, come in Fig.1 a destra) c) ρ = -1 in caso di perfetta dipendenza lineare inversa fra x ed y, quando cioè il legame tra x ed y è perfettamente lineare su una retta decrescente (al crescere di x, y diminuisce in modo perfettamente proporzionale) 2. L’utilizzo di test per la costruzione di scale L’obiettivo dei test attitudinali consiste nell’esigenza di misure oggettive di performance (abilità, attitudine, etc.) definite come indicatori sintetici che sottendono tutti una medesima dimensione inerente qualche aspetto dell’“attitudine” globale di ogni utente verso una particolare aspetto della vita. In particolare si fa riferimento al concetto di abilità motoria e cognitiva, (Tesio et al., 1996), di qualità della vita, (Apolone et al., 1997), di ritardo mentale (Ware, 1987) etc. Le considerazioni principali per la scelta della metodologia da affrontare per la stima di tali indicatori di performance fanno emergere principalmente due ordini di problemi: • • Gli indicatori utili per stimare le performance sono desunti da test-questionari e tipicamente di natura categoriale (passa/non passa) o ordinale (passa /passa con difficoltà / non passa); Si presentano tipicamente situazioni di dati mancanti . In letteratura il problema della stima di variabili non direttamente osservabili (latenti, come ad esempio abilità, attitudine, capacità motoria, intelligenza etc.) è stato affrontato dal punto di vista applicativo per valutare abilità, capacità o più in generale attitudini verso diversi aspetti della realtà, sintetizzabili con il termine "latent traits" (LT) spesso non direttamente osservabili, ma desumibili da un insieme di items (prove attitudinali, questionari, prove fisiche, mentali, tests, etc...) che misurano a meno di errori tale latent trait. Le metodologie utilizzate per la stima di variabili non osservabili o latenti (LV) hanno attinto dai modelli di analisi fattoriale (MF, Bartolomew, 1987) definito attraverso un modello che suppone l’esistenza di pochi LT “inosservabili” (x1,..xm) sottostanti all’insieme degli Items (y1..yp); l’analisi fattoriale consiste nel descrivere un fenomeno complesso descritto da una serie di k items (y1..yk) in forma più semplice derivando un numero limitato (m<k) di latent trait (x1 x2,..xm) non osservabili, ma ricavati sostanzialmente come una media dell’insieme delle variabili osservate (y1..yk), ponderando in maniera differente l’importanza di ogni item originale1 (attraverso delle componenti di peso), in modo da conservare la maggior informazione possibile. L’analisi fattoriale permette di risponde alle seguenti domande: 1. Quanti latent trait inosservabili servono per spiegare tutti gli item2; 2. Quanta parte della variabilità del complesso degli item cattura ogni LT (autovalore); 3. Quanta parte della variabilità di ogni item è catturata dall’insieme dei LT (comunalità); 4. Qual è il peso di ogni variabile sulla costruzione di ogni LT (factor weights); Esempio Su un campione di anziani si sono rilevati i risultati relativi allo stato di autosufficienza attraverso l’osservazione di 4 attività della vita quotidiana (Items) rilevati su una scala da 0 a 15 (0=dipendenza, 15= autonomia): X1 =trasferimenti letto-sedia, X2 = deambulazione, X3 = igiene personale, X4 = alimentazione. L’estrazione di pochi LT cercherà di riassumere in qualche modo i 4 Items ma nello stesso tempo perdere il minor numero di informazioni (variabilità dei 4 Items): dall’analisi fattoriale si sono 1 Rispetto alla semplice somma degli items, come nell’approccio delle scale cumulative, mostrato in seguito. Spearman (1904) ad esempio presentò un modello a due fattori, secondo il quale le abilità mentali descritte da un test contenente prove (Item) di intelligenza, potevano essere ridotte ad un fattore di abilità logico-matematica e ad uno espressivo-linguistico. 2 3 ricavati gli autovalori: ogni LT, dal primo al quarto spiega l’84%, il 15% l’1% e lo 0% della variabilità dei 4 Items e dunque la scelta dei primi due LT assicura il 99% della varibilità globale, perdendo solo l’1% di informazione possiblie passando dai 4 Items ai due LT. I primi due fattori vengono definiti dai coefficienti (factor weights) LT1 = 0.96 X1 + 0.92 X2 + 0.74 X3 + 0.75 X4 LT2 = -0.06 X1 - 0.15 X2 + 0.40 X3 + 0.41 X4 Il primo LT, poiché viene definito semplicemente come somma degli Items (si noti che i pesi degli Items sono diversi), può considerarsi un indicatore di autonomia globale, mentre osservando i segni dei coefficienti il secondo mostra il contrasto tra X1, X2 verso X3 X4: ciò significa che tale fattore può interpretarsi come un indicatore di autonomia legato all’equilibrio e all’uso delle mani (poiché i contrasti esistono tra le attività di locomozione tout court verso le attività di igiene personale e alimentazione). I punteggi ricavati dalle due relazioni precedenti costituiscono due utili indicatori di performance motoria e motoria-manuale per ogni anziano, ricavata dalle 4 variabili iniziali (riduzione). Le comunalità per le 4 variabili (0.93, 0.88,0.71,0.74) mostrano che i due fattori prescelti spiegano una quota elavata della variabilità di ognuna delle X 3. L’uso di scale cumulative I test sono misurazioni obbiettive e standardizzate di un campione di comportamento supposto rappresentativo della totalità del comportamento stesso. Un test può essere presentato come una batteria di k prove (y1, y2,…. yk), un elenco di item (elementi, prove, domande, esercizi), raccolti in un questionario, intervista, scheda. In letteratura le prime forme di stima di LT ha coinciso con la semplice somma degli item in una batteria di test: T = Σi xi (scala cumulativa); tale scelta sebbene semplicistica conserva tuttora un notevole seguito destato dalla semplicità e dalla semplice applicabilità in ogni disciplina; tuttavia è importante valutare la bontà dello strumento proposto, cioè poter rispondere alla domanda se la misura cumulativa così costruita presenta le caratteristiche adeguate allo scopo. 3.1 Caratteristiche per la costruzione di una scala Per essere valido come strumento di misura, il test, la batteria, il questionario o, comunque in senso lato, le prove specificate nel test devono presentare alcune caratteristiche: 1. Concetto unidimensionale Il ricercatore deve scegliere opportuni insiemi di items tali che il LT che si vuole stimare sottenda un'unica dimensione latente (unidimensionale); qualora invece sottenda più di una dimensione latente finisce per fornire risultati contraddittori in quanto non risulta chiaro se e in che misura ogni item e gli items nel loro complesso si riferiscano ad un particolare LT oggetto di studio (abilità motoria) o ad un altro LT affine, ma diverso (capacità di equilibrio). Standardizzazione La somministrazione del test deve avvenire con procedure uniformi, ossia con le stesse modalità (materiali, limiti di tempo, frasi da utilizzare, assegnazione del punteggio) per tutti i soggetti testati. Validità (validity) Il test deve realmente misurare ciò che si è prefissato di misurare, deve cioè essere valido. In particolare la "validità di contenuto" riguardante le variabili da misurare, a chi è destinato il test; il modello teorico cui esso si rifà, le caratteristiche degli item. Tali indicazioni vengono 4 manifestate nei pareri e nei giudizi degli esperti nei gruppi di discussione e nelle riunioni atte per trovare accordi unanimi sul tipo di prove da somministrare (né troppo facili, né troppo difficili etc), sul modo di codificare oggettivamente le performance di un allievo sulla prova (es. specificare due sole categorie: l’allievo supera l’esercizio o non lo supera oppure predisporre più gradi di abilità), stabilendone il punteggio e i gradi di abilità. La "validità di costrutto" invece è intesa sia come capacità del test (insieme di Items) di cogliere relazioni tra coppie di Items sia come capacita’ del test di discriminare tra diversi LT (es. l’abilità motoria dall’equilibrio); tale verifica si risolve attraverso la valutazione dell’unidimensionalità del LT attraverso il modello di analisi fattoriale precedentemente descritto. Affidabilità (reliability) È l’accuratezza e la coerenza del test, e si basa sulla necessità che questo fornisca misurazioni precise, stabili e oggettive. L 'analisi di affidabilità può essere usata per costruire le scale certe di misura, per migliorare le scale esistenti e per valutare l'affidabilità delle scale già in uso. Tale analisi si rende necessaria poiché come già mostrato dal modello fattoriale alla base di un fattore latente (es. "abilità motoria") sottostante ad un numero di item vi è una componente di errore da valutare; in tale ipotesi si suppone che vi sia una parte del fattore latente che le prove del test "non carpiscono". Di conseguenza, la risposta del soggetto ad un item (yi) particolare riflette due componenti: in primo luogo, il concetto “vero” (x, abilità motoria), in secondo luogo, una certa funzione estranea o di errore (ei), cioè la componente che tale item non coglie. Una misura è affidabile se riflette principalmente il punteggio vero, cioè se la variabilità degli errori è nulla; in questo contesto la definizione di affidabilità è data dal rapporto tra la variabilità del concetto vero (x) e la variabilità dell’insieme degli Items. Poiché x non si conosce si può valutare la proporzione di vera varianza catturata dagli item, attraverso il coefficiente di affidabilità (α di Cronbach) α = kρ 1 + ρ ( k − 1) (1) dove ρ è la media delle correlazioni esistenti tra ogni coppia dei p Items e k il numero di items. Se la correlazione media è nulla significa che tutte le coppie di correlazioni sono nulle, dunque il numeratore si annulla, lasciando un indice di completa inaffidabilità delle prove (α=0); altrimenti quanto più α è vicino ad 1 tanto più le prove sono affidabili; se la correlazione media è uno significa che tutti gli Item sono massimamente correlati lasciando nella (1) un valore unitario coerente con il fatto che tutti gli item non presentano componenti di errore e misurano dunque tutti il fattore vero (scala massimamente affidabile). Empiricamente si ritengono accettabili scale con α>0,70. Se gli item sono di natura binaria (es. supera / non supera l’esercizio) il coefficiente α equivalente è il seguente (Lord e Novick, 1968) a: Kr = (k/k-1) [1- (Σj pj qj / σ2) ] (2) dove pj è la percentuale di individui che passano l’esercizio nell’item j, qj la percentuale degli individui che non passano l’item j, k il numero di item e σ2 denota la varianza della somma degli itemi T. Oltre al coefficiente di affidabilità globale generalmente si osserva anche l’α se eliminiamo una variabile alla volta, potendosi così osservare se l’eventuale eliminazione di un item assicura una maggiore consistenza nel complesso degli item. 5 Un’altra misura di affidabilità globale è il coefficiente di Correlazione punto biseriale (PB, Lord e Novick, 1968), definita come la correlazione tra i punteggi ottenuti dai soggetti su un item e il punteggio totale dei soggetti su tutti gli Item (esisterà dunque una PB per ogni Item); Item con valori elevati di tale coefficiente riflette il fatto tale item misuri lo stesso LT degli altri Items; se i PB sono tutti sufficientemente elevati essi effettivamente la stessa cosa, cioè sottendono tutti la stessa dimensione latente. Se un PB è basso (tipicamente <0,75) probabilmente tale Item va eliminato dal test; un altro modo di selezionare Item consiste nel valutare il coefficiente α della (1) eliminando un Item alla volta; in questo modo per ogni Item si ottiene un coefficiente α (definito α se eliminato) che indica come varia il grado di affidabilità del test rispetto all’α globale della (1) quando si elimina un particolare Item (vedi esempio di Tab.1). Altri tipi di affidabilità del sistema riguardano le seguenti situazioni: Affidabilità e riproducibilità nel tempo (test retest) Se lo stesso individuo è sottoposto più volte al medesimo test, o ad una sua forma equivalente, si deve ottenere lo stesso punteggio sia in situazioni diverse, a distanza di tempo; si chiede la stabilità dei risultati a successive somministrazioni (test retest). Se la scala è affidabile, ci aspettiamo che nelle due occasioni (t1, t2) i punteggi totali nelle due occasioni abbiano un’alta correlazione positiva (ρxy = 1). Scale via via meno affidabili forniscono correlazioni tra le due occasioni via via più basse. Affidabilità e riproducibilità tra intervistatori (k di Cohen ) Nel caso in cui lo stesso soggetto venga valutato da più rilevatori (giudici) o da strumenti diversi (diverse batterie di test che mirano alla stima dello stesso LT) va valutato l'accordo tra tali valutatori o strumenti attraverso il coefficiente di accordo Cohen K (Lord e Novick, 1968) basato sulla proporzione di casi osservati nella quale gli strumenti sono in accordo ovvero classificano lo stesso soggetto nella stessa categoria (passa/non passa); un valore pari a 1 indica accordo perfetto, pari a 0 indica che l'accordo può essere considerato casuale. Affidabilità del sottocampione (split-half reliability) Ci si può chiedere che cosa succeda alla reliability se il campione di soggetti che affrontano il test viene diviso casualmente in due gruppi separati (sottocampioni). A tal fine si calcola il punteggio totale del test dei soggetti nei due sottocampioni x (primo sottocampione) ed y (secondo sottocampione) e si valuta la correlazione tra le risposte nei due gruppi ρxy ; più precisamente si calcola il coefficiente split half dalla formula: 2ρxy / (1 + ρxy); se il test è affidabile, ci aspettiamo che i punteggi totali nelle due sottocampioni abbiano una correlazione positiva ed elevata, scale via via meno affidabili forniscono correlazioni via via più basse 4. Passi per la costruzione di scale In generale i passi per la costruzione di una scala affidabile sono di seguito presentati: Step 1: Generare items: processo creativo, brainstorming, esperti, in gruppi di discussione di esperti (operatori) del settore per definire la validità di contenuto (quali e quanti Items, quali e quante categorie di risposta per ciascun Item); Step 2: scegliere items of difficoltà calibrata: dopo aver inserito gli item il questionario va somministrato ad un campione di typical respondents per identificare gli Item che non discriminano (effetto pavimento; tutti passano l’Item, nessuno passa l’Item); per scegliere item calibrati valuto la difficoltà degli item e la capacità discriminatoria. Difficoltà. L'item non deve essere né troppo facile né troppo difficile, tale aspetto è misurato con pj il rapporto tra i soggetti che superano la prova j e il totale di soggetti che effettuano la prova j: empiricamente si ritengono accettabili valori tra 0,25 e 0,75. 6 Capacità discriminatoria. L'item j deve il più possibile distinguere tra i soggetti "più bravi" e quelli "meno bravi"; l’ indice maggiormente utilizzato è dato dalla differenza tra pj1 (percentuale di risposte corrette considerando il 25% dei soggetti con punteggio totale più elevato) e pj2 (percentuale di risposte corrette considerando il 25% dei soggetti con punteggio totale meno elevato; empiricamente si ritengono accettabili per tale indice valori superiori a 0,30. Step 3: Scegliere gli item con alta affidabilità: Alfa di Cronbach globale, coefficiente Alfa, eliminando un item alla volta, correlazione PB (eventualmente test-retest, K, split half) Step 4: Tornare allo step 1 dopo aver eliminato gli item che non rendono affidabile la scala. 5. Un esempio L’esempio mostrato nella Tabella 1 presenta l’analisi di affidabilità di 10 items con punteggio da 0 a 10 ciascuno; il punteggio medio dei 10 Items è 7.35 e dalla (1) l’affidabilità globale (α=0,79) è elevata: le ultime tre colonne mostrano la correlazione tra ogni item e la somma degli Item (Correlazione PB), la media e il coefficiente alpha se l’item in questione viene eliminato (esempio se elimino l’Item 5 α diventa 0.82 rispetto a 0.79 che è l’affidabilità globale e la media dei 10 Item diventa 8.01 rispetto a quella totale di 7.35) .Chiaramente tutte le colonne mostrano che gli items 5 and 6 vanno eliminati poiché non sono consistenti con il resto della scala, perché senza tali Item le misure di affidabilità (ultima colonna) migliorano rispetto all’affidabilità globale (α= 0,79), inoltre la correlazione PB è bassissima rispetto agli atri Items e il punteggio medio aumenta drasticamente eliminando ciascuno dei due Items. ITEM Item1 item2 item3 item4 item5 item6 item7 item8 item9 item10 PB 0.65 0.66 0.54 0.47 0.05 0.11 0.58 0.60 0.50 0.57 Media se eliminato 7.20 7.33 7.40 7.52 8.01 7.91 7.35 7.30 7.42 7.33 α se eliminato 0.75 0.75 0.76 0.77 0.82 0.81 0.76 0.75 0.77 0.76 Tab.1: Analisi di affidabilità: le colonne identificano il numero di Item, la correlazione Punto Biseriale e la media dei punteggi dei 10 Item e il coefficiente α se eliminato (eliminando di volta in volta l’Item corrispondente) Riferimenti Bibliografici Apolone G., Mosconi P., Ware J.E. (1997), Questionario sullo stato di salute SF-36. Manuale d’uso e guida all’interpretazione dei risultati, Guerini e Ass., Milano. Bartholomew, D.J. (1987), Latent variable models and factor analysis, New York: Oxford University Press. Lord, F. M. e Novick, M. R. (1968). Statistical theories of mental test scores. Reading, MA: Addison-Wesley. 7 Lovaglio P.G., (2001) La stima di outcome latenti, Atti del Convegno Intermedio della Società Italiana di Statistica, Processi e Metodi Statistici di Valutazione, Cisu, 5-7 Maggio,.pp. 393396 Roma. Warr, P. (1987) Work, unemployment and mental health (Oxford University Press, Oxford,). Wright B. D., Mok M., (2000) Rasch models overwiew, Journal of applied measurement, 1(1), pp.83-106 Abstract. Il presente lavoro, riguardante la costruzione e la validazione di scale in ambito psicometrico, fornisce gli strumenti statistici più utilizzati a tal fine, descrivendone l’impianto metodologico e razionale per il loro utilizzo per chi non ha familiarità con le metodologie di ricerca quantitativa. In particolare dopo aver introdotti gli strumenti statistici di base si definirà il concetto di scala valida o affidabile attraverso gli indicatori più utilizzati per la verifica della validità di contenuto e la validità di costrutto. 8

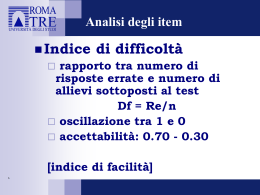

Scaricare