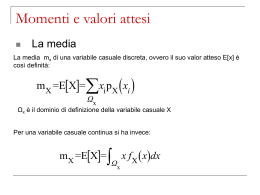

Matematica e statistica Versione didascalica: parte 6 • • • Sito web del corso http://www.labmat.it Docente: Prof. Sergio Invernizzi, Università di Trieste e-mail: [email protected] 1.6. Variabili aleatorie finite • Esperimento E • Spazio campionario • In ogni prova, osservata (misurata) una “variabile” X • Il valore osservato di X dipende da quale degli eventi elementari si verifica nella prova in questione: X è una “variabile aleatoria”. • Nel caso più semplice X assume un numero finito di valori : x1 , x2 , x3 , ..., xN con corrispondenti probabilità p1 , p2 , p3 , ..., pN 1.6. Variabili aleatorie finite: esempio Nel caso dei due dadi X assume un numero finito di valori : 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12 con corrispondenti probabilità 1 , 2 , 3 , 4 , 5 , 6 , 5 , 4 , 3 , 2 , 1 36 36 36 36 36 36 36 36 36 36 36 1.6. Variabili aleatorie finite: esempio • Esperimento E = lancio di due dadi • Spazio campionario • La v.a. X in questione è null’altro che una applicazione reale X: R definita sulle coppie = (r, v) dalla formula X() = r + v. Si noti che è possibile interpretare # X 1 ({8}) 5 P( X = 8) = = 36 # come “massa” della controimagine X -1({8}) = { in tali che C()=8} se si attribuisce la massa 1 = 100% a tutto lo spazio . 1.6.1. Valore atteso e varianza • 80 lanci di un dado truccato: x <- floor(1+6*runif(80)^2) x = {1, 1, 1, 2, 4, 1, 5, 3, 1, 2, 5, 1, 1, 2, 1, 5, 1, 2, 3, 4, 4, 2, 1, 1, 4, 1, 1, 6, 1, 6, 1, 1, 3, 2, 2, 6, 2, 1, 1, 1, 1, 2, 3, 1, 2, 1, 1, 6, 3, 6, 1, 1, 3, 6, 5, 4, 1, 2, 2, 4, 2, 2, 1, 3, 1, 5, 2, 1, 4, 4, 1, 2, 1, 5, 1, 2, 2, 5, 1, 3} • calcolo la media aritmetica: m = (1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 1 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 2 + 3 + 3 + 3 + 3 + 3 + 3 + 3 + 3 + 4 + 4 + 4 + 4 + 4 + 4 + 4 + 4 + 5 + 5 + 5 + 5 + 5 + 5 + 5 + 6 + 6 + 6 + 6 + 6 + 6)/80 = 196/80 = 2.45 (continua) m = (1 + 1 + 1 + 1 + 1 + 2 + 2 + 4 + 4 + 6) / 80 1 1 2 2 4 + + + + + 1 1 2 2 4 + + + + + 1 1 2 3 5 + + + + + 1 1 2 3 5 + + + + + 1 1 2 3 5 + + + + + 1 1 2 3 5 + + + + + 1 1 2 3 5 + + + + + 1 1 2 3 5 + + + + + 1 1 2 3 5 + + + + + 1 1 2 3 6 + + + + + 1 1 2 4 6 + + + + + 1 1 2 4 6 + + + + + 1 1 2 4 6 = (33 1 + 18 2 + 8 3 + 8 4 + 7 5 + 6 6) / 80 = 33 80 8 8 7 6 1 18 2 3 4 5 80 80 80 80 80 6 = circa f11 f 2 2 f3 3 f 4 4 f5 5 f 6 6 6 p1 x1 p2 x2 p3 x3 p4 x4 p5 x5 p6 x6 = pk xk k =1 + + + + + 1 1 2 4 6 + + + + + (continua) • In generale il valore atteso = E[ X ] = N x k =1 k pk (baricentro) N 2 Var [ X ] = ( x ) pk • Varianza (momento di inerzia) k k =1 • Deviazione standard = Var[ X ] = N 2 ( x ) pk k k =1 4.1. Stime dei parametri • Popolazione: X • Numero di prove: n • Campione aleatorio: • Valori osservati: • X1 , X 2 , X 3 , ..., X n x1 , x2 , x3 , ..., xn Non confondere con i valori possibili • Media campionaria: n = 1 n k =1, n Xk • Il valore osservato della media campionaria mn = 1n k =1, n xk = ˆ = E[ X ] N viene usato come stimatore della media vera = E[ X ] = xk pk k =1 (continua) • Stimatore Tn di un parametro corretto (unbiased) : E[Tn] = coerente (consistent): lim Var[Tn] = 0 • La media campionaria è uno stimatore corretto e coerente della media vera: vedremo che E[ M n ] = Var[ M n ] = 2 / n (è un teorema: cf. diapositiva 26) • Stimatore o consuntivo: statistic • Statistica come scienza: statistics Stima della media di 2 dadi = 7. Facciamo 8 osservazioni m della media campionaria, con diverse dimensioni del campione: n = 5, 10, 50, 200 n=5 m osservati: 7.60, 6.00, 8.00, 4.60, 7.80, 6.40, 6.80, 8.20 n = 10 m osservati: 6.60, 7.70, 8.70, 5.60, 6.40, 6.80, 7.40, 7.00 n = 50 m osservati: 6.68, 6.42, 7.28, 7.40, 6.96, 6.86, 6.96, 7.48 n = 200 m osservati: 7.15, 6.80, 7.23, 6.98, 7.08, 7.08, 7.07, 6.88 n = 1000 m osservati: 6.94, 6.86, 7.12, 7.01, 6.91, 6.93, 7.02, 7.06 Qui invece rappresentiamo 250 osservazioni m della media campionaria Mn, con dimensioni del campione: n = 25 n = 50 n = 100 n = 200 I valori osservati m della media campionaria Mn sono centrati su e tanto meno dispersi quanto più n è grande, … I valori osservati m della media campionaria Mn sono centrati su e tanto meno dispersi quanto più n è grande, … Quindi se n è “grande”, abbiamo una “buona probabilità” che un singolo valore osservato m della media campionaria Mn (ossia la media aritmetica dei valori osservati del campione) sia una “buona” stima per . La stima è migliore tanto più grande è n (la dimensione del campione). 4.2.1 La varianza campionaria • Consuntivo varianza campionaria: S n2 = n11 k =1,n ( X k M n ) 2 La varianza campionaria è uno stimatore corretto e coerente della varianza vera (è un teorema: cf. diapositive 27, 28, 29): ˆ 2 = n11 k =1,n ( xk mn )2 2 • Se si dividesse per n si otterrebbe uno stimatore (biased = non corretto) in quanto n 1 2 E[ S ] = 2 n 2 n S 2 n distorto Sulla calcolatrice • Stime sulla TI-82 • Popolazione X = -ln(rand) • n (max 99) valori osservati in L1 • Comando 1-Var Stats L1 • x = mn = stima della media • Sx = stima della deviazione standard non distorta • x = stima della deviazione standard distorta • minX, Q1 , Med, Q3 , maxX = “riassunto a 5 numeri” [ box plot ] minimo primo quartile mediana (almeno il 50% ... e almeno il 50% ....) terzo quartile massimo [ NB animazione delle schermate ] > x <- -log(runif(99)) > x [1] [7] [13] [19] [25] [31] [37] [43] [49] [55] [61] [67] [73] [79] [85] [91] [97] 0.442406779 0.948137321 0.439984155 0.468903451 0.237981589 3.709382632 1.010956427 1.046182539 1.356679765 1.220112306 0.586604401 1.432247566 2.223455853 0.115486534 0.718340727 0.089948549 0.756498358 1.520114323 4.632340154 0.087883367 2.481204484 0.432601672 1.710685905 1.277979394 0.991990006 0.251157440 1.397272292 0.419796978 0.241009211 0.269832732 0.255647427 0.597733568 0.452019811 1.250687755 0.359739819 0.122841389 0.327555402 0.346950869 2.591373233 0.186195443 0.047300276 0.314767995 0.137009917 1.359575045 0.586009376 0.218992103 0.060091875 0.556714480 0.603395773 0.226443560 1.910004276 Stesso esempio con R 1.196004366 0.725634687 1.131393955 0.073592979 0.273996105 0.915975775 1.085035943 2.068547432 0.417083051 3.397626651 1.145115010 0.876719352 0.398964894 4.165507832 0.795164795 2.096750485 1.142232603 1.002278314 0.412639758 0.549544999 0.268526137 0.065707763 0.069276794 0.120096882 0.307458761 0.270470772 0.472123723 0.281467705 1.157393991 1.140225430 0.839431267 2.878146447 0.066834102 0.731509306 1.432809035 0.796314267 0.031064219 0.097969750 1.654436531 0.478522417 0.390503350 0.303111629 0.531094403 0.492258877 2.870695956 1.054656225 0.009448098 1.253159978 > summary(x) Min. 1st Qu. Median Mean 3rd Qu. Max. 0.009448 0.272200 0.586000 0.898600 1.177000 4.632000 BoxPlot (riassunto a 5 numeri) Min 1Quart. Mediana 3Quart. “Max” dati “anomali” Media vs Mediana • Centralità & Dispersione • Scale a rapporti: usare preferibilmente • Media & Deviazione standard • Scale qualitative: usare preferibilmente • Mediana & Quartili (riassunto a 5 numeri) (nel Curriculum Vitae inserire boxplot dei voti) 1.6.2. Formule per E[X] e Var[X] • Valore atteso di aX+b E[ f ( X )] = k =1, N f ( xk ) pk f ( x) = ax b E[aX b] = k =1, N (axk b) pk = = a k =1, N xk pk b ( k =1, N pk ) = aE[ X ] b 1.6.2. Formule per E[X] e Var[X] • Varianza come valore atteso E[ f ( X )] = k =1, N f ( xk ) pk f ( x) = ( x E[ X ]) 2 E[( X E[ X ]) 2 ] = k =1, N ( xk E[ X ]) 2 pk = = Var[ X ] 1.6.2. Formule per E[X] e Var[X] • Varianza di aX+b • Poniamo aX+b al posto di X nella formula precedente Var[ X ] = E[( X E[ X ]) ] 2 Var[aX b] = E[(aX b E[ aX b]) ] = 2 = E[(aX b aE[ X ] b ]) 2 ] = = E[a ( X E[ X ]) ] = 2 2 = a E[( X E[ X ]) ] = a Var[ X ] 2 2 2 1.6.2. Formule per E[X] e Var[X] • Valore atteso di X+Y • P{ {X = xk} {Y = yj } } = pkj • E[ X Y ] = k =1, N ( xk y j ) pkj = j =1, M = k =1, N xk ( j =1, M pkj ) j =1,M y j ( k =1, N pkj ) = k =1, N xk pk j =1, M y j q j = E[ X ] E[Y ] 1.6.2. Formule per E[X] e Var[X] • Valore atteso di XY per variabili indipendenti • P{ {X = xk} {Y = yj } } = pkj = P{X = xk} P{Y = yj } = pk qj • E[ XY ] = k =1, N ( xk y j ) pkj = j =1, M = k =1, N j =1, M xk y j pk q j = = k =1, N xk pk j =1, M y j q j = E[ X ] E[Y ] 1.6.2. Formule per E[X] e Var[X] • Varianza di X+Y Var[ X Y ] = Var[ X ] 2Cov[ X , Y ] Var[Y ] Cov[ X , Y ] = E[( X E[ X ]) (Y E[Y ])] • Per variabili indipendenti: Cov[X,Y] = 0 • Varianza di X+Y per variabili indipendenti Var[ X Y ] = Var[ X ] Var[Y ] Cov[ X , Y ] = 0 1.6.2. Formule per E[X] e Var[X] • Covarianza zero non implica indipendenza! • Lanciamo i due dadi R e V per 100 volte. Valutiamo : • La variabile doppia (R, V) • La variabile doppia (X,Y) = (R + V, R – V ): 1.6.2. Formule per E[X] e Var[X] • X = R + V e Y = R – V sono evidentemente v.a. dipendenti (ad esempio se X=12 non puo' che essere Y=0, e se X=11 non puo' che essere Y=1 oppure Y=-1), ma la covarianza è nulla. In generale applicare funzioni X = f(R,V) e Y = g(R,V) a due variabili R e V indipendenti fornisce due variabili dipendenti X e Y con dipendenza di tipo talvolta inaspettato (cf. CD). 1.6.2. Formule per E[X] e Var[X] • ... la covarianza è nulla: Cov[ X , Y ] = E[( X E[ X ]) (Y E[Y ])] Cov[ R V , R V ] = E[( R V E[ R V ]) ( R V E[ R V ] )] = = E[( R V 2 E[ R ]) ( R V )] E[ R] = E[V ] = E[ R 2 V 2 2 R E[R] 2 V E[V ]] = E[ R 2 ] E[V 2 ] 2 E[R ]2 2 E[V ]2 = 0 E[ R 2 ] = E[V 2 ] Standardizzazione = E[ X ] = Var[ X ] X Z= = (1/ ) X ( / ) E[ Z ] = (1/ ) E[ X ] / = ( E[ X ] ) / = 0 Var[ Z ] = (1/ ) 2 Var[ X ] = (1/ 2 ) 2 = 1 Standardizzazione della media M n = n1 k =1,n X k E[ M n ] = E[ n1 k =1,n X k ] = n1 k =1,n E[ X k ] = n1 n = Var[ M n ] = Var[ n1 k =1,n X k ] = ( n1 ) 2Var[ k =1,n X k ] = 2 1 =( ) n k =1, n Var[ X k 2 1 ]=( ) = ( n1 ) 2 n 2 = 2 / n Zn = Mn 2 /n = Mn n n = 2 k =1, n La media campionaria è uno stimatore corretto e coerente S n2 = n11 k =1, n ( X k M n ) 2 X k M n = ( X k ) (M n ) La varianza campionaria è uno stimatore corretto ( n 1) S n2 = k =1, n [( X k ) ( M n )]2 = = k =1, n [( X k ) 2 2( X k )( M n ) ( M n ) 2 ] = k =1, n ( X k ) 2 2( M n ) k =1, n ( X k ) k =1, n ( M n ) 2 = k =1, n ( X k ) 2 2( M n )( k =1, n X k n ) n( M n ) 2 = k =1, n ( X k ) 2 2( M n )(nM n n ) n( M n ) 2 = k =1, n ( X k ) 2 2n( M n ) 2 n( M n ) 2 = k =1, n ( X k ) 2 n( M n ) 2 La varianza campionaria è uno stimatore corretto E[(n 1) S n2 ] = E[ k =1, n ( X k ) 2 n] nE[( M n ) 2 ] = nE[( X k ) 2 ] nVar[ M n ] = n 2 n E[ Sn2 ] = 2 2 n = (n 1) 2 La varianza campionaria è uno stimatore coerente Var[ Sn2 ] = E[( Sn2 2 ) 2 ] 4 E [ S Per lo sviluppo del binomio questo richiede il calcolo di n] Il risultato : 4 4 n 3 2 Var[ Sn ] = 0 4 n n 1 Dove 4 = E[( X ) 4 ] si assume finito.

Scaricare