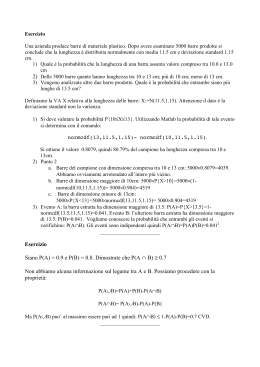

2. VARIABILI CONTINUE A. Federico ENEA; Fondazione Ugo Bordoni Scuola estiva di fonetica forense Soriano al Cimino 17 – 21 settembre 2007 VARIABILI E SPAZI CONTINUI Se un esperimento consiste, ad esempio, nel misurare la prima formante di una vocale, lo spazio degli eventi S si può far corrispondere a tutti i punti di un intervallo di un asse reale: si ha in questo caso uno spazio degli eventi descritto da una variabile continua. Se le misure sono più d’una, come nel caso che si misurino tutte le formanti, lo spazio degli eventi è multidimensionale e continuo. Un vettore XS è un evento necessariamente associato ad una misura di probabilità nulla. La ripartizione in sottoinsiemi s S dello spazio degli eventi lascia la possibilità di misure di probabilità non nulle associate ai sottoinsiemi perché sono a tutti gli effetti eventi discreti. ESPERIMENTI NEGLI SPAZI CONTINUI Il risultato di un esperimento rappresentato da p numeri reali, può essere X = x1, x2, … xp…… definiti in un dominio S in uno spazio degli eventi multidimensionale (multivariato), Sp. Gli assiomi probabilistici ed i teoremi del calcolo delle probabilità vengono adattati alle variabili continue riconducendo lo spazio ad un reticolo numerabile di intervalli. Ad ogni sottodominio elementare siS si può associare una probabilità cui si possono applicare i principi degli spazi discreti degli eventi. FUNZIONI DI DENSITÀ E DISTRIBUZIONE La prima delle proprietà si esprime nel continuo al seguente modo: P(Ei) = Si p(X) d X ; P(S) = 1. La funzione p(x) è definita in modo che si possa calcolare la probabilità di un sottoinsieme Ei attraverso la sua integrazione locale. Il calcolo delle probabilità negli spazi continui è dominato da queste funzioni note come funzioni di densità di probabilità, p.d.f. = p(X) . Si tratta di funzioni associate ad altre funzioni, dette di distribuzione di probabilità, che sono gli integrali definiti delle p.d.f. corrispondenti alla probabilità che la variabile vettoriale sia inferiore ad un valore dato, X0, argomento della P.D.F., cioà che X < X0. MOMENTI DELLA pdf I momenti della funzione si definiscono per p=1: Mk = (xk ) = S xk p(x) d x ed in particolare la media: (x ) = = S x p(x) d x e la varianza: (x-)2 = 2 = S (x-)2 p(x) d x Queste definizioni sono immediatamente generalizzabili ai momenti di ordine superiore ed alle pdf multivariate. Si può dimostrare che la conoscenza dei momenti di tutti gli ordini consente di specificare la funzione pdf in tutti i punti. ALCUNE LEGGI Si definiscono alcune leggi indipendenti dalla pdf: Diseguaglianza di Markov: sia x una variabile aleatoria positiva con un valore atteso = E(x). Per ogni 0: P(x ≥ ) ≤ / che corrisponde all’idea che man mano che cresce rispetto a la probabilità deve diminuire. 0 0 E ( x) xP( x)dx xP( x)dx xP( x)dx xP( x)dx P( x)dx P( x ) ALCUNE LEGGI Diseguaglianza di Cebychev: applicando la legge di Markov alla distanza euclidea dalla media della variabile x, (x-)2, per qualunque k>0: P(|x-| k) 1/k2 Diseguaglianza di Chernoff: se nella diseguaglianza precedente si inserisce la media di un campione di n estrazioni indipendenti di una popolazione: x = 1/n Si xi si ottiene: P(|x-| k) 2/nk2 che tende a zero al crescere di n. GRANDI NUMERI Teorema dei grandi numeri o di Bernoulli: “La frequenza relativa di qualunque evento casuale converge alla sua probabilità all’aumentare del numero delle prove” Si ottiene direttamente dalla diseguaglianza di Chernoff applicata ad una variabile binomiale bernoulliana [0;1] e dalla definizione di media , che corrisponde alla frequenza di tale variabile e che deve convergere al valore della probabilità p dell’estrazione dell’1. LIMITE CENTRALE Teorema del limite centrale: “Per un campione di n estrazioni x1, x2, ... xn; qualunque sia la funzione di densità di probabilità p(x), la variabile: y = n-½Sk (xk-) converge in distribuzione ad una particolare funzione, denominata p.d.f. “Normale”, N(,2)” LA DISTRIBUZIONE NORMALE DI GAUSS Per p=1 la distribuzione normale ha la forma: N(,2) = (22)-½ exp [-(x-)2 /22)] interamente definita dai parametri ,2, quindi dai momenti del primo e secondo ordine. Densità di probabilità DISTRIBUZIONE NORMALE 0.4 0.3 0.2 0.1 0 -3 -2 -1 0 x/std.dev-media 1 2 3 CONVERGENZA ALLA DISTRIBUZIONE NORMALE DISTRIBUZIONE DI UNA MEDIA 120 FREQUENZE 100 n=1 80 n=2 60 n=5 n=10 40 20 1 0,8 0,6 0,4 0,2 0 -0,2 -0,4 -0,6 -0,8 -1 0 MEDIA La immagine mostra la rapida convergenza alla normale di una media di n numeri a distribuzione uniforme. LA DISTRIBUZIONE DEI QUADRATI La somma y dei quadrati di p variabili normali a media nulla =0 ed a varianza unitaria 2=1 ha una distribuzione chi-quadratica con p gradi di libertà: 2(y)= [2 p/2 (1/2p)]-1yp/2-1e-y/2 DISTRIBUZIONE CHI QUADRATO 0,40 0,35 DENSITA' 0,30 p=1 p=4 p=16 0,25 0,20 p=2 p=8 p=20 0,15 0,10 0,05 0,00 0 10 20 30 y 40 LA FUNZIONE DI VEROSIMIGLIANZA Sia stata estratta una sequenza di n vettori indipendenti Xi costituenti un campione X e sia assegnata una famiglia di k p.d.f.s, f1, f2, … fK. La probabilità congiunta della sequenza è diversa per ciascuna delle k ipotesi, corrispondenti a k diverse attribuzioni del campione. La funzione di verosimiglianza dell’ipotesi k-esima è una densità di probabilità congiunta, quindi un prodotto del tipo: L(fk|X) = p(x|fk) = ifk(Xi) Si tratta di una funzione della pdf propria di ogni possibile ipotesi che non gode di nessuna delle proprietà asssiomatiche della probabilità. LA FUNZIONE DI VEROSIMIGLIANZA NORMALE Si assuma una famiglia di p.d.f. (p.es. normali, binomiali, etc.) definita da una forma funzionale f e da un vettore di parametri = (1,2, … m). Nel caso della distribuzione normale con p=1 = (,2) ed f = N(,2), quindi: p(x|) = p(x|,2) = L( ;x) = L(,2;x) = (22)-½nJ exp -[Si(xi-)2 /22)] La funzione di verosimiglianza logaritmica è: l = -1/2 n log (22) - Si(xi-)2 /22) L, come funzione di ,2, non è una p.d.f, e non gode di proprietà assiomatiche. LA DISTRIBUZIONE MULTIVARIATA NORMALE Campioni di vettori aleatori composti da p variabili, congiuntamente normali, sono governati dalla funzione di densità di probabilità (p.d.f) multivariata N(;S): p(x |;S) = |2S |-1/2 exp -[(x - ) S-1 (x - )’] dove e S sono i valori attesi di x* e di W. Le sezioni di isoprobabilità di p(x|;S) sono superfici di ellissoidi p-dimensionali: di volume p/2 i ai/ (p/2+1) e di area p/2 p(i ai)(p-1)/p / (p/2+1) LA DISTRIBUZIONE MULTIVARIATA NORMALE SEZIONI NORMALI EQUIPROBABILI IL TEOREMA DI BAYES NEL CONTINUO Sia X un vettore di n osservazioni x1, x2, … xn di una popolazione regolata da una pdf p(x) per la cui definizione sono necessari k parametri 1, 2, … k come accade per la distribuzione normale interamente definita da e (k=2). Nell’approccio bayesiano le sono esse pure variabili aleatorie governate dalle loro proprie pdf, p(). La probabilità congiunta riscritta per il continuo: p(X,) = p(X/) p() = p(/X) p(X) Da cui il teorema di Bayes nel continuo: p(/X) = p(X/) p()/p(X) LA PROBABILITÀ A PRIORI DEL CAMPIONE Nella formula compaiono due probabilità di eventi che precedono l’estrazione del campione X e sono dunque a-priori, la p(X) e la p(). Per calcolare p(X) non c’è che da integrare su i due termini della formula di Bayes e rammentare che l’integrale della probabilità a posteriori deve essere 1. Ne segue che la: p(X) = p(X/) p() d = costante è un valore che, estratto X, è sempre lo stesso. Svolge il ruolo di coefficiente di normalizzazione. Nella formula di Bayes espressa in forma di chances (odds) si semplifica a numeratore-denominatore. LA PROBABILITÀ A PRIORI DELL’IPOTESI La seconda probabilità a priori, p(), esprime tutto quello che sappiamo a priori sull’oggetto del test, ivi compresa la colpevolezza o l’innocenza di uno o più imputati. Se X è un vettore di formanti di una voce incognita, che si ritiene possa appartenere ad uno tra m parlatori noti, o a viene assegnato il valore j del parlatore j-esimo che si confida essere l’anonimo, o gli si attribuisce un valore non informativo, che non può che essere quello che definisce la pdf dell’intera popolazione cui appartengono tutti i parlatori LA VEROSIMIGLIANZA L’operazione sperimentale informativa che noi eseguiamo consiste effettivamente nella estrazione del campione X un vettore di n osservazioni x1, x2, … xn Il teorema delle probabilità congiunte, data l’indipendenza delle n misure, permette di scrivere: p(X/) = L(|X) = i p(xi/) Ed infine di ricavare la pdf a posteriori da due pdf a priori e dalla verosimiglianza di un dato campionario: p(/X) = p(X/) p()/p(X) IL CASO NORMALE MONOVARIATO Supponiamo che la pdf a priori sia normale: N(,2) = (22)-½ exp [-(-)2 /22)] e che di tipo normale sia anche la verosimiglianza espressa rispetto alla media del campione x: L(|X) exp [-(-x)2 /2w2)] Si dimostra senza difficoltà che posto: = (-2 + w-2x)/(-2 + w-2) la probabilità a posteriori è ancora una normale: p(/X) = N(; (-2 + w-2)-1] INFERENZA BAYESIANA_1 Supponiamo che siano state eseguite n osservazioni di una variabile normale monodimensionale x di cui sia nota la varianza w2 e si supponga una distribuzione a priori noninformativa (>>w). Si calcola la pdf a posteriori: N(x,w2/n) = (2w2/n)-½ exp [-n(-x)2 /2w2)] Con la semplice utilizzazione di una tavola della distribuzione normale si può determinare l’intervallo attorno ad x che racchiude l’importo voluto di probabilità, di norma il 99%, intervallo bayesiano HPD (high probability region). INFERENZA BAYESIANA_2 Supponiamo che siano state eseguite n,m osservazioni di due variabili normali x, z monodimensionali di pari varianza w2. Si supponga una distribuzione a priori noninformativa (>>w). Si calcola la pdf a posteriori nei due casi. Se w è nota la pdf è normale: N(x-z,w2/(1/n+1/m)) Se viceversa w non è noto ed è stimato come media pesata delle due varianze campionarie: s2 = 1/(n+m-2) [(n-1)Sx2 + (m-1)Sz2] la variabile: t = [ -(x-z)]/s(1/n+1/m)1/2 è distribuita come una T di Student: T(0, 1, n+m-2) T DI STUDENT La pdf di Student ha code più alte, fianchi più stretti e varianza maggiore rispetto alla normale cui tende rapidamente all' aumentare dei gradi di libertà. x s/ n ~ t di Student (con n=n-1 g.d.l.) f(t) 0.4 gaussiana 0.3 0.2 p=0.1 n t di Student (n=2) 0.1 p=0.1 0 l l -8 -6 -4 -2 0 1.28 1.89 2 4 6 t8

Scaricare