Metodi e strumenti per “grandi” problemi Annalisa Massini Dipartimento di Informatica Introduzione I grandi problemi su cui l'uomo si interroga sin dall'antichità sono problemi che nascono dalla curiosità-necessità di sapere come si è formato l'universo in cui viviamo, come è fatto l'uomo, cosa determina l'unicità di ogni essere umano e… se il nostro mondo continuerà ad essere vivibile. Da sempre filosofi e scienziati tentano di rispondere a queste domande: • nel passato con risposte di tipo filosofico-religioso • attualmente con risposte di stampo più prettamente scientifico. 2 Introduzione La scienza computazionale • si occupa di trovare modelli matematici e tecniche numeriche per affrontare problemi scientifici (non solo) • utilizza i modelli trovati per esplorare e studiare i problemi e per trovare soluzioni usando calcolatori. Le simulazioni numeriche • rendono possibile lo studio di fenomeni complessi che sarebbe troppo costoso, troppo pericoloso, troppo lungo nel tempo studiare con una sperimentazione diretta, • sono diventate parte integrante dei processi di progettazione, sviluppo e decisione • sono lo strumento essenziale per l’investigazione scientifica. 3 Introduzione Il metodo basato su simulazioni della scienza computazionale può essere ormai considerato il terzo modo di fare scienza, oltre ai due metodi tradizionali sperimentale e teorico: • tradizionalmente il metodo scientifico parte dall’osservazione dei fenomeni, registra i dati relativi alle misure e analizza le informazioni ricavate per spiegare e modellare i fenomeni osservati • attualmente si eseguono simulazioni per osservare i fenomeni. Per eseguire simulazioni numeriche adeguate sono state progettate e realizzate architetture per calcolatori ad alte prestazioni. 4 Introduzione • L’introduzione di calcolatori ad alte prestazioni, ha permesso di ampliare i metodi della ricerca scientifica che adesso può utilizzare modelli matematici molto più sofisticati e simulare fenomeni che non è possibile ottenere con sperimentazioni. • Gli attuali supercalcolatori possono raggiungere prestazioni dell’ordine di grandezza del Petaflop = 1015 flop, un milione di miliardi di operazioni in virgola mobile. • Il primo a raggiungere prestazioni dell’ordine del Petaflop è stato Roadrunner dell’IBM, nel 2008 (Los Alamos National Laboratory), superato poco dopo da Cray Jaguar 5 Introduzione • Supercalcolatori con prestazioni dell’ordine del Petaflop • creano flussi di dati dell’ordine dell’exabyte=1018 byte • devono essere in grado di gestire exabyte di dati • Ad esempio, il progetto per il radio telescopio ASKAP (Australian Square Kilometre Array Pathfinder) comprenderà un array di 36 antenne di 12m di diametro. • In una settimana genererà più informazioni di quelle attualmente contenute in tutto il World Wide Web e richiederà una nuova rete in fibra ottica per il trasporto di dati dall’osservatorio al centro di calcolo. 6 Introduzione La scienza computazionale porta alla generazione di quantità di dati al di là delle attuali capacità di analisi e comprensione servono metodi che portino a nuove scoperte scientifiche utilizzando grandi quantità di dati. La distribuzione delle informazioni può essere considerata il quarto paradigma della scienza: si può ottenere attraverso strutture di calcolo mirate alla condivisione, gestione, visualizzazione e analisi delle grandi masse di dati ottenuti. Servono strumenti nuovi progettati a questo scopo, come in passato si sono progettati microscopi, telescopi e i più svariati strumenti e, successivamente, calcolatori. 7 Introduzione I problemi in cui le grandi simulazioni giocano un ruolo chiave includono astrofisica, biologia e chimica computazionale, previsioni climatiche e molte altre. I problemi provengono quindi da molte discipline: • gli scienziati hanno bisogno di competenze informatiche • gli informatici devono sapere affrontare gli specifici problemi scientifici Serve: • sapere individuare le metodologie scientifiche ed informatiche corrette e le architetture di calcolo adatte Il calcolatore è lo strumento essenziale dell’investigazione scientifica. 8 Introduzione Per risolvere un problema con simulazioni computazionali: • sviluppare un modello matematico per descrivere il fenomeno o il sistema fisico tramite equazioni • utilizzare i metodi appropriati per la risoluzione numerica delle equazioni • sviluppare programmi con opportuno linguaggio o ambiente sw • scegliere un’architettura appropriata • rendere comprensibili i risultati usando una visualizzazione grafica adeguata • interpretare i risultati • ripetere alcuni dei passi precedenti 9 Introduzione Lo sviluppo tecnologico deve quindi essere rivolto alla progettazione e realizzazione: • di supercalcolatori con • prestazioni sempre più elevate • capacità di gestione ed elaborazione di grandi masse di dati prodotti dalle simulazioni e strumentazioni scientifiche • di sistemi che permettano a scienziati e ricercatori di condividere le informazioni mettendo a disposizione • i risultati delle simulazioni scientifiche • il contenuto dei database realizzati. 10 L’origine e l’evoluzione dell’universo L’universo • La cosmologia è la scienza che studia l'universo nel suo insieme e ne vuole spiegare l'origine e l'evoluzione. • Ha le sue radici nella narrazioni religiose riguardo l'origine di tutte le cose, cosmogonia, e nei grandi sistemi filosofici. • La cosmologia moderna nasce fra il 1915 ed il 1929: • nel 1915 Einstein pubblicò il primo articolo sulla teoria della relatività generale • nel 1929 Hubble scoprì la legge, che porta il suo nome, che implica che l‘universo è in espansione. • La teoria della relatività di Einstein sostituiva la teoria della gravitazione universale newtoniana. 12 Einstein e Hubble - Mt. Wilson-Observatory, 1931 L’universo • Einstein per primo applicò la sua teoria al calcolo dell'evoluzione dinamica dell'universo e trovò che, assumendo che la materia sia distribuita nell'universo in modo omogeneo, anche un universo infinito tenderebbe a collassare su sé stesso. • La cultura del periodo (idee newtoniane e teologia dell'epoca) resero Einstein dubbioso sulle implicazioni della sua teoria e lo portarono a modificare le sue equazioni introducendo un termine repulsivo, la costante cosmologica Lambda, per controbilanciare l'azione attrattiva del campo gravitazionale, rendendo l'universo statico. 13 L’universo L’introduzione della costante cosmologica fece emergere: • esiste un unico valore della costante cosmologica che consente di avere un universo in equilibrio statico • ogni altro valore, anche estremamente prossimo a quello indicato da Einstein, conduce ad un universo in collasso o in espansione. • Nel 1922 Friedmann abbandonò l'ipotesi che l'universo fosse statico e trovò che le soluzioni delle equazioni della relatività generale indicavano che all’inizio l'universo era infinitamente denso e da allora si era espanso. • Nel 1927 anche Lemaître arrivò allo stesso risultato in modo indipendente. 14 L’universo • La metrica di Friedmann-Lemaître-Robertson-Walker o FLRW è una metrica di Riemann che descrive a grande scala un universo omogeneo e isotropo (cioè che rispetta il principio cosmologico derivante dalle equazioni di Einstein) in espansione o in contrazione. • Queste idee trovarono conferma sperimentale nella scoperta di Hubble che notò che tutte le galassie osservate, dalle più vicine fino a quelle poste a centinaia di milioni di anni luce, si allontanano da noi ad una velocità proporzionale alla loro distanza, cioè l'universo si sta espandendo, legge di espansione dell'universo. 15 L’universo Evolution of our universe. Credit: NASA 16 L’universo Einstein, alla luce della scoperta di Hubble, dichiarò che l'introduzione della costante cosmologica nelle sue equazioni costituì il più grande errore della sua carriera. Nel 1965 Penzias e Wilson scoprirono casualmente la radiazione cosmica di fondo, che • mostra che tutto l'universo si è raffreddato fino a -270 gradi centigradi dopo l'esplosione iniziale • è ritenuta essere il residuo termico del Big Bang • ha posto fine alla controversia fra i sostenitori del Big Bang e quelli della teoria dello stato stazionario. 17 L’universo La scoperta della radiazione cosmica ha portato allo sviluppo del modello inflazionario, secondo il quale l’universo, subito dopo essere nato, ha attraversato una fase di espansione esponenziale, estremamente rapida ed accelerante, (nel modello tradizionale è decelerante). • La costante cosmologica ripudiata da Einstein ha un ruolo fondamentale per spiegare il Big Bang e la dinamica dell'universo. • Le osservazioni del telescopio spaziale Hubble hanno messo in evidenza che l'universo mostra un'espansione accelerata. 18 Visualization of the early Universe as it condensed Credits: Argonne National Lab. L’universo • Le equazioni di Einstein sono equazioni differenziali parziali non lineari, cioè equazioni difficili da risolvere in modo esatto. • Ci sono soluzioni esatte per casi specifici, come per lo studio di buchi neri o le soluzioni nel modello di FriedmannLemaître-Robertson-Walker per un universo in espansione. • Data la difficoltà, spesso le equazioni di Einstein vengono risolte usando metodi di integrazione numerica. • Supercomputer sono utilizzati per simulare la geometria dello spazio-tempo e risolvere le equazioni di Einstein in situazioni particolari, come la collisione di buchi neri o la distribuzione di materia e i suoi movimenti, usando come riferimento la velocità della luce. L’universo • I risultati ottenuti con il satellite WMAP nel 2003 hanno confermato il modello dell’inflazione CDM e mostrato che: • solo il 4-5% di tutta la materia del nostro universo è materia ordinaria (o barionica), fatta di atomi, la maggior parte della quale consiste di idrogeno ed elio • circa il 73% è una forma di Energia oscura uniformemente distribuita che accelera l’espansione cosmica • circa il 23% è Materia Oscura Fredda (Cold Dark Matter). • La vera natura della materia oscura e dell’ energia oscura sono tra i più profondi problemi della fisica. 20 La mappa delle anisotropie ottenuta da WMAP in 5 anni WMAP/NASA) L’universo Le simulazioni cosmologiche giocano un ruolo chiave nello stabilire di cosa è fatto il nostro universo, come si è formata la sua struttura e come si evolva nelle galassie o nei cluster di galassie che vediamo intorno a noi. Il Virgo Consortium, formato da astrofisici provenienti da Regno Unito, Germania, Giappone, Canada e USA, ha rilasciato il 2 Giugno 2005 i primi risultati della più grande e realistica simulazione della crescita di una struttura cosmica e della formazione di galassie e quasar, pubblicati poi su Nature 21 Millennium simulation • Il Virgo Consortium mostra come il confronto di dati simulati e dati dovuti alle estese osservazioni possa rivelare i processi fisici mettendo in evidenza la creazione di reali galassie e buchi neri. Millennium Simulation: • • • ha utilizzato più di 10 miliardi di particelle, ognuna delle quali rappresenta circa un miliardo di masse solari di materia oscura ha considerato una regione cubica dell'universo di 2 miliardi di anni luce per lato, 22 il volume è stato popolato con circa 20 milioni di “galassie”. Millennium simulation • Per Millenium Simulation, il supercomputer del Max Planck Supercomputing Centre a Garching, Germania, è stato occupato più di un mese per l'elaborazione. • L’evoluzione dei circa 20 milioni di galassie e buchi neri è stata ricreata applicando sofisticate tecniche di modellazione ai 25 Tb di output archiviato. • Il supercomputer usato è un IBM pSeries e include: • 28 nodi di calcolo, • 2 nodi per I/O, • uno switch ad alte prestazioni • una memoria principale di 2 TB. Il sistema operativo è AIX, versione IBM di Unix. 23 Simulation by Roadrunner Il 26 ottobre 2009 è stato annunciato “Scientists use world's fastest supercomputer to model origins of the unseen universe” Il Roadrunner Model sviluppato dal gruppo di Nuclear and Particle Physics, Astrophysics and Cosmology di Los Alamos: • serve per una delle più grandi simulazioni del mondo per lo studio della distribuzione di materia nell’universo • permette di guardare solo un piccolo segmento dell’universo “osservabile” • ma per la simulazione serve un supercalcolatore dalle prestazioni dell’ordine del Petaflop, il Roadrunner. 24 Simulation by Roadrunner Il team di Los Alamos: • ha scritto il codice in modo da sfruttare in pieno sia l’architettura del Roadrunner, • ha generato programmi per l’analisi e la visualizzazione dei dati ottenuti con le simulazioni • ha studiato un modello particelle-griglia gerarchica per far combaciare gli aspetti fisici della simulazione con l’architettura ibrida del Roadrunner. Nel modello: • l’unità di base del modello è una particella con una massa di un miliardo di soli circa • il modello include più di 64 miliardi di queste particelle • ogni galassia ha massa pari a circa mille miliardi di soli. 25 Roadrunner Il Roadrunner è un sistema ibrido sviluppato nel Los Alamos National Lab. da IBM in collaborazione con US Dept. of Energy • 6480 dual-core AMD Opterons con 51.8 TB RAM • 12960 PowerCell 8i core con 51.8 TB RAM • utilizza connessioni InfiniBand per collegare i componenti, • utilizza il sistema operativo Red Hat Enterprise Linux, • occupa circa 1100 metri quadrati, • consuma 3.9 MegaWatt di potenza • durante test eseguiti a giugno 2008 ha raggiunto il petaflop durante l'esecuzione di Linpack. Il progetto genoma Progetto genoma L’obiettivo del progetto genoma era quello di determinare la sequenza di basi azotate che formano il DNA, cioè delineare le mappe genetiche e fisiche di un dato organismo. Il Progetto Genoma Umano (the Human Genome Project): • aveva come scopo finale la descrizione completa del genoma umano mediante il sequenziamento • ha avuto inizio nel 1990 presso i National Institutes of Health degli Stati Uniti • la prima bozza del genoma è stata rilasciata nel 2000 • la sequenza completa si è avuta nel 2003. Un progetto parallelo e indipendente dal governo è stato condotto dalla Celera Corporation. 28 Progetto genoma • Il genoma è contenuto all’interno di ogni cellula del corpo umano e governa lo sviluppo umano. • Il patrimonio genetico di ogni individuo è contenuto nel genoma sotto forma di lunghe molecole di DNA, i cromosomi. • Ogni cromosoma è una lunga stringa di DNA arrotolato in una specie di gomitolo. • ll genoma umano è costituito da circa 3 milioni di basi nucleotidiche e l'opera di sequenziamento, cioè l'identificazione dell'ordine dei nucleotidi, ha rivelato che contiene circa 30-40 000 geni. 29 Progetto genoma • L'informazione genetica è codificata tramite un codice a quattro lettere che rappresentano i quattro nucleotidi che formano il DNA, cioè adenina, citosina, guanina, timina, abbreviati con le iniziali A, C, G, T. • I cromosomi comprendono milioni di copie delle 4 lettere che sono disposte in geni e sezioni che non sono geni, ma che hanno funzioni in parte di regolazione e controllo e in parte ancora ignota. Progetto genoma Per leggere il DNA i cromosomi sono ridotti in frammenti ognuno dei quali viene poi letto individualmente. • Le sequenze dei cromosomi interi vengono poi ricostruite a partire dalle sequenze di centinaia di migliaia di frammenti di DNA. • Per sequenziare il genoma sono stati due approcci che differiscono nel modo in cui si taglia e si riassembla il DNA e nel fatto che mappino i cromosomi prima o dopo aver decodificato la sequenza: •sequenziamento gerarchico •sequenziamento shotgun 31 Progetto genoma Sequenziamento gerarchico Si crea prima una mappa fisica dell’intero genoma tagliando il cromosoma in grandi frammenti e tenendo traccia di questi prima di procedere al sequenziamento. • Più copie di un cromosoma vengono tagliate in modo casuale in frammenti lunghi circa 150,000 bp (coppie di basi) e fatti replicare in un BAC - Bacterial Artificial Chromosome. • Ogni frammento viene tagliato con un singolo enzima in modo da ottenere un’etichetta di identificazione univoca. • Sovrapponendo i BAC si può determina la posizione dei BAC e la mappa di ogni cromosoma. • Ogni BAC viene poi spezzato in modo random in pezzi di 1500 bp • Si sequenziano le 500 bp ai lati di ogni frammento. • Tramite programma si uniscono i diversi frammenti cercando sequenze comuni. Progetto genoma Whole Genome Shotgun Sequencing • • • • Questo metodo non genera la mappa fisica ed è quindi molto più veloce. • Alcune copie del genoma vengono fatte in pezzi di 2,000 bp (base pairs) usando una siringa pressurizzata. Altre copie vengono ridotte in pezzi da 10,000 bp. I frammenti da 2,000 bp e 10,000 bp vengono inseriti in un pezzo di DNA che può replicarsi in un batterio. Si decodificano le 500 bp ai due lati di ogni frammento delle due collezioni da 2,000 e 10,000 bp, “plasmid libraries”. Sequenziare gli estremi di ogni pezzo è la parte cruciale per ricomporre il cromosoma. I milioni di frammenti sequenziati vengono assemblati tramite programmi, si ottiene così ogni singolo cromosoma. 33 Progetto genoma • Il sequenziamento completo del genoma fornisce dati grezzi: 6 miliardi di lettere per il DNA di un individuo. • La sequenza completa del DNA del genoma di un individuo, non fornisce di per sè informazioni cliniche utili. • Affinchè i dati forniti dal sequenziamento del genoma possano essere utilizzati è necessario fornire una analisi di essi per capire il loro significato e ottenere informazioni utili, ad esempio a prevenire malattie. • Bisogna avere a disposizione metodi per: accedere alle informazioni velocemente e facilmente poter trasformare le informazioni in altre informazioni 34 Progetto genoma I risultati aspettati dal progetto genoma umano sono: • rivoluzione nella diagnosi e cura di malattie a base genetica • progressi nella comprensione dell’evoluzione molecolare e biologia di base. • I risultati prodotti dal progetto genoma saranno la base di un’altra rivoluzione nella biologia. • Nel 1991 Gilbert (in Towards a paradigm shift in biology, Nature) osservava che il progetto genoma stava producendo un cambiamento nei paradigmi usati dai biologi per fare esperimenti, procedere nella comprensione ed estendere le conoscenze in biologia. 35 Progetto genoma • La biologia è una scienza sperimentale descrittiva. • Nel nuovo paradigma, usando le nuove metodologie i biologi usano le informazioni rese disponibili dal progetto genoma sulla sequenza di nucleotidi del genoma e altre informazioni ricavate dai database per cominciare a proporre congetture predittive, seguite da esperimenti. • Questo cambiamento di paradigmi comporta un cambiamento da una scienza quasi completamente sperimentale verso una scienza sempre più fortemente predittiva. 36 Progetto genoma • Il sequenziamento del DNA è una componente irrinunciabile di praticamente qualunque tecnica di manipolazione genica. • Ancora più importante è il fatto che le informazioni ottenute tramite il sequenziamento sono la base indispensabile per la messa in atto di qualsiasi procedura di manipolazione del DNA. • Determinare la sequenza di una particolare regione di DNA può rappresentare un fine già di per sé, ad esempio se si vuole studiare una mutazione ereditaria. Progetto genoma Sin dalla nascita del progetto genoma, si è delineata una crescente necessità di: potenza di calcolo, sia velocità che efficienza capacità di memoria e progetto database adeguati comunicazioni rapide tra computer fisicamente lontani estrazione e visualizzazione delle informazioni generate estrazione dei principi che governano i processi biologici dall’analisi delle informazioni raccolte. 38 Progetto genoma L’introduzione di nuove tecniche di sequenziamento e la recente realizzazione di piattaforme di next generation sequencis – come quelle di Roche, Illumina and SOLiD – permettono di ottenere il sequenziamento del genoma in pochi giorni. La quantità di dati ottenuta per un genoma corrisponde a qualche TeraByte. La velocità di sequenziamento e la quantità di memoria richiesta stanno generando nuove richieste per tecniche di memorizzazione e compressione, condivisione e trasferimento informazioni. Blue Gene Blue Gene è il nome di un'architettura di supercomputer a parallelismo massivo nato per sviluppare metodi di calcolo per la comprensione di processi biologici fondamentali, come ad esempio il funzionamento delle proteine. Il progetto è una cooperazione del United States Department of Energy, IBM e Università e si è poi differenziato in diversi progetti Blue Gene (Blue Gene/L, il Blue Gene/C e il Blue Gene/P, con potenze di calcolo che vanno dalle decine di teraflop al petaflop Nel novembre 2007 BlueGene era il più potente computer del pianeta. Il primato gli è stato tolto nel giugno 2008 da IBM Roadrunner. La modellazione del clima Modellazione del clima Il GCM, General Circulation Model o Global Climate Model, è un modello matematico per la descrizione della circolazione dell’atmosfera e degli oceani sul pianeta. The instantaneous net ecosystem exchange (NEE) of CO2 from a C-LAMP simulation during July 2004. Green = uptake by the biosphere; red= net flux into the atmosphere. Produced by J.Daniel for the NCCS Annual Report. Il GCM usa le stesse equazioni usate nel modello di previsioni meteorologiche Numerical Weather Prediction, NWP, per simulare numericamente i cambiamenti climatici conseguenti ai lenti cambiamenti di parametri fisici, come le concentrazioni dei gas responsabili dell’effetto serra. Modellazione del clima • Le prime versioni di GCM progettate per applicazioni climatiche su scale temporali dai decenni ai secoli sono dovute a Manabe e Bryan del Geophysical Fluid Dynamics Laboratory di Princeton, New Jersey, 1969. • Manabe e Bryan furono i primi ad eseguire simulazioni di un modello climatico globale accoppiando i modelli atmosferico e oceanico e stabilendo così il ruolo dell’oceano nel trasporto del calore. • I modelli attuali simulano la circolazione dell’oceano in superficie e in profondità, accoppiata alla circolazione atmosferica, modellando lo scambio che avviene attraverso la superficie dell’oceano. 43 Modellazione del clima • Vengono quindi accoppiati i cambiamenti veloci che avvengono nell’atmosfera con quelli lenti che avvengono negli oceani. • I GCM possono inoltre essere accoppiati a modelli dinamici dei ghiacci oceanici e alle condizioni sulla superficie della terra (mentre i modelli NWP non sono invece accoppiati al modello dinamico dell’oceano). •I modelli numerici di calcolo intensivo sono basati sull’integrazione di un insieme di equazioni per la fluidodinamica, equazioni di Navier-Stokes, su una sfera rotante. 44 Results from the Parallel Climate Model, by Gary Strand, NCAR Modellazione del clima Le equazioni di Navier-Stokes costituiscono un sistema di equazioni differenziali alle derivate parziali che descrive il comportamento di un fluido dal punto di vista macroscopico, modellandolo come un continuo deformabile. Con le equazioni di Navier-Stokes si formalizzano matematicamente tre principi fisici ai quali i fluidi così modellati devono sottostare: • principio di conservazione della massa (equazione di continuità); • secondo principio della dinamica (bilancio della quantità di moto); • primo principio della termodinamica (conservazione dell'energia). 45 Modellazione del clima Le 3 equazioni (due scalari ed una vettoriale) non sono sufficienti, da sole, alla determinazione del campo di moto del fluido, poichè contengono 20 incognite: • densità, vettore velocità (3 incognite), pressione, tensore degli sforzi viscosi (9 incognite), vettore accelerazione di campo (3 incognite), energia interna e vettore flusso termico, riconducibile a una funzione di un coefficiente di conducibilità termica e della temperatura (2 incognite). 46 Modellazione del clima E’ necessario quindi: • definire le proprietà termo-fisiche del fluido (densità, conducibilità termica, energia interna, ecc.) e il campo di forze in cui si muove (vettore accelerazione di campo); • imporre condizioni al contorno e condizioni iniziali. A causa della loro non linearità, le equazioni di NavierStokes non ammettono quasi mai una soluzione analitica, ma si deve determinare una soluzione approssimata con un metodo numerico. 47 Simulare l’effetto serra Il General Circulation Model, GCM, è stato usato per studiare il riscaldamento causato dal raddoppiamento del biossido di carbonio su un periodo di 20 anni. • Le prime simulazioni furono fatte negli anni ’90 sul calcolatore vettoriale CRAY-1, che raggiungeva picchi di velocità di 200 Mflops (2x102x106 floating point operation/sec): ogni giorno simulato richiedeva 110 sec due simulazioni da 19 anni richiesero oltre 400 ore di calcolo 48 Simulare l’effetto serra • Si utilizza una griglia 3D • La velocità del calcolatore è importantissima infatti: la griglia usata era composta di 2000 punti per coprire la superficie terrestre e da 9 livelli di altitudine, per un totale di 18000 punti In ogni punto della griglia si hanno 8-9 variabili (temperatura, concentrazione di CO2, velocità del vento, …) • 49 Simulare l’effetto serra Osservazioni • La griglia utililizzata è molto rada: su Spagna-Portogallo cadono 2 punti • Raddoppiando la densità di punti sulla superficie terrestre: i punti di griglia nelle tre dimensioni aumentano di un fattore 8 da 400 ore si passa a più di 3000 ore di calcolo, avendo sempre pochi punti su Spagna-Portogallo 50 Simulare l’effetto serra • Sulle simulazioni per le previsioni dei cambiamenti climatici si studia e si investe moltissimo August 24, 2009 NASA’s Goddard Space Flight Center Greenbelt, Md made available to scientists in August the first unit of an expanded high-end computing system that will serve as the centerpiece of a new climate simulation capability … The expansion added 4,128 computer processors to Goddard’s Discover high-end computing system. The IBM iDataPlex "scalable unit" uses Intel’s newest Xeon 5500 series processors, which are based on the Nehalem architecture introduced in spring 2009. … installation of another 4,128 Nehalem processors this fall, bringing Discover to 15,160 processors. fonte: http://earthobservatory.nasa.gov/Newsroom 51 Architetture per il calcolo ad alte prestazioni Architetture L’architettura di un supercomputer è caratterizzata da: • presenza di migliaia di unità di calcolo • connessioni ad alta velocità tra le unità di calcolo • coordinamento delle comunicazioni da parte di estensioni apposite del sistema operativo, generalmente Unix Sono richieste prestazioni sempre più elevate e ottimizzate: • per eseguire alcuni tipi di operazioni e metodi di calcolo • accedere raramente alla memoria principale, utilizzando maggiormente una memoria locale più vicina al processore Le principali applicazioni per cui si utilizzano supercomputer riguardano problemi che richiedono processi di calcolo intensivo caratterizzati dalla ripetizione di passi elementari. Architetture Dalle classifiche TOP500 2000 IBM ASCI White Lawrence Livermore Nat. Lab. USA 7.22 TFLOPS 2002 NEC Earth Simulator Center, Giappone 35.86 TFLOPS 2004 SGI Project Columbia, NASA Adv. Supercomp. USA 42.70 TFLOPS 2004 IBM Blue Gene/L (32 768) DOE/IBM, USA 70.72 TFLOPS 2005 IBM Blue Gene/L (65 536) DOE/NNSA/LLNL, USA 136.8 TFLOPS 2005 IBM Blue Gene/L (131 072) DOE/NNSA/LLNL, USA 280.6 TFLOPS 2007 IBM Blue Gene/L (212 992) DOE/NNSA/LLNL, USA 478.2 TFLOPS 2008 IBM Roadrunner Los Alamos Nat. Lab., USA 1.026 PFLOPS 2009 Jaguar Cray XT5-HE Oak Ridge Nat. Lab.USA 1.759 PFLOPS 54 Architetture Jaguar Cray • 84 cabinet quad-core Cray XT4 system con 8 gigabytes of memory per node and • 200 upgraded Cray XT5 cabinets, using six-core processors. 16 gigabytes per node • total of 362 terabytes of high-speed memory • Scalable I/O Network (SION), which links The two systems together and to the Spider file system. • XT5 256 service and I/O nodes providing up to 240 GB/s bandwidth to SION and 200 Gb/s to external networks. • XT4 116 service and I/O nodes providing 44 GB/s bandwidth to SION and 100 Gb/s to external networks. 55 Architetture • Green500 si occupa di classifiche per supercomputer a maggior efficienza rispetto al consumo di energia. • Per decenni la nozione di performance è stata sinonimo di velocità ed è infatti una delle misure più utilizzate è FLOP. • Per ottenere maggiore velocità i supercomputer consumano enormi quantità di energia elettrica e producono quantità di calore tali da necessitare di originali strutture di raffreddamento per poter lavorare. • L’enfasi sulla velocità ha portato ad ignorare metriche come affidabilità e usabilità con conseguente aumento nei costi di manutenzione. Architetture • La classifica di Green500 vuole alzare l’attenzione sul consumo di energia e incoraggiare chi investe in supercomputer ad impegnarsi in modo che i supercomputer servano solo a simulare i cambiamenti climatici e non a generarli. • La lista della Green500 si affianca a quella della TOP500 e confrontando i supercomputer rispetto alla metrica performance-per-watt. • La prima classifica di Green500 è del 2007 e fu annunciata a SC|07. • E’ stata stilata utilizzando come unità di misura la performance misurata in FLOP come per TOP500 e la potenza misurata in watt, FLOP/W. Status of HPC Applications - 2010 • Negli ultimi decenni i satelliti orbitanti intorno alla terra e le • • navicelle inviate nello spazio hanno raccolto grandi quantità di dati. Molti progetti sono volti all’uso di risorse di calcolo ad alte prestazione per utilizzare tali dati e simulare l’universo. La Computational Life Science è diventata una disciplina strategica a cavallo tra biologia molecolare e computer science, con grande impatto sulla medicina e le biotecnologie. Molti metodi e soluzioni computazionali sono nati dalla biologia molecolare. Sin dalle prime realizzazioni di supercalcolatori, la simulazione dell’atmosfera e degli oceani ha permesso di ottenere risultati sia nella modellazione del problema che nello sviluppo di capacità di calcolo sempre più potenti. Uno dei problemi più studiati riguarda il riscaldamento globale. 58 http://www.supercomp.de/isc10/Program/Overview Bibliografia • G. Shainer, B. Sparks, S. Schultz, E. Lantz, W. Liu, T. Liu, G. Misra “From Computational Science to Science Discovery: The next Computing Landscape” http://www.top500.org/files/HPC_Advisory_Council.pdf, 2010 • L.D. Fosdick, E.R. Jessup, C.J. C. Schauble and G.Domik, “Introduction to HighPerformance Scientific Computing”, The MIT Press, 1996 • M.T. Heath, “Scientific computing: An Introductory Survey”, Mc Graw-Hill, 2002 --------------------------------------------------------------------------------------------• http://www.bda.unict.it/Pagina/It/Notizie_1/0/2009/02/23/2589_.aspx • http://www.supercomp.de/isc10/Program/Overview • http://www.ska.gov.au/Pages/default.aspx • http://www.bda.unict.it/Pagina/It/Notizie_1/0/2009/02/23/2589_.aspx • http://www.physorg.com/news181932271.html • http://www.ornl.gov/ • http://earthobservatory.nasa.gov/Newsroom/view.php?id=39925 • http://www.genomenewsnetwork.org/articles/06_00/sequence_primer.shtml59 • http://www.green500.org/home.php

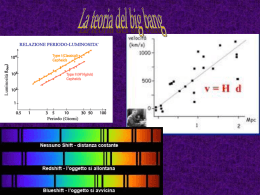

Scarica