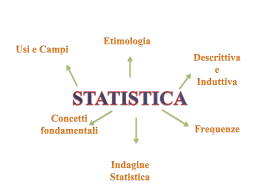

Relatrice Bassi Ilaria Classe 5° D Tur Anno scolastico 2004/2005 1. Etimologia 2. La statistica come raccolta di dati 3. La formalizzazione matematica della statistica 4. Cronologia 1700 – 1799 1800 – 1899 1900 – 1949 Dal 1950 La Statistica è una scienza relativamente giovane il cui contenuto non è ancora visibile in modo corretto perché spesso viene confusa con le statistiche: dati, tabelle, grafici, indici, medie. In effetti, essa è presente in tutte le scienze e rappresenta uno strumento essenziale per la scoperta di leggi e relazioni tra fenomeni. Intervenendo in tutte le situazioni nelle quali occorre assumere decisioni in condizioni d’incertezza, la Statistica si configura come un momento importante della ricerca scientifica, della pianificazione economica e dell'azione politica. L'evoluzione storica della Statistica nasconde due anime che si ritrovano sia nella didattica e nella ricerca sia nel pensare comune dei non specialisti e, quindi, nel linguaggio dei massmedia. Etimologia L'etimologia della parola "Statistica" deriva dal vocabolo italiano "Stato" e fa riferimento, nella quasi totalità dei linguaggi europei, alla constatazione per cui le prime informazioni su fenomeni reali sono state raccolte ed organizzate ad opera degli organismi statali che ne erano anche i principali utilizzatori. Esistono altre versioni circa la derivazione etimologica di "Statistica", come quella che fa riferimento a status, per indicare che tale scienza esamina la situazione contingente della realtà oppure al latino statera (=bilancia), al tedesco Stadt (=città). Anche se convincenti sul piano logico-concettuale, queste derivazioni non trovano riscontri storici obiettivi se paragonati all'uso crescente del termine "Statistica" inteso come raccolta d’informazioni organizzate e gestite dallo "Stato". La prima apparizione del vocabolo "statistica" in questa accezione sembra essere quella dell'italiano Ghislini che, nel 1859, indica la Statistica come "descrizione delle qualità che caratterizzano e degli elementi che compongono uno Stato". Statistica come raccolta di dati La prima anima della Statistica è connaturata all'Homo sapiens che prende coscienza del mondo e dei suoi simili e che, nella lotta alla sopravvivenza, elabora comportamenti ottimali per nutrirsi, difendersi e riprodursi. Tali strategie alternano sconfitte e successi ma, grazie ad approssimazioni successive, permettono il diffondersi di convinzioni, usi e costumi e, alla fine, di conoscenza, scienza e cultura. Quando tali convinzioni si codificano nella vita del clan, della tribù, di un popolo o di una nazione, nascono le regole di comportamento e, quindi, la legge. Questa esigenza conoscitiva cresce con lo sviluppo delle relazioni tra popoli. Con la nascita dei grandi Stati europei, si attribuisce all'analisi statistica dei fenomeni collettivi un interesse pubblico che spinge progressivamente le nazioni occidentali a dotarsi di Istituti "centrali" di Statistica, deputati per legge alla raccolta, organizzazione e diffusione di dati sulla popolazione, sulle abitazioni, sulle risorse economiche e su tutti gli aspetti rilevanti della vita collettiva di una nazione, di una Comunità di stati (Unione Europea) o dell'intero pianeta (Nazioni Unite). Oggi, gli organismi pubblici che istituzionalmente raccolgono e diffondono informazioni statistiche sono innumerevoli ed agiscono secondo una gerarchia di competenze che individua nell'Ente locale la sede prioritaria di raccolta del dato elementare, mentre al verifica, l'aggregazione e la pubblicazione sono di competenza dell'Ente centrale (per l'Italia è l'ISTAT). La formalizzazione matematica della statistica La seconda anima della Statistica nasce da una constatazione differente che solo da pochi secoli ha trovato una formalizzazione compiuta. Di fronte alla realtà che muta, vi sono risultati che meritano più fiducia di altri perché si ripetono con maggiore regolarità. Ciò viene percepito soprattutto in rapporto al clima e all'alternanza delle stagioni ma riguarda anche i raccolti agricoli, le malattie, le vicende umane, ecc. In tali contesti, la mente umana registra regolarità senza certezze, convinzioni non sicurissime, ripetizioni di eventi non sempre garantiti da un esito univoco. Da un lato ciò genera paura e impone cautele contro i rischi (la mutualità prima e le assicurazioni poi), dall'altro sollecita il gioco e la scommessa (inventando artificialmente l'aleatorietà nel risultato tramite semplici strumenti: palline, dadi, carte). Pur essendo ben presente nella storia e nella cultura sin dai primordi della civiltà, la probabilità diventa un concetto importante e ben formalizzato solo a partire dal secolo XVIII anche se, già in precedenza e grazie soprattutto a Galileo, Pascal e Fermat, si può intravedere il sorgere di un nuovo modo di applicare la matematica ai giochi, cioè quella nuova disciplina che sarà poi denominata Calcolo delle probabilità. Si dovrà però aspettare ancora altri duecento anni perché diventi palese la connessione tra le osservazioni incerte e la possibilità di prevederle, controllarle e simularle. Così, all'inizio del 1900, nasce e si diffonde un’impostazione verso lo studio della realtà che trova nell'inferenza il suo nucleo centrale e negli schemi probabilistici degli strumenti utili ed essenziali per assumere decisioni coerenti. La saldatura tra queste due anime della Statistica avviene con molto ritardo e solo quando, di fronte alla natura sempre più sperimentale della conoscenza, ci si pone il problema della validità delle ipotesi. Il metodo statistico diviene nei fatti la metodologia della ricerca scientifica e la prassi nelle analisi dei risultati di laboratorio ancor prima di essere riconosciuto come strumento di indagine autonomo. Oggi, anche in conseguenza dei veloci mutamenti tecnologici ed informatici, si assiste ad un costante tentativo di utilizzare la Statistica a sostegno di tesi predefinite, cioè come uno strumento di convincimento ideologico. Cronologia 1700-1799 • 1708: Pierre de Montmort scrive Essai d'analyse sur le jeux de hasard • 1713: Jakob Bernoulli formula in Ars conjectandi il primo teorema limite, ovvero la legge dei grandi numeri • 1760: un matematico svizzero, Johann Heinrich Lambert, fa uso di grafici di elevata qualità nella sua opera Photometria. • 1782: A.W.Crome, economista tedesco, utilizza nella sua ProductenKarte von Europa quelli che vengono ora chiamati cartogrammi • 1786: William Playfair utilizza decine di diagrammi (soprattutto serie storiche, ma anche il primo diagramma a barre) nel suo Commercial and Politica Atlas 1800-1899 • 1801: William Playfair introduce il diagramma a torta nel suo Statistical Breviary • 1824: La variabile casuale di Cauchy viene Siméon-Denis Poisson vent'anni prima di Augustin Louis Cauchy. Nell'ambito delle critiche alla variabile casuale Normale Poisson dimostra che la media aritmetica di n errori indipendenti distribuiti con la funzione di densità in questione non tende verso una Normale. • 1834: su proposta di Lambert-Adolphe-Jacques Quételet viene fondata la Statistical Society of London • 1835: Lambert-Adolphe-Jacques Quételet pubblica uno scritto nel quale, fra le altre cose, c'erano i dati riguardanti la misura del torace di soldati scozzesi e la statura dei militari di leva francesi. Quételet mostrò come tali dati si distribuivano come una variabile casuale Normale, ma non andò oltre. • 1853: su proposta di Lambert-Adolphe-Jacques Quételet si tiene il primo congresso dell'Istituto Internazionale di Statistica (prima della sua fondazione) • 1879: Luigi Perozzo introduce uno stereogramma rappresentante la piramide tridimensionale della popolazione a partire dei dati dei censimenti svedesi 1750-1875. • 1885: viene fondato l'Istituto Internazionale di Statistica 1900-1949 • 1900 • Karl Pearson presenta la variabile casuale chi quadro • George Udny Yule pubblica in Philosophical Transactions of the Royal Society of London l'articolo "On the association of attributes in statistics" dove introduce l'indice di associazione per tabelle di contingenza 2x2 detto Q di Yule • 1901 • viene fondata Biometrika, rivista britannica, su iniziativa di Karl Pearson, W.F.R.Weldon e Davenport.Tra i suoi finanziatori vi sono Francis Galton, tra i suoi editori lo stesso Karl Pearson. • 1903 • George Udny Yule descrive il Paradosso di Simpson nell'articolo "Notes on the theory of association of attributes in Statistics", comparso in Biometrika, mezzo secolo prima che e E. H. Simpson lo facesse con l'articolo "The interpretation of interaction in contingency tables" nel Journal of the Royal Statistical Society (1951). • 1904 • Karl Pearson introduce il termine tabella di contingenza • Charles Spearman pone le basi dell'analisi fattoriale, studio che completerà otto anni dopo • Charles Spearman propone il coefficiente di correlazione dei ranghi • 1908 • William Sealy Gosset presenta la variabile casuale t di Student e il corrispondente test • 1925 • Ronald Fisher pubblica il notevole Statistical methods for research workers che influenzerà generazioni di ricercatori. In tale testo compare l'analisi della varianza • Ronald Fisher introduce il concetto di gradi di libertà • Durante il congresso dell'Istituto Internazionale di Statistica, dopo polemiche durate anni, una risoluzione adottata distingue tra campionamento casuale e campionamento ragionato • 1933 • Andrey Nikolaevich Kolmogorov pubblica gli assiomi della probabilità in Grundbegriffe der Wahrscheinlichkeitsrechnung. • Andrey Nikolaevich Kolmogorov descrive la statistica |Fn(x) - F0(x)|. • Harold Hotelling fonda l'analisi delle componenti principali • Jerzy Neyman e Egon Pearson pubblicano On the Problem of the Most Efficient Tests of Statistical Hypotheses dove viene descritto l’approccio detto appunto "Neyman-Pearson" sviluppato fin dal 1926 • Durante il congresso dell'Istituto Internazionale di Statistica, su iniziativa di K.Wikler, viene istituita una commissione per la standardizzazione delle rappresentazioni grafiche in statistica • 1935 • Ronald Fisher introduce in The Design of Experiments la regola che gli esperimenti devono essere programmati (disegnati) prima di essere effettuati, affinché i test statistici possano avere una loro validità. In questo ambito introdusse i concetti di ipotesi nulla (H0) e ipotesi sperimentale (H1). Afferma (e si tratta di una grande novità in ambito del metodo scientifico) che nessuna ricerca sperimentale poteva dimostrare l'ipotesi sperimentale, ma solo "accettare" o "respingere" l'ipotesi nulla, anche se effettuare tanti esperimenti in cui si rigettava l'ipotesi nulla aumentava la credibilità che l'ipotesi sperimentale fosse vera. • 1936 • George Gallup ottiene grande notorietà prevedendo correttamente il risultato delle elezioni presidenziali intervistando soltanto 50 mila persone, mentre l'allora molto quotato Literary Digest sbagliò clamorosamente la previsione pur avendo intervistato molte più persone. • 1938 • il fisico Frank Benford analizzò raccolte di numeri formulando la legge di Benford già scoperta nel 1881 dal matematico e astronomo Simon Newcomb e descritta in "American Journal of Mathematics". • 1939 • Vladimir Smirnov costruisce il test di Kolmogorov-Smirnov • La Società Italiana di Statistica viene fondata il 15 gennaio • 1948 • Viene pubblicato l'esito di una ricerca sull'uso della streptomicina per la cura della tubercolosi che ha fatto uso del primo esperimento clinico randomizzato, progettato da Austin Bradford Hill • 1949 • George Kingsley Zipf (1902-1950), linguista e filologo statunitense dopo aver studiato per diverse lingue la frequenza con la quale compaiono le parole, proponendo in "Human Behaviour and the Principle of Least-Effort" una relazione oggi nota come legge di Zipf Dal 1950 • 1960 - Sidney Siegel e John Wilder Tukey pubblicano il test di SiegelTukey nel Journal of the American Statistical Association con l'articolo "A nonparametric sum of ranks procedure for relative spread in unpaired samples". • www.matematicamente.it • www.google.it • www.wikpedia.com • Enciclopedia

Scarica

![I dati e la statistica [d]](http://s2.diazilla.com/store/data/000019594_1-e054456b9f288c40956cf5ac39dc6ad4-260x520.png)