Vittorio Casella

Appunti, parte 1

Fotogrammetria

Topografia e Tecniche Cartografiche

Anno Accademico 2001-2002

Dipartimento di Ingegneria Edile e del Territorio

Università degli Studi di Pavia

Capitolo 1

Il rilevamento e le misure

Esistono fenomeni il cui esito non è prevedibile a priori come il lancio di un

dado o di una moneta, la durata di una lampadina, la misura di precisione

di una grandezza fisica (lunghezza, angolo, temperatura o velocità).

Questi fenomeni presentano una regolarità di fondo, come si può constatare effettuando ripetizioni: anche se non è possibile stabilire con certezza

l’esito del lancio di un dado, è comunque noto che, effettuando molte ripetizioni, la faccia con il numero 1 si presenterà circa 1/6 delle volte. Analogamente in una misura di precisione, per esempio una misura di lunghezza con

riga millimetrata e stima del decimo di millimetro, n ripetizioni forniranno

probabilmente n risultati diversi, ma comunque concentrati in un intervallo

abbastanza ristretto.

I fenomeni che hanno la caratteristica di non essere prevedibili quando si

consideri una sola estrazione (sia essa il lancio di una moneta o l’esecuzione di

una misura), ma che mostrano una regolarità quando si analizzino estrazioni

ripetute, si dicono fenomeni aleatori e sono descritti dalla Probabilità e dalla

Statistica. La prima permette di prevedere il comportamento di un fenomeno

aleatorio noto, come ad esempio calcolare la probabilità che lanciando una

moneta simmetrica (modello noto) si ottenga per tre volte consecutive testa.

La seconda procede nel verso contrario e cerca di conoscere un fenomeno

aleatorio a partire dal suo comportamento; si potrebbe per esempio cercare

di stabilire se una moneta è simmetrica o meno osservando l’esito di molti

lanci.

Le misure di precisione sono un fenomeno aleatorio con cui i rilevatori si

confrontano continuamente; per poter svolgere la propria attività in modo

appropriato, essi devono saper trattare le misure in modo adeguato e, a volte,

piuttosto sofisticato. Questo spiega perchè tutti i testi riguardanti argomenti

di rilevamento abbiano una significativa sezione dedicata al calcolo delle

probabilità e alla statistica.

La nostra trattazione inizia introducendo la terminologia delle misure

e prosegue con alcuni elementi di calcolo delle probabilità e di statistica,

1

Vittorio Casella - Dispense, parte 1

finalizzati al trattamento delle misure.

1.1

Le misure sono fenomeni aleatori

L’interesse della Topografia e della Fotogrammetria per la statistica deriva

dalla necessità di effettuare misure di qualità ed affidabili. Lasciamo ai

metrologi e ai filosofi della scienza il compito, per certi versi appassionante,

di discutere su cosa sia una misura e se esista il valore vero di una misura.

Queste note ricorrono all’idea ingenua di misura e assumono che il valore vero

esista e che riusciremmo a scoprirlo se misurando evitassimo gli innumerevoli

piccoli errori accidentali che fatalmente sporcano il lavoro sperimentale. Un

topografo chiede alla statistica di essere guidato

• per effettuare le migliori misure possibili con una certa strumentazione,

• per conoscere comunque la bontà e la affidabilità delle misure fatte,

• per capire che fare se deve raggiungere una certa precisione,

• per confrontare efficacemente e razionalmente misure prese in momenti diversi e stabilire se la loro differenza sia attribuibile ai soli errori

di misura o abbia altra causa. Se i movimenti di una frana venissero controllati misurando periodicamente la distanza fra due punti, la

varie misure risulterebbero inevitabilmente diverse le une dalle altre

e sarebbe necessario fare ricorso alla statistica per discriminare fra la

fluttuazione casuale e il reale movimento del terreno.

1.2

Precisione e accuratezza

La qualità di una misura si esprime generalmente mediante due termini:

precisione e accuratezza. La prima descrive la concentrazione di misure

ripetute, mentre la seconda esprime la distanza fra le misure ed il valore

vero. Una misura ottimale deve essere ovviamente precisa ed accurata, ma

capita a volte di effettuare misure precise ma non accurate, oppure accurate

ma non precise, oppure anche, nel caso peggiore, non accurate e non precise.

E’ abbastanza calzante una analogia fra le misure e gli spari ripetuti di un

tiratore a un bersaglio, che potrebbero essere:

• vicini gli uni agli altri e concentrati attorno al centro del bersaglio:

misura precisa e accurata (Caso a);

• vicini gli uni agli altri e concentrati attorno ad un punto lontano

dal centro del bersaglio, magari per una srettifica del mirino: misura

precisa ma non accurata (Caso c));

2

Vittorio Casella - Dispense, parte 1

Caso a

Caso b

Caso c

Caso d

• piuttosto dispersi attorno al centro del bersaglio: misura poco precisa

ma accurata (Caso b);

• dispersi attorno a un punto lontano dal centro del bersaglio: misura

poco precisa e poco accurata (Caso d).

La terminologia usata per parlare della qualità della misura non è sempre coerente e per questo può trarre in inganno. Spesso infatti si usa il

termine precisione come indicatore onnicomprensivo della qualità di una

misura, mentre quando si vogliono enucleare i vari aspetti che concorrono

a determinarla, si distingue fra precisione e accuratezza. Sta all’attenzione

del lettore o dell’ascoltatore capire quale sia il reale significato dei termini

usati valutando il contesto nel quale vengono impiegati.

1.3

Precisione assoluta e relativa

Un’altra utile distinzione è fra precisione assoluta (o accuratezza, il discorso

vale per entrambe) e precisione relativa. Sbagliare di un millimetro la misura

della distanza Terra-Luna è un risultato straordinario, mentre sbagliare della

stessa quantità la misura con il calibro del diametro di un piccolo cilindro

metallico costituisce un errore marchiano. La precisione relativa è un numero

puro uguale al rapporto fra l’errore commesso e l’entità delle misure; nel caso

del GPS ad esempio le basi vengono usualmente determinate con errore di

1 mm per Km, dunque la precisione relativa è di 10−6 oppure, come si suole

dire, 1 ppm (una parte per milione).

3

Vittorio Casella - Dispense, parte 1

1.4

Misure dirette e indirette

Le misure vengono distinte in dirette e indirette, a seconda che sia possibile

o meno misurare direttamente ciò che vogliamo conoscere.

• Una misura è diretta quando è possibile misurare direttamente la grandezza X che si desidera conoscere. Se si dispone di un distanziometro

elettronico e si desidera conoscere la distanza fra due punti intervisibili, è possibile misurare direttamente tale distanza. Le proprietà

statistiche di X possono essere messe in luce con tecniche basate sulla

ripetizione delle misure, che verranno descritte in seguito.

• Supponiamo invece che si voglia conoscere la lunghezza di una linea

spezzata, come il confine di una proprietà; una soluzione potrebbe essere misurare direttamente i segmenti che la compongono e poi sommare

la lunghezze parziali. Supponiamo ora, per fare un altro esempio, che

si voglia misurare la superficie di un’area rettangolare: si potrebbero

misurare entrambi i lati e poi moltiplicare le lunghezze. In entrambi

questi casi si vuole conoscere una grandezza X e si sanno misurare

delle grandezze Y legate alla prima da una relazione

X = g(Y )

(1.1)

Il calcolo del valore di X è semplice, ma resta da capire come risalire

alle proprietà statistiche di X, una volta note quelle di Y .

• Supponiamo ora che si voglia caratterizzare il coefficiente di elasticità

di una molla. Una soluzione potrebbe essere sollecitarla con varie forze

note, misurare le elongazioni da esse prodotte e ricavare in questo

modo l’incognita. La lunghezza di una molla varia in funzione della

forza applicata secondo la legge

l = kF + lr

(1.2)

dunque si tratterebbe in questo caso di misurare l e di ricavare k. Si

tratta insomma di un problema in cui il rapporto fra le grandezze da

determinare X e le grandezze misurabili Y è del tipo

Y = g(X)

(1.3)

e la stima di X richiede in qualche modo, che verrà meglio specificato

in seguito, l’inversione della funzione g. Non vi è dubbio che questo

terzo caso sia il più complesso da trattare.

4

Vittorio Casella - Dispense, parte 1

1.5

Importanza della ridondanza

E’ necessario sottolineare che ogni discorso sulla qualità delle misure ha

come condizione necessaria la ridondanza delle informazioni. Se si desidera

conoscere una distanza e la si misura una volta, non si avrà alcun strumento

razionale per capire se la misura effettuata sia buona o cattiva; se invece si

dispone di più ripetizioni, il loro confronto permette di dire molte cose sulla

bontà delle misure.

La ripetizione delle misure permette anzitutto, banalmente, di scovare

eventuali errori grossolani, ma soprattutto offre la possibilità di quantificare

gli errori accidentali, cioè stimare la bontà del lavoro fatto.

1.6

Le cause degli errori

Le fonti di errore nelle misure sono schematicamente tre: lo strumento impiegato, l’ambiente nel quale si opera, l’operatore, cioè colui che mette in

stazione lo strumento, effettua collimazioni e letture, trascrive le misure

effettuate, ecc.

1.7

Errori grossolani, sistematici e accidentali

Gli errori che vengono commessi durante le misure vengono usualmente

suddivisi in tre categorie: errori grossolani, sistematici ed accidentali.

Gli errori grossolani, detti anche blunders o gross errors, sono causati

da fattori esterni alla misura vera e propria, come le sviste del rilevatore,

che potrebbe leggere 4 invece di 6 su un display, o scrivere 9 invece di 3

sul libretto di campagna; per fare un altro esempio, un errore grossolano si

verifica quando il restitutista fotogrammetrico, dovendo riconoscere e collimare su un fotogramma un punto di coordinate note, si confonde e collima

un punto diverso.

Quelli grossolani non sono errori di misura, da trattare ed analizzare con

gli strumenti della statistica, ma dovrebbero piuttosto essere individuati ed

eliminati: tale compito non è sempre agevole, soprattutto quando la mole

dei dati rilevati e grande. Tuttavia le misure ridondanti e un uso attento

degli indicatori statistici offrono la ragionevole possibilità di trovarli: se

ad esempio è stata ripetuta più volte una misura di distanza, sarà facile

accorgersi se una volta è stato scritto male il risultato.

Gli errori sistematici originano dalla mancata o non corretta considerazione di alcuni aspetti dei fenomeni fisici coinvolti nelle misure. Se per

esempio si effettuano misure con un distanziometro elettronico assumendo

che la velocità di propagazione dei segnali sia c, cioè la velocità della luce nel

vuoto, si commette un errore sistematico perchè la velocità di propagazione

5

Vittorio Casella - Dispense, parte 1

nell’atmosfera è diversa. Tale errore sistematico può essere annullato modellizzando la variazione della velocità della luce nell’atmosfera in funzione

di temperatura e umidità.

L’esempio appena descritto permette di comprendere anche come difficilmente gli errori sistematici siano individuabili mediante ripetizione, in

quanto le diverse ripetizioni sarebbero caratterizzate dagli stessi errori sistematici.

Ci sono casi in cui una corretta metodica permette tuttavia di individuare gli errori sistematici e di renderli casuali, come si dice in gergo. Ogni

volta che uno strumento topografico viene messo in stazione e in bolla, esso

sarà caratterizzato da un errore residuo di verticalità che si comporterà come

errore sistematico in tutte le misure fatte durante quella stazione. Se si ripetesse più volte la messa in stazione, e ogni volta si effettuassero le misure,

l’errore residuo di verticalità smetterebbe di essere costante e diventerebbe

accidentale.

Non è pensabile eliminare completamente gli errori sistematici, ma questo non è nemmeno necessario: di volta in volta, fissato il livello qualitativo che le misure devono avere, si stabilirà quali errori sistematici debbano

essere presi in considerazione. Per moltissimi scopi, per esempio, l’errore

residuo di verticalità, purchè le procedure di messa in stazione siano effettuate correttamente, è tale da produrre errori trascurabili rispetto a quelli

tollerati. Vi sono casi in cui tale errore deve invece essere reso casuale mediante molteplici ripetizioni, come prescriveva ad esempio l’IGMI (Istituto

Geografico Militare Italiano) per il rilevamento del vertici del I ordine delle

rete trigonometrica.

Gli errori che non sono nè grossolani nè sistematici sono casuali o accidentali o stocastici. Essi sono responsabili delle piccole fluttuazioni che

la ripetizione di misure di precisione evidenzia. Essi sono dovuti a un complesso di ragioni: piccole imperfezioni degli strumenti, variazioni minime

delle condizioni ambientali, errori di lettura e collimazione commessi dagli

operatori.

6

Capitolo 2

La probabilità

La probabilità è alla base di tutte le tecniche che permettono di gestire e

studiare gli errori contenuti nelle misure e per questo o l’esposizione inizia

proprio dalle diverse definizioni di probabilità che sono state date.

2.1

La definizione di probabilità secondo Laplace

Consideriamo a titolo di esempio il lancio di un dado: l’insieme delle possibili

uscite, detto anche spazio campionario o spazio degli eventi elementari è

Ω = {1, 2, 3, 4, 5, 6}

(2.1)

Non è soddisfacente poter calcolare solo la probabilità degli eventi elementari

che costituiscono Ω perchè è necessario saper calcolare anche, ad esempio, la

probabilità che, da un’estrazione, risulti un numero pari. Una formulazione

probabilistica corretta del problema del dado deve quindi fornire la probabilità di qualunque sottoinsieme di Ω. Tali sottoinsiemi sono detti eventi e

costituiscono l’insieme Σ, detto spazio degli eventi. Esempi di eventi sono,

fra gli altri

∅

Ω

{1, 3, 5}

{1}

{2}

{2, 4, 6}

{3}

{4}

{1, 2, 3}

{5}

{5, 6}

{6}

{1, 4, 6}

La probabilità è una proprietà degli eventi che si misura con un numero

compreso fra 0 ed 1 e che quantifica la facilità con cui si verificano. Un evento avente probabilità 0 è detto evento impossibile mentre un evento avente

probabilità 1 è detto evento certo. E’ intuitivo pensare che la probabilità

dell’evento {1} sia 1/6 e che la probabilità dell’evento {2, 4, 6} sia 1/2; la

traduzione formale di queste considerazioni è la seguente definizione di Laplace: se un fenomeno ha N risultati, mutuamente escludentesi ed

ugualmente possibili, la probabilità di un evento A è il rapporto

7

Vittorio Casella - Dispense, parte 1

fra il numero dei casi favorevoli nA ed il numero dei casi possibili

N

nA

(2.2)

PA =

N

Sia A = {2, 4, 6} l’evento corrispondente all’uscita di un numero pari,

per il quale vale nA = 3; essendo N = 6, nell’ipotesi che il dado sia regolare,

si ha

nA

3

1

= =

PA =

N

6

2

La definizione di Laplace (o delle probabilità a priori) non è soddisfacente sul piano teorico per ragioni che si potrebbero riassumere dicendo che

si tratta di un approccio puramente deduttivo che prescinde dai fenomeni reali. Un po’ semplificando si potrebbero fare le seguenti osservazioni

sull’approccio di Laplace.

• La 2.2 è in un certo senso tautologica: non definisce la probabilità, ma

si limita ad indicare come calcolarla. In conseguenza di questo, l’applicazione di tale definizione richiede, per individuare N casi mutuamente escludentesi ed ugualmente possibili, la valutazione aprioristica

delle proprietà di simmetria del sistema.

• Non è dunque possibile applicare la definizione di Laplace ai sistemi

di cui non sia possibile effettuare aprioristicamente uno studio della

simmetria. La 2.2 si rivela allora inutile per i sondaggi elettorali o per

lo studio del comportamento di un dado truccato.

• Non esistono criteri per valutare se, in un certo caso concreto, le ipotesi

siano corrette. Se assumiamo che una moneta sia simmetrica, possiamo

prevedere l’esito di una serie di lanci, ma non è possibile verificare se

la moneta sia simmetrica o meno.

• La definizione di Laplace è di difficile applicazione quando il numero

degli eventi possibili è infinito.

2.2

La definizione di probabilità secondo Von Mises

La definizione prende spunto da un principio, verificato sperimentalmente,

detto legge empirica del caso. Consideriamo nuovamente un dado e l’evento

A precedentemente definito, e immaginiamo di effettuare un numero N di

lanci, conteggiando in numero nA dei casi favorevoli (cioè l’uscita di uno dei

numeri 2, 4, 6). E’ ragionevole pensare che il rapporto nA /N (cioè la frequenza relativa) tenda, per N grandi, a stabilizzarsi attorno alla probabilità

PA dell’evento A.

8

Vittorio Casella - Dispense, parte 1

Si giunge cosı̀ alla definizione di Von Mises: la probabilità PA di un

evento A è il limite a cui tende la frequenza relativa (numero degli

esiti favorevoli diviso il numero totale delle estrazioni) quando il

numero delle prove tende all’infinito.

nA

(2.3)

N →∞ N

La 2.3, detta anche definizione frequentistica, ha il merito di definire

il concetto di probabilità in modo da evidenziare il legame fra esperienza

e schema teorico; tale definizione può applicarsi anche ai casi nei quali la

definizione di Laplace cade in difetto. Tuttavia non è soddisfacente sul piano

concettuale.

PA = lim

• La definizione di Von Mises richiede che le condizioni di aleatorietà si

mantengano costanti durante la N prove.

• Si postula che il limite esista, senza meglio specificare la rapidità della

convergenza. Questo aspetto è fondamentale perchè la 2.3 può essere

usata in pratica solo assumendo un N finito sufficientemente grande,

commettendo cosı̀ un errore che dovrebbe essere stimato.

Inoltre è possibile (anche se difficile) che una lunga serie di esperimenti

converga al risultato sbagliato, cosı̀ come è possibile che, lanciando

dieci volte una moneta, esca sempre testa.

La definizione frequentistica di probabilità può essere usata immaginando che N sia sufficientemente grande per poter scrivere:

PA ≈

nA

N

(2.4)

che può essere esplicitata rispetto a nA

nA ≈ N P A

il cui significato è che, effettuando N estrazioni, il numero di volte in cui si

verifica un evento A è mediamente uguale al prodotto della probabilità di

A per N. Quest’ultima affermazione è da intendersi cosı̀: ripetendo molte

volte il blocco di N estrazioni si troverebbero valori di nA diversi ma tanto

più concentrati attorno al valore previsto dalla 2.2 quanto più è grande il

valore di N .

2.3

Definizione assiomatica di probabilità

Le definizioni di Laplace e Von Mises non sono pienamente soddisfacenti sul

piano concettuale dunque non possono essere usate per fondare una teoria

9

Vittorio Casella - Dispense, parte 1

della probabilità, anche se sono utili nei casi concreti in quanto si avvicinano

all’idea intuitiva di probabilità.

E’ possibile dare una definizione astratta di probabilità che non è affetta

dai limiti delle precedenti e tuttavia le contiene. Tale definizione è basata

sul linguaggio insiemistico. Questo paragrafo descrive in modo discorsivo le

proprietà di una tale definizione, mentre le sezioni successive formalizzeranno

tali proprietà.

Si prende anzitutto in considerazione l’insieme dei possibili eventi elementari di un esperimento, detto spazio campionario e indicato con Ω. Un

qualunque evento A è un sottoinsieme dello spazio campionario. La famiglia

di tutti gli eventi associati ad un certo esperimento è lo spazio degli eventi

Σ: esso deve essere definito in modo tale da contenere tutti gli eventi di cui

si desidera conoscere la probabilità. Richiamiamo ora le proprietà principali

della definizione assiomatica di probabilità.

• Deve esistere la probabilità di Ω, uguale a 1. Nel caso del dado: si

vuole che la probabilità che esca un numero qualunque sia 1.

• Deve esistere la probabilità dell’insieme vuoto, uguale a 0. Si parla di

evento impossibile.

• Deve esistere una funzione di probabilità che misura la probabilità di

ogni elemento di Σ. Essa deve essere additiva.

P : Σ → [0, 1]

• Se si conosce la probabilità di un evento A, deve esistere la probabilità

che tale evento non si verifichi e la somma delle due probabilità deve

fare 1. Nel caso del dado: se si conosce la probabilità dell’evento

A = {2, 4, 6}, deve esistere la probabilità dell’evento {1, 3, 5}, cioè del

complementare di A rispetto ad Ω, che indicheremo con Ac ; deve valere

inoltre PAc = 1 − PA .

• Se si conosce la probabilità di due eventi A e B, deve esistere la probabilità che si verifichi A o B, evento rappresentato da A ∪ B; se A e

B sono disgiunti, tale probabilità deve coincidere con la somma delle

probabilità di A e B. Si tratta dell’addittività della probabilità.

• Se si conosce la probabilità di due eventi A e B, deve esistere la probabilità che si verifichi A e B cioè A ∩ B ed essa deve tenere conto

dell’addittività della probabilità.

10

Capitolo 3

I fenomeni aleatori

unidimensionali

3.1

Le variabili casuali

I fenomeni aleatori di maggiore interesse ai fini del corso hanno come spazio

campionario l’insieme dei numeri reali R: l’esito di una misura di precisione

è un numero reale qualunque, anche se ciò non significa, ovviamente, che

tutti i numeri abbiano la stessa probabilità.

Si pone dunque il problema di definire una distribuzione di probabilità

su R: lo spazio campionario Ω è in questo caso tutta la retta reale e l’applicazione della definizione astratta di probabilità richiederebbe la definizione

di una funzione di probabilità P che avrebbe come dominio, lo spazio degli

eventi, l’insieme dei sottoinsiemi di R. Ma un generico sottoinsieme di R

può essere davvero molto complesso, dunque la definizione della funzione P

è un compito impegnativo, che può essere fortunatamente reso più semplice,

come mostreremo.

Anzitutto è possibile dimostrare che lo spazio degli eventi significativi è

costituito solo dagli intervalli del tipo ]a, b]: si tratta allora di definire distribuzioni di probabilità sugli intervalli di R e, per la precisione, è sufficiente

farlo per gli intervalli del tipo ] − ∞, a] in quanto la probabilità di intervalli

diversi può essere dedotta facilmente.

Quando un fenomeno aleatorio ha uno spazio campionario rappresentabile sulla retta reale ed è possibile definire la probabilità per ogni insieme

del tipo

I(c) = {x ∈ R, x ≤ c} =] − ∞, c]

(3.1)

si è in presenza di una variabile casuale ad una dimensione. Indicheremo le variabili casuali semplicemente con vc.

Il motivo per cui è stata usata l’espressione spazio campionario rappresentabile sulla retta reale invece che spazio campionario coincidente con la

retta reale è che, come vedremo, anche fenomeni aleatori discreti come il

11

Vittorio Casella - Dispense, parte 1

lancio di una moneta o di un dado possono essere descritti con il linguaggio

delle vc.

Una vc si dice discreta se si riferisce ad un fenomeno aleatorio discreto, avente cioè uno spazio campionario costituito da un numero finito di

elementi; se il fenomeno aleatorio ha come spazio campionario R o un suo

sottoinsieme, la vc associata si dice continua.

Le vc si indicano con una lettera maiuscola e i risultati delle estrazioni

con la stessa lettera minuscola. Per esempio il risultato di un’estrazione

dalla vc X si indica con x.

3.2

La funzione di distribuzione

Sia X una vc continua; ciò significa che è assegnata la probabilità degli

intervalli

P (] − ∞, c])

∀c ∈ R

(3.2)

In tal caso si può definire la funzione di distribuzione FX

FX : R → [0, 1]

.

FX (c) = P (] − ∞, c])

∀c ∈ R

(3.3)

Una funzione cosı̀ definita ha le seguenti proprietà

limc→−∞ FX (c) = 0

limc→+∞ FX (c) = 1

FX (a) ≤ FX (b) ∀a, b ∈ R, a ≤ b

(3.4)

La 3.3 definisce la funzione di distribuzione e fornisce uno strumento

per ricavarla da una distribuzione di probabilità nota. Capita più spesso di

assegnare una FX allo scopo di specificare una distribuzione di probabilità.

Infatti ogni funzione avente la proprietà 3.4 definisce una distribuzione di

probabilità su R nel modo seguente

.

P (] − ∞, c]) = FX (c)

.

P (]a, b]) = FX (b) − FX (a)

(3.5)

(3.6)

Si noti che la 3.6 è una definizione e non una deduzione dalla 3.5; tale

definizione è fatta in modo che la probabilità che resta cosı̀ definita sia

additiva, come richiedono gli assiomi sulla probabilità. La definizione 3.6

mette in rilievo il significato della funzione di distribuzione di una vc X,

come strumento per calcolare la probabilità che una estrazione dal fenomeno

aleatorio associato ad X fornisca un valore minore o uguale a c.

Nello schema appena delineato rientrano anche le vc discrete, aventi

uno spazio campionario costituito da un numero finito di valori: consideriamo a titolo di esempio una moneta e immaginiamo di stabilire la seguente

12

Vittorio Casella - Dispense, parte 1

1

0.5

0

0

1

Figura 3.1: La funzione di distribuzione di una moneta

corrispondenza

p = 1/2 testa

x=0

x=1

p = 1/2 croce

x 6= 1, 2 p = 0

alla quale si può associare la seguente funzione di distribuzione

x<0

0

1/2 0 ≤ x < 1

FM (x) =

1

x≥1

(3.7)

(3.8)

Si tratta di una funzione a gradini e quindi non continua.

3.3

La funzione densità di probabilità

Supponiamo che una vc X abbia una FX differenziabile cioè che

∃

d

FX (x) ∀x ∈ R

dx

Si può in tal caso definire la funzione densità di probabilità fX nel modo

seguente

. d

fX (x) =

FX (x)

dx

13

(3.9)

Vittorio Casella - Dispense, parte 1

La 3.9 può essere invertita grazie al teorema fondamentale del calcolo

integrale

Z a

FX (a) =

fX (x)dx

(3.10)

−∞

da cui si ricava

b

Z

P (]a, b]) =

fX (x)dx

(3.11)

a

Una funzione densità di probabilità ha le seguenti caratteristiche:

fX (x) ≥ 0 ∀x ∈ R

Z +∞

fX (x)dx = 1 ⇒

−∞

(3.12)

lim fX (x) = 0

|x|→+∞

(3.13)

Si può dimostrare al contrario che ogni funzione avente le caratteristiche 3.13 definisce una distribuzione di probabilità ed una funzione di

distribuzione nel modo seguente:

Z a

.

FX (a) =

fX (x)dx

(3.14)

.

P ([a, b]) =

−∞

Z b

fX (x)dx

(3.15)

a

La funzione densità di probabilità di una vc X, è lo strumento per calcolare

la probabilità di un intervallo ]a, b] ed esiste solo se la FX è differenziabile. A

questo proposito, in letteratura si trova una notazione che è utile spiegare:

immaginiamo di scegliere un punto c ed un valore ∆c in modo tale che sia

fX (x) ≈ fX (c) ∀x ∈ [c, c + ∆c]

(spesso questo si esprime, in modo non del tutto preciso, affermando che ∆c

è un infinitesimo). La probabilità dell’intervallo [c, c + ∆c] può allora essere

calcolata in modo approssimato

Z

c+∆c

fX (x)dx ≈ ∆cfX (c)

P ([c, ∆c]) =

(3.16)

c

Si legge a volte che la probabilità che X sia nell’intervallo [x, x + dx] è data

dal differenziale della densità di probabilità, cioè fX (x)dx.

3.4

Sintesi sui modi di assegnare una distribuzione

di probabilità

Una distribuzione di probabilità sulla retta reale può essere assegnata in

almeno tre maniere differenti.

14

Vittorio Casella - Dispense, parte 1

• Assegnazione diretta della probabilità di ogni intervallo del tipo 3.1;

si tratta di una via percorribile solo teoricamente, tranne che in casi

particolari.

• Assegnazione per mezzo di una funzione di distribuzione FX . Tale

approccio è equivalente al primo.

• Assegnazione per mezzo di una funzione densità di probabilità. Questo

metodo non è equivalente ai precedenti in quanto la conoscenza della

fX garantisce la conoscenza della FX , ma il contrario è falso. Infatti

se FX non è differenziabile, come nel caso della moneta, fX non esiste.

3.5

Media e varianza di una variabile casuale

Una vc X è completamente caratterizzata e descritta dalla funzione di distribuzione FX o dalla funzione densità di probabilità fX in quanto esse

permettono di ricostruire la distribuzione di probabilità associata ad X.

Tali funzioni descrivono quindi in modo potente ed esaustivo un fenomeno

aleatorio, tuttavia vi è l’esigenza di disporre di indicatori capaci di riassumere alcune proprietà fondamentali delle distribuzioni di probabilità e,

in particolare, è utile individuare la regione nella quale una vc si addensa,

cioè la parte dell’insieme campionario dove è più probabile che si trovi una

estrazione.

Nel caso di vc discrete, con uno spazio campionario costituito da N valori

xi , i = 1, 2, . . . , N , ciascuno caratterizzato da una probabilità pi , si definisce

media il numero

N

X

µ=

xi pi

(3.17)

i=1

Si tratta di sommare ogni valore dello spazio campionario pesato con la sua

probabilità. Per le vc continue, ricordando la definizione di integrale come

limite di una somma, si definisce media della vc X il numero

Z +∞

µ=

dx xfX (x)

(3.18)

−∞

Un altro aspetto fondamentale di una distribuzione di probabilità è la

dispersione, cioè la misura in della distanza media degli elementi dello spazio campionario dalla media; tale misura va intesa in senso probabilistico,

dunque dire che una vc ha bassa dispersione non significa che non esistono

elementi dello spazio campionario lontani dalla media, ma piuttosto che essi

hanno una bassa probabilità di manifestarsi. La misura di dispersione per

eccellenza è la media della variabile (X −µ)2 , pesata secondo la distribuzione

di probabilità di X. Tale grandezza è si chiama varianza e corrisponde, per

15

Vittorio Casella - Dispense, parte 1

le vc discrete al numero

2

σ =

N

X

(xi − µ)2 pi

(3.19)

i=1

e per le vc continue alla quantità

Z +∞

2

σ =

dx (x − µ)2 fX (x)

(3.20)

−∞

√

Spesso si considera anche il parametro σ = σ 2 detto deviazione standard o scarto quadratico medio. La vc (X − µ) è usualmente detta variabile

scarto.

E’ opportuno inserire a questo punto una piccola digressione sul. . . segno

della radice quadrata. Tutti gli studenti freschi degli esami di Analisi ricorde√

ranno di aver sempre visto rappresentare graficamente la funzione f (x) = x

come funzione a valori positivi; d’altra parte non esiste calcolatrice al mondo

che, richiesta di calcolare la radice quadrata di 4, risponderebbe -2. Capita

spesso di leggere frasi del tipo: La deviazione standard di un certo fenomeno

è stata stimata essere ±14.5cm. Questo è scorretto, a giudizio di chi scrive

e tale errore è alimentato dalla mancata distinzione fra due problemi connessi l’uno all’altro, ma distinti: è certamente vero che l’equazione x2 = 4

ha due soluzioni, in particolare +2 e -2, ma la radice quadrata di 4 è, per

definizione, la soluzione positiva dell’equazione appena richiamata, cioè 2.

3.6

Principali variabili casuali

Delle infinite vc che si possono concepire in linea di principio, ve ne sono

alcune di utilità particolare, perchè sono adatte a modellizzare determinati

fenomeni fisici.

3.6.1

La variabile casuale normale o di Gauss

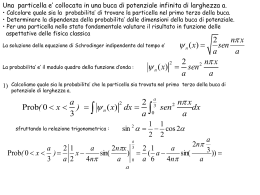

Questa distribuzione di probabilità è caratterizzata dalla densità di probabilità

(x − µ)2

−

1

2σ 2

fN (x; µ, σ) = √

e

(3.21)

σ 2π

definita su tutto R e simmetrica rispetto al punto x = µ. La si trova spesso

indicata anche con la notazione N [µ, σ].

I parametri µ e σ 2 indicano naturalmente media e varianza della distribuzione in quanto, se considerassimo la densità di probabilità

1

fX (x; a, b) = √

b 2π

16

(x − a)2

2b2

e

−

Vittorio Casella - Dispense, parte 1

0.7

0.6

0.5

0.4

N(2, 0.7)

0.3

N(4, 0.7)

0.2

0.1

0

−4

N(2, 1.4)

−2

0

2

4

6

8

Figura 3.2: Densità di probabilità per alcune normali

e calcolassimo media e varianza mediante le 3.18 e 3.20, troveremmo proprio

a e b2 . Se tali parametri coincidono con media e varianza della vc X, è lecito

indicare questo esplicitamente sostituendo loro i simboli µ e σ 2 .

La vc normale è adatta a descrivere le misure di precisione e per questo

si assume che effettuare una misura equivalga ad una estrazione da una

normale: µ è associato al valore vero della misura mentre σ 2 quantifica la

dispersione della vc e quindi la bontà del metodo usato per la misura.

Consideriamo ora il problema di calcolare la probabilità di un certo

intervallo [a, b], per una N [µ, σ] assegnata: si tratta di valutare l’integrale

Z

P ([a, b]) =

a

b

1

dx √

σ 2π

(x − µ)2

2σ 2

e

−

(3.22)

che, mediante la trasformazione di coordinate z = x − µ/σ, si trasforma

nell’integrale

x2

Z b−µ

−

σ

1

(3.23)

P ([a, b]) =

dz √

e 2

a−µ

2π

σ

La funzione integranda è a ben guardare la densità di probabilità di

una particolare vc normale, detta distribuzione normale standardizzata ed

indicata con Z; essa è caratterizzata dai parametri µ = 0 e σ = 1. Possiamo

allora concludere che la trasformazione

X −µ

X = N [µ, σ] →

= Z = N [0, 1]

(3.24)

σ

17

Vittorio Casella - Dispense, parte 1

trasforma una normale qualsiasi in una normale standardizzata e che vi è un

legame relativo alla probabilità degli intervalli associati alla vc trasformanda

e alla vc trasformata

a−µ b−µ

,

(3.25)

P N [µ, σ] ∈ [a, b] = P Z ∈

σ

σ

Tale trasformazione si chiama standardizzazione e viene spesso impiegata per

ricondurre dei calcoli relativi a una normale qualunque a calcoli riguardanti

la normale standardizzata.

In particolare vengono spesso presi in considerazione gli intervalli notevoli

[µ − σ, µ + σ]

[µ − 2σ, µ + 2σ]

[µ − 3σ, µ + 3σ]

la cui probabilità è costante per ogni vc normale in quanto, qualunque sia

la scelta µ e σ, si ha

Z µ+σ

Z +1

dxfX (x; µ, σ) =

dxfZ (x) = 0.6826

−1

+2

µ−σ

µ+2σ

Z

Z

dxfX (x; µ, σ) =

dxfZ (x) = 0.9544

−2

Z +3

µ−2σ

Z µ+3σ

dxfX (x; µ, σ) =

dxfZ (x) = 0.9974

−3

µ−3σ

Si noti come sia praticamente certo che una estrazione da una distribuzione normale sia contenuta nell’intervallo [µ − 3σ, µ + 3σ]. Quest’affermazione

può essere meglio compresa nei termini della definizione frequentistica di

probabilità (si veda la 2.2): effettuando ripetuti blocchi di 1000 estrazioni,

mediamente solo 3 estrazioni per blocco cadranno all’esterno dell’intervallo

suddetto.

E’ pur vero che una misura è modellizzata, in genere, da una vc normale,

ma nello sviluppo dei calcoli si incontrano grandezze derivate, come il quadrato della vc scarto, che hanno distribuzione diversa dalla normale. Fra le

vc conosciute e studiate, meritano di essere menzionate la vc uniforme, la

χ2 e la t di Student.

3.6.2

La variabile casuale uniforme

La variabile casuale uniforme è molto semplice ed è caratterizzata da una

fU costante su un intervallo finito [a, b]

x ∈ [a, b]

c

fU (x) =

(3.26)

0

altrove

18

Vittorio Casella - Dispense, parte 1

La condizione di normalizzazione pone un vincolo che lega i tre parametri

in gioco

1

c(b − a) = 1 → c =

b−a

Media e varianza assumono rispettivamente i valori

a+b

Il punto medio dell’intervallo[a, b]

(3.27)

2

(b − a)2

σ2 =

(3.28)

12

E’ certamente ragionevole che la varianza, misura della dispersione, dipenda dalla lunghezza b − a dell’intervallo sul quale la vc uniforme esiste;

è convincente anche il fatto che una grandezza quadratica come la varianza

dipenda dal quadrato di tale lunghezza.

µ=

3.7

Variabile casuale funzione di un’altra variabile

casuale - Risultati parziali

Nelle situazioni pratiche capita spesso, dovendo determinare una grandezza

X, di misurare una grandezza Y , legata alla precedente da una relazione

X = g(Y )

Per fare un esempio, dovendo determinare l’area di un piazzale quadrato, si

potrebbe misurare la lunghezza di un lato ed elevarla al quadrato: si pone

dunque il problema della funzione di una vc. In genere si ha che, se Y è una

vc, cioè un fenomeno aleatorio, anche X lo sarà.

Il problema generale della vc casuale funzione di un’altra è il seguente:

se Y è una vc avente come funzione densità di probabilità fY (y) e se X è una

seconda vc legata alla precedente dalla relazione X = g(Y ) è possibile dedurre la forma funzionale della densità di probabilità di X, cioè fX (x). Tale

problema non verrà affrontato in questa sezione, che fornirà semplicemente

alcuni risultati relativi a media e varianza.

Ciononostante premettiamo una osservazione sulla forma della densità

di probabilità di una vc funzione di altre: la vc somma delle vc X e Y non

ha come densità di probabilità la somma delle densità di probabilità delle

vc addende. Sia Z la somma di X e Y : essa non ha come densità la somma

di fX (x) e fY (y), anzitutto perchè tale funzione non è normalizzata a 1;

inoltre supponendo che X sia normale e concentrata attorno a 100 e Y sia

normale e concentrata attorno a 200, è ragionevole pensare che X + Y sia

concentrata attorno a 300, mentre la somma fX (x) + fY (y) è bimodale (ha

due massimi) attorno a 100 e 200.

Veniamo ora al problema della vc funzione di un’altra: ci limiteremo

come detto ad enunciare alcuni risultati parziali interessanti. Uno, anzitutto,

riguarda le trasformazioni lineari di vc normali.

19

Vittorio Casella - Dispense, parte 1

Teorema 1 (Funzione lineare di una vc normale) Sia Y = N [µY , σY ])

e siano a e b due costanti; allora X = aY + b è una vc normale, e in

particolare

X = N [aµY + b, aσY ])

Dunque la normalità è conservata sotto trasformazioni lineari. Ciò non

avviene in genere, per trasformazioni qualunque. Se si considera ad esempio X = Y 2 , dove Y è una normale, si comprende immediatamente che

X non può essere dello stesso tipo in quanto ha come spazio campionario

R+ (cioè l’insieme dei numeri reali positivi), mentre lo spazio campionario

di una normale è R. Questa conclusione ha valore generale: la funzione

di una vc appartenente ad una certa famiglia (N, t, U, χ2 ) non appartiene

necessariamente alla stessa famiglia.

Il risultato appena enunciato può essere generalizzato in due maniere,

considerando vc qualunque e considerando trasformazioni qualunque. Enunciamo un interessante risultato sulla trasformazioni lineari di vc qualunque.

Teorema 2 (Funzione lineare di una vc) Se X = aY + b dove Y è una

vc, allora

µX = aµY + b

(3.29)

2

σX

= a2 σY2

(3.30)

Consideriamo ora il caso di trasformazioni generiche: se la funzione g è

qualsiasi, è possibile dedurre delle relazioni approssimate. Si può dimostrare che se la funzione g ha un andamento regolare, senza grosse variazioni,

nell’intervallo in cui Y è concentrata, vale un importante risultato.

Teorema 3 (Media e varianza di una vc funzione di un’altra) Se fra

due vc X ed Y esiste una relazione del tipo X = g(Y ) e g ha un andamento

abbastanza regolare, senza grosse variazioni di pendenza, sull’intervallo in

cui Y si concentra, allora vale

µX ' g(µY )

2

0

(3.31)

2 2

σX ' g (µY ) σY

(3.32)

Consideriamo ora un esempio. Sia L la vc associata alla misura del

lato di un quadrato e sia A la vc associata all’area del quadrato stesso. La

relazione che le lega è, evidentemente A = L2 . La funzione g è in tal caso

g(x) = x2 : applicando i risultati del teorema 3 si ha

µA ' µ2L

(3.33)

σA2 ' (2µL )2 σL2

(3.34)

σA ' 2µL σL

(3.35)

20

Vittorio Casella - Dispense, parte 1

L

A=LxL

eL x L

eL x L

eL

eL x eL

L

eL

Figura 3.3: Visualizzazione della propagazione dell’errore nel calcolo di

un’area

Emerge che l’errore che si commette nella misura del lato si propaga quando tale misura viene manipolata formalmente per determinare l’area del

quadrato.

Il risultato appena conseguito può essere meglio compreso se si adotta

una scrittura meno rigorosa e si indicano i valori veri rispettivamente con L

e A e i valori misurati rispettivamente, con L̄ e Ā; indicando con L l’errore

di cui è affetto L, si può scrivere

L̄ = L + L

2

(3.36)

2

2

2

Ā = L̄ = (L + L ) = L + 2LL + L

2

= A + 2LL + L

(3.37)

(3.38)

da cui si può dedurre che l’errore che caratterizza A è il seguente

A = 2LL + 2L

Tale conclusione è in accordo con la 3.35 e può essere facilmente spiegata

con una illustrazione.

Per precisione si deve notare che la Fig. 3.3 evidenzia come quest’ultima

trascuri i termini di errore del secondo ordine. Ciò è dovuto al fatto che le

relazioni 3.31 e 3.32 sono approssimate e sono state ottenute sviluppando

la funzione g in serie di Taylor troncata al primo ordine: questo semplice

esempio evidenzia dunque anche i limiti di validità delle suddette relazioni.

21

Vittorio Casella - Dispense, parte 1

3.8

Intervallo di confidenza

Consideriamo un valore α ∈ [0, 1] e, fissata una vc X, cerchiamo un intervallo di R nel quale X sia localizzata con probabilità 1 − α. La soluzione è

un intervallo di confidenza con livello di significatività α il cui significato è

chiarito, ancora una volta, dall’interpretazione frequentistica di probabilità:

estraendo N volte da X, ci aspettiamo di trovare valori compresi nell’intervallo di confidenza circa N (1 − α) volte. E’ chiaro che il problema descritto

ha un interesse pratico solo se α è abbastanza piccolo: comunemente si

scelgono i valori 0.05 e 0.01.

Affronteremo il problema per gradi: cerchiamo anzitutto un intervallo di

confidenza della forma ]−∞, a]; chiediamo dunque che a soddisfi l’equazione

P (] − ∞, a]) = 1 − α

(3.39)

FX (a) = 1 − α

(3.40)

cioè che sia

Si tratta di un’equazione in a che, in genere, non si sa risolvere in forma

chiusa1 . Si ricorre allora a soluzioni approssimate mediante tabelle oppure

programmi, come ad esempio MATLAB. La soluzione si indica con Xα . Essa

è caratterizzata dalla proprietà

P (] − ∞, Xα ]) = 1 − α

(3.41)

Dovendo stabilire un intervallo limitato a destra e a sinistra, la scelta

che viene fatta usualmente è

[Xα/2 , X1−α/2 ]

(3.42)

anche se non è l’unica scelta possibile.

Per le vc la cui fX (x) è simmetrica rispetto all’origine, come ad esempio

la normale standardizzata e la t di Student, è possibile stabilire un legame

fra i due estremi dell’intervallo di confidenza.

Dimostreremo anzitutto che si ha

P (] − ∞, −a]) = P ([a, ∞])

∀a

(3.43)

Per definizione di funzione densità di probabilità si ha

Z −a

P (] − ∞, −a]) =

dxfX (x)

(3.44)

−∞

Effettuando un cambio di variabile u = −x si ha

Z −a

Z

dxfX (x) = −

P (] − ∞, −a]) =

−∞

a

dufX (−u)

∞

Per le vc continue trattate in queste note, si ha che FX è C ∞ (R) e monotona e dunque

invertibile, ma non si sa dare esplicitamente la funzione FX nè, tantomeno, FX−1 .

1

22

Vittorio Casella - Dispense, parte 1

Ricordando che lo scambio degli estremi di integrazione dell’integrale definito

ne cambia il segno, si ha

Z ∞

P (] − ∞, −a]) =

dufX (−u)

a

Sfruttando la simmetria della funzione integranda si ha infine il risultato

cercato

Z ∞

P (] − ∞, −a]) =

dufX (u) = P ([a, ∞])

a

Ricordando ora che, per definizione, Xα/2 è caratterizzato dalla proprietà

P ([−∞, Xα/2 ]) = α/2

e che, per quanto appena dimostrato, si ha anche

P ([−Xα/2 , ∞]) = α/2

si può ricavare

P ([−∞, −Xα/2 ]) = 1 − α/2

da cui la la conclusione

X1−α/2 = −Xα/2

3.8.1

Intervalli di confidenza di vc normali

Affrontiamo il problema del calcolo dell’intervallo di confidenza al livello di

significatività α per una vc normale qualunque X = N [µX , σX ]); indichiamo tale intervallo con [Xα/2 , X1−α/2 ]. E’ opportuno calcolare l’intervallo

di confidenza dello stesso livello di significatività per la vc standardizzata,

[Zα/2 , Z1−α/2 ] e poi ricavare quello della X mediante la 3.24

Xα/2 = Zα/2 σX + µX

(3.45)

X1−α/2 = Z1−α/2 σX + µX = −Zα/2 σX + µX

(3.46)

da cui il risultato che lo IC cercato è centrato sulla media µX e ha semilunghezza −Zα/2 σX .

3.8.2

Esercizi sull’intervallo di confidenza

1. Si consideri la normale N [2, 2] e si calcolino gli estremi dell’intervallo

di confidenza di probabilità al 95% e al 99%.

2. Data la normale N [−8, 3] e si calcoli la probabilità dell’intervallo ] − ∞, 2]

e di quello [−10, −3].

23

Scarica