Geometria I

appunti (non rivisti dai professori) delle lezioni

Ateneo Studenti Fisica

Alessandro Principi

Indice

Strutture algebriche

Spazi Vettoriali . . . . . .

Sottospazi vettoriali . . .

Costruire sottospazi

Altri sottospazi . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2

3

5

5

5

Sistemi Lineari

. . . . . . . . .

. . . . . . . . .

. . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

7

7

8

9

10

Dimensione e base di uno spazio vettoriale

Formula di Grassman . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12

14

Rango di un’applicazione lineare

Classe di Equivalenza . . . . . . . . . . . . . . . . . . . . . . . .

Calcolo del rango di una matrice a scalini S e di una base di ImS

Matrici Elementari e invertibili . . . . . . . . . . . . . . . . . . .

Calcolo della matrice inversa attraverso l’algoritmo di Gauss . . .

Matrice associata a un’applicazione lineare . . . . . . . . . . . .

Matrice del cambiamento di base . . . . . . . . . . . . . . .

16

16

18

18

20

20

21

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Applicazioni Lineari, Sistemi Lineari

Nucleo e Immagine di un’applicazione lineare,

Risoluzione di sistemi lineari . . . . . .

Algoritmo di Gauss . . . . . . . . . . . .

Prodotto di Matrici . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

SD-equivalenza

23

Determinante

Criterio dei minori orlati . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

29

Coniugio e Similitudine

Calcolo di autovalori e autospazi per una matrice . . . . . . . . . . . . . . . . . . . . . . . . . .

Diagonalizzabilitá . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Triangolabilitá . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

31

33

34

Forme bilineari

Forma quadratica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

36

37

Congruenza, forme isometriche

Rango di un’applicazione bilineare . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

38

38

Prodotti Scalari

Prodotti scalari definiti positivi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Proprietá degli spazi euclidei . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

40

44

45

Teorema Spettrale e prodotti Hermitiani

Prodotti Hermitiani . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

47

49

Ateneo Studenti Fisica

1

Strutture algebriche

Definizione: Sia X un insieme, e sia ∗ una funzione tale che: ∗ : X × X −→ X. Allora si dice che ∗ è

un’operazione su X.

¡

¢

Definizione: X, ∗ si dice gruppo se X è un insieme e ∗ un’operazione su X che verifica 3 proprietà:

1. Esistenza dell’elemento neutro: ∃e ∈ X t. c. a ∗ e = e ∗ a = a;

2. Esistenza dell’inverso: ∀a ∈ X ∃b ∈ X t.c. a ∗ b = b ∗ a = e;

3. Proprietà associativa: ∀a, b, c ∈ X, (a ∗ b) ∗ c = a ∗ (b ∗ c).

¡

¢

Definizione: X, ∗ si dice gruppo commutativo (o abeliano) se è un gruppo e vale la proprietà commutativa: ∀a, b ∈ X , a ∗ b = b ∗ a.

Definizione:

¡ Sia X

¢ un insieme, + (detta somma) e · (detto prodotto) due operazioni su X. Allora

si dice che X, +, · è un campo se valgono le seguenti proprietà:

1. Esistenza dell’elemento neutro (detto 0) per la somma;

2. Esistenza dell’inverso per la somma;

3. Proprietà associativa per la somma;

4. Proprietà commutativa per la somma;

5. Esistenza dell’elemento neutro (detto 1) per il prodotto;

6. Proprietà associativa per il prodotto;

7. Proprietà distributiva: ∀a, b, c ∈ X, a·(b +c) = a·b +a·c, (a +b)·c = a·c +b·c

(Conta l’ordine!);

8. Esistenza dell’inverso per il prodotto;

9. Proprietà commutativa per il prodotto.

¡

¢

Definizione: X, +, · è un anello se valgono le proprietà 1 - 7 sopra elencate. É un anello commutativo

se vale anche la proprietà 9.

¡

¢

Definizione: X, +, · è un corpo se valgono le proprietà 1 - 8 sopra elencate.

2

Ateneo Studenti Fisica

Strutture algebriche

¡

¢

Definizione: V, +, ·, K si dice spazio vettoriale se:

• V è un insieme;

• K è un campo;

• + è una somma in V (+: V × V −→ V);

• ·: K × V −→ V (detto prodotto per scalare).

e valgono le seguenti proprietà:

• (V, +) è un gruppo commutativo;

• ∀α, β ∈ K, ∀v ∈ V, (αβ)v = α(βv);

• ∃1 ∈ K t. c. ∀v ∈ V 1 · v = v;

• ∀α, β ∈ K, ∀v ∈ V, (α + β)v = αv + βv;

• ∀α ∈ K, ∀v, w ∈ V, α(v + w) = αv + αw;

Spazi Vettoriali

Definiamo ora alcuni spazi vettoriali:

1) Sia K un campo, chiamiamo Kn = {(x1 , x2 , . . . , xn ) | xi ∈ K ∀i = 1, . . . , n}.

Definiamo + e · in questo modo:

def

(x1 , x2 , . . . , xn ) + (y1 , y2 , . . . , yn ) = (x1 + y1 , x2 + y2 , . . . , xn + yn ),

∀(x1 , x2 , . . . , xn ), (y1 , y2 , . . . , yn ) ∈ Kn

def

a · (x1 , x2 , . . . , xn ) = (a · x1 , a · x2 , . . . , a · xn ), ∀a ∈ K, ∀(x1 , x2 , . . . , xn ) ∈ Kn

Notiamo innanzitutto che + e · sono ben definiti (poichè si basano sulle proprietà del campo K), e che,

grazie a queste definizioni, otteniamo uno spazio vettoriale.

2) Sia K un campo, e sia

K[x] = {a0 + a1 x + . . . + an xn | ai ∈ K, ∀i = 1, . . . , n}

e siano + e · le due operazioni classiche sui polinomi (somma e prodotto tra polinomi). Si verifica che,

con le definizioni date, K[x] è un anello commutativo:

• Elemento neutro per la somma: il polinomio i cui coefficienti sono tutti uguali a zero;

• Inverso per la somma: polinomio con i coefficienti inversi;

• Elemento neutro per il prodotto: è il polinomio 1 (tutti i coefficienti dei termini di grado

superiore a zero sono zero);

• le altre proprietà valgono perchè i coefficienti sono in un campo;

Verifichiamo che non vale l’esistenza dell’inverso per il prodotto:

consideriamo due polinomi p(x) e q(x) entrambi diversi da zero di grado rispettivamente m e n e consideriamo il loro prodotto p(x) · q(x). In tal modo otteniamo un polinomio di grado m +n.

Se fosse, ad esempio, q = p−1 , allora avremmo che p(x) · q(x) = 1. Ma ciò é impossibile per polinomi che

non siano costanti (i cui coefficienti dei termini di grado superiore a zero siano diversi da zero), in quanto

essi avrebbero grado maggiore di zero (ovvero il grado di 1).

Se ora consideriamo (K[x], +, ·, K), con + definito come sopra e · definito come:

Ateneo Studenti Fisica

3

Strutture algebriche

· : K × K[x] −→ K[x]

(a, p(x)) 7−→ a · p(x)

Si verifica che é uno spazio vettoriale.

3) Sia V spazio vettoriale su K e sia A un insieme qualsiasi. Sia F l’insieme delle applicazioni (funzioni)

da A in V . (F, +, ·, K) é uno spazio vettoriale se definiamo + e · come segue:

∀f, g ∈ F , f + g : A −→ V é t. c.:

def

∀a ∈ A, (f + g)(a) = f (a) + g(a)

∀f ∈ F , ∀λ ∈ K, λf : A −→ V é t. c.:

def

∀a ∈ A, (λf )(a) = λf (a)

4) Sia K un campo. Definiamo:

M (p, q, K) = {matrici con p righe, q colonne con elementi in K}

Una Matrice é nella forma:

a11

..

.

ap1

···

..

.

···

a1q

..

.

apq

dove ai j ∈ K, ∀i = 1, . . . , p, ∀j = 1, . . . , q.

Sia A ∈ M (p, q, K):

Ai = i-esima riga;

Ai = i-esima colonna;

[A]ij = elemento di posto (i, j), dove i indica la riga e j la colonna;

0 é la matrice nulla ([0]ij = 0 ∀i, j)

A, B ∈ M (p, q, K), A = B ⇐⇒ [A]ij = [B]ij ∀i, j

Definiamo + e · :

def

∀A, B ∈ M (p, q, K), [A + B]ij = [A]ij + [B]ij ∀i, j

def

∀λ ∈ K, ∀A ∈ M (p, q, K), [λA]ij = λ[A]ij ∀i, j

(M (p, q, K), +, ·, K) é uno spazio vettoriale:

• (M (p, q, K), +) é un gruppo abeliano:

1. 0 é l’elemento neutro;

2. esiste l’inverso: [A]ij + (−[A]ij ) = 0;

3. vale la proprietá associativa:

[(A + B) + C]ij = [A + B]ij + [C]ij = [A]ij + [B]ij + [C]ij = [A]ij + [B + C]ij =

= [A + (B + C)]ij ;

4. si verifica analogamente la commutativa;

• con metodi analoghi si verificano le altre proprietà.

Proposizioni

Sia V uno spazio vettoriale:

1. lo 0 è unico in V:

se ∃01 , 02 ∈ V =⇒ 01 = 01 + 02 = 02 per gli assiomi;

2. ∀x ∈ V ∃! − x ∈ V

se ∃(−x)1 , (−x)2 ∈ V inversi di x per somma =⇒ (−x)1 = (−x)1 + x + (−x)2 = (−x)2 ;

4

Ateneo Studenti Fisica

Strutture algebriche

3. ∀v ∈ V 0 · v = 0

0 · v = (0 + 0)v = 0 · v + 0 · v =⇒ 0 · v = 0;

4. se α · x = 0 =⇒ o α = 0 o x = 0

se α = 0, ok.

se α 6= 0 =⇒ ∃α−1 ∈ K t. c. α−1 α = 1 =⇒ x = α−1 αx = α−1 · 0 = 0 =⇒ x = 0;

5. (−1)x = −x

x + (−1)x = (1 − 1)x = 0 · x = 0.

Sottospazi vettoriali

Definizione: V spazio vettoriale su K. W ⊂ V si dice sottospazio vettoriale di V se:

• 0 ∈ W;

• ∀x, y ∈ W, x + y ∈ W ;

• ∀α ∈ K, ∀x ∈ W, αx ∈ W .

dove + e · in questo caso sono le restrizioni della somma e del prodotto su V a W .

Costruire sottospazi

Si puó fare prendendo alcuni vettori e il piú piccolo sottospazio che li contiene.

Sia V sp. vett. su K, v1 , . . . , vn ∈ V , c1 , . . . , cn ∈ K. Chiamiamo c1 v1 + . . . + cn vn combinazione lineare

di v1 , . . . , vn . Chiamiamo poi:

span(v1 , . . . , vn ) = {c1 v1 + . . . + cn vn | c1 , . . . , cn ∈ K}

tale insieme è il piú piccolo sottospazio di V contenente v1 , . . . , vn :

• contiene 0 (tutti i ci = 0);

• contiene vi ∀i = 1, . . . , n;

• (a1 v1 + . . . + an vn ) + (b1 v1 + . . . + bn vn ) = (a1 + b1 )v1 + . . . + (an + bn )vn

(la somma di due combinazioni lineari é ancora una combinazione lineare);

• lo stesso per il prodotto per scalare;

• é il piú piccolo per la definizione che ne abbiamo dato: in un sottospazio vettoriale ci devono

stare v1 , . . . , vn e le loro combinazioni lineari. Abbiamo imposto solo questo nella definizione di

span(v1 , . . . , vn ).

Altri sottospazi

Sia V sp. vett. su K, U, W due sottospazi vettoriali di V. Allora U ∩ W è un sottospazio vettoriale di

V. Verifichiamolo:

• contiene 0 (sia U che W lo contengono);

• ∀x, y ∈ U ∩ W, x + y ∈ U ∩ W , infatti x e y appartengono sia ad U che a W . Essendo questi

sottospazi, la somma de due vettori appartiene ancora ad entrambi, quindi alla loro intersezione;

• lo stesso per il prodotto per scalare.

Vogliamo costruire il piú piccolo sottospazio contenente U e W . Notiamo innanzitutto che U ∪ W non

soddisfa la nostra ricerca, in quanto non è chiuso per somma. Chiamiamo:

U + W = {u + w | u ∈ U, w ∈ W }

La definizione che abbiamo dato é buona, poiché sia u che w appartengono a V , quindi ha senso sommarli.

Ateneo Studenti Fisica

5

Strutture algebriche

Facciamo vedere che é il sottospazio che cercavamo:

• U ⊂ U + W : ∀u ∈ U, u ∈ U + W , perché u = u + 0 (con 0 ∈ W );

• W ⊂ U + W , per lo stesso motivo (con 0 ∈ U );

• 0 ∈ U + W : infatti 0 = 0 + 0;

• ∀u1 , u2 ∈ U, ∀w1 , w2 ∈ W =⇒ (u1 + w1 ) + (u2 + w2 ) = (u1 + u2 ) + (w1 + w2 )

ma (u1 + u2 ) ∈ U, (w1 + w2 ) ∈ W =⇒ (u1 + w1 ) + (u2 + w2 ) ∈ U + W ;

• ∀u ∈ U, ∀w ∈ W, ∀k ∈ K =⇒ k(u + w) = ku + kw

ku ∈ U, kw ∈ W =⇒ k(u + w) ∈ U + W ;

?

• é il piú piccolo: se Z sottosp. vett. t. c. U ⊂ Z, W ⊂ Z =⇒ U + W ⊂ Z:

∀ u + w ∈ U + W, u ∈ U, w ∈ W =⇒ u + w ∈ Z (poiché é sottosp. vett.) =⇒ U + W ⊂ Z

Definizione: se U ∩ W = {0}, allora U + W si denota U ⊕ W e si dice che i due sottospazi sono in

somma diretta tra loro.

Proposizione: in U ⊕ W ogni vettore si scrive in modo unico come: u + w, u ∈ U, w ∈ W .

Dimostrazione: se ∃u1 , u2 ∈ U, ∃w1 , w2 ∈ W t. c. u1 + w1 = u2 + w2 =⇒ u1 − u2 = w1 − w2 .

Ma u1 − u2 ∈ U, w1 − w2 ∈ W =⇒ u1 − u2 ∈ U ∩ W, w1 − w2 ∈ U ∩ W .

Poiché U ∩ W = {0}, u1 − u2 = 0, w1 − w2 = 0, e i vettori sono a due a due uguali.

Definizione: se U é sottospazio vett. di V , un sottospazio W di V si dice supplementare di U se

U ⊕W =V.

N.B.: Il supplementare non é unico.

6

Ateneo Studenti Fisica

Applicazioni Lineari, Sistemi Lineari

Siano V, W K-spazi vettoriali, e sia f : V −→ W un’applicazione. Si dice che f é un’applicazione lineare

se soddisfa:

• ∀x, y ∈ V f (x + y) = f (x) + f (y);

• ∀α ∈ K, ∀x ∈ V f (αx) = αf (x).

Osservazione: Se f é lineare allora f (0) = 0.

Dimostrazione: f (0) = f (0 + 0) = f (0) + f (0) =⇒ f (0) = 0.

Definiamo la moltiplicazione tra due vettori (uno riga e uno colonna, entrambi con n elementi) e tra una

matrice A ∈ M (p, n, K) e un vettore B ∈ Kn :

b1

n

X

def

(a1 . . . an ) · ... = a1 b1 + . . . + an bn =

ai bi

bn

a11

..

.

ap1

...

...

a1n

.. ·

.

apn

i=1

b1

a11 b1 + . . . + a1n bn

.. def

..

. =

.

bn

ap1 b1 + . . . + apn bn

Osservazione: il vettore risultato della seconda moltiplicazione é un vettore C ∈ Kp

Sia A ∈ M (p, n, K) e sia LA : Kn −→ Kp

X 7−→ AX

Si verifica che LA é un’applicazione lineare. Tutte le applicazioni lineari sono

portuna matrice.

Osservazione: A ∈ M (p, n, K), X ∈ Kn , A · X = x1 A1 + . . . + xn An

1

0

Proposizione: sia g : Kn −→ Kp lineare, siano e1 = . , . . . , en =

..

0

formato

da

tutti

0,

eccetto

l’elemento

i-esimo,

uguale

ad

1)

e sia inoltre:

A = g(e1 ) . . .

infatti prodotte da un’op-

0

..

.

(ossia ei é il vettore

0

1

g(en ) . Allora g = LA .

?

Dimostrazione: ∀X ∈ Kn , g(X) = LA (X):

Sapendo che A · X = x1 A1 + . . . + xn An , X = x1 e1 + . . . + xn en e che g é lineare, allora:

LA (X) = AX = x1 A1 + . . . + xn An = x1 g(e1 ) + . . . + xn g(en ) = g(x1 e1 ) + . . . + g(xn en ) =

= g(x1 e1 + . . . + xn en ) = g(X).

Nucleo e Immagine di un’applicazione lineare, Sistemi Lineari

Definizione: Siano V e W due spazi vett. e sia f : V −→ W lineare. Definiamo nucleo e immagine di

f come:

Ateneo Studenti Fisica

7

Applicazioni Lineari, Sistemi Lineari

Kerf = {x ∈ V | f (x) = 0}

Imf = {y ∈ W | ∃x ∈ V t. c. f (x) = y}

Osservazione: f é surgettiva ⇐⇒ Imf = W

Proposizione:

1. Kerf é un sottospazio vett. di V ;

2. Imf é un sottospazio vett. di W ;

3. f é iniettiva ⇐⇒ Kerf = {0}

Dimostrazione: :

1.

• 0 ∈ Kerf , poiché f (0) = 0;

• ∀x, y ∈ Kerf =⇒ x + y ∈ Kerf : f (x + y) = f (x) + f (y) = 0 + 0 = 0;

• ∀x ∈ Kerf, ∀α ∈ K =⇒ αx ∈ Kerf : f (αx) = αf (x) = α · 0 = 0.

2.

• 0 ∈ Imf , poiché f (0) = 0;

• ∀z, w ∈ Imf, ∃x, y ∈ V t. c. z = f (x), w = f (y) =⇒ z + w = f (x) + f (y) =

= f (x + y) =⇒ z + w ∈ Imf ;

• ∀z ∈ Imf, ∃x ∈ V t. c. z = f (x) =⇒ ∀α ∈ K, αz = αf (x) = f (αx) =⇒ αz ∈ Imf .

3. =⇒: Sappiamo che {0} ⊂ Kerf . Facciamo vedere che Kerf ⊂ {0}.

Sia x ∈ Kerf =⇒ f (x) = 0 = f (0). Poiché f é iniettiva: f (x) = f (0) ⇐⇒ x = 0

⇐=: Facciamo vedere che se f (x) = f (y) ⇐⇒ x = y

f (x) − f (y) = f (x − y) = 0 =⇒ x − y ∈ Kerf =⇒ x − y = 0, x = y

Analogamente: KerLA = {X ∈ Kn | AX = 0}.

Risoluzione di sistemi lineari

Definizione: Si dice sistema lineare di p equazioni in n incognite x1 , . . . , xn un sistema nella forma:

a11 x1 + a12 x2 + . . . + a1n xn = b1

a21 x1 + a22 x2 + . . . + a2n xn = b2

...

ap1 x1 + ap2 x2 + . . . + apn xn = bp

tale che aij ∈ K, bk ∈ K.

Definizione: (y1 , . . . , yn ) ∈ Kn é una soluzione di un sistema lineare se é soluzione di tutte le equazioni

che lo compongono. Risolvere un sistema lineare vuol dire trovare tutte le soluzioni.

Definizione: due sistemi lineari si dicono equivalenti fra loro se hanno le stesse soluzioni.

Dedichiamoci ora alla risoluzione dei sistemi lineari. Prima osserviamo che:

Osservazione: i sistemi a scalini sono semplici da risolvere. Essi sono nella forma:

a11 x1 + a12 x2 + a13 x3 + . . . + a1n xn = b1

a22 x2 + a23 x3 + . . . + a2n xn = b2

...

app xp + . . . + apn xn = bp

Chiamiamo aii 6= 0 pivot.

É importante che le incognite calino scendendo nel sistema: é possibile, in tale situazione, risolvere l’ultima equazione ricavando xp = a−1

pp (bp − ap,p+1 xp+1 − . . . − apn xn ), sostituire la variabile ricavata nella

precedente equazione e iterare il processo fino ad arrivare alla prima equazione.

8

Ateneo Studenti Fisica

Applicazioni Lineari, Sistemi Lineari

Osservazione: : Eseguendo su un sistema lineare le seguenti operazioni elementari si ottiene un sistema

ad esso equivalente:

1. scambiare due equazioni (l’ordine non conta);

2. moltiplicare un’equazione per α ∈ K, α 6= 0;

3. sommare ad una equazione un multiplo di un’altra.

Possiamo vedere un sistema lineare anche nella forma:

a11 . . . a1n

..

..

.

.

ap1

...

apn

x1

.. =

.

xn

b1

..

.

bn

dove la matrice appartiene a M (p, n, K) ed é detta matrice dei coefficienti.

Osservazione: AX = B é risolubile ⇐⇒ ∃Y ∈ Kn t. c. AY = B ⇐⇒ B ∈ ImLA .

Se LA é surgettiva il sistema é sempre risolubile (esiste sempre Y t. c. AY = B).

Se LA é iniettiva il sistema ha un’unica soluzione (se esiste Y soluzione, é unica: LA (X) = LA (Y ) ⇐⇒

X = Y ).

Un sistema a scalini é rappresentato da una matrice a scalini.

Ci preoccupiamo ora di trasformare una matrice in una a scalini. Per far questo possiamo usare le seguenti

operazioni elementari per riga (che altro non sono che le operazioni elementari sopra citate):

1. scambiare due righe;

2. moltiplicare una riga per α ∈ K, α 6= 0 (Ai → αAi );

3. sommare ad una riga un multiplo di un’altra (Ai → Ai + βAj ).

Algoritmo di Gauss

Cominciamo con un esempio:

µ

1

2

2

−1

4

3

¶

½

=

x + 2y = 4

2x − y = 3

Se la prima colonna é non nulla, guardo l’elemento [A]11 . Se é 0, scambio due righe portando al primo

posto una riga il cui primo elemento é diverso da 0. A questo punto (nel nostro esempio) A2 → A2 − 2A1 :

µ

¶

1

2

4

0 −5 −5

Faccio in modo che sotto al primo pivot non rimangano che 0, quindi itero il procedimento considerando

il secondo pivot (l’elemento di posto [A]22 ) senza toccare piú la prima riga.

Enunciamo ora l’algoritmo di Gauss per ridurre una matrice A a scalini utilizzando le operazioni per riga:

1. sia j1 il minimo intero t. c. Aj1 6= 0 (prendo la prima colonna non nulla);

2. a meno di scambiare due righe posso supporre che [A]1j1 6= 0;

3. ∀i > 1 sostituisco Ai → Ai − ([A]−1

1j1 · [A]ij1 ) · A1 ;

4. itero il procedimento sulla sottomatrice ottenuta scartando la prima riga e le prime j1 colonne.

Esempio:

1 2 3

1

0

1 2 4 −3 → 0

2 1 0

1

0

2

0

−3

3

1

−6

1

2

0

−3 → 0 −3

1

0

0

3

0

1

−6

1 −3

Teorema:

1. Tramite un numero finito di operazioni per riga ogni matrice puó essere trasformata in una a scalini.

Ateneo Studenti Fisica

9

Applicazioni Lineari, Sistemi Lineari

2. Ogni sistema AX = B é equivalente ad un sistema a scalini (cioé ad A1 X = B1 con (A1 |B1 ) a

scalini).

Osservazione: se AX = B é un sistema equivalente a SX = T , dove (S | T ) é a scalini:

• il sistema é risolubile ⇐⇒ numero di pivots di S = numero di pivots di (S | T );

• se é risolubile, ricavo r variabili in funzione di n − r parametri.

Prodotto di Matrici

Siano f e g due applicazioni lineari tale che:

f

g

Kn −→ Kp −→ Kq

con f (X) = AX e g(X) = BX, dove A ∈ M (p, n, K), B ∈ M (q, p, K).

Osservazione: La composizione di due applicazioni lineari é lineare:

¡

¢

¡

¢

¡

¢

¡

¢

• (g ◦ f )(x + y) = g f (x + y) = g f (x) + f (y) = g f (x) + g f (y) = (g ◦ f )(x) + (g ◦ f )(y);

¡

¢

¡

¢

¡

¢

• (g ◦ f )(αx) = g f (αx) = g αf (x) = αg f (x) = α(g ◦ f )(x).

Anche (g ◦ f ) deve essere indotta da una matrice: ∃C ∈ M (q, n) t. c. (g ◦ f )(X) = CX ∀X ∈ Kn .

Per capire come la matrice C derivi dalle matrici A e B, calcoliamo l’elemento di posto j nel vettore

(g ◦ f )(X) ∈ Kq . Utilizziamo la notazione [(g ◦ f )(X)]j1 in quanto vediamo il vettore come una matrice

con q righe e 1 colonna.

Ricordiamo inoltre che data una matrice A ∈ M (p, n, K) e un vettore X ∈ Kn :

[AX]i1

n

X

¡

¢

=

[A]ik · [X]k1

k=1

[(g◦f )(X)]j1 = [B(AX)]j1 =

p

X

[B]jh ·[AX]h1 =

p

X

h=1

h=1

!

à p

n

n

X

X

¡

¢ X

[B]jh ·

[B]jh · [A]hi ·[X]i1

[A]hi ·[X]i1 =

i=1

i=1

h=1

Dunque se B · A ∈ M (q, n) allora:

[AX]ji =

p

X

[B]jh · [A]hi = Bj · Ai

h=1

Poiché si moltiplica la j-esima riga di B per la i-esima colonna di A, tale prodotto viene detto: prodotto

riga per colonna.

Osservazione: non sempre due matrici sono moltiplicabili: abbiamo visto che la prima deve avere un

numero di colonne pari al numero di righe della seconda.

Si verifica che, nei casi in cui il prodotto ha senso:

• (AB)C = A(BC)

• (λA)B = λ(AB)

• (A + B)C = AC + BC

• A(B + C) = AB + AC

• Ip A = AIq = A, ∀A ∈ M (p, q), In ∈ M (n, n) t. c. [In ]ii = 1, [In ]ji = 0 j 6= i

1

0

..

La matrice In , detta matrice identica é nella forma:

.

0

1

10

Ateneo Studenti Fisica

Applicazioni Lineari, Sistemi Lineari

Ci restingiamo ora al caso delle matrici quadrate,¡ ossia quelle

¢ in cui il numero di righe e di colonne é lo

stesso. Le indichiamo con M (n). Consideriamo M (n), +, · , con · restrizione del prodotto fra matrici

all’insieme delle matrici quadrate. Esso é un anello non commutativo.

Facciamo vedere con un esempio che non vale le proprietá commutativa:

µ

¶ µ

¶ µ

¶

1 2

2 −1

2 5

·

=

3 1

0

3

6 0

µ

2

0

−1

3

¶ µ

1

·

3

2

1

¶

µ

=

−1

9

3

3

¶

Dimostriamo che non esiste l’inverso per tutti gli elementi dell’anello (e dimostriamo quindi che é effettivamente un anello e nonµun corpo).

¶

1 1

Consideriamo la matrice

6= 0 e facciamo vedere che non esiste nessuna matrice che, moltipli0 0

candola a destra, ci dia la matrice identitá:

µ

¶ µ

¶ µ

¶ µ

¶

1 1

a b

a+b c+d

1 0

·

=

=

0 0

c d

0

0

0 1

Ne ricaviamo un assurdo, poiché abbiamo 0 = 1.

Definizione: sia A un anello, a ∈ A, a 6= 0 si dice divisore di zero se ∃b ∈ A, b 6= 0 t. c. a · b = 0.

Osservazione: un campo e un corpo non contengono divisori di 0 (a causa dell’esistenza dell’inverso).

Facciamo vedere che l’anello considerato contiene divisori di 0:

µ

¶ µ

¶ µ

¶

1 0

0 0

0 0

·

=

0 0

1 1

0 0

Definizione: A ∈ M (n) si dice nilpotente se ∃m ∈ N t. c. Am = 0.

La seguente matrice é nilpotente:

µ

¶ µ

¶ µ

¶

0 1

0 1

0 0

·

=

0 0

0 0

0 0

Ateneo Studenti Fisica

11

Dimensione e base di uno spazio

vettoriale

Definizione: V spazio vettoriale si dice finitamente generato se ∃v1 , . . . , vn t. c. V = span(v1 , . . . , vn ),

cioé

n

X

∀v ∈ V ∃c1 , . . . , cn ∈ K t. c. v =

ci vi

i=1

.

Osservazione:

¡ R[x]

¢ non é finitamente generato. Se p1 (x), . . . , pm (x) fossero generatori, detto

s = max deg pi (x) , ∀i = 1, . . . , m, non si potrebbero ottenere polinomi di grado maggiore ad s.

Definizione: v1 , . . . , vn ∈ V si dicono linearmente indipendenti se l’unica combinazione lineare nulla dei

vi é quella con i coefficienti tutti nulli. Ossia:

c1 v1 + . . . + cn vn = 0 ⇐⇒ c1 = . . . = cn = 0

Definizione: {v1 , . . . , vn } si dice base di V se sono generatori di V e linearmente indipendenti.

Esempi:

{e1 , . . . , en } sono una base di Kn

{1, x, . . . , xd } sono una base di Kd [x], ossia il sottospazio vettoriale di K[x] contenente i polinomi di grado

minore o uguale a d.

Osservazione: v ∈ V é linearmente indipendente =⇒ v 6= 0.

Proposizione: se uno almeno fra v1 , . . . , vk é nullo =⇒ v1 , . . . , vk sono linearmente dipendenti;

Dimostrazione: se v1 = 0 =⇒ v1 + 0 · v2 + . . . + 0 · vn = 0, ma il primo coefficiente é non nullo.

Proposizione: Sia k ≥ 2. v1 , . . . , vk sono linearmente indipendenti ⇐⇒ almeno uno di essi é combinazione lineare degli altri.

Dimostrazione:

=⇒: ∃α1 , . . . , αk ∈ K non tutti nulli t. c. α1 v1 + . . . + αk vk = 0.

Se per esempio: α1 6= 0 =⇒ α1 v1 = −(α2 v2 + . . . + αk vk ) =⇒ v1 = −α1−1 (α2 v2 + . . . + αk vk ). Cioé v1 é

combinazione lineare degli altri vettori.

⇐=: Se v1 = b2 v2 + . . . + bk vk =⇒ v1 − b2 v2 − . . . − bk vk = 0, ossia sono linearmente dipendenti.

Osservazione: v1 , . . . , vk sono vettori linearmente indipendenti e m ≤ k =⇒ v1 , . . . , vm sono linearmente indipendenti.

Osservazione: se vp ∈ span(v1 , . . . , vp−1 ) =⇒ span(v1 , . . . , vp ) = span(v1 , . . . , vp−1 ).

Proposizione: Se B = {v1 , . . . , vm } é una base di V , allora ogni v ∈ V si scrive in modo unico come:

v = a1 v1 + . . . + am vm . a1 , . . . , am si dicono coordinate di v rispetto alla base B e si scrive [v]B .

Dimostrazione:

Se v = a1 v1 + . . . + am vm = b1 v1 + . . . + bm vm =⇒ (a1 − b1 )v1 + . . . + (am − bm )vm = 0.

Essendo v1 , . . . , vm linearmente indipendenti: ai − bi = 0 ∀i = 1, . . . , m =⇒ ai = bi ∀i = 1, . . . , m.

In uno spazio Kn le componenti di un vettore coincidono con le coordinate, se si una la base canonica

C = {e1 , . . . , en }.

12

Ateneo Studenti Fisica

Dimensione e base di uno spazio vettoriale

Fissare B base di V significa fissare l’applicazione: [ ]B : V −→ Kn .

Verifichiamo che l’applicazione [ ]B é lineare:

?

• [ ]B (v + w) = [ ]B (v) + [ ]B (w)

v = a1 v1 + . . . + an vn , w = b1 v1 + . . . + bn vn

a1 + b1

a1

b1

.. ..

.

.

[v + w]B =

= . + .

.

an + bn

an

=⇒ v + w = (a1 + b1 )v1 + . . . + (an + bn )vn

= [v]B + [w]B ;

bn

• allo stesso modo per il multiplo.

¡

¢

[ ]B é iniettiva: se v¡ ∈ Ker[ ]B ¢=⇒ [v]B = 0, . . . , 0 ¡=⇒ v = 0 ·¢v1 + . . . + 0 · vn .

[ ]B é surgettiva: ∀ c1 , . . . , cn ∃v ∈ V t. c. [v]B = c1 , . . . , cn , basta prendere v = c1 v1 + . . . + cn vn .

Definizione: un’applicazione lineare inettiva e surgettiva si dice isomorfismo.

Definizione: quando tra due spazi vettoriale c’é un isomorfismo si dicono isomorfi.

Teorema: sia {v1 , . . . , vn } una base di V , e siano w1 , . . . , wp p vettori di V . Se p > n =⇒ w1 , . . . , wp

sono linearmente dipendenti.

Dimostrazione: Essendo {v1 , . . . , vn } una base posso scrivere w1 , . . . , wp come loro combinazioni lineari:

w1 = a11 v1 + . . . + an1 vn

w2 = a12 v1 + . . . + an2 vn

..

.

wp = a1p v1 + . . . + anp vn

Cerco α1 , . . . , αp non tutti nulli t. c. α1 w1 + . . . + αp wp = 0:

0 = α1 w1 + . . . + αp wp = α1 (a11 v1 + . . . + an1 vn ) + . . . + αp (a1p v1 + . . . + anp vn ) =

= (a11 α1 + . . . + a1p αp )v1 + . . . + (an1 α1 + . . . + anp αp )vn

Ma v1 , . . . , vn sono tutti linearmente indipendenti, quindi una loro combinazione lineare nulla si ottiene

sono se i coefficienti sono tutti nulli, cioé se:

a11 α1 + . . . + a1p αp = 0

..

.

an1 α1 + . . . + anp αp = 0

Quindi (α1 , . . . , αp ) devono essere soluzioni del sistema lineare omogeneo (i cui termini noti sono tutti

nulli)

é:

la cui matrice associata

a11 . . . a1p

..

.. ∈ M (n, p)

.

.

an1 . . . anp

Sappiamo che un sistema omogeneo ha sempre soluzione (almeno la soluzione nulla), ma ci interessa che

ne abbia almeno un’altra non nulla. Osserviamo che il numero di pivot é al piú n, ma n < p, quindi esiste

almeno un’altra soluzione (α1 , . . . , αp ) non nulla.

Corollario: se B = {v1 , . . . , vn } e S = {w1 , . . . , wp } sono due basi di V =⇒ n = p

Dimostrazione: dal teorema n ≥ p, ma anche p ≥ n, poiché sono entrambe basi =⇒ n = p

Definizione:

se V ammette una base ©Bª= {v¢1 , . . . , vn }, si dice che V ha dimensione n e si indica

¡

dimV = n per convenzione si pone dim 0 = 0 .

© ª

Proposizione: sia V 6= 0 . Da ogni insieme finito di generatori é possibile estrarre una base di V (ogni

spazio vettoriale finitamente generato ammette una base).

Ateneo Studenti Fisica

13

Dimensione e base di uno spazio vettoriale

Dimostrazione: sia v1 , . . . , vk un insieme di generatori di V©. Posso

supporre

ª

© ªvi 6= 0 ∀i = 1, . . . , k.

v1 é linearmente indipendente©poichéª é diverso da 0. Se span v1 = V =⇒ v1 é base di V .

Altrimenti consideriamo

v2 , altrimenti

© v2 e v1 , vª2 . Se sono linearmente indipendenti allora

© tengo

ª

©

ª lo si

scarta e© i rimanenti

v

,

v

,

.

.

.

,

v

sono

ancora

generatori,

poiché

v

∈

span

v

=⇒

span

v

,

v

k ª

2

1

1 2 =

ª

©1 3

©

ª

= span v1 =⇒ span v1 , v3 , . . . , vk = span v1 , v2 , v3 , . . . , vk .

Si itera l’algoritmo per gli altri generatori. Alla fine si ottiene una lista di vettori linearmente indipendenti

e generatori.

Corollario: se v1 , . . . , vk generano V =⇒ dimV ≤ k

Lemma: se dimV = n e v1 , . . . , vn sono linearmente indipendenti =⇒ {v1 , . . . , vn } é una base di V .

Dimostrazione: se per assurdo v1 , . . . , vn non generano V =⇒ ∃v ∈ V − span(v1 , . . . , vn ). Allora

v1 , . . . , vn , v sono linearmente indipendenti, infatti sia a1 v1 + . . . + an vn + bv = 0; sicuramente b = 0 altrimenti v ∈ span(v1 , . . . , vn ), ma v1 , . . . , vn sono linearmente indipendenti, quindi a1 = 0 ∀i = 1, . . . , n.

Abbiamo allora trovato n + 1 vettori linearmente indipendenti, ma dimV = n. Assurdo.

Teorema: (di completamento a base) se dimV = n e {v1 , . . . , vk } sono vettori linearmente indipendenti,

(k ≤ n) =⇒ ∃vk+1 , . . . , vn ∈ V t. c. {v1 , . . . , vk , vk+1 , . . . , vn } é una base di V .

Dimostrazione: se k = n é giá una base. Se k < n =⇒ v1 , . . . , vk =⇒ span(v1 , . . . , vk ) ⊂ V . Quindi

∃vk+1 ∈ V − span(v1 , . . . , vk ) t. c. v1 , . . . , vk , vk+1 sono linearmente indipendenti. Se k + 1 = n la base

é trovata, altrimenti si itera il procedimento cercando vk+2 ∈ V − span(v1 , . . . , vk+1 ).

Osservazione: se v1 , . . . , vk sono linearmente indipendenti e conosco una base B = {w1 , . . . , wn } di

V =⇒ posso completare v1 , . . . , vk a base cosı́: {v1 , . . . , vk , w1 , . . . , wn }. Ottengo in tal modo un insieme

di generatori di V non tutti linearmente indipendenti. Da questo, applicando l’algoritmo sopra esposto,

estraggo una base di V della forma: S = {v1 , . . . , vn , w1 , . . . , win−k }.

Proposizione: sia V uno spazio vettoriale finitamente generato, W ⊂ V sottospazio vettoriale =⇒ W

é finitamente generato e dimW ≤ dimV .

Dimostrazione: se W = {0} sicuramente dimV ≥ 0. Sia quindi W 6= {0} =⇒ ∃w1 ∈ W, w1 6= 0.

{w1 } é linearmente indipendente in W e anche in V , poiché w1 ∈ V e la verifica da fare é la stessa.

Ora, se span(w1 ) = W =⇒ dimW = 1 e dimV ≥ 1.

Altrimenti se span(w1 ) ⊂ W =⇒ ∃w2 ∈ W − span(w1 ) t. c. {w1 , w2 } sono linearmente indipendenti in

V e W . Si itera il procedimento un numero finito di volte, al piú pari a dimV , poiché quest’ultimo é

finitamente generato.

Corollario: se dimW = dimV, W ⊂ V =⇒ W = V .

Dimostrazione: dimW = n =⇒ B = {w1 , . . . , wn } é base di W . Ma w1 , . . . , wn ∈ V , sono linearmente

indipendenti e generatori, sono n = dimV =⇒ V = span(w1 , . . . , wn ) = W .

Formula di Grassman

Sia V uno spazio vettoriale, e siano U, W ⊂ V sottospazi vettoriali. Allora:

dim(U + W ) = dimU + dimW − dim(U ∩ W )

Dimostrazione: sia {v1 , . . . , vm } una base di U ∩ W . Possiamo completare a base di U e di W :

∃um+1 , . . . , up ∈ U t. c. {v1 , . . . , vm , um+1 , . . . , up } base di U . Allora dimU = p.

∃wm+1 , . . . , wq ∈ W t. c. {v1 , . . . , vm , wm+1 , . . . , wq } base di W . Quindi dimW = q.

Proviamo che dim(U + W ) = p + q − m; basta provare che {v1 , . . . , vm , um+1 , . . . , up , wm+1 , . . . , wq } é

una base di U + W , poiché sono nel numero giusto. Dimostriamo innanazitutto che sono generatori:

∀u + w ∈ U + W :

u = a1 v1 + . . . + am vm + bm+1 um+1 + . . . + bp up ;

w = c1 v1 + . . . + cm vm + dm+1 wm+1 + . . . + dq wq ;

quindi ogni u + w ∈ U + W si scrive come combinazione lineare di questi vettori. Dimostriamo ora che

sono linearmente indipendenti:

a1 v1 + . . . + am vm + bm+1 um+1 + . . . + bp up + cm+1 wm+1 + . . . + cq wq = 0

a1 v1 + . . . + am vm + bm+1 um+1 + . . . + bp up = −(cm+1 wm+1 + . . . + cq wq )

14

Ateneo Studenti Fisica

Dimensione e base di uno spazio vettoriale

quindi cm+1 wm+1 +. . .+cq wq appartiene sia a W (poiché combinazione di wm+1 , . . . , wq ), sia a U (poiché

combinazione lineare di v1 , . . . , vm , um+1 , . . . , up base di U ). Allora:

cm+1 wm+1 + . . . + cq wq ∈ U ∩ W =⇒ ∃α1 , . . . , αm t. c. cm+1 wm+1 + . . . + cq wq = α1 v1 + . . . + αm vm

La combinazione lineare nulla di cui sopra diventa:

a1 v1 + . . . + am vm + bm+1 um+1 + . . . + bp up + α1 v1 + . . . + αm vm = 0

Essa é una combinazione lineare nulla dei vettori della base di U , che sono linearmente indipendenti.

Sicuramente quindi bi = 0 ∀i = m + 1, . . . , p. In tal modo abbiamo che:

a1 v1 + . . . + am vm + cm+1 wm+1 + . . . + cq wq = 0

Ma tali vettori formano una base di W =⇒ i coefficienti di una loro combinazione lineare nulla sono tutti

nulli. Dunque {v1 , . . . , vm , um+1 , . . . , up , wm+1 , . . . , wq } é una base di U + W .

Corollario: se U ∩ W = {0} =⇒ dim(U ⊕ W ) = dimU + dimW .

Proposizione: sia V uno spazio vettoriale, U ⊂ V sottospazio vettoriale. Sia {u1 , . . . , up } una base di

U , ∃vp+1 , . . . , vn ∈ V t. c. {u1 , . . . , up , vp+1 , . . . , vn } é una base di V . Sia Z = span(vp+1 , . . . , vn )

=⇒ V = U ⊕ Z.

Dimostrazione: facciamo innanzitutto vedere che U ∩ Z = {0}:

Se v ∈ U ∩ Z allora possiamo scrivere v come:

v = a1 u1 + . . . + ap up , dato che v ∈ U e

v = bp+1 vp+1 + . . . + bn vn , dato che v ∈ Z.

Allora, eguagliando le due espressioni:

a1 u1 + . . . + ap up − bp+1 vp+1 − . . . − bn vn = 0.

Ma una combinazione lineare nulla dei vettori della base di V é possibile se e solo se i coefficienti sono

tutti nulli. Allora v = 0 é l’unico vettore in U ∩ Z.

Mostriamo ora che U ⊕ Z = V . Sappiamo che:

dim(U ⊕ Z) = dimV , ma anche U ⊕ Z ⊂ V =⇒ U ⊕ Z = V .

Proposizione: sia V = U ⊕ Z, B = {u1 , . . . , up } base di U , S = {z1 , . . . , zq } base di Z. Allora B ∪ S é

base di V .

Dimostrazione: Sicuramente sono generatori, visto la loro somma diretta é V . Facciamo vedere che

sono anche linearmente indipendenti:

α1 u1 + . . . + αp up + β1 z1 + . . . + βq zq = 0 =⇒ α1 u1 + . . . + αp up = −(β1 z1 + . . . + βq zq )

Allora sia α1 u1 + . . . + αp up che β1 z1 + . . . + βq zq appartengono contemporaneamente a U e Z, quindi

appartengono a U ∩ Z.

Ma U ∩ Z = {0}, quindi:

α1 u1 + . . . + αp up = 0

β1 z1 + . . . + βq zq = 0

Essendo u1 , . . . , up linearmente indipendenti (poiché formano una base di U ), cosı́ come z1 , . . . , zq , tutti

i coefficienti αi , βi sono zero, quindi i vettori {u1 , . . . , up , z1 , . . . , zq } sono tra loro tutti linearmente

indipendenti e formano una base di V .

Ateneo Studenti Fisica

15

Rango di un’applicazione lineare

Lemma: siano V e W due spazi vettoriali, f : V −→ W un’applicazione lineare. Allora

1. se v1 , . . . , vk sono vettori linearmente indipendenti in V e f é iniettiva =⇒ f (v1 ), . . . , f (vk ) sono

indipendenti in W ;

2. se v1 , . . . , vk generano V =⇒ f (v1 ), . . . , f (vk ) generano Imf (se f é surgettiva generano W ).

Dimostrazione:

1. a1 f (v1 ) + . . . + ak f (vk ) = f (a1 v1 + . . . + ak vk ) = 0 =⇒ a1 v1 + . . . + ak vk ∈ Kerf = {0} =⇒

=⇒ a1 = . . . = ak = 0;

2. ∀f (y) ∈ Imf, y ∈ V, ∃b1 , . . . , bk t. c. y = b1 v1 + . . . + bk vk =⇒ f (y) = f (b1 v1 + . . . + bk vk ) =

= b1 f (v1 ) + . . . + bk f (vk ). Ogni vettore in Imf é generato da f (v1 ), . . . , f (vk ).

Corollario: se f é un isomorfismo =⇒ f trasforma una base di V in una di W .

Teorema: (formula delle dimensioni) sia f : V −→ W lineare =⇒ dimV = dimKerf + dimImf .

Dimostrazione: sia dimV = n, dimKerf = p. Proviamo che dimImf = n − p.

Sia {v1 , . . . , vp } una base di Kerf . La completiamo a base di V : B = {v1 , . . . , vp , vp+1 , . . . , vn } =⇒

=⇒ f (v1 ), . . . , f (vp ), f (vp+1 ), . . . , f (vn ) generano Imf (per il Lemma 2). Ma f (v1 ) = . . . = f (vp ) = 0,

quindi basta dimostrare che f (vp+1 ), . . . , f (vn ) sono linearmente indipendenti:

0 = ap+1 f (vp+1 ) + . . . + an f (vn ) = f (ap+1 vp+1 + . . . + an vn ) =⇒ ap+1 vp+1 + . . . + an vn ∈ Kerf =⇒

=⇒ ∃b1 , . . . , bp ∈ K t. c. ap+1 vp+1 + . . . + an vn = b1 v1 + . . . + bp vp =⇒

=⇒ ap+1 vp+1 + . . . + an vn − (b1 v1 + . . . + bp vp ) = 0 =⇒ ap+1 = . . . = an = b1 = . . . = bp = 0

Poiché sono tutti vettori di una base di V , quindi linearmente indipendenti. Dunque dimImf = n − p =

= dimV − dimKerf .

Conseguenze:

1. dimImf ≤ dimV ;

2. se dimV = dimW, f é iniettiva ⇐⇒ f é surgettiva

Dimostrazione: (=⇒): f iniettiva =⇒ Kerf = {0} =⇒ dimW = dimV = dimImf =⇒ essendo

Imf ⊂ W, dimImf = dimW =⇒ Imf = W .

(⇐=): f surgettiva ⇐⇒ Imf = W =⇒ dimKerf = dimV − dimImf = dimV − dimW = 0 =⇒

=⇒ Kerf = {0} =⇒ f é iniettiva;

Corollario: V, W K-spazi vettoriali, V, W sono isomorfi ⇐⇒ dimV = dimW .

Dimostrazione:

(⇐=) : dimV = dimW = n =⇒ V ∼

= Kn ∼

= W.

(=⇒) : ∃f : V −→ W isomorfismo di spazi vettoriali =⇒ Kerf = {0}, Imf = W =⇒ dimV =

dimKerf + dimImf = dimW .

Si dice che V e W appartengono alla stessa classe di equivalenza.

Classe di Equivalenza

Definizione: Sia E un insieme. Data R una relazione tra gli elementi dell’insieme, é possibile stabilire

se, presi due elementi di E, essi sono in relazione fra loro. In particolare R é una relazione di equivalenza

16

Ateneo Studenti Fisica

Rango di un’applicazione lineare

se valgono le seguenti proprietá:

• riflessiva: ∀x ∈ E xRx;

• simmatrica: ∀x, y ∈ E, xRy =⇒ yRx;

• transitiva: ∀x, y, z ∈ E, xRy e yRz =⇒ xRz.

Definizione: ∀x ∈ E, R relazione di equivalenza, si dice classe di equivalenza di x l’insieme: [x] = {y ∈

E | yRx}

Proprietá:

1.

S

[x] = E (ossia le classi di equivalenza ricoprono E);

2. [x] = [y] ⇐⇒ xRy:

Dimostrazione: (=⇒): x ∈ [x] = [y] =⇒ x ∈ [y] =⇒ xRy per definizione di classe d’equivalenza.

(⇐=): ∀z ∈ [x] zRx, poiché si ha anche che xRy =⇒ zRy (proprietá transitiva) =⇒ z ∈ [y]. Vale

il viceversa: ∀z ∈ [y] zRy, yRx (proprietá riflessiva) =⇒ zRx =⇒ z ∈ [x];

3. se [x] 6= [y] =⇒ [x] ∩ [y] = ∅.

Definizione: dato E un insieme, R una relazione d’equivalenza, si dice insieme quoziente:

E/R = {[x] | x ∈ E}

Proposizione: siano V , W e Z tre spazi vettoriali, e siano f, g due applicazioni lineari tali che:

f

g

V −→ W −→ Z:

¡

¢

1. dimIm(g ◦ f ) ≤ min dimImf, dimImg ;

2. se f é un isomorfismo =⇒ dimIm(g ◦ f ) = dimImg;

3. se g é un isomorfismo =⇒ dimIm(g ◦ f ) = dimImf .

Dimostrazione: :

1. dimIm(g ◦ f ) = dimIm(g |

) = dimImf − dimKer(g |

) ≤ dimImf .

Imf

Imf

Im(g ◦ f ) ⊆ Img =⇒ dimIm(g ◦ f ) ≤ dimImg.

¡

¢

Allora, dovendo essere minore dell’una e dell’altra: dimIm(g ◦ f ) ≤ min dimImf, dimImg ;

2. f isomorfismo =⇒ f surgettiva, quindi Imf = W . Allora:

dimIm(g ◦ f ) = dimIm(g |

) = dimIm(g | ) = dimImg;

W

Imf

3. g isomorfismo =⇒ g iniettiva, quindi Kerg = {0}. Allora:

dimIm(g ◦ f ) = dimImf − dimKer(g |

) = dimImf − dim{0} = dimImf .

Imf

Teorema: sia dimV = n e sia B = {v1 , . . . , vn } una base di V . Siano w1 , . . . , wn vettori di W . =⇒

∃!f lineare tale che f : V −→ W e f (vi ) = wi ∀i = 1, . . . , n.

Dimostrazione:

Esistenza:

∀v ∈ V, ∃a1 , . . . , an ∈ K, unici, t. c. v = a1 v1 + . . . + an vn .

Definiamo f (v) = a1 w1 + . . . + an wn . Proviamo che tale definizione verifica i vincoli, ossia che f definita

in questo modo é lineare:

• ∀v, w ∈ V, v ¡= a1 v1 + . . . + an vn , w = b1 v¢1 + . . . + bn vn .

f (v +w) = f (a1 +b1 )v1 +. . .+(an +bn )vn = (a1 +b1 )w1 +. . .+(an +bn )wn = a1 w1 + . . . + an wn +

+ b1 w1 + . . . + bn wn = f (v) + f (w);

• Lo stesso si fa per il multiplo.

Ateneo Studenti Fisica

17

Rango di un’applicazione lineare

Unicitá:

∀v ∈ V, v = a1 v1 + . . . + an vn .

Se f é un’applicazione lineare tale che f (vi ) = wi ∀i = 1, . . . , n, allora:

f (v) = f (a1 v1 + . . . + an vn ) = a1 f (v1 ) + . . . + an f (vn ) = a1 w1 + . . . + an wn .

Quindi la definizione che abbiamo dato é l’unica affiché f fosse lineare.

Definizione: sia f un’applicazione lineare. Si dice rango di f (e si indica rkf ) la dimensione di Imf .

Cominciamo considerando le matrici M (p, q, K), ovvero le applicazioni lineari da Kq a Kp .

Se A ∈ M (p, q, K), data C = {e1 , . . . , eq } la base canonica di Kq , abbiamo dimostrato che Ae1 , . . . , Aeq

generano l’immagine di A.

Ma Aei = Ai , ossia l’i-esima colonna di A. Quindi: ImA = span(A1 , . . . , Aq ).

Proposizione: sia A ∈ M (p, n) e sia S una sua ridotta a scala. Allora rkA = rkS.

Dimostrazione: dalla formula delle dimensioni:

rkA = dimImA = dimKn − dimKerA = n − dimKerA;

rkS = n − dimKerS.

Ma KerA = KerS. Infatti essi sono gli insiemi delle soluzioni dei due sistemi lineari omogenei associati:

AX = 0 e SX = 0. Essendo essi due sistemi equivalenti (S é ottenuto da A tramite riduzione di Gauss)

hanno le stesse soluzioni, cioé KerA = KerS =⇒ rkA = rkS.

Calcolo del rango di una matrice a scalini S e di una base di ImS

Proposizione: sia S ∈ M (p, n, K), con p1 , . . . , pr r pivots non nulli nelle colonne S j1 , . . . , S jr . Allora

esse formano una base di ImS e che, quindi, rkS = r.

Dimostrazione: S j1 , . . . , S jr sono linearmente indipendenti:

a1 S j1 +. . .+ar S jr = 0. Dalla prima somma otteniamo un vettore. Consideriamo l’ultima componente

non nulla di tale vettore (che otteniamo dalla sola colonna S jr ):

..

..

. .

ar pr = 0

0

0

Affinché sia uguale a 0, poiché pr 6= 0 per ipotesi =⇒ ar = 0. Si itera il procedimento, considerando che

ora l’ultima componente non nulla é data dalla colonna S jr−1 .

Sono generatori:

facciamo vedere che ∀i 6= j1 , . . . , jr , S i é una combinazione lineare di S j1 , . . . , S jr , ossia che

∃a1 , . . . , ar ∈ K t. c. S i = a1 S j1 + . . . + ar S jr . Cercare a1 , . . . , ar significa cercare le soluzioni del

seguente sistema lineare:

a

1

.

S j1 . . . S jr ·

.. = S i

ar

Sappiamo che la soluzione esiste se non compare un pivot nella colonna dei termini noti. Nel nostro caso

tutte le colonne in cui compaiono pivot sono S j1 , . . . , S jr , quindi esiste la soluzione, poiché abbiamo posto

i 6= j1 , . . . , jr .

Corollario: In particolare il numero di pivots non dipende dalla riduzione a scala (abbiamo dimostrato

che il rango é invariante rispetto alla riduzione di Gauss).

Matrici Elementari e invertibili

Sia M ∈ M (m, n). Le mosse di Gauss per riga si realizzano moltiplicando M a sinistra con opportune

matrici elementari, che si ottengono apportando modifiche alla matrice identitá:

18

Ateneo Studenti Fisica

Rango di un’applicazione lineare

1. scambiare due righe i, j t. c. i 6= j, 1 ≤ i, j ≤ m. La relativa matrice elementare (Aij ) si ottiene

dalla matrice identitá scambiando la riga i-esima con la j-esima;

2. moltiplicare la riga i-esima per k: basta moltiplicare la i-esima riga della matrice identitá per k e

otteniamo la matrice elementare (Bik );

3. aggiungere alla i-esima riga k volte la j-esima:

I

1

Cijk =

k

I

1

I

dove si é indicata con I un’opportuna matrice identitá (ossia una serie di 1 sulla diagonale). k

compare nel posto [C]ij .

Sappiamo che le mosse di Gauss sono invertibili, quindi devono essere indotte da matrici invertibili. Infatti:

A2ij = I (scambiando due volte le righe i, j otteniamo nuovamente la matrice di partenza);

Bi k1 · Bik = I (moltiplicando la riga i per k e k1 otteniamo la riga stessa);

Ci,j,k · Ci,j,−k = I (sommiamo e sottraiamo la stessa riga moltiplicata per k).

Osservazione: Per ottenere le mosse di Gauss sulle colonne, anziché sulle righe, basta utilizzare le stesse

matrici elementari moltiplicando a destra.

Proposizione: Sia A ∈ M (n) (A : Kn −→ Kn ). Sono fatti equivalenti:

1. A é una matrice invertibili;

2. A é un isomorfismo;

3. rkA = n.

Dimostrazione:

(1) ⇐⇒ (2): A matrice invertibile ⇐⇒ ∃B ∈ M (n) t. c. A · B = B · A = I ⇐⇒ (considerando A e B

come applicazioni lineari) B é l’inversa di A ⇐⇒ A é bigettiva ⇐⇒ A é un isomorfismo.

(2) ⇐⇒ (3): A isomorfismo ⇐⇒ n = dim(Kn ) = dim(ImA) + dim(KerA) = rkA + dim{0} = rkA.

¡

¢

Teorema: (di Rouché-Capelli

¡ ) ¢AX =¡B é ¢risolubile ⇐⇒ rkA = rk A|B .

Dimostrazione:

(sono

equivalenti ). Sappiamo che rkA = rkS,

¡

¢

¡

¢(idea)¡ A|B

¢ → S|T a scalini

¡

¢

rk A|B = rk S|T . Ma S|T é risolubile ⇐⇒ rk S|T = rkS.

Data A ∈ M (p, n) sappiamo che ImA = span(A1 , . . . , An ). Resta da determinare una base di ImA,

sapendo che dim(ImA) = rkA = rkS = r. A tal proposito consideriamo una qualunque riduzione di

Gauss che trasforma la matrice A in S (a scalini). Sappiamo che ∃E1 , . . . , Em matrici elementari tali

che:

S = Em · . . . · E1 · A

Detta M = Em · . . . · E1 , possiamo dare un’interpretazione dell’algoritmo di Gauss sotto forma di

applicazioni lineari:

A

M

Kn −→ Kp −→ Kp

Sappiamo che M é una matrice invertibile (poiché prodotto di matrici invertibili), dunque é un isomorfismo di spazi vettoriali. Ma un isomorfismo manda basi in basi, quindi M trasforma una base di ImS in

una di ImA.

Sia {S j1 , . . . , S jr } una base di ImS. Poiché M · Aj = S j :

M · Aj1 = S j1

..

.

M · Ajr = S jr

Ateneo Studenti Fisica

19

Rango di un’applicazione lineare

Di conseguenza {Aj1 , . . . , Ajr } sono una base di ImA.

Conseguenza: Algoritmo di estrazione di una base per span(v1 , . . . , vm ), v1 , . . . , vm ∈ Kp . Costruiamo

la seguente matrice:

v1

...

vm ∈ M (p, m).

Allora span(v1 , . . . , vm ) = ImA. Per trovare la base cercata si considerano le colonne che in una ridotta

a scala contengono i pivots. Abbiamo visto che tali colonne formano una base di ImA, quindi anche di

span(v1 , . . . , vm ).

Osservazione: sia V un qualsiasi spazio vettoriale, non necessariamente Kn , e siano v1 , . . . , vm vettori

di V da cui vogliamo estrarre una base di span(v1 , . . . , vm ). Fissata B una base di V , abbiamo l’isomorfismo [ ]B : V −→ Kn . Si applica l’algoritmo di estrazione di una base a [v1 ]B , . . . , [vn ]B .

Calcolo della matrice inversa attraverso l’algoritmo di Gauss

Sia A ∈ M (n)µ t. c. rkA

¶ = n. Cerchiamo X tale che AX = I (inversa a destra).

1 2

Es. Sia A =

. Si puó calcolare il rango attraverso una riduzione di Gauss e vedere che rkA = 2.

1 3

Cerchiamo una matrice X tale che:

µ

¶ µ

¶ µ

¶

1 2

x y

1 0

·

=

1 3

z t

0 1

Ossia

AX 1 = I 1¶, AXµ2 = I 2 . Possiamo

il sistema

µ

¶ rappresentare

µ

¶ (e risolverlo): µ

1 0

3 −2

1 2 1 0

1 2

1 0

3

→

→

. Quindi X =

1 3 0 1

0 1 −1 1

0 3 −1

1

−1

cercavamo.

Ripetiamo il procedimento nel caso generico con A ∈ M (n):

1

1

AX = I

¡

¢

¡

¢

Gauss

..

⇐⇒

A

|

I

−→

I

|

B

⇐⇒

.

AX n = I n

IX 1 = B 1

..

.

n

IX = B

−2

1

¶

é quello che

⇐⇒ X = B

n

Facciamo vedere che B é anche inversa a sinistra:

¡

¢

¡

¢ ¡

¢

∃M invertibile (prodotto di elementari) t. c. I | B = M A | I = M A | M I =⇒ B = M I = M,

I = M A = BA.

Matrice associata a un’applicazione lineare

Proposizione: Siano V e W due spazi vettoriali tali che n = dimV, p = dimW , e sia f : V −→ W

un’applicazione lineare. Siano B = {v1 , . . . , vn } e S = {w1 , . . . , wp } basi rispettivamente di V e di W .

Sia A ∈ M (p, n) tale che:

£

¤

£

¤

A = f (v1 ) S . . . f (vn ) S

che indichiamo come A = mB,S (f ) o A = mB

S (f ) (cioé la matrice associata nelle basi B e S ad f ).

£ ¤

£

¤

Proposizione: se A = mB

f (v) S = A · v B

S (f ) =⇒ ∀v ∈ V

¡

¢

Dimostrazione: ∀v ∈ V ∃a1 , . . . , an ∈ K, t. c. v = a1 v1 + . . . + an vn =⇒ [v]B = a1 , . . . , an .

Per linearitá di f e sostituendo i valori di f (v1 ), . . . , f (vn ) otteniamo:

f (v) = a1 f (v1 ) + . . . + an f (vn ) = a1 (a11 w1 + . . . + ap1 wp ) + . . . + an (a1n w1 + . . . + apn wp ) =

= (a11 a1 + . . . + a1n an )w1 + . . . + (ap1 a1 + . . . + apn an )wp .

20

Ateneo Studenti Fisica

Rango di un’applicazione lineare

Allora:

a11 a1 + . . . + a1n an

a11

£

¤

.

.

..

f (v) S =

= ..

ap1 a1 + . . . + apn an

ap1

...

a1n

.. ·

.

apn

a1

.. = A · £v ¤

.

B

an

Osservazione: Da quanto sopra segue che il diagramma:

f

V −→ W

↓

↓

A

Kn −→ Kp

é commutativo.

Proposizione: Siano V , W spazi vettoriali, con n = dimV e p = dimW , f : V −→ W lineare e siano

B = {v1 , . . . , vn } e S = {w1 , . . . , wp } basi rispettivamente di V e W . Allora l’applicazione:

α

f −→ mB

S (f )

che ad ogni applicazione associa la sua matrice associata nelle basi B e S, é un isomorfismo.

Dimostrazione: α é lineare:

£

¤

£

¤

∀f, g ∈ Hom(V, W ), α(f + g) = (f + g)(v1 ) S . . . (f + g)(vn ) S

¡

¢

Utilizzando la definizione di somma di funzioni (f + g)(v) = f (v) + g(v) e la linearitá di [ ]S :

£

¤

£

¤

£

¤

£

¤

α(f + g) = f (v1 ) S . . . f (vn ) S + g(v1 ) S . . . g(vn ) S = α(f ) + α(g)

Allo stesso modo per il multiplo.

α é iniettiva (dimostriamo che Ker(f ) = {0}):

se α(f ) = 0 (matrice nulla) =⇒ f (v1 ) = . . . = f (vn ) = 0. Da teorema sappiamo che un’applicazione

lineare é ben definita da ció che fa su una base dello spazio di partenza. Poiché f manda tutti i vettori

in 0 =⇒ f = 0.

α é surgettiva (facciamo vedere che data A£ esiste¤ sempre f t. c. A = mB

S (f )):

i

Presa A = mB

(f

),

definisco

f

tale

che

f

(v

)

=

A

,

∀i

=

1,

.

.

.

,

n.

Per teorema ∃!f ∈ Hom(V, W )

i S

S

che manda una base in vettori prescritti.

¡

¢

Corollario: dim Hom(V, W ) = pn

Proposizione: siano V, W, Z spazi vettoriali, con basi rispettivamente B, S, T . Siano f, g applicazioni

f

g

B

lineari tali che VB −→ WS −→

), B = mST£ (g). ¤Allora mB

T (g

£ ZT . Siano

¤ A£= ¡mS (f¢¤

£ ◦¤ f ) = B · A.

Dimostrazione: ∀v ∈ V, (g ◦ f )(v) T = (g f (v) T = B · f (v) S = B · A · v B .

Definizione: sia f un’applicazione lineare. Definiamo rkf = dim(Imf ).

Diamo un modo¡ per calcolare rkf

¢:

Imf = span f (v1 ), . . . , f (vn ) ∼

= span(A1 , . . . , An ) =⇒ dim(Imf ) = dim(ImA) = rkA.

Matrice del cambiamento di base

Il cambiamento di base avviene tramite un’applicazione lineare che manda ciascun vettore in sé stesso.

Tale applicazione é l’identitá (da non confondere con la matrice identitá):

Id : VB −→ VS

La matrice associata all’applicazione identitá (A ∈ M (n) t. c. A = mB

S (Id)) é tale che:

∀v ∈ V [v]S = A · [v]B

Ateneo Studenti Fisica

21

Rango di un’applicazione lineare

£

¤

che segue da f (v) S = A · [v]B , con f = Id.

É chiaro che la matrice A é invertibile, essendo rkA = dim(Imf ) = dimV = n

Osservazione: B = mSB (Id) é la matrice inversa di A, poiché A · B = I, cioé applicando le due matrici

in sequenza, le coordinate di ciascun vettore rimangono immutate.

22

Ateneo Studenti Fisica

SD-equivalenza

Definizione: chiameremo gruppo lineare di rango n su campo K:

GL(n, K) = {A ∈ M (n, K) | Aé invertibile}

¡

¢

Dimostriamo che GL(n, K), · , con · prodotto fra matrici, é effettivamente un gruppo (non commutativo):

?

1. · é un’operazione in GL(n, K): ∀A, B ∈ GL(n, K) =⇒ AB ∈ GL(n, K).

Sia (AB)−1 = B −1 A−1 . Verifichiamo che é una buona definizione: AB · B −1 A−1 = A · A−1 = I;

2. Esistenza dell’inverso: ∀A ∈ GL(n, K) =⇒ A−1 ∈ GL(n, K), poiché (A−1 )−1 = A;

3. esiste l’elemento neutro per il prodotto, ossia I;

4. Proprietá associativa: vale per tutte le matrici, quindi anche per quelle invertibili.

Siano V, W due spazi vettoriali, f : V −→ W un’applicazione lineare, B e B 0 due basi di V , S e S 0 due

0

B0

basi di W . Siano n = dimV, p = dimW, A = mB

S (f ), A = mS 0 (f ). Consideriamo il seguente diagramma:

A

VB −→ WS

↑N

↓M

A0

VB0 −→ WS 0

A0 = M AN dove M e N sono le matrici associate all’identitá (matrici di cambio di base).

Osservazione: M ∈ GL(p, K), N ∈ GL(n, K), poiché prodotto di matrici elementari invertibili.

Definizione: due matrici A, B ∈ M (p, n) sono dette SD-equivalenti se ∃M ∈ GL(p, K), ∃N ∈ GL(n, K) t. c.

B = M AN .

Osservazioni:

1. SD-equivalenza é una relazione di equivalenza:

• Proprietá riflessiva: A ≡ A, poiché ∃Ip ∈ GL(p), ∃In ∈ GL(n) t. c. A = Ip AIn ;

• Proprietá simmetrica: A ≡ B =⇒ B ≡ A, poiché B = M AN =⇒ A = M −1 BN −1 ;

• Proprietá transitiva: A ≡ B, B ≡ C =⇒ A ≡ C, poiché B = M AN, C = P BQ =⇒

=⇒ C = (P M )A(N Q). Infatti P, M ∈ GL(p) =⇒ P M ∈ GL(p); lo stesso per N e Q.

2. se A ≡ B =⇒ rkA = rkB:

¡

rkB = rk(M AN ); N¡ isomorfismo =⇒ rk(M AN ) = rk

¢ (M A)N ) = rk(M A), M isomorfismo =⇒

=⇒ rk(M A) = rkA poiché rk(f ◦ g) ≤ min(rkf, rkg) . Il rango é un invariante per SD-equivalenza;

3. che A e B siano SD-equivalenti vuol dire che rappresentano la stessa applicazione in basi diverse;

4. equivalentemente, per le applicazioni lineari, date f, g ∈ Hom(V, W ), dove dimV = n, dimW = p:

f ≡ g ⇐⇒ ∃ϕ ∈ GL(V ), ∃ψ ∈ GL(W ) t. c. g = ψ ◦ f ◦ ϕ;

S

B

B

B

B

f ≡ g ⇐⇒ mB

S (g) = mS (ψ) · mS (f ) · mB (ϕ) ⇐⇒ mS (g) ≡ mS (f );

In questo caso f e g sono applicazioni diverse nelle stesse basi, non la stessa applicazione vista in

basi diverse.

Ateneo Studenti Fisica

23

SD-equivalenza

Proposizione: siano V, W due spazi vettoriali tali che dimV = n, dimW = p. Si f : Vµ −→ W ¶

lineare

Ir 0

B

tale che r = rkf . Allora esistono una base B di V e una base S di W tali che mS (f ) =

0 0

Dimostrazione: rkf = r =⇒ dim(Kerf ) = n − r. Sia {vr+1 , . . . , vn } una base di Kerf .

La completiamo a base B = {v1 , . . . , vr , vr+1 , . . . , vn } di V .

Sappiamo che {f (v1 ), . . . , f (vr )} generano Imf , dato che f (vr+1 ) = . . . = f (vn ) = 0, sono r =⇒ sono

una base di Imf .

Li completiamo a base S = {f (v1 ), . . . , f (vr ), wr+1 , . . .µ

, wp } di W

¶.

Ir 0

B

La matrice associata ad f nelle basi B, S é: mS (f ) =

0 0

µ

¶

Ir 0

Corollario: sia A ∈ M (p, n), se rkA = r =⇒ A ≡

0 0

Basta scegliere le basi come nella dimostrazione precedente.

Teorema: A ≡ B ⇐⇒ rkA = rkB (ossia il rango é un invariante completo di SD-equivalenza).

Dimostrazione: (=⇒) giá fatto.

µ

¶

Ir 0

(⇐=) rkA = rkB = r =⇒ A ≡

≡ B =⇒ A ≡ B (transitivitá).

0 0

Corollario: ∀A ∈ M (p, n), rkA = rktA.

µ

Ir

Dimostrazione: sia r = rkA =⇒ A = M ·

0

¶

¶ µ

tµ

tµ

Ir 0

Ir 0

· tM ,

=

=⇒ tA = tN ·

0 0

0 0

t

t

t

0

0

Ir

0

¶

· N con M ∈ GL(p), N ∈ GL(n).

0

0

¶

∈ M (n, p).

t

N ∈ GL(n, K), perché I = tI = (N N −1 ) = (N −1 )tN =⇒ (N −1 ) é l’inversa di tN ; lo stesso per

t

M.

¶

µ

Ir 0

t

=⇒ rktA = r.

=⇒ A ≡

0 0

Corollario: sia R(A) = span(A1 , . . . , Ap ) lo spazio generato

dalle righe di A. Allora dimR(A)

= rkA.

¡

¢

Dimostrazione: dimR(A) = dimC(tA) = rktA = rkA dove C(tA) = span(tA1 , . . . , tAn ) .

Proposizione: se A ∈ M (p, n) e B é sottomatrice di A =⇒ rkB ≤ rkA.

Dimostrazione: B = (Ai1 , . . . , Aim | Aj1 , . . . , Ajk ). Sia C = (Ai1 , . . . , Aim | A1 , . . . , An ).

C é ottenuta da A prendendo tutte le colonne e alcune righe. Pensando al rango per riga: rkC ≤ rkA.

Allo stesso modo B é ottenuta da C prendendo tutte le righe e alcune colonne. Pensando al rango per

colonna: rkB ≤ rkC ≤ rkA.

Definizione: ogni sottomatrice quadrata é detta un minore. Si dice ordine del minore il numero delle

sue righe (e colonne).

Proposizione: sia A ∈ M (p, n), e sia B un minore di A di ordine q invertibile =⇒ le righe di A che

entrano a formare B sono linearmente indipendenti.

Dimostrazione: Supponiamo che B sia formato dalle prime q righe e q colonne di A. Proviamo che

A1 , . . . , Aq sono linearmente indipendenti:

α1 A1 + . . . + αq Aq = 0 =⇒ α1 B1 + . . . + αq Bq = 0 ⇐⇒ α1 = . . . = αq = 0 (sono linearmente indipendenti).

Proposizione: il rango di una matrice A ∈ M (p, q) é il massimo degli ordini dei suoi minori invertibili.

Dimostrazione: sia rkA = r, ρ il massimo ordine dei suoi minori invertibili.

Sia B un minore di A di ordine ρ invertibile =⇒ A contiene ρ righe linearmente indipendenti =⇒

=⇒ rkA ≥ ρ, ρ ≤ r.

Ma in A esistono r righe linearmente indipendenti, che supponiamo essere A1 , . . . , Ar .

Sia C = (A1 , . . . , Ar | A1 , . . . , Aq ) =⇒ rkC = r (pensato come rango per riga). Allora C contiene r

colonne linearmente indipendenti, supponiamo C j1 , . . . , C jr .

Sia M = (A1 , . . . , Ar | Aj1 , . . . , Ajr ) ∈ M (r), minore di A di ordine r, invertibile (contiene r colonne

linearmente indipendenti) =⇒ ρ ≥ r.

Poiché valgono contemporaneamente ρ ≤ r e ρ ≥ r =⇒ ρ = r.

24

Ateneo Studenti Fisica

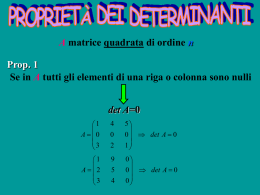

Determinante

Sia A ∈ M (n, K), sappiamo che rkA é il massimo numero di righe e colonne indipendenti.

Cerchiamo una funzione: det : M (n, K) −→ K tale che detA = 0 ⇐⇒ le righe di A sono linearmente

dipendenti.

Esempio:

sia n = 2 : A =

µ

a11

a21

a12

a22

¶

. Abbiamo 3 casi:

1. Se a11 e a21 sono entrambi nulli, le righe sono dipendenti.

2. Se a11 6= 0 =⇒ tramite operazioni per righe:

µ

¶

a11

a12

A→

0 a22 − a−1

11 · a21 · a12

Le righe di A sono dipendenti ⇐⇒ a22 − a−1

11 · a21 · a12 = 0 ⇐⇒ a11 · a22 − a21 · a12 = 0.

3. Se a11 = 0 ma a21 6= 0:

µ

n=2: A=

a21

0

a22

a12

¶

Le righe di A sono dipendenti ⇐⇒ a12 = 0, ossia se non é un pivot.

Ponendo, nel caso n = 2, detA = a11 · a22 − a12 · a21 =⇒ detA = 0 ⇐⇒ Le righe sono linearmente

dipendenti.

Abbiamo trovato la funzione che cercavamo nel caso n = 2. Vediamo ora alcune sue proprietá:

1. det é lineare nelle righe. Supponiamo che la prima riga di A sia combinazione lineare di altre due:

µ

¶

µ

¶

µ

¶

λB + µC

−B−

−C−

∃B, C ∈ K2 t. c. A =

. Verifichiamo che det A = λ det

+µ

−A2 −

−A2 −

−A2 −

Infatti:

µ se B = (b1 b2 ), C = (c

¶ 1 c2 ), A2 = (a1 a2 ):

λb1 + µc1 λb2 + µc2

det

= a2 (λb1 + µc1 ) − a1 (λb2 + µc2 ) = λ(a2 b1 − a1 b2 ) + µ(a2 c1 − a1 c2 ) =

a1

a2

µ

¶

µ

¶

b1 b2

c1 c2

=λ

+µ

a1 a2

a1 a2

2. Se A ha due righe uguali =⇒ det A = 0;

3. det I = 1.

Passiamo ora al caso generico, e supponiamo che det A, definito prima, verifichi le 3 proprietá sopra

elencate. Abbiamo le seguenti conseguenze:

• se A ha una riga nulla =⇒ det A = 0.

Dimostrazione: se Ai = 0, ∀B ∈ Kn (riga) =⇒ Ai = 0 · B. Allora, applicando la proprietá 1:

det(A1 , . . . , 0 · B, . . . , An ) = 0 · det(A1 , . . . , B, . . . , An ) = 0;

• se A0 é ottenuta da A scambiando due righe =⇒ det A0 = − det A.

Dimostrazione:

A = (A1 , . . . , Ai , . . . , Aj , . . . , An )

Ateneo Studenti Fisica

25

Determinante

A0 = (A1 , . . . , Aj , . . . , Ai , . . . , An ).

Consideriamo la matrice A00 = (A1 , . . . , Ai + Aj , . . . , Ai + Aj , . . . , An ). Poiché ha due righe uguali:

det A00 = 0. Applicando le proprietá 1 e 2:

0

z

}|

{

00

0 = det A = det(A1 , . . . , Ai , . . . , Aj , . . . , An ) + det(A1 , . . . , Ai , . . . , Ai , . . . , An ) +

0

z

}|

{

+ det(A1 , . . . , Aj , . . . , Aj , . . . , An ) + det(A1 , . . . , Aj , . . . , Ai , . . . , An ) = det A + det A0

=⇒ det A0 = − det A;

• se B ∈ M (n, K) é ottenuta da A sommando ad una riga una combinazione lineare delle altre

=⇒ det B = det A.

Dimostrazione: B = (A1 + α2 A2 + . . . + αn An , A2 , . . . , An ). Applicando la proprietá 1:

det B = det A +

n

X

0

z

}|

{

αi det(Ai , A2 , . . . , An ) = det A

i=2

• se le righe di A sono linearmente dipendenti =⇒ det A = 0.

Dimostrazione: se A = (α2 A2 + . . . + αn An , A2 , . . . , An ):

det A =

n

X

0

z

}|

{

αi det(Ai , A2 , . . . , An ) = 0

i=2

• se A é diagonale A =

a1

0

..

.

=⇒ det A = a1 · . . . · an .

0

an

Dimostrazione: Per le proprietá 2 e 3:

a1

0

1

.

..

det

= a1 · . . . · an · det

0

an

0

0

..

.

= a1 · . . . · an

1

Teorema: (unicitá) se det verifica le proprietá 1, 2 e 3 =⇒ ∀A ∈ M (n, K), det A é univocamente

determinato.

Dimostrazione: Riduciamo A a scalini (S) con operazioni per riga di primo e terzo tipo (scambi di

righe, somma con multiplo). Dalla terza conseguenza sopra elencata, sappiamo che sommare ad una riga

il multiplo di un’altra non fa variare il determinante.

Se sono stati fatti m scambi di righe =⇒ det A = (−1)m · det S. Abbiamo 2 casi:

• rkS < n (almeno l’ultima riga é nulla) =⇒ det S = 0 =⇒ det A = 0;

• rkS = n. Finora abbiamo ridotto A in forma triangolare. Con ulteriori operazioni elementari per

riga riduciamo

S a S 0diagonale.

p1

0

.

0

..

S =

=⇒ det S = det S 0 = p1 · . . . · pn

0

pn

=⇒ det A = (−1)m · p1 · . . . · pn

Quindi il valore della funzione é univocamente determinato.

N.B. I pivots possono essere diversi a seconda della riduzione che é stata fatta, ma il loro prodotto é

costante (a meno del segno).

Corollario: det A = 0 ⇐⇒ le righe di A sono linearmente indipendenti.

Dimostrazione: (⇐=) giá fatta.

Gauss

(=⇒) Se per assurdo le righe di A fossero indipendenti =⇒ A −→ S. S ha n pivots =⇒ det A =

m

m

= (−1) · det S = (−1) · p1 · . . . · pn 6= 0. Assurdo.

26

Ateneo Studenti Fisica

Determinante

Esistenza:

def

n = 1 =⇒ det a = a;

n = 2 =⇒ det A = a11 a22 − a21 a12 ;

n =⇒ Sia A ∈ M (n), ai1 = [A]i1 , Ai1 la sottomatrice ottenua da A scartando la prima colonna e la

i-aesima riga (detta complemento algebrico). Allora si chiama sviluppo di Laplace:

det A =

n

n

X

(−1)i+1 ai1 · det Ai1

n−1

i=1

Verifichiamo per induzione su n che valgono le 3 proprietá per lo sviluppo di Laplace.

• n = 2 giá fatto.

• Passo induttivo: supponiamo che le 3 proprietá valgano per il caso detn−1 e verifichiamo che valgono

anche detn :

1. supponiamo che ∃B, C ∈ Kn t. c. Aj = λB + µC.

?

Siano A0 = (A1 , . . . , B, . . . , An ), A00 = (A1 , . . . , C, . . . , An ) =⇒ det A = λ det A0 + µ det A00 .

Consideriamo [A]i1 e Ai1 al variare di i:

se i 6= j =⇒ [A]i1 = [A0 ]i1 = [A00 ]i1 , mentre det Ai1 = λ det A0 i1 + µ det A00 i1 ;

se i = j =⇒ [A]j1 = λ[A0 ]j1 + µ[A00 ]j1 , mentre Aj1 = A0 j1 = A00 j1 .

X£

¡

¢¤

¡

¢

det A =

(−1)i+1 [A]i1 · λ det A0 i1 + µ det A00 i1 + (−1)j+1 λ[A0 ]j1 + µ[A00 ]j1 · det Aj1

i6=j

Applicando quanto sopra:

à n

!

à n

!

X

X

i+1

0

0

i+1

00

00

(−1) [A ]i1 · det A i1 +µ

(−1) [A ]i1 · det A i1 = λ det A0 +µ det A00

det A = λ

i=1

i=1

2. Sia A tale che Ai = Aj . Verifichiamo che det A = 0

A = (A1 , . . . , Ai , . . . , Ai , . . . , An )

Se k 6= i, j =⇒ det Ak1 = 0 perché contiene due righe uguali.

Se k = i =⇒ [A]k1 = [A]i1 = [A]j1 e det Ai1 = (−1)j−i−1 · det Aj1 (come se la j-esima riga

venisse spostata verso l’alto di j − i − 1 posizioni, scambiandola ogni volta con la precedente,

fino ad assumere l’i-esima posizione).

det A =

zX

0

}|

{

¡

¢

(−1)k+1 [A]k1 · det Ak1 +(−1)i+1 [A]j1 · (−1)j−i−1 ·det Aj1 +(−1)j+1 [A]j1 ·det Aj1

k6=i,j

Ma il secondo e il terzo blocco sono opposti, quindi det A = 0.

3. Verifichiamo che det In = 1.

Se i 6= 1 =⇒ [A]i1 = 0;

se i = 1 =⇒ [A]11 = 1 e det A11 = 1 (é ancora una matrice identitá di rango n − 1).

det A = (−1)2 [A]11 · det A11 +

z

n

X

0

}|

{

(−1)i+1 [A]i1 · det Ai1 = 1

i=2

Osservazione: facendo lo sviluppo di Laplace lungo qualsiasi colonna della matrice si ottiene una funzione che verifica le proprietá 1, 2 e 3. Poiché abbiamo dimostrato l’unicitá del determinante concludiamo

che tutte queste funzioni sono uguali.

Osservazione: se A ∈ M (n) =⇒ det(αA) = αn det A.

Ateneo Studenti Fisica

27

Determinante

Teorema: (di Binet) siano A, B ∈ M (n, K) =⇒ det(AB) = det A · det B.

Dimostrazione: se det B = 0 =⇒ rkB < n =⇒ rk(AB) < min(rkA, rkB) < n =⇒ det(AB) = 0.

Se det B 6= 0 definiamo f (A) = det(AB)

det B . Vogliamo dimostrare che f (A) = det A; basta quindi provare

che verifica le proprietá 1, 2 e 3 e ricordarsi dell’unicitá del determinante.

1. Linearitá nelle righe: sia Ai = λP + µQ, P, Q ∈ Kn , allora:

det(AB) = det λP + µQ·

B

= det λP B + µQB = λ det P B +µ det QB

Poiché det B 6= 0 =⇒ rkB = n =⇒ P B 6= 0, QB 6= 0 =⇒ la i-esima riga della matrice AB é

combinazione lineare di altre due. Essendo det(AB) lineare nelle righe lo é anche f (A).

2. Allo stesso modo, se A ha due righe uguali, anche AB le avrá. Allora det AB = 0.

3. f (I) =

det(IB)

det B

= 1.

−1

Corollario: sia A ∈ M (n) invertibile =⇒ det A−1 = (det A) .

−1

Dimostrazione: A · A−1 = I =⇒ det(A · A−1 ) = 1 =⇒ det A · det A−1 = 1 =⇒ det A−1 = (det A)

Corollario: siano A, B ∈ M (n) invertibili =⇒ AB é invertibile.

Dimostrazione: det A 6= 0, det B 6= 0 =⇒ det(AB) = det A · det B 6= 0 =⇒ AB é invertibile.

Proposizione: ∀A ∈ M (n, K), det tA = det A.

Dimostrazione: se det A = 0 =⇒ rktA = rkA < n =⇒ det tA = 0.

Consideriamo le matrici elementari : quelle di primo e secondo tipo sono simmetriche, quindi sono uguali

alla loro trasposta (e di conseguenza vale la proposizione), mentre quelle di terzo possono essere ricondotte

tramite un’operazione elementare (che non fa variare il determinante) all’identitá, quindi a una matrice

simmetrica. La proposizione vale per tutte le matrici elementari.

Passiamo ora al caso generico con det A 6= 0. Con opportune matrici elementari:

Em · . . . · E1 · A = I =⇒ tA · tE1 · . . . · tEm = I =⇒ A = (tEm )−1 · . . . ·(tE1 )−1

−1

det tA = det(tEm

)· . . . · det(tE1−1 ) = (det tEm )−1 · . . . ·(det tE1 )−1 · (det A)−1 · det A =

£

¤−1

= (det Em )−1 · . . . ·(det E1 )−1 · (det A)−1 · det A = det(Em · . . . · E1 · A)

· det A = det A.

|

{z

}

I

Osservazione: lo sviluppo di Laplace secondo la prima riga:

f (a) =

n

X

(−1)1+i [A]1i · det A1i

i=1

é uguale a det A.

Dimostrazione:

f (a) =

n

X

det(tA)i1

z }| {

t

(−1)i+1 [tA]i1 · det (A1i ) = det tA = det A

i=1

Proposizione: (regola di Cramer ) Sia AX = B un sistema tale che A ∈ M (n, K), B ∈ Kn , e supponiamo

B(i)

det A 6= 0. Se y1 , . . . , yn é soluzione del sistema =⇒ yi = det

det A , dove

B(i) = (A1 , . . . , Ai−1 , B,

Ai+1

, . . . , , An ).

y1

Dimostrazione: se Y = ... , sappiamo che AY = B =⇒ y1 A1 + . . . +yn An = B. Allora:

yn

det B(i) = det(A1 , . . . , Ai−1 ,

n

X

i=1

yi Ai , Ai+1 , . . . , , An ) =

n

X

yi det(A1 , . . . , Ai , . . . , , An ) = yi det A

i=1

Proposizione: sia A ∈ M (n, K) inveribile. Allora la matrice B ∈ M (n, K) definita da (Aij é il

complemento algebrico):

(−1)i+j det Aij

[B]ij =

det A

28

Ateneo Studenti Fisica

Determinante

é la matrice inversa di A.

Dimostrazione: verifichiamo che AB = I:

[AB]hk =

n

X

[A]hi · [B]ik =

i=1

n

X

(−1)i+k [A]hi ·

i=1

det Aki

det A

Tale espressione assume i valori:

1 se k = h, poiché il numeratore della frazione é lo sviluppo di det A;

0 se k 6= h: possiamo costruire la matrice A0 in cui A0 k = A0 h = Ah (cioé la h-esima e la k-esima riga

di A0 sono uguali alla h-esima di A) =⇒ det A0 = 0.

Nei casi in cui k 6= h: [A]hi = [A0 ]ki e Aki = A0 ki (viene cancellata proprio la k-esima riga, l’unica

che abbiamo modificato; non ci si accorge della differenza). Dunque, in questo caso:

[AB]hk =

n

X

(−1)i+k [A0 ]ki ·

i=1

det A0 ki

det A0

=

=0

det A

det A

Criterio dei minori orlati

Definizione: sia A ∈ M (p, q) e sia B un minore di A di ordine n. C é un minore orlato di B se é

un minore di A di ordine n + 1 e B = (C1 , . . . , Cn | C 1 , . . . , C n ) (ossia scartando da C l’ultima riga e

l’ultima colonna si ottiene B).

Esempio:

µ

1 2 3 1

1

0 √9 5 1

A=

B=

0

π

2 1 0

Sono

minori orlati diB:

1

1 2 3

C 0 = 0 √9 5 C 00 = 0

2 1

π

π

2

9

¶

2 1

√9 1

2 0

Proposizione: : sia A ∈ M (p, q), e sia B un minore di ordine n tale che:

• det B 6= 0;

• tutti i minori orlati di B hanno determinante nullo.

Allora rkA = n.

Dimostrazione: supponiamo che B = (A1 , . . . , An | A1 , . . . , An ) (cioé che sia composto dalle prime

n righe e colonne di A). Sicuramente A1 , . . . , An sono linearmente indipendenti (entrano a formare il

minore). Dimostriamo che generano tutte le altre righe.

Consideriamo quindi la sottomatrice C = (A1 , . . . , An , Ai | A1 , . . . , Aq ), i = n + 1, . . . , p (costituita

dalle righe che entrano a formare B piú una e da tutte le colonne di A).

C1 , . . . , Cn sono indipendenti, ma ∀i = n + 1, . . . , p, Ci ∈ span(C1 , . . . , Cn ), perché prendendo tutte le

righe e le prime n colonne piú una (tra le rimanenti) di C si ottiene un minore orlato di B =⇒ C ha n

colonne linearmente indipendenti =⇒ rkC = n =⇒ Ai é linearmente dipendente.

Ateneo Studenti Fisica